1.简介

递归神经网络(RNN)可以捕捉和利用自然和人工语言、语音、视频和各种其他形式的时间序列中的序列结构。RNN中的循环信息流意味着过去看到的数据对RNN的当前状态有影响,形成了一种通过对两者进行编码的(非线性)时间轨迹来获得记忆的机制什么和什么时候过去的工作使用RNN来研究神经种群动力学(Costa等人,2017年),并证明了生物神经网络和模拟条件下训练的人工网络之间的定性相似动力学(Mante等人,2013年;Sussillo等人,2015年;Cueva等人,2020年). 反过来,这就对使用此类网络作为研究大脑功能的手段的有效性提出了质疑。考虑到这一点,由于梯度消失问题,训练标准的香草RNN来捕获序列中的长期依赖性是一项挑战(Hochreiter,1991年;Bengio等人,1994年). 已经提出了几种特殊的RNN架构来缓解这个问题,特别是长短期存储器(LSTM)单元(Hochreiter和Schmidhuber,1997年)它明确地防止在必要时对隐藏状态中存储的信息进行不必要的破坏。最近,LSTM的简化称为门控复发单元(GRU)(Cho等人,2014年)由于其在语音方面的表现,在计算神经科学和机器学习社区中变得流行起来(Prabhavalkar等人,2017年),音乐(Choi等人,2017),视频(Dwibedi等人,2018年),提取神经数据背后的非线性动力学(Pandarinath等人,2018年). 然而,某些机械任务,特别是无界计数,对LSTM网络来说很容易,但对GRU网络来说却不是(Weiss等人,2018年).

尽管有这些实证研究结果,但我们对GRU记忆结构的内部时间演化及其表示非线性时间动力学的能力缺乏系统的了解。这样的理解将明确哪些特定任务(自然任务和人工任务)可以执行或不能执行(Bengio等人,1994年),计算是如何实现的(啤酒,2006;苏西洛和巴拉克,2012年),并帮助预测定性行为(啤酒,1995;赵和朴,2016). 此外,大量文献讨论了RNN的局部动力学(平衡点)(Bengio等人,1994年;苏西洛和巴拉克,2012年),但一个完整的理论还需要了解全局属性(啤酒,1995). 此外,对GRU网络拓扑结构的确定性理解将为经过训练的网络的泛化能力提供基本见解,从而有助于理解如何为特定任务播种RNN(Doya,1993年;Sokół等人,2019年).

通常,RNN的隐藏状态动力学可以写为小时t吨+1=(f)(小时t吨,x个t吨)其中x个t吨是序列中的当前输入,由t吨,(f)是一个非线性函数,并且小时t吨表示隐藏的内存状态,其中包含负责未来输出的所有信息。在没有输入的情况下,小时t吨随时间演化:

哪里(f)(·) :=(f)(·,0)为了简化符号。换句话说,我们可以将存储在RNN中的记忆的时间演化视为方程(1)定义的自治动力系统的轨迹,并使用动力系统理论进一步研究和分类RNN中可获得的时间特征。在本文中,我们打算通过连续时间分析提供对GRU内部工作的深入直觉。虽然RNN传统上是在离散时间实现的,但我们在下一节中显示,这种形式的GRU可以解释为基本常微分方程系统的数值近似。从历史上看,与连续时间系统相比,离散时间系统的分析通常更具挑战性,这主要是因为它们的跳跃的自然,允许在低维中进行更复杂的动力学(Pasemann,1997年;Laurent和von Brecht,2017年). 由于许多抽象和物理系统的相对连续性,在某些情况下直接分析训练的RNN的潜在连续时间系统可能非常有用,同时将离散化增加的动力学复杂性解释为数值分析的异常(LeVeque和LeVeque,1992年;托马斯,1995年;He等人,2016年;Heath,2018年). 此外神经常微分方程促进了计算神经科学和机器学习社区将他们的注意力转向神经网络的连续时间实现(Chen等人,2018年;Morrill等人,2021年).

我们讨论了大量观测到的局部和全局动力学结构,并通过训练GRU以预测具有规定动力学的时间序列来验证理论。为了不影响演示,我们将分析限制在低维,以便于可视化(啤酒,1995;赵和朴,2016). 然而,对于任何有限维的训练有素的GRU,这里的发现仍然适用,并且可以根据具体情况进行进一步分析(讨论中有更多关于这方面的信息)。此外,为了确保我们的工作可以访问,我们将在交付过程中采用教学方法。我们推荐梅斯(梅斯,2007)了解有关该主题的更多背景信息。

2.门控递归单元的基本连续时间系统

GRU使用两个内部选通变量:更新浇口 z(z)t吨保护d日-维度隐藏状态和重置闸门 第页t吨允许覆盖隐藏状态并控制与输入的交互.

哪里和是参数矩阵,是偏置向量,⊙表示元素的乘法,σ(z(z)) = 1/(1+e(电子)−z(z))是元素式logistic sigmoid函数。注意,隐藏状态渐近包含在[−1,1]内d日由于饱和非线性,这意味着如果状态被初始化在这个捕获区域之外,那么它最终必须在有限的时间内进入并在以后的所有时间内都保持在该区域内。

请注意,更新门z(z)t吨控制隐藏状态的每个维度衰减的速度,为内存提供自适应时间常数。具体来说,作为,GRU可以实现对过去的完美记忆并忽略x个t吨。因此d日-维度GRU能够通过更新门保持接近恒定的存储器,因为0<[z(z)t吨]j个<1,其中[·]j个表示j个-向量的第个分量。此外,自回归权重(主要是U型小时和U型第页)可以支持时间演变内存(Laurent和von Brecht,2017年认为这是一个障碍,并建议在简化的GRU中删除所有复杂的动力学行为)。

为了进一步研究记忆结构,让我们考虑在没有输入的情况下隐藏状态的动力学,即。,x个t吨= 0, ∀t吨,其形式为方程式(1)。从动力学系统的角度来看,系统的所有输入都可以理解为自治系统的扰动,因此对可实现的动力学集没有影响。为了利用连续时间动力系统理论丰富的描述语言,我们将自主GRU-RNN识别为以下连续时间动力系的加权正向Euler离散化:

哪里由于σ(·)和tanh(·)都是光滑的,所以这个连续极限是合理的,并作为进一步分析的基础,因为所有GRU网络都试图接近这个连续极限。在下文中,GRU将引用连续时间版本(方程式7)。请注意,更新门z(z)(t吨)同样扮演着状态相关时间常数的角色,用于内存衰退。然而,我们注意到z(z)(t吨)沿点方向调整流速,导致所有轨迹的非恒定非线性减慢,如z(z)(t吨) ∈ (0, 1). 自1−z(z)(t吨)>0,因此不能改变符号,它充当(等式7)和同一系统之间的同胚,去掉了这个领先的乘法项。因此,它不会改变动力学的拓扑结构(库兹涅佐夫,1998年),我们可以放心地忽略z(z)(t吨)在以下理论分析中(第3、4节)。在这些部分中,我们设置U型z(z)=0和b条z(z)=0。连续时间GRU的推导可以在补充材料.关于以下影响的进一步详细信息z(z)(t吨)在本文的最后一节中进行了讨论。

3.一维GRU的稳定性分析

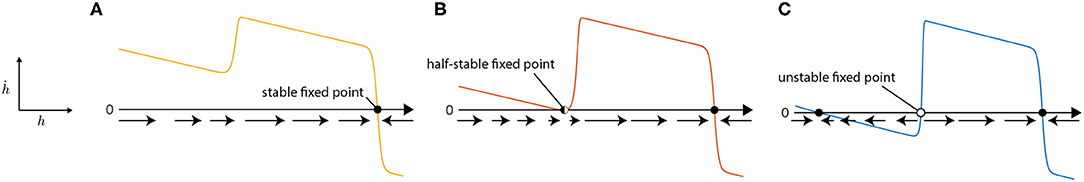

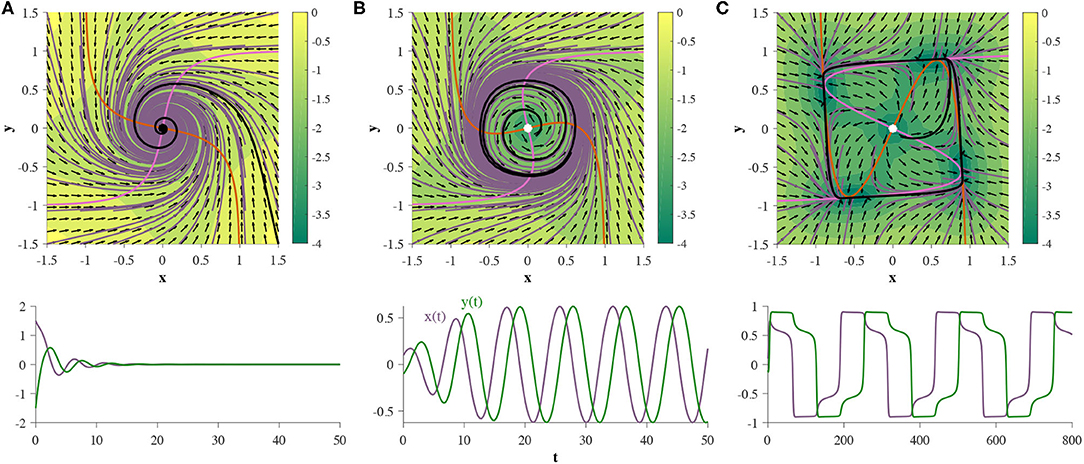

对于1D GRU(d日=1),方程(7)简化为一维动力系统,其中每个变量都是标量。1D GRU的表达能力非常有限,因为只有三种稳定性结构(拓扑)存在(参见补充材料): (图1A)单个稳定节点(图1B)稳定节点和半稳定节点,以及(图1C)由不稳定节点分隔的两个稳定节点(请参见图1). 隐藏状态的相应时间演化为(A)衰减到固定值,(B)衰减到一个固定值,但从一个方向停止在中间值直到扰动,或(C)衰减到两个固定值之一(双稳态)。双稳态可用于模拟开关,例如在简单决策的环境中,输入可在状态之间来回扰动系统。

GRU采用的拓扑由其参数决定。如果GRU开始于对应于(a)的参数空间的区域,我们可以在参数空间中平滑地将参数改变为横向(B),并在(C)处结束。这通常被称为鞍节点分岔。一般来说,分岔是指动力系统的拓扑结构因参数平滑变化而发生的变化。参数空间中发生分岔的点称为分岔点(例如。,图1B),我们将在分歧点改变其稳定性的不动点称为分岔不动点(例如,半稳定不动点图1B). 分岔余维是指为了保持在分岔流形上而必须改变的参数数量。在我们的例子中,鞍节点分岔是余维-1(库兹涅佐夫,1998年). 就在从(A)过渡到(B)之前,半稳定节点附近的流动可能会表现出任意缓慢的流动。我们将其称为慢速点(苏西洛和巴拉克,2012年). 在这种情况下,慢点允许亚稳态,在亚稳态中,轨迹将流向慢点,在移动到稳定的定点之前保持一段时间。

4.二维GRU的分析

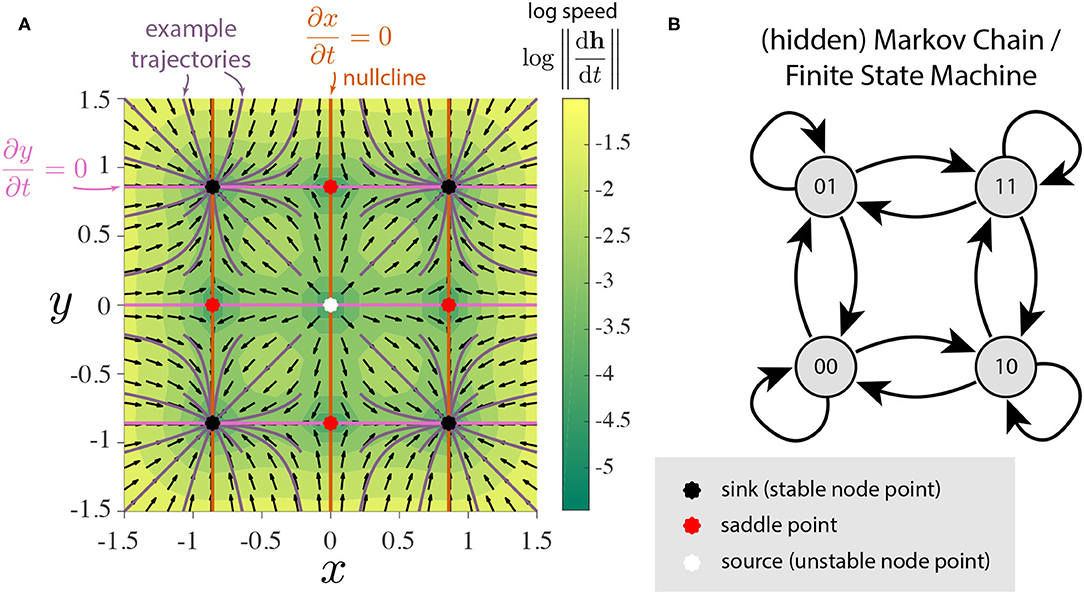

我们将看到,添加第二个GRU会打开大量可能的拓扑结构。为了简单起见,我们表示小时作为x个和年。我们将方程(7)定义的二维流场可视化为相图揭示了感兴趣的拓扑结构(梅斯,2007). 首先,两个独立的双稳态GRU的相图可以可视化为图2A。它清楚地显示了预期的4个稳定状态,共有9个固定点。这可以看作是具有4个状态的有限状态机的连续时间连续空间实现(图2B). 观测到的三种固定点(稳定点(汇点)、不稳定点(源点)和鞍点)表现出局部线性动力学,然而,全局几何是非线性的,它们的拓扑结构可以根据它们的排列而变化。

我们探索了二维GRU可实现的稳定性结构。由于观测到的拓扑数量相对较多,本节的重点将是演示2D GRU可以获得的所有观测到的局部和全局动力学特征。所有已知拓扑的目录可以在补充材料以及本文描述的每个相位图的参数。我们不能说这个目录是否详尽无遗,但所发现的结构的绝对数量证明了GRU网络的表达能力,即使是在低维度上。

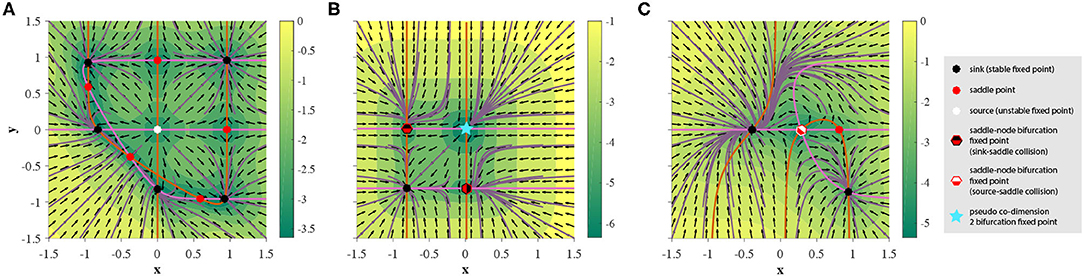

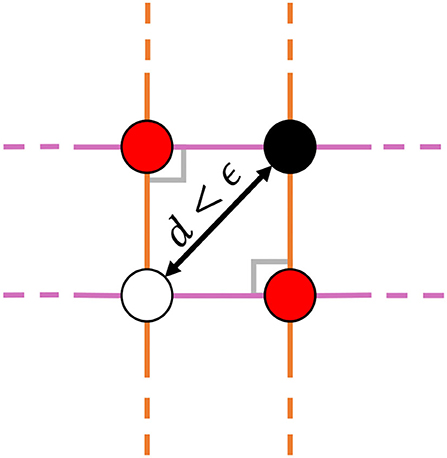

在继续之前,让我们花这段时间描述观察到的所有局部动力学特征。除了前面提到的三种类型的不动点外,2D GRU还可以表现出各种分叉不动点,这是由参数空间的区域所导致的,这些区域将所有拓扑限制在简单的不动站(即稳定、不稳定和鞍点)。从行为上讲,这些不动点是前三者的混合体,从而产生了更丰富的可获得动力。在图3,我们显示了所有观察到的不动点类型虽然在2D GRU系统中没有观察到余维2分支不动点,但伪坐标-2分叉不动点是通过将汇点、源点和两个鞍点足够靠近来观察的,这样,在实施时,所有四个点都保持在机器精度以下,从而充当单个不动点。图4进一步证明了这一概念,以及图3B描述和示例。我们稍后将讨论这种伪分支点允许系统显示同质性的二维紧集上的行为。在图3A,我们看到11个不动点,这是2D GRU系统中观察到的最大不动点数。仔细观察这个系统,可以发现一种解释是具有输入驱动跃迁的5个离散状态的连续模拟,类似于图2这给网络以这种方式编码有限状态集的能力施加了一个可能的上限。

分岔不动点的添加为动态实现更复杂的模型打开了大门。以中描述的四状态系统为例图3B。如果将隐藏状态设置为在相空间的第一象限中初始化[即(0,∞)2],轨迹将流向原点处的伪二维分岔不动点。通过输入引入噪声将随机导致轨迹直接或首先流入两个第一类鞍节点分岔不动点之一,从而接近(−1,−1)处的稳定不动点。这类模型可用于多种应用,例如感知决策(Wong和Wang,2006年;丘格兰和坎宁安,2014年).

我们将通过显示Andronov-Hopf分岔的存在来开始对2D GRU观测到的非局部动力学的研究,其中稳定的不动点分岔为一个极限环包围的不稳定不动点。极限环是一个具有明确吸引域的吸引集。然而,与稳定的不动点不同,在稳定的不动点中,在吸引池中初始化的轨迹流向单个点,极限环将轨迹拉入稳定的周期轨道。如果周期轨道围绕不稳定的不动点,则吸引子为自激,否则为隐藏吸引子(梅斯,2007). 虽然在各种二维系统中都观察到了隐藏吸引子,但在二维GRU系统中却没有发现它们,我们推测它们并不存在。如果所有参数都设置为零,除了隐藏状态权重,这些权重被参数化为具有相关增益的旋转矩阵,那么我们可以将旋转作为增益和旋转角度的函数引入向量场。正确调整这些参数将导致极限循环;饱和非线性的结果阻碍了距离原点足够远的旋转流速,从而将轨迹拉向闭合轨道。

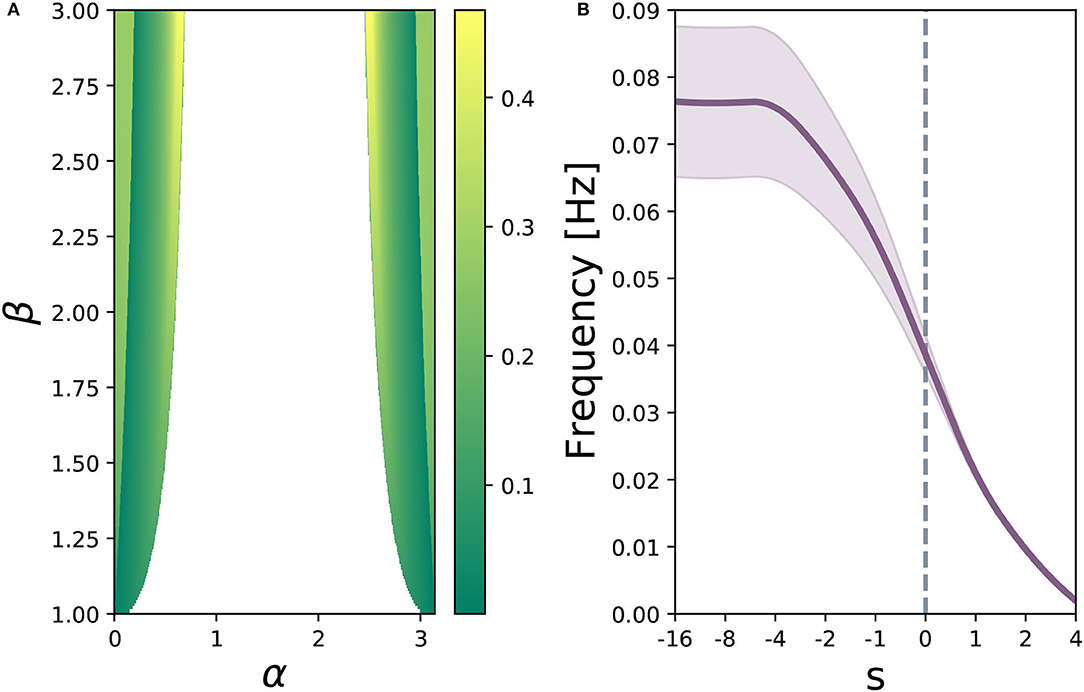

对于α,β∈ℝ+和秒∈ℝ,

设β=3和秒= 0. 如果,系统有一个稳定的固定点(稳定螺旋),如所示图5A.如果我们不断减小α,系统将在大约.随着α的不断减小,轨道周期增加,并且由于零点可以任意靠近,所以可以任意设置该轨道周期的长度。图5B显示了相对较短轨道周期的示例,以及图5C描述了慢轨道的行为。如果我们继续允许α减小,系统将同时经历四次鞍节点分岔,并最终处于拓扑等效于中描述的状态图2A.图6A描述了由方程(8)参数化的方程(7)参数空间的区域,其中可以清楚地看到Andronov-Hopf分支流形。图6B演示了重置门对振荡频率的一种影响。如果我们改变偏置矢量b条第页α−β参数空间中呈现极限环的区域的预期振荡周期发生变化。从计算上讲,极限环是模拟神经元爆发的一种常见的动力学结构(伊日凯维奇,2007年)发生在许多基础工程中,包括霍奇金-霍克斯利模型(霍奇金和赫胥黎,1952年)和FitzHugh-Nagumo模型(菲茨休,1961年). 这种动态也出现在人工任务中的各种人口水平动态中,例如正弦波生成(苏西洛和巴拉克,2012年). 此外,初始化隐藏状态矩阵U型小时理论上证明,当所有块都充当解耦振荡器时,沿对角线具有2×2块且其他地方都为零的偶数维连续时间RNN(tanh或GRU)有助于学习长期相关性(Sokół等人,2019年).

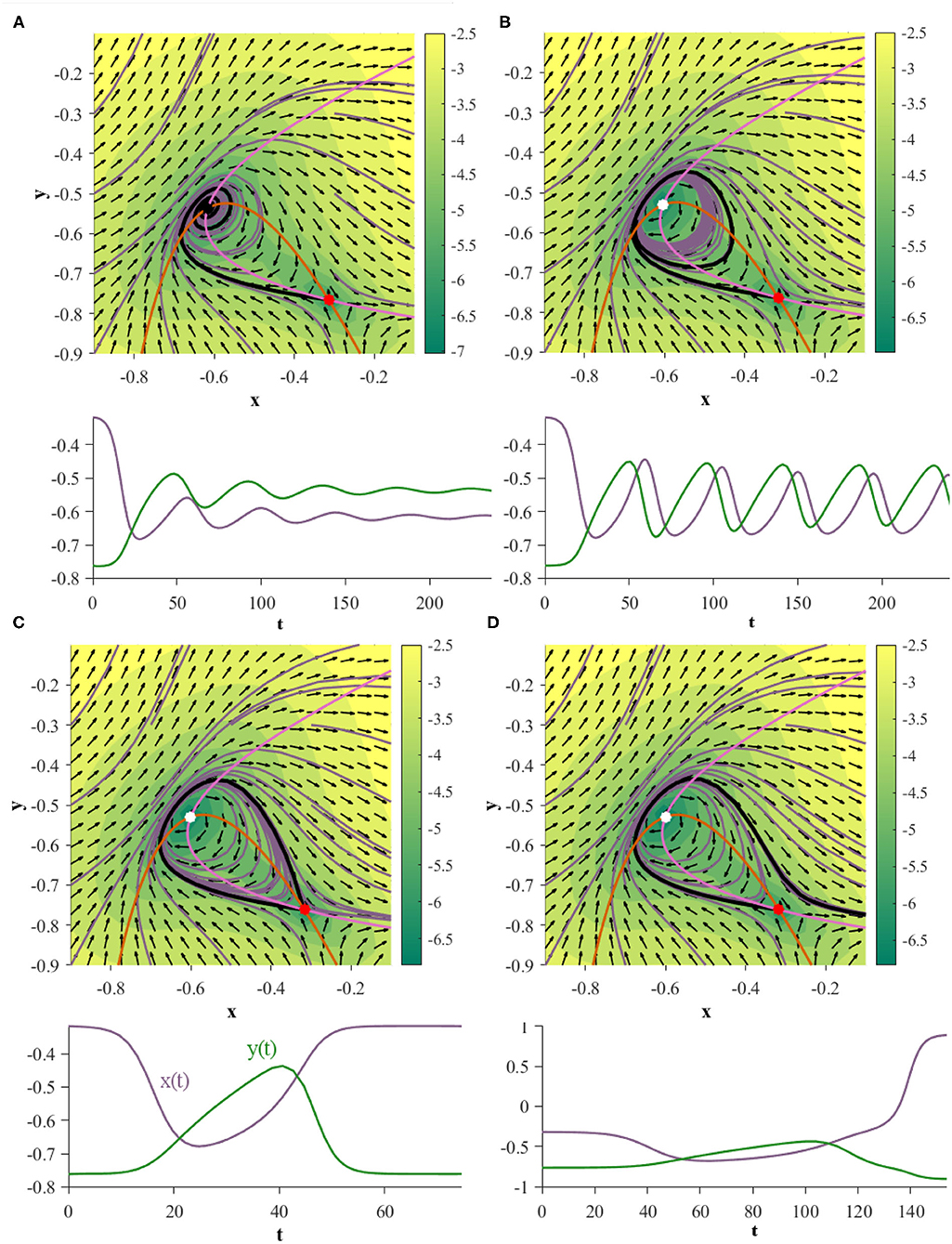

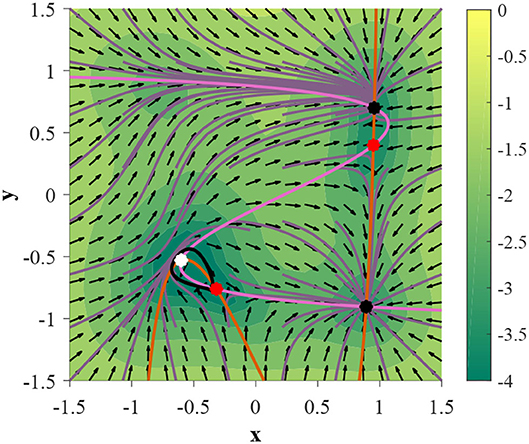

关于第二个非局部动力学特征,可以证明二维GRU可以经历同宿分岔,其中周期轨道(在这种情况下为极限环)在分岔点扩张并与鞍碰撞。在这个分岔点,系统表现出一个同宿轨道,在这个轨道上初始化的轨道在向前和向后的时间都落入同一个不动点。为了演示此行为,请按如下方式定义网络参数:

对于γ∈ℝ,

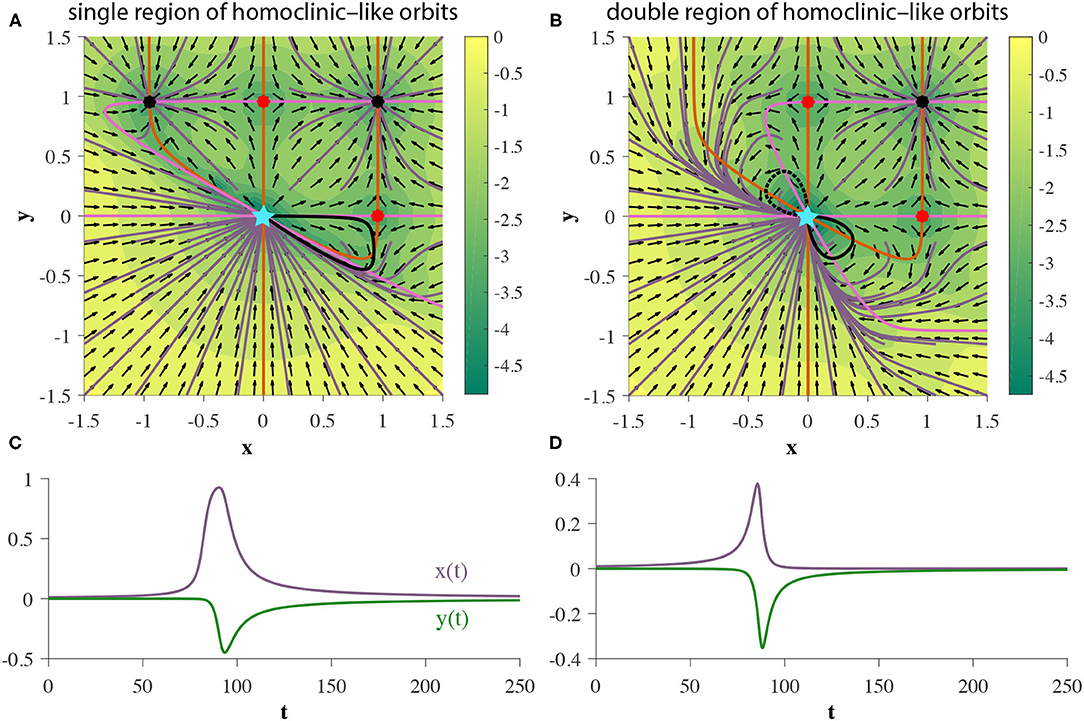

在这种参数化下,当γ=0.054085时,二维GRU系统表现出同宿轨道(图7). 为了展示这种分岔以及之前的Andronov-Hopf分岔在行动中的顺序,我们转向图8,其中参数由方程(9)定义,γ初始化为0.051 in图8A.

除了适当的同宿轨道外,我们还观察到,对于给定的参数集,2D GRU可以显示一个或两个同宿类轨道的有界平面区域,如图9A、B分别是。在这些区域之一初始化的任何轨迹都将流入原点处的伪二维分岔不动点,而不管时间流向哪个方向。由于伪二维分叉不动点从技术上讲是由四个不动点组成的簇,包括一个源和一个汇,如图4,实际上没有同宿环。然而,由于这些不动点非常接近,因此,由于使用有限精度,远离源但位于汇吸引域内的轨迹将呈现同宿性。这种特征行为能够准确描述各种模型,包括神经元尖峰(Izhikevich,2007年).

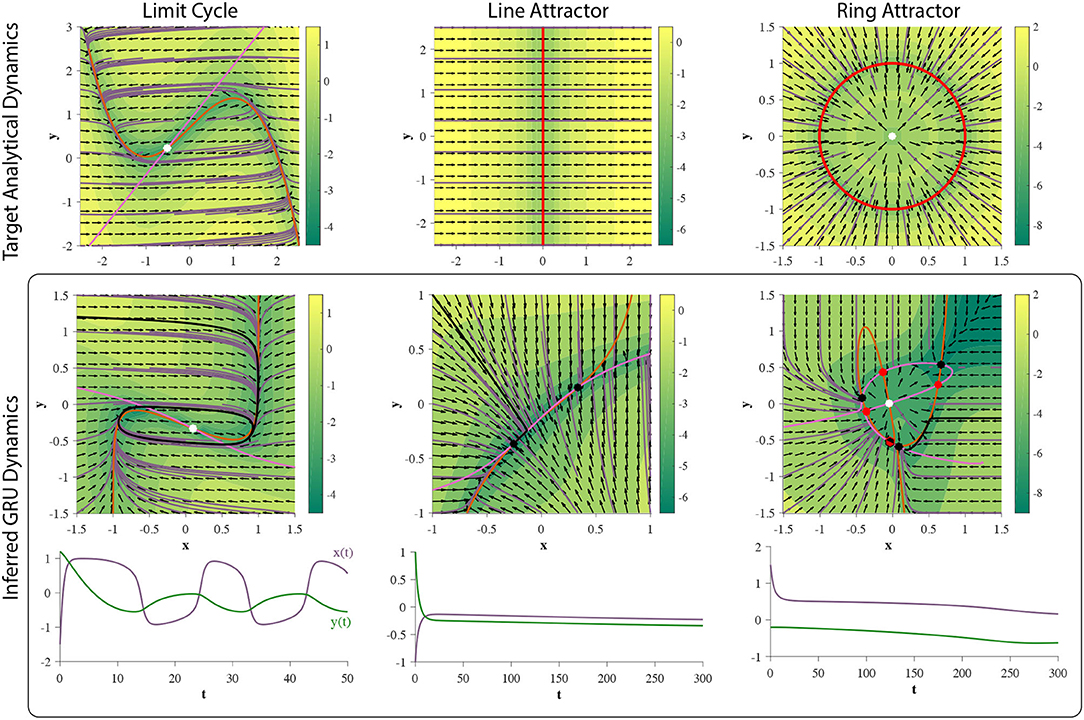

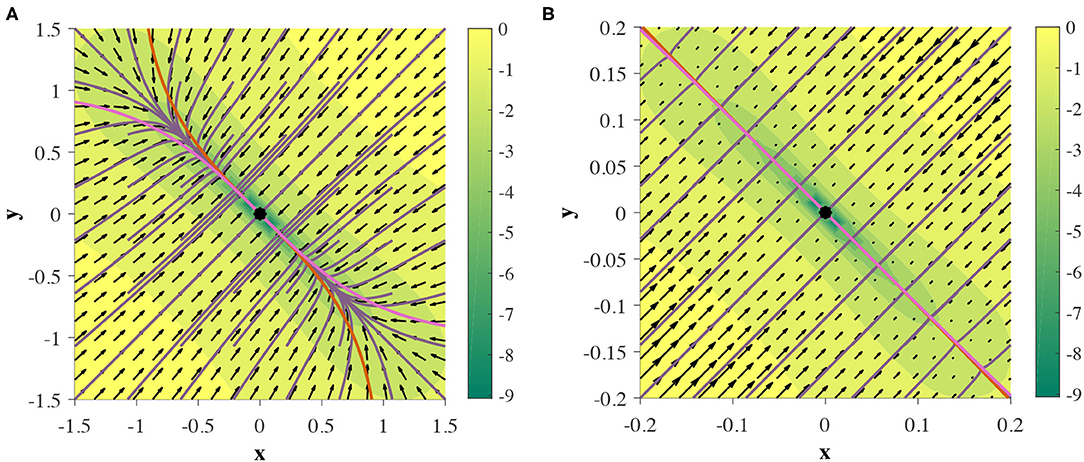

对于有限不动点拓扑和全局结构,下一个要问的逻辑问题是2D GRU可以显示无限多个固定点吗?在需要对非点结构(如线吸引子和环吸引子)进行静态吸引的模型中,这种行为通常是可取的。计算上,沿直线吸引子的运动可以解释为积分(Mante等人,2013年),在包括情绪分析在内的各种任务中,它被视为一种关键的人群水平机制(Maheswaranathan等人,2019b)和决策(Mante等人,2013年). 在类似的情况下,围绕环形吸引子的运动在计算上可以表示为模积分或算术。环形吸引子动力学在神经科学中的一个已知应用是方向的表示(Kim等人,2017年). 虽然在连续GRU系统中还没有看到这种行为,但可以对线吸引子进行近似,如所示图10。我们将此现象称为伪线吸引子,其中零点在一个小的有限间隔内保持足够接近,从而允许通过慢点任意缓慢流动。

5.实验:时间序列预测

作为将我们的理论付诸实践的一种手段,在本节中,我们探讨了使用2D GRU对连续时间平面动力系统进行时间序列预测的几个示例。上一节的结果表明了此RNN可以学习哪些动态特性,并建议了哪些训练会失败。以下所有计算机实验都由RNN组成,其中隐藏层由2D GRU组成,然后是线性输出层。该网络经过训练,可以根据给定的初始观测值进行29步预测,而无需通过预测进行进一步输入。因此,为了产生准确的预测,RNN必须完全依赖于隐藏层动力学。

我们对网络进行训练,以最大限度地减少以下多步骤损失函数:

其中θ是GRU和线性读数的参数,T型=29是预测范围,w个我(t吨)是我-真实系统生成的第个时间序列,以及是k个-给定的步长预测w个0.

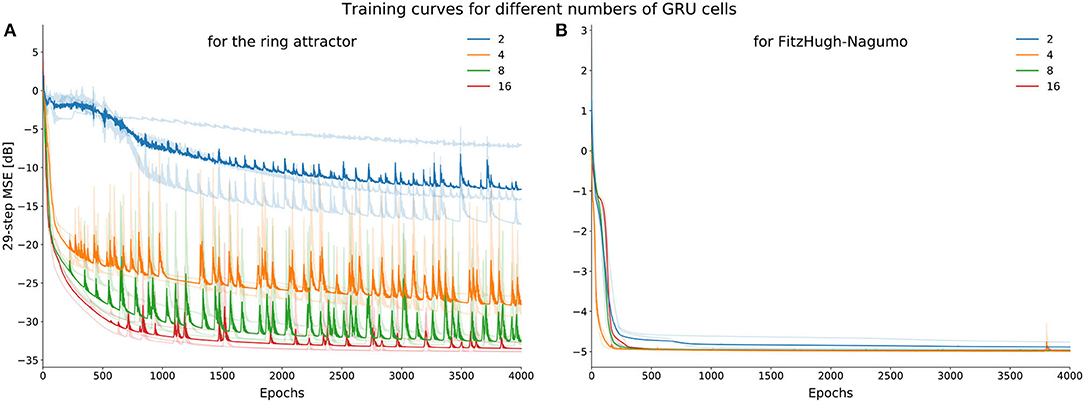

每个轨迹的隐藏状态初始化为零。然后使用ADAM对RNN进行4000个时代的训练(Kingma和Ba,2014年)在整批模式下,使损失函数最小化,即预测轨迹与数据之间的均方误差。N个traj公司=667个时间序列用于训练。图11描述了RNN尝试学习我们下面描述的每个动力学系统的实验结果。

5.1. 极限循环

为了测试2D GRU是否可以学习极限环,我们使用一个简单的非线性振荡器,称为FitzHugh-Nagumo模型(FitzHugh,1961年). FitzHugh-Nagumo模型定义如下:,在本实验中,我们将选择τ=12.5,一= 0.7,b条=0.8,以及在这种模型参数的选择下,系统将呈现一个由极限环包围的不稳定不动点(不稳定螺旋)(图11). 如第4节所示,2D GRU能够表示此拓扑。实验结果证实了这一说法(图11),因为2D GRU可以捕获拓扑等效动力学。

5.2. 线条吸引器

如第4节所讨论的,2D GRU可以显示伪线吸引子,通过该吸引子系统可以在一个小的有限域上模拟解析线吸引器。我们将使用平面线吸引子的最简单表示:ẋ = −x个, ẏ = 该系统将沿着年-轴,位于x个= 0 (图11). 轨迹将直接垂直于吸引子流动。高斯白噪声在训练数据中。虽然训练网络的隐藏状态动力学与解析线吸引子的隐藏状态动态不完全匹配,但作为伪线吸引器的每个不动点附近都存在一个小的子区间(图11). 因此,添加的仿射变换(线性读出)可以在有限域上缩放和重定向此子区间。由于d维GRU中的所有吸引子都绑定到[-1,1]d日,没有线吸引子可以在任何给定方向上无限延伸,这与GRU无法执行无界计数很好地匹配,因为这样的任务的连续模拟需要沿着这样的吸引子移动轨迹。

5.3. 环形吸引器

对于这个实验,使用了一个代表半径为1的标准环吸引子的动力学系统:ẋ = −(x个2+年2− 1)x个; ẏ = − (x个2+年2−1)年这个系统展示了一个以不稳定不动点为中心的吸引环。我们添加了高斯噪声在训练数据中。

在我们的分析中,我们没有观察到两个GRU表现出这一组动力学,并且该实验的结果在图3periments表示他们不能。相反,隐藏状态动力学属于观察到的有限不动点拓扑(参见补充材料). 此外,我们可以在多次初始化中看到这一点,并且随着GRU维数的增加,近似的质量也会提高(图12),表明对于实际任务,需要许多GRU来获得这组动力学的足够近似值(Funahashi和Nakamura,1993年).

6.讨论

通过示例和实验,我们指出了在表达各种已知的神经计算中至关重要的动力学类,并可通过2D GRU网络获得。我们证明了系统无法学习连续吸引子,似乎在任何有限维中,一种假设存在于各种神经表示中的结构。虽然GRU网络最初不是作为神经科学模型制作的,但已有大量工作表明,神经记录和人工RNN的潜在动力学在人口水平上具有高度的定性相似性(Mante等人,2013年;Sussillo等人,2015年). 此外,最近的研究修改了这种人工模型,以模拟各种神经生物学现象(Heeger和Mackey,2019年). 最近的一项研究表明,不同体系结构和非线性的训练后的RNN在相同任务上训练成功后,彼此表达出非常相似的不动点拓扑(Maheswaranathan等人,2019a),表明人工网络动力学和神经种群动力学之间可能存在联系。因此,对GRU网络中可获得的动力学特征的理解可以让人们评论使用这种架构作为人群水平上大脑动力学模拟的有效性。

尽管这份手稿通过考虑2D GRU简化了问题,但许多研究已经将皮层动力学解释为低维连续时间动力学系统(Harvey等人,2012年;Mante等人,2013年;Cueva等人,2020年;麦克道尔和巴斯曼,2020年;赵和朴,2020年;Flesch等人,2021年). 这并不是说,大多数受神经科学启发的标准任务都可以用这样一个低维网络来解决。然而,证明神经科学中常见的动力学特征可以出现在低维中,有助于人们对大型网络的属性进行评论。这些属性包括突触连接稀疏等特征。例如,显示稀疏连接的尖峰模型已被证明与完全连接的RNN相比表现良好(Bellec等人,2018年). 此外,众所周知,修剪(即删除)训练RNN中相当大比例的突触连接通常会导致网络在训练任务上的性能几乎没有下降(Frankle和Carbin,2019年). 这表明大型网络还有两个可检验的属性。第一个是在同一网络中进行计算所需的动力机制的冗余或多重实现。例如,如果只有一个极限环足以准确地执行所需任务,则经过训练的网络可能会出现多个极限环,每种方法在质量上对整体计算的作用是相同的。第二是每个拓扑结构对突触扰动/剪枝的鲁棒性。例如,如果我们有一些动力学结构,比如极限环,我们在参数空间中可以移动多少,同时仍然保持该结构的存在?

在相关方面,GRU体系结构已被用于更复杂的机器学习设置中,以解释神经记录的实时动态(Pandarinath等人,2018年;Willett等人,2021年). 这些工具使研究人员能够更好地理解和研究神经反应之间的差异。对GRU网络的内部工作原理和表达能力的了解只能通过前面所述的相同推理路线,进一步加深我们对此类设置的局限性和优化的理解,从而有助于推进这类技术,帮助整个神经科学领域。

与GRU相比,RNN体系结构最相似的是LSTM,因为GRU被设计为离散时间实现中该预先存在设计的模型和计算简化。在相当长的一段时间内,LSTM可以说是最流行的离散时间RNN体系结构,在许多基准任务上优于其他时间模型。然而,在比较LSTM和GRU的连续时间实现时有一个警告。一维LSTM(即单个LSTM单元)是一个二维动态系统,因为信息存储在系统的隐藏状态和单元状态中(Hochreiter和Schmidhuber,1997年). 通过选择本文中用于剖析GRU的分析,LSTM是一种截然不同的系统类别。与2D GRU相比,我们预计LSTM装置的动力学阵列会有所不同,且更加有限。然而,我们不认为这是一个公平的比较。

我们在这份手稿中选择忽略的GRU架构的一个属性是更新门的影响z(z)(t吨). 如第2节所述,此门的每个元素都绑定到(0,1)d日由于方程(7)只有一个包含更新门的项,[1−z(z)(t吨)]不动点拓扑不依赖于z(z)(t吨),因为这个词总是严格意义上的正数。该闸门的作用是调节水流的点速度,因此可以使缓慢的歧管上升。因为每个元素z(z)(t吨)与更新门的一个元素相关联的相位空间的足够靠近一的区域将在与这些元素相关联的方向上似乎没有运动。例如,在2D GRU系统中,如果z(z)(t吨)距离1足够近,轨迹将在x个。这些慢点不是实际的固定点。因此,在自主系统中,如果有足够的时间,穿过它们的轨迹最终将克服这种中断。然而,这可能会为分析实际实施的连续时间GRU增加一个复杂因素。有限精度的使用允许流速低于机器精度,本质上是创造伪吸引子在这些地区。包含这些点的相空间区域将定性地表现为吸引集,而不是传统的动力系统术语,这使得它们更难分析。如果需要,我们建议查看z(z)(t吨)因为这个术语独立于连续时间系统中的其余术语。所以,任何发现的慢点都可以与相空间中的传统不动点叠加。为了避免有限精度的影响,该系统可以通过硬件实现(约旦和帕克,2020年). 然而,需要给予适当的注意,以减轻模拟缺陷。

与更新门不同,我们演示了重置门第页(t吨)影响网络的不动点拓扑,允许更复杂的动力学类,包括同质性轨道。这些效果最好通过零线的形状来描述。我们将在这里保持事物的定性,以帮助建立直觉。在2D中,如果重置门权重矩阵的每个元素U型第页和偏见b条第页为零,则nullclines可以形成两个形状。首先是一个乙状形状(图5A,10,11; 推断的极限环和线吸引子),允许它们与与其关联维正交的线(或更高维的超平面)相交一次。第二个是s型形状(图5B、C,7,11; 极限环),允许它们与与其关联尺寸正交的直线相交最多三次。s形的波峰和波谷也可以无限延伸(图2A). 在这种情况下,与给定维度相关联的三个看似断开的零线中的两个可以任意地放在一起(图3B). 不同的第页(t吨)允许nullclines的几何体呈现多个其他形状。这些附加结构中的第一个是像草叉一样的形状(图3A、C,9). 通过断开两个尖头从干草叉我们得到了第二个结构,同时显示出一个sigmoid形状和一个优莱克形状(图3C). 将无穷远处的“U”端向下弯曲成ℝ2连接它们,形成我们的第三个结构O型形状(图3围壁;推断出的环吸引器–橙色nullcline)。然后,这种O形形状也可以与nullcline的附加线段相交,从而创建一条连续的曲线(图3围壁;推断出的环吸引子-粉红色nullcline)。重置门的一个结果是增加了以稳定不动点形式编码信息的能力。如果我们忽视第页(t吨),我们最多可以获得四个水槽(图2A),因为我们仅限于零线的交点;两组三条平行线。公司注册第页(t吨)增加可获得的固定点数量(图3A). 请参阅补充材料看看这些零点结构是如何导致大量不同的不动点拓扑的。

这项工作的几个有趣的扩展立即浮现在脑海中。首先,三维连续时间GRU网络的扩展为更复杂的动力学特性的可能性打开了大门。在非线性系统中,三个空间维度是体验混沌动力学所需的最小值(梅斯,2007),并且由于GRU参数空间的巨大尺寸,即使在低维中,这种行为也是可能的。类似地,可能存在其他类型的分岔,包括极限环分岔,允许更复杂的振荡行为(库兹涅佐夫,1998年). 此外,高维GRU可能会产生复杂的中心流形,需要对中心流形进行简化以更好地分析和解释相空间动力学(卡尔,1981年). 虽然我们认为底层GRU拓扑与训练是分开的,但考虑吸引子结构如何影响学习可以为成功实现RNN模型带来洞察力(Sokół等人,2019年). 到目前为止,这一研究主题大多还未被阐明。我们相信,这些发现以及本手稿中提出的工作,将为研究递归神经网络的可训练性开辟新的途径,并有助于进一步理解其与生物神经网络的数学相似性。

数据可用性声明

本文中包含了研究中提出的原始贡献/补充材料,可向相应作者进行进一步查询。

作者贡献

IJ进行了分析。IJ、PS和IP撰写了手稿。PS进行了数值实验。IP构思了这个想法,建议并编辑了手稿。所有作者都已阅读并批准了最终稿。

基金

这项工作得到了NIH EB-026946和NSF IIS-1845836的支持。IJ得到了石溪大学高级计算科学研究所研究员奖学金的部分支持。

利益冲突

作者声明,该研究是在没有任何可能被解释为潜在利益冲突的商业或金融关系的情况下进行的。

致谢

我们感谢Josue Nassar、Brian O'Donnell、David Sussillo、Aminur Rahman、Denis Blackmore、Braden Brinkman、Yuan Zhao和D.S就本手稿的分析和写作提供的有益反馈和对话。

补充材料

本文的补充材料可以在以下网站上找到:https://www.frontiersin.org/articles/10.3389/fncom.2021.678158/full#补充-材料

脚注

工具书类

Beer,R.D.(1995)。关于小型连续时间递归神经网络的动力学。适应。贝哈夫. 3, 469–509. doi:10.1177/105971239500300405

PubMed摘要|CrossRef全文|谷歌学者

Beer,R.D.(2006)。连续时间递归神经网络的参数空间结构。神经计算. 18, 3009–3051. doi:10.1162/neco.2006.18.12.3009

PubMed摘要|CrossRef全文|谷歌学者

Bellec,G.、Salaj,D.、Subramoney,A.、Legenstein,R.和Maass,W.(2018年)。长短期记忆和在尖峰神经元网络中学习。arXiv:1803.09574[cs,q-bio].arXiv:1803.09574.

谷歌学者

Bengio,Y.、Simard,P.和Frasconi,P.(1994年)。学习梯度下降的长期依赖性是困难的。IEEE传输。神经网络. 5, 157–166. doi:10.1109/72.279181

PubMed摘要|CrossRef全文|谷歌学者

Carr,J.(1981)。中心流形理论的应用,1982年版纽约州纽约市;海德堡;柏林:斯普林。

谷歌学者

Chen,R.T.Q.、Rubanova,Y.、Bettencourt,J.和Duvenaud,D.K.(2018年)。“神经常微分方程”,in神经信息处理系统进展,第31卷,编辑S.Bengio、H.Wallach、H.Larochelle、K.Grauman、N.Cesa Bianchi和R.Garnett(蒙特利尔,QC:Curran Associates,Inc.)。

谷歌学者

Cho,K.、van Merrienboer,B.、Gulcehre,C.、Bahdanau,D.、Bougares,F.、Schwenk,H.等人(2014年)。使用RNN编码器-解码器学习短语表示以进行统计机器翻译。arXiv:1406.1078[cs,统计].arXiv:1406.1078号.doi:10.3115/v1/D14-1179

CrossRef全文|谷歌学者

Choi,K.、Fazekas,G.、Sandler,M.和Cho,K.(2017年)。《用于音乐分类的卷积递归神经网络》2017 IEEE声学、语音和信号处理国际会议(ICASSP)(新奥尔良,洛杉矶:IEEE),2392–2396。

谷歌学者

Churchland,M.M.和Cunningham,J.P.(2014)。用于生成河段的动态基础集。冷泉港。交响乐团。数量。生物. 79, 67–80. doi:10.1101/sqb.2014.79.024703

PubMed摘要|CrossRef全文|谷歌学者

Costa,R.、Assael,I.A.、Shillingford,B.、de Freitas,N.和Vogels,T.(2017)。《大脑皮层微电路作为门循环神经网络》神经信息处理系统的进展30,eds I.Guyon,U.V.Luxburg,S.Bengio,H.Wallach,R.Fergus,S.Vishwanathan,R.和Garnett(加州长滩:Curran Associates,Inc.),272-283。

谷歌学者

Cueva,C.J.、Saez,A.、Marcos,E.、Genovesio,A.、Jazayeri,M.、Romo,R.等人(2020年)。工作记忆和时间编码的低维动态。程序。国家。阿卡德。科学。美国. 117, 23021–23032. doi:10.1073/美国国家统计局.1915984117

PubMed摘要|CrossRef全文|谷歌学者

Doya,K.(1993)。梯度下降学习中递归神经网络的分支。IEEE传输。神经网络. 1, 75–80.

谷歌学者

Dwibedi,D.、Sermanet,P.和Tompson,J.(2018年)。《使用卷积选通递归单元的视频中的时间推理》IEEE计算机视觉和模式识别(CVPR)研讨会会议记录(犹他州盐湖城)。

谷歌学者

FitzHugh,R.(1961年)。神经膜理论模型中的冲动和生理状态。生物物理学。J型. 1, 445–466. doi:10.1016/S0006-3495(61)86902-6

PubMed摘要|CrossRef全文|谷歌学者

Flesch,T.、Juechms,K.、Dumbalska,T.,Saxe,A.和Summerfield,C.(2021)。大脑和神经网络中任务表征的丰富和懒惰学习。bioRxiv,2021.04.23.441128年冷泉港实验室部分:新结果。

谷歌学者

Funahashi,K.-I.和Nakamura,Y.(1993年)。用连续时间递归神经网络逼近动力系统。神经网络. 6, 801–806. doi:10.1016/S0893-6080(05)80125-X

PubMed摘要|CrossRef全文|谷歌学者

Harvey,C.D.、Coen,P.和Tank,D.W.(2012年)。虚拟飞行决策任务期间顶叶皮层的选择特异性序列。自然484, 62–68. doi:10.1038/nature10918

PubMed摘要|CrossRef全文|谷歌学者

He,K.、Zhang,X.、Ren,S.和Sun,J.(2016)。《图像识别的深度残差学习》2016年IEEE计算机视觉和模式识别会议(CVPR)(内华达州拉斯维加斯:IEEE),770-778。

PubMed摘要|谷歌学者

Heath,M.T.(2018)。《科学计算:导论调查》,第二版修订SIAM-工业和应用数学学会,费城,第二版(纽约州纽约市)。

谷歌学者

Heeger,D.J.和Mackey,W.E.(2019)。振荡递归门控神经积分器电路(ORGaNIC),神经动力学的统一理论框架。程序。国家。阿卡德。科学. 116, 22783–22794. doi:10.1073/pnas.1911633116

PubMed摘要|CrossRef全文|谷歌学者

Hochreiter,S.(1991)。Untersuchungen zu动态神经网络(博士论文),慕尼黑大学。顾问J.Schmidhuber。

谷歌学者

Hochreiter,S.和Schmidhuber,J.(1997年)。长短期记忆。神经计算. 9, 1735–1780. doi:10.1162/neco.1997.9.8.1735

CrossRef全文|谷歌学者

霍奇金·A.L.和赫胥黎·A.F.(1952)。膜电流的定量描述及其在神经传导和兴奋中的应用。生理学杂志. 117, 500–544. doi:10.1113/jphysiol.1952.sp004764

PubMed摘要|CrossRef全文|谷歌学者

伊日凯维奇,E.M.(2007年)。神经科学中的动力系统马萨诸塞州剑桥:麻省理工学院出版社。

谷歌学者

Kim,S.S.、Rouault,H.、Druckmann,S.和Jayaraman,V.(2017年)。中的环形吸引子动力学果蝇属中央大脑。科学类356849–853.doi:10.1126/science.aal4835

PubMed摘要|CrossRef全文|谷歌学者

Kingma,D.P.和Ba,J.(2014)。亚当:一种随机优化方法。arXiv:1412.6980[cs]。arXiv:1412.6980。

谷歌学者

库兹涅佐夫,Y.A.(1998)。应用分叉理论基础第二版.柏林;海德堡:斯普林格·弗拉格。

谷歌学者

Laurent,T.和von Brecht,J.(2017年)。“无混沌的递归神经网络”,in2017年第五届国际学习代表大会(土伦)。

谷歌学者

LeVeque,R.J.和LeVeque,R.(1992年)。守恒定律的数值方法,第2版.巴塞尔协议;马萨诸塞州波士顿:Birkhäuser。

谷歌学者

MacDowell,C.J.和Buschman,T.J.(2020年)。低维时空动力学是皮层神经活动的基础。货币。生物.30、2665.e8–2680.e8。doi:10.1016/j.cub.2020.04.090

PubMed摘要|CrossRef全文|谷歌学者

Maheswaranathan,N.、Williams,A.、Golub,M.、Ganguli,S.和Sussillo,D.(2019a)。《神经动力学在大量递归网络中的普遍性和个体性》神经信息处理系统进展,第32卷eds H.Wallach、H.Larochelle、A.Beygelzimer、F.d’Alché-Buc、E.Fox和R.Garnett(不列颠哥伦比亚省温哥华:Curran Associates公司)。

PubMed摘要|谷歌学者

Maheswaranathan,N.、Williams,A.、Golub,M.D.、Ganguli,S.和Sussillo,D.(2019b)。用于情感分类的反向工程递归网络揭示了线吸引子动力学。arXiv:1906.10720[cs,统计].arXiv:1906.10720年.

PubMed摘要|谷歌学者

Mante,V.、Sussillo,D.、Shenoy,K.和Newsome,W.(2013年)。通过前额叶皮层的循环动力学进行上下文相关计算。自然503, 78–84. doi:10.1038/nature12742

PubMed摘要|CrossRef全文|谷歌学者

Meiss,J.(2007)。微分动力系统数学建模和计算。工业和应用数学学会科罗拉多州博尔德:科罗拉多大学。

谷歌学者

Morrill,J.、Salvi,C.、Kidger,P.、Foster,J.和Lyons,T.(2021年)。长时间序列的神经粗糙微分方程。arXiv:2009.08295[cs,数学,统计].arXiv:2009.08295年.

谷歌学者

Pandarinath,C.、O'Shea,D.J.、Collins,J.、Jozefowicz,R.、Stavisky,S.D.、Kao,J.C.等人(2018年)。使用顺序自动编码器推断单次试验的神经种群动力学。自然方法15, 805–815. doi:10.1038/s41592-018-0109-9

PubMed摘要|CrossRef全文|谷歌学者

Pasemann,F.(1997)。一个简单的混沌神经元。物理。D非线性现象104, 205–211. doi:10.1016/S0167-2789(96)00239-4

CrossRef全文|谷歌学者

Prabhavalkar,R.、Rao,K.、Sainath,T.N.、Li,B.、Johnson,L.和Jaitly,N.(2017)。《语音识别的序列到序列模型比较》2017年国际演讲(ISCA)(斯德哥尔摩),939–943。

谷歌学者

Sokół,P.A.,Jordan,I.,Kadile,E.,and Park,I.M.(2019年)。“稳定极限环神经网络的伴随动力学”,in2019年第53届信号、系统和计算机Asilomar会议(加利福尼亚州太平洋格罗夫),884-887。

谷歌学者

Sussillo,D.和Barak,O.(2012年)。打开黑箱:高维递归神经网络中的低维动力学。神经计算. 25, 626–649. doi:10.1162/NECO_a_00409

PubMed摘要|CrossRef全文|谷歌学者

Sussillo,D.、Churchland,M.、Kaufman,M.T.和Shenoy,K.(2015)。为肌肉活动的产生找到自然主义解决方案的神经网络。自然神经科学. 18:1025–1033. doi:10.1038/nn.4042

PubMed摘要|CrossRef全文|谷歌学者

Thomas,J.W.(1995年)。数值偏微分方程:有限差分方法,第1版纽约州纽约市:施普林格。

谷歌学者

Weiss,G.、Goldberg,Y.和Yahav,E.(2018年)。关于语言识别中有限精度RNN的实际计算能力。arXiv:1805.04908[cs,统计].arXiv:1805.04908.doi:10.18653/v1/P18-2117

CrossRef全文|谷歌学者

Willett,F.R.、Avansino,D.T.、Hochberg,L.R.,Henderson,J.M.和Shenoy,K.V.(2021年)。通过手写实现高性能的脑-文本通信。自然593, 249–254. doi:10.1038/s41586-021-03506-2

PubMed摘要|CrossRef全文|谷歌学者

Wong,K.-F.和Wang,X.-J.(2006)。感知决策中时间整合的递归网络机制。神经科学杂志. 26, 1314–1328. doi:10.1523/JNEUROSCI.3733-05.2006

PubMed摘要|CrossRef全文|谷歌学者

Zhao,Y.和Park,I.M.(2016)。《神经轨迹的可解释非线性动态建模》神经信息处理系统(NIPS)的进展(巴塞罗那)。

谷歌学者