1.简介

想象一下由体素和仅体素组成的混合现实体验。周围的环境、对象和这种环境中的人都是由体素组成的,无论它们是真实的还是虚拟的。这种混合现实环境在视觉外观上具有内在的连贯性,将从自然发生的遮挡、碰撞和交互中受益,并将提供一个计算和工程简单优雅的系统。纯粹基于体素的方法将受益于数十年来对2D技术(如图像存储和压缩)的研究和开发,并将其转化为三维体素世界。此外,它还将受益于现有的体素研究。基于体素的混合现实(MR)体验就像在立体像素世界中漫步。

虽然体素的概念并不新鲜,已广泛用于模拟和其他计算目的,但沉浸在交互式体素空间中的实际实时体验仍处于初级阶段。在本文中,正如标题所示,我们想为在MR系统中使用体素提供一个案例,并将证明,即使使用当今可实现的低维表示,体素也可以是一种有效的MR体验传递方式。我们强调了混合现实中体素的当前可能性和未来潜力,即使今天的视觉真实性不如三角渲染等其他方法。此外,我们认为MR环境的未来将由体素决定。

我们的研发目标是远程呈现和协作、娱乐、教育和培训领域的应用场景,以及评估用户在混合现实环境中的行为。为了服务于这些场景和其他场景,我们必须能够从多个视点实时交互式地捕获、体素化、存储、处理、传输和显示用户和对象。

基于体素的混合现实使用体素(而仅使用体素)以交互实时方式直观地表示空间合并和对齐的真实和虚拟对象、主体和环境。通常,偏心体素化技术将用于在基于体素的MR系统中表示现实的可见形状,例如,通过使用外部RGB-D相机捕捉场景。

体素是体积像素,它们在三维空间中以规则的网格隔开,并且在它们之间没有间隙。与点云的类似概念相反,体素只能位于网格指定的空间中的离散位置。网格是规则的,即在整个MR体积中,所有可能的体素位置都是等距的。体素可以是任何形状,但必须全部是相同的形状,如果在空间中相邻放置,则应给观众一个无间隙的印象。立方体形状适合使用,但只要保持无间隙感知,其他形状也可以使用。

我们基于体素的方法可以被视为继当今普遍存在的高度发展的二维像素渲染技术之后的下一个合理步骤。我们对如何将2D(交互式)视频体验转变为三维、交互式、混合现实体验感兴趣,即使在当今的技术条件下也是如此。我们专注于提供这样一种立体像素体验的实时方面,以3D体验换取分辨率。

基于体素的MR环境中的所有内容都由体素表示,以实现视觉一致性。在实时呈现或在混合环境中记录之前,对真实对象、真实人物和周围环境进行体素化。即使体素允许实际的体积数据表示,即实体和空洞,通常也只会捕获真实的视觉外壳,然后将其转换为体素。使用一个或多个捕获设备(例如深度摄影机)重建真实环境或单个对象,然后将捕获的曲面元素(点、网格)转换为体素,同时在相应位置保持捕获的颜色。通常,此过程是从偏心的视角执行的,即独立于观众当前的观看位置和方向。然后,用户可以虚拟地穿过由偏心视图构建的体素空间,例如最近通过以下方法在网格环境中演示的情况林德鲍尔和威尔逊(2018)。

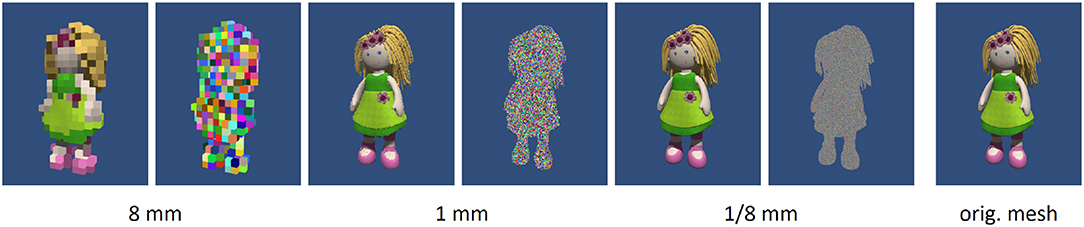

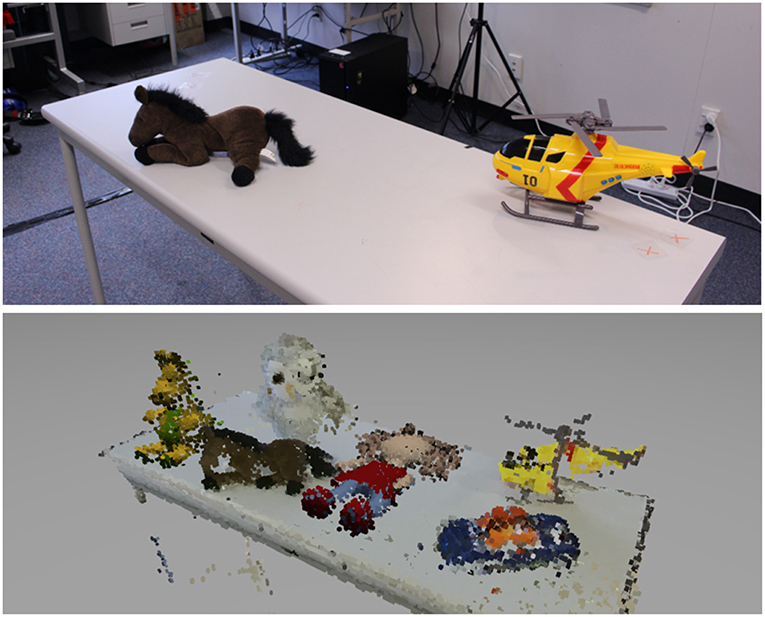

此外,所有纯虚拟元素都以类似的方式进行体素化。通常,这意味着物体的视觉分辨率将被有意降低,以实现视觉一致性。3D模型,如计算机辅助设计(CAD)对象被转换为真实比例,然后进行体素化,以便稍后集成到混合环境中,如所示图1,2所有混合现实实时、记录和虚拟元素被合并并在空间上对准到一个空间中,目的是被体验为一个相干MR空间。

我们将研究体素表示的相关工作;表明体素在MR应用中在数学和计算上也是有效的;解释为什么体素对基于体素的MR非常有效;介绍我们基于体素的MR系统的工作原型解决方案混合体素现实(MVR);使用MVR系统探索低分辨率混合现实场景的存在和共存(图1); 最后讨论分支、应用场景以及当前和未来工作的领域。

2.相关工作

我们断言体素适用于广泛的MR应用。支持这一观点的文献分为三大类。首先,体素既可以作为空间推理的有效表示,也可以作为与MR应用程序相关的许多任务的解决方案的基础。这支持了我们的断言,即体素已经准备好作为MR应用的基础广泛使用。其次,有一系列使用非真实感建模技术的MR研究。该文献表明,真实感对MR体验并不重要,因此,我们无法(目前)部署逼真度接近现实的体素模型,这并不是直接使用体素模型的根本障碍。最后,我们回顾了体素在MR系统中的现有应用,说明了这种表示已经支持的技术范围。

2.1. 基于体素的表示

体素在视觉计算中有着悠久的使用历史,具有两种常规体素网格(克利里和威维尔,1988年)和八叉树结构(米格尔,1982年)几十年来一直用于加速图形计算。其他基于树的细分方法,如k个-D棵树(宾利,1975年)和BSP树(Fuchs等人,1980年)有着同样悠久的历史。虽然基于点和网格的图形已经占据主导地位,但受GPU上硬件加速的支持,体素和其他矩形框结构仍用于加速光线跟踪等任务(科恩和谢弗,1994年;Sramek和Kaufman,2000年;Mahovsky和Wyvill,2004年),拓扑分析(科恩·奥尔和考夫曼,1995年),体积估算(Reitinger等人,2003年),碰撞检测(Nießner等人,2013a),阴影渲染(Kämpe等人,2016年)和其他复杂的照明效果(Crassin等人,2011年). 其中许多技术使用体素来近似更复杂的几何体,但在纯基于体素的系统中,这些方法不再是近似方法。

基于体素的MR特别感兴趣的一个领域是实时高效构建基于体素世界模型的能力。深度摄影机已成为此类重建的宝贵来源,虽然RGB-D摄影机的原始数据通常是点云,但体素在KinectFusion等系统中用作中间表示(Izadi等人,2011年;Newcombe等人,2011年). 通过构建固定的占用网格结构,这里使用体素从多个视图中整理信息。固定网格大小限制了重建体积,尽管这可以通过随时间移动工作体积来缓解(Roth和Vona,2012年)使用八叉树(Zeng等人,2012年)或体素散列(Nießner等人,2013b). 这些方法已扩展到大体积映射(Dai等人,2017年)和动态场景的实时重建(Dou等人,2013年,2016;Newcombe等人,2015年;Innmann等人,2016年). 体素还为基于轮廓的重建提供了方便的表示(Slenbrouck等人,2015年)因为它们可以显式地表示自由空间。同样,这些方法已经成功地扩展到动态场景的实时重建(Cheung等人,2000年;Sridhar和Sowmya,2009年). GPU加速和稀疏体素网格的使用通常是这些重建中的关键组件(Loop等人,2013年),随着nVidia的GVDB库的发布,这可能会变得更加广泛,以支持此类计算(Hoetzlein,2016年)这项工作表明,即使是复杂场景也可以实时转换为基于体素的表示,这对于基于体素MR来说至关重要。

在最近的几种语义标记方法中,体素也是基础。虽然并非所有MR应用程序都需要此类标签,但它们在辅助技术和协作虚拟工作空间的某些方面非常有用。Häne等人(2013年,2017)使用体素表示场景标签上的空间约束。他们还能够推断出未观察到的体素的标签,从而进行体积估计和体积分割。虽然他们的方法在可分配的标签数量上受到限制,但可以通过体素空间的基于块的细分进行某种程度的扩展(Cherabier等人,2016年). 规则的体素栅格也为deep提供了理想的基础卷积神经网络(CNN),正如最近由周和塔泽尔(2018)他将三维点云转换为基于体素的表示,然后应用CNN在从移动车辆捕获的数据中检测行人、汽车和骑自行车的人。由于卷积层是通过在网格上应用加权连接来工作的,因此体素空间的子体积提供了对图像补丁的直接模拟。交互式标签也通过体素支持,如语义绘制(Valentin等人,2015年)用户可以通过手势和声音提供标签。这些标签用于训练分类器,以便在提供更多信息时支持半自动标记。

真实感照片混合现实研究与开发试图将虚拟对象无缝地合并到真实场景中,并将其大部分注意力放在一致的照明上(Kronander等人,2015年). 如果这不能完美地完成,尤其是当人类角色要融入混合环境时,MR错觉可能会很快破灭。这种所谓的神秘山谷效应(Ho和MacDorman,2017年)可以通过应用非真实感渲染技术(见下文)或使用真实对象或人作为混合源来避免(Beck和Froehlich,2017年)本文也对此进行了论证。

2.2. 非真实感混合现实

在当前的保真度级别上,纯基于体素的渲染无法提供真实的世界视图。对于基于体素的MR,我们提倡对真实世界进行体素化,以便真实元素和虚拟元素变得无法区分(Regenbrecht等人,2017a). 非真实感渲染已被证明可以减少真实和虚拟对象之间的外观差异(Fischer等人,2005年)当两者都以风格化的方式渲染时,或者为了在其他不变的场景中吸引对风格化对象的注意(Haller,2004年).

Chen等人(2008)使用水彩渲染技术模糊真实和虚拟对象之间的区别,Steptoe等人(2014)比较逼真、风格化(边缘增强)和“虚拟化”(边缘检测和去饱和颜色),发现风格化的环境提供了真实和虚拟元素的最佳混合,并且所有三种处理都提供了高度的存在性和体现性。

对于视频透视AR,通常需要在渲染对象时对物理相机的噪声特性建模(Klein和Murray,2010年). 同样,这旨在通过使虚拟对象具有与低成本相机相同的噪声外观来模糊真实和虚拟之间的区别。

这项研究的共同主题是,现实主义对于在环境中建立真实和虚拟元素之间的存在感或无缝体验并不重要。相反,一个关键因素似乎是真实元素和虚拟元素具有相似的视觉特性,允许用户将虚拟视为真实。

2.3. 基于体素的混合现实

体素已经在混合现实应用程序中使用了一段时间。如前所述,体素通常用于建模和渲染虚拟元素。然而,真正基于体素的混合现实系统使用体素作为世界的显式和可见表示。许多利用体素的渲染系统,如KinectFusion(Izadi等人,2011年;Newcombe等人,2011年)体素是前面讨论的几种方法的基础数据结构,尤其是那些处理语义标签的方法(Häne等人,2013年,2017;Valentin等人,2015年;周和塔泽尔,2018年),并提供了一种直接表示自由空间的方法,允许对闭塞进行自然建模。

最近在混合现实中利用这些好处的一个例子是“混合现实”(林德鲍尔和威尔逊,2018年). 用户可以看到他们所在空间的实时重建,并且可以将虚拟、远程或预先录制的元素插入到该视图中。支持这一点的底层数据结构是一个规则的体素网格,模型的交互、修改和合成都发生在体素尺度上。然而,向用户呈现的是更传统的渲染,其中体素被转换为网格模型。然而,这样的转换并不是向用户提供引人注目的体验所必需的。Regenbrecht等人(2017a)显示了直接体素渲染,就像上面讨论的其他非真实感渲染方法一样,提供了强烈的存在感和体现感。与之前在视频中合并真实和虚拟see-through显示的工作一样(克莱因和默里,2010年),此过程中的一个关键步骤是渲染具有与物理传感器(在本例中为Kinect深度传感器)相似噪声特性的虚拟元素,以便真实和虚拟变得无法区分。

3.基于体素的MR系统的特点

基于体素的MR可以在计算和软件技术方面提供简单和优雅。这种新的简单性适用于虚拟世界的存储、计算和呈现方式,也适用于我们与它们交互的方式,从而加深对底层概念的理解。表示这种简单性的体素很容易理解和处理。如果我们以尽可能纯净的方式将系统的各个方面都简化为体素,那么我们在计算、工程以及用户体验方面都会获得许多其他方法难以实现的积极效果。然而,我们不想将基于体素的技术与这里的其他技术进行技术或经验上的基准测试;我们更想证明体素对于我们的目标混合现实体验是有效的。

在下文中,让我们看看体素在提供实时MR体验方面的更多优势:视觉一致性、统一模型处理(所有内容都表示为固定网格中的体素)、固有的内置遮挡处理以及更容易的碰撞检测。

3.1. 视觉一致性

视觉连贯性可以内在地实现,因为一切都以体素的形式表示。当今最先进的混合现实系统存在真实和虚拟元素之间的保真度差异。要么现实是高分辨率的,而虚拟现实不是(例如,光学透视增强现实),要么虚拟现实是高清晰度的,而现实不是(如,视频透视增强真实)。即使投影增强现实(通常称为空间AR)通常也无法提供无缝融合所需的质量。虽然有一些方法可以最小化这些差异,但基于体素的MR可能是根据需求进行缩放的明显选择方法。除了分辨率匹配外,还必须模拟真实世界捕获过程中的所有空间、时间和外观缺陷,以实现一致性。例如,将深度感应摄影机的闪烁和噪波效果应用于虚拟对象以将其混合。

3.2. 分辨率的可扩展性

所需的整体分辨率是可扩展的。图2显示了使用下面描述的混合体素现实系统渲染的体素化3D模型的示例分辨率。渲染的体素分辨率能够匹配真实捕捉设备的有效体素分辨率。例如,我们的(2.5米)3结合微软Kinect相机的交互体积系统,我们可以实现8毫米的体素分辨率(体素边缘长度)。如果这些设备的分辨率增加,则虚拟分辨率可以与此增加相匹配,并且图2显示了体素大小小于1/8毫米的示例。然而,当前的离线计算硬件实际上可以处理分辨率为4-8 mm的1000万个体素场景(Regenbrecht等人,2017a)而体素分辨率尚不能满足MR应用的交互性要求。

3.3. 视觉遮挡、交互和碰撞

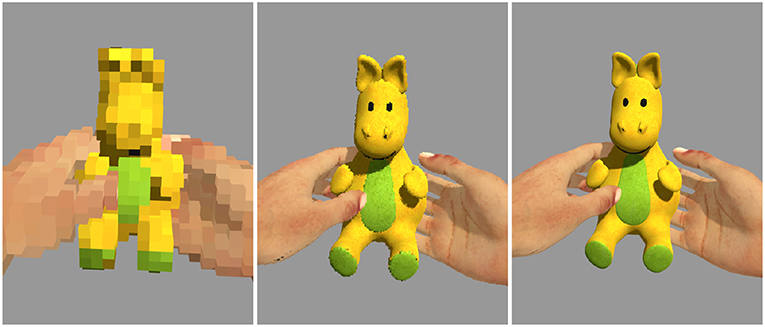

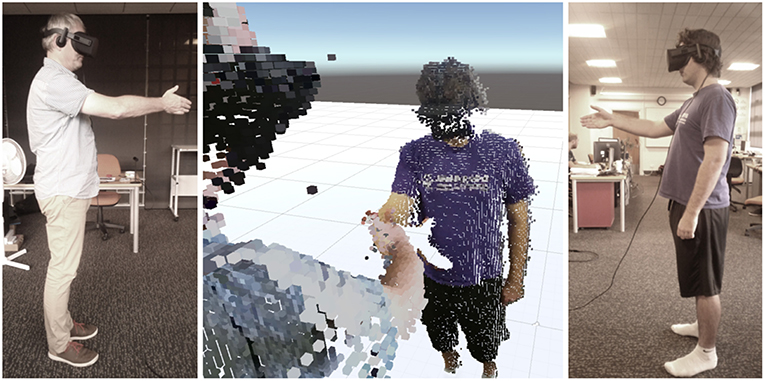

而传统的遮挡处理在虚拟现实中,尤其是混合现实中(Collins等人,2017)是一个具有挑战性的研究课题,基于体素的混合现实方法从本质上解决了这一问题。每个体素都有一个“自然”深度位置,因此可以正确处理所有场景遮挡(在体素分辨率的限制范围内)。由于真实对象和虚拟对象的处理方式相同,因此甚至不存在真实-虚拟遮挡冲突,例如手动交互通常会发生这种冲突。图3说明了如何解决虚拟对象和交互手之间的相互遮挡。

类似地,碰撞,特别是场景中所有对象之间的手动交互,可以以计算高效和更可预测的方式处理,例如,用户的手与体素环境中的虚拟对象的碰撞(参见图3). 从计算上来说,计算所讨论的体素之间的碰撞是非常便宜的。此外,用户与对象的交互基于实际交互点(体素),而不是基于任何可能令人困惑的不可见代理几何体(如碰撞器)。此外,由于底层的体素栅格,可以使用计算成本低廉的碰撞器,如球体。

4.混合体素现实系统

在我们的实验室环境中,我们实现了一个原型系统,该系统允许基于体素的混合现实的实际体验,即,对于用户来说,环境中除了体素之外,没有其他元素。这需要(a)捕获和体素化真实环境,(b)将真实环境(元素)作为体素进行记录和回放,(c)三维模型(CAD模型)的体素化,以及对于非共存环境,通过网络传输体素数据。我们的系统集成到Unity场景图中,我们的源代码将公开。

4.1. 捕获

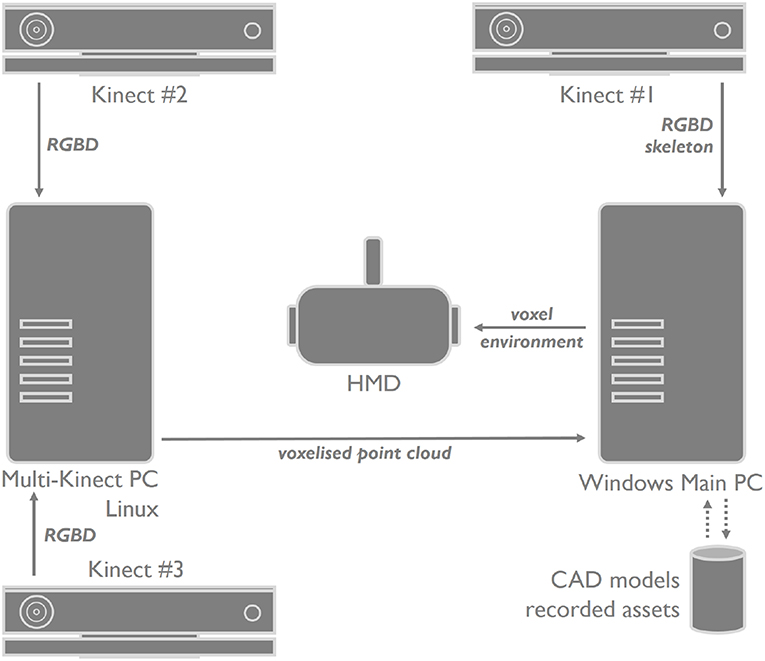

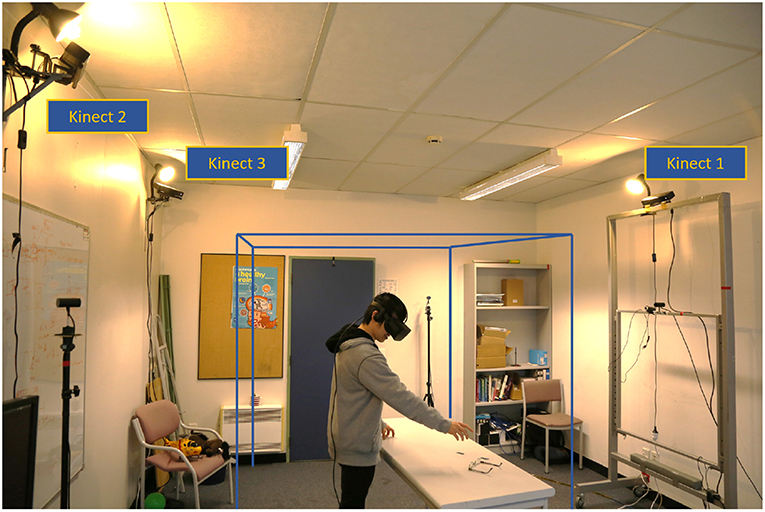

该系统的早期版本仅支持共用(非联网)用户,并且只使用一个Kinect摄像头(Regenbrecht等人,2017a); 在这里,使用三个Kinect摄像头拍摄真实环境(图5). Kinect相机#1是我们的主相机,连接到(Windows)计算机,该计算机也是我们提供视觉体素体验的主计算机。头戴式显示器及其跟踪系统也连接到该主计算机。

此外,另外两个Kinect摄像头(#2和#3)连接到第二台(Linux)计算机,该计算机预处理两个RGB-D数据流,并通过专用网络端口将数据发送到主计算机(图4). 我们的多Kinect服务器(MKS)基于Beck等人的校准多个RGB-D传感器的实现(Beck和Froehlich,2017年). 我们使用了他们用于实现多Kinect服务器的相同Libfreenect2库,以及用于在多线程上并发RGB-D数据采集的C++Boost库。我们还使用了ZeroMQ中间件框架在本地发送RGB-D数据,因为他们的系统提供了接收RGB-D(使用ZeroMQ)数据、对RGB-D进行体素化以及通过UDP发送体素数据的方法。当MKS获取新的RGB-D图像帧时,将调整彩色图像以适应深度传感器的视野。因为我们为每个Kinect设备使用并发Boost线程,所以Boost barrier对象用于同步所有Kinect线程,以确保每个线程同时处理RGB-D数据。否则,如果没有同步,某些线程处理RGB-D图像帧的速度可能会比其他线程快,从而在某个时间点产生不同的图像。然后,每个Kinect处理后的RGB-D帧被写入ZMQ消息,然后发送到体素化服务器。体素化器应用程序接收这些ZMQ消息,读取RGB-D帧,从RGB-D图像中获取彩色点云数据,然后基于用户定义的边界框(或体素空间)对点云进行体素化。然后,体素位置被截断为无符号短整数,并通过UDP发送到我们的主MVR系统。我们还使用不同的端口将所有RGB-D数据作为单独的实例发送,以便我们可以手动校准每个Kinect(使用Unity场景图),但代价是帧不同步,校准简单。虽然我们也可以实施Beck等人的多Kinect校准方法,但我们选择了手动校准程序,因为我们不需要亚毫米精度,因为我们的体素大小受到Kinect分辨率的限制(导致8毫米体素分辨率)。此外,非同步帧在这里就足够了,因为我们要么只捕获静态环境/对象,要么动态对象(记录的人)移动速度不够快,导致体素对齐问题。不过,未来更高的体素分辨率和更快移动对象的可能录制将需要同步。

我们从主Kinect接收的骨骼数据用于将体素分配给身体部位以供未来使用,与本文报道的研究和应用场景无关。此外,虽然基础设施可以容纳三台以上的Kinect摄像头,但我们将数量限制为三台。这也缓解了多个Kinect相机之间产生时间噪声的干扰问题(空中和物体周围的体素闪烁)。

4.2. 录音和放音

与稍后在基于体素的MR场景中回放时一样,使用相同的系统设置来记录环境中的对象或人。录制在主计算机上完成,录制的场景被逐帧存储。

在我们的系统中,体素表示为3D位置和颜色。我们系统中的体素位置表示立方体的一个角。体素颜色使用RGBA颜色空间表示。总共一个体素可以用16个字节表示:x、y、z位置的三种浮点数据类型(12个字节),以及每个红色、绿色、蓝色和alpha通道的四个字节数据类型(四个字节)。一个体素帧被存储为体素列表,一个体元(录制)视频被存储为一个体素帧列表。

记录的体素文件的大小取决于当前的体素分辨率-较高的分辨率会增加场景的整体体素计数。作为指导原则,8 mm体素每个体素帧生成大约200–250 kB。一秒钟的录制大约占用7 MB,30秒的录制总计约200 MB。录制完成后,使用C#标准库序列化捕获的体素帧,并将其存储为二进制文件。

记录的体素数据是相对于用户定义的体素空间和大小存储的,因此可以直接反序列化并回放到Unity场景中。此外,假设定义的体素空间和大小与录制相同,则将在其原始位置播放。根据Kinect的帧速率每秒记录30帧。

我们还没有为此投资压缩技术,我们录制的剪辑被存储和加载,没有任何显著的延迟。我们没有使用任何优化或压缩技术,但出于我们的目的,记录的文件仍然小到可以有效处理。

4.3. 网络

为了支持我们的远程呈现和协作应用场景,我们实现了一个简单但有效的网络协议,以在局域网和广域网中传输和接收体素数据流。特别是对于广域网,必须在要发送的数据包数量和每个数据包的大小之间找到平衡。我们通过使用快速、标准的大学互联网连接,在两个非常遥远的地点现场测试不同的配置,来确定有效的数据包大小。

我们执行无损压缩,将体素位置数据从12字节减少到6字节。在我们的Unity系统中,一个单位等于1 m,这意味着8 mm的体素大小由0.008的浮点值表示。因为浮点值的最大精度存储到小数点后的1/1000位,所以可以乘以1000得到一个整数。然后,我们将整个数字存储为一个16位有符号整数,基本上我们将单位从米转换为毫米。当然,只有当C#短数据类型的体素位置值在−32768和32767范围内时,此压缩方法才有效。然而,基于我们的统一体素分辨率(320×320×320)和8 mm体素,每个体素位置轴可以在短数据类型范围内很好地表示在−2560和2560之间。对于体素颜色,如果alpha通道保持不变(255),我们可以将其从4个字节减少到3个字节。为了解压缩体素数据,我们将压缩后的位置值除以1000(单位从毫米转换为米),然后添加常量alpha值255(恢复为32位RGBA)。因此,我们以每个体素发送[int16 x,int16 y,int16 z,byte red,byte green,byte blue],数据包大小最多为166个体素,即每个数据包9×166个字节。

我们选择UDP是因为它是为快速数据传输(适合实时性能)而设计的,但以可靠性为代价。对于我们的应用程序,我们可以容忍一些数据包丢失,前提是它不会显著影响体素化场景的视觉外观。基于最大UDP包大小(65535字节),我们的初始远程呈现网络协议每个UDP包传输9×7000字节(每个包7000个像素),这在实验室环境中运行良好。但为了减少与真实WAN互联网连接的IP层数据包分段/重组相关的开销,我们将体素数据包大小减少到每个UDP数据包9×166字节(每个数据包166个体素),这正好适合以太网MTU(1500字节)。

我们在并发线程上实现了体素的发送和接收。当发送方线程收到一个新的帧时,我们将该帧分割成更小的段(每个包166个体素)。对于每个体素,我们在上述方法中减少体素数据,将它们写入数据包缓冲区,并在数据包缓冲区填充后将它们发送到接收器线程。我们继续,直到处理完所有剩余的体素。当处理帧中的所有体素时,将发送最后一个1字节的数据包以指示帧的结束。在接收方线程上,我们实现了一个用于并发读写的双缓冲区(render/receiver线程)。我们首先检查接收到的数据包是否是1字节的数据包。如果是这样,我们将最新的帧缓冲区分配给未使用的缓冲区(前/后)。然后,我们检查呈现和接收线程是否未使用这两个双缓冲区。如果是这样,我们交换缓冲区,并向渲染线程提升一个新的帧标志。当没有收到帧末数据包时,我们从数据包中提取所有字节,解压缩体素,然后将其写入本地缓冲区(最新的帧缓冲区)。

4.4。CAD立体化

为了提供一个连贯的混合现实环境,CAD模型被体素化并修改以匹配捕获对象的外观。我们通过建模一个虚拟Kinect,将光线投射到场景中,根据深度分辨率(512×424)和水平/垂直视野(70/60°),将Kinect捕获和体素化结果紧密匹配。Kinect设备位于世界原点上方2.3米处,面朝下约30°(图5); 因此,在Unity场景中,光线从相同的Kinect位置以相同的角度投射。对于每个深度图像像素,光线将通过近剪裁平面(0.5 m)投射到场景中。如果光线与网格相交,则会获得所有512×424条光线的交点和颜色(基本上是均匀间隔的点云)。然后将其映射到我们的体素空间中,生成体素化的CAD模型。我们还受益于光线投射体素化,因为通过使用这些Kinect设备属性,我们定义了一个视图视锥,它自动提供视锥剔除。

仅此技术只能生成静态体素模型;然而,我们必须考虑与Kinect体素化类似的时间噪声。运动学噪声受以下因素的影响:(1)被捕获物体到传感器的距离;(2) 相机和捕获表面之间的角度;(3) 深度图像中的像素到中心像素的距离;以及(4)捕获材料的反射率。我们使用简单的高斯函数为CAD体素化再现了该噪声,其中标准偏差是基于体素和虚拟Kinect位置之间的距离计算的。

4.5. 集成和渲染

所有对象都被体素化为320的规则栅格空间3体素(2.563米38 mm网格分辨率),并在Unity3D系统中渲染。我们通过使用具有点列表输入类型和三角流列表输出类型的几何着色器来实现这一点。我们将每个生成的体素的单个位置发送到着色器,在该着色器中,GPU计算构成每帧每个体素的相应立方体的顶点和面。为了在Unity的限制范围内工作,我们每个着色器最多提交65536个点,根据场景中的体素数量生成其他游戏对象。与基于CPU和GameObject的解决方案相比,此方法允许使用交互式帧速率更新和渲染数量级更多的体素。

渲染器取消了单个体素的照明,单个体素生成的所有顶点都具有相同的颜色,正如在重建过程中确定的那样,立方体面不受环境光或定向光的影响。尽管如此,因为物理对象的重建包括真实世界的照明,而虚拟对象的体素生成包括虚拟场景的照明,所以整个对象看起来是被照明的。

如果重叠对象(例如物理对象和虚拟对象)在同一点生成多个体素,我们只渲染单个体素,而不进行颜色平均。这样可以消除z向冲突,并确保单独的对象保持不同,而不是相互混合。然后使用Oculus Utilities for Unity 5渲染最终的视觉输出,并显示在HMD上。

整个系统在一个办公室中运行(中间有一张物理桌子)。三个Kinect摄像头大致放置在天花板高度,形成一个三角形。为了保持照明一致,在Kinect传感器旁边放置了三个附加灯。我们使用三个Oculus跟踪摄像头。这种设置给了我们足够的自由和稳定性来跟踪我们的交互空间(图5). 通过我们的MVR系统,我们瞄准了我们的重点混合现实应用领域,即远程呈现和远程协作、不同环境下人类行为研究、娱乐、培训和教育。因此,我们在MVR系统中提供了专门用于支持这些应用程序的功能。在下一节中,我们将探索我们的具体原型实现混合体素现实系统的实证可行性。我们通过一项实验室研究测试了关于基于体素的MR环境对我们的应用目标的感知的一些假设,特别是作为MR定义元素的存在感和共存感。

5.用户研究

我们使用我们实现的混合体素现实系统设计并执行了一项用户研究。特别令人感兴趣的问题是,人们是否会认为我们基于体素的MR体验具有说服力,人们是否能够区分真实的、记录的和纯粹虚拟的物体和人,以及是否能够培养存在感和共存感。虽然这些问题的答案可能看起来微不足道,但对于我们的低分辨率体验,它们需要得到解决和确认。

总之,我们发现

•我们的系统能够提供存在感和共同存在感,

•记录的字符令人信服,并触发与真实情况相当的响应,

•人们无法区分真实物体和虚拟或记录的物体。

因此,原则上,我们能够支持我们的目标应用场景:可以启用通信和协作,可以支持虚拟和真实对象与环境的交互,可以为教育培训提供预先录制的、真实的或虚拟的内容。此外,所有方面都融入到一个连贯的混合现实体验中。在下文中,我们详细描述了MVR系统的实验。

5.1. 参与者和程序

20名18至59岁(平均32岁)不同种族的参与者(其中11名为白种人)参与了这项研究。其中9名参与者有VR和HMD的经验。

每个参与者都戴着头盔,单独接触基于体素的MR系统。HMD安装在实验办公室外面。这样,参与者就看不到真实的环境或操作系统的人。研究人员将参与者带进房间,解释任务,收集答案并做笔记。操作员在不同的场景之间切换,并在其中一个场景中扮演真实角色。研究结束后,进行问卷调查,以测量参与者在环境中的存在感、空间感知和经历模拟疾病的迹象。

5.2. 条件和场景

我们对以下各小节中提出的五个问题感兴趣。

5.2.1. 人们能够区分虚拟(录制或体化)对象和真实(物理呈现)对象吗?

给每位参与者看一张桌子,上面摆着各种不同来源的物品(玩具)。对象可以(a)真实存在,(b)通过三个Kinect设置记录并回放,或者(c)从CAD对象中体素化。准备了两个不同的场景,每个场景有六个物体,参与者被要求说出物体的名称,然后指定每个场景中的真实物体(图6). 在这两个场景中的每一个场景中,参与者被要求在识别出低、中或高等级的真实物体后对其信心进行评级。参与者被允许走近桌子,在完成任务后通过触摸来探究他们的假设。在我们基于体素的环境中,人们无法自信地正确区分真实物体和虚拟物体,因为总体置信水平低至中等,正确识别与错误识别的比率并不比偶然高。需要更多的研究来解释哪些因素会影响对真实或虚拟物体的感知。

5.2.2. 人们会对虚拟(录制)角色立即做出反应吗?

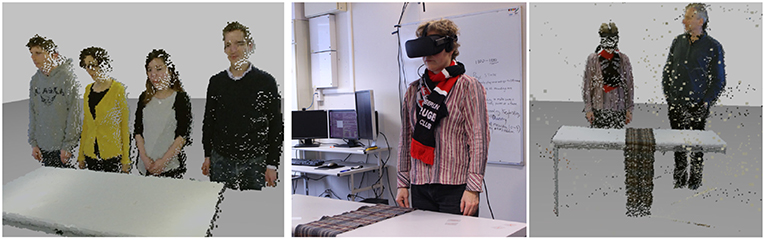

为了调查所记录的字符是否足够令人信服,从而引发即时反应,播放了一段录音,显示教师阅读一张纸大约三秒钟,然后将纸交给桌子对面的参与者,以探究参与者是否会通过伸手去拿文件立即采取行动(图7,左)。收集了即时、犹豫或根本没有反应的数据。我们发现,录制的虚拟角色很有说服力,在大多数情况下(18名参与者)都会触发即时响应,但环境中的不连贯因素(在我们的案例中,声音与位置不一致)可能会导致一些犹豫(2名参与者)。

5.2.3. 人们能够区分虚拟(记录)角色和真实(物理呈现)角色吗?

我们想知道记录的字符是否与真实字符具有相同的说服力。加载了一个场景,其中显示了两个录制的角色和一个真实的角色,这样,参与者就会看到一个场景:三个人站在桌子后面,被要求在10-20秒内指向真实的角色(图7,右侧)。我们发现,人们无法自信地正确区分真实角色和虚拟角色,因为我们的结果显示,超过一半的参与者错误地识别了真实角色,或者根本无法区分。

5.2.4. 人们能够识别虚拟(记录)角色的性别吗?

为了探索被记录字符的识别水平,我们准备了两个场景,每个场景有四个人的记录。我们注意记录下人们对性别的暗示不太多(例如,没有面部毛发),并且在录制当天,没有女性演员穿着裙子或连衣裙。参与者被要求指定角色的性别,并告诉我们他们何时认出了自己亲身认识的角色(图8,左)。人们能够非常准确地指定所记录字符的性别,但随着距离的增加(在我们的例子中超过2.3米),识别就不那么自然了,但仍然是正确的。

5.2.5。人们对自己和环境中其他人的空间意识发展了吗?

为了探索这个问题,我们准备了一个带有虚拟镜子的场景。我们在桌上放了两条真正的围巾,参与者被要求试穿他们选择的围巾并观察他们的镜面反射。几秒钟后,一个录制好的角色从侧面进入现场(图8,右侧)。如果参与者(a)转头,或(b)意识到并发表评论,或(c)什么都没做,讲师会记下笔记。我们的期望是,大多数参与者都会转头看看旁边的角色,但这并没有实现。只有一名参与者立即转头。16名参与者评论说,房间里有人,他们要么伸手到正确的一边去感觉是否有人在那里,要么在被问及角色与他们的关系时指向正确的位置。三名参与者没有做出任何反应,但当被问及时,他们报告说,他们意识到有人在他们身边。尽管我们没有得到预期的回应,但我们确信所有参与者都在空间上意识到了被记录角色的位置。

5.2.6. 自我报告的存在性和可信度

完成任务后,参与者填写了一份共21个项目的综合问卷。前八项是从igroup presence问卷IPQ中选择的(舒伯特等人,2001年). IPQ是一种工具,用于测量一个人在虚拟环境中的存在感,评估空间存在、参与度和真实性,这也与混合现实环境有关。我们遗漏了六项仅适用于纯虚拟环境的内容。除了IPQ的应用外,我们还管理了混合现实经验问卷(MREQ)的八项子集(Regenbrecht等人,2017b). 通过选择BAIL的三个共现项目来测量共现(Bailenson等人,2005年),并且我们添加了两个项目,询问基于体素的MR系统(BoOC)中对象和字符的可信度。所有问题都使用了利克特式量表(7分)。

所有四份问卷的平均值(IPQ、MREQ、BAIL、BoOC)均显著高于单样本测试的中点吨-假设不相等方差进行测试(df=19)。用一个吨-临界值为1.73 all吨-统计数据更高(第页<0.05)比吨-关键(IPQ:7.80,MREQ:14.99,BAIL:4.43,BoOC:6.01),因此平均值显著高于中点(4.0)。根据这些结果,我们得出结论,我们的基于体素的MR系统能够实现存在感、共存感,并且据报道,物体和角色令人信服。在审查了三个共同在场问卷项目后,我们意识到它们有点误导,因为在实验期间,老师实际在场。这些项目应该重新措辞,以强调混合现实场景中角色的共存。

5.2.7. 总结

通过测试人们区分真实(物理呈现)对象和虚拟对象(从CAD模型记录或体素化)以及真实字符和MR环境中记录字符的能力,探索了MVR系统的可行性。与我们的预期一致,我们发现在这两种场景中,参与者都无法高精度地识别真实的物体或角色,并且参与者对自己的选择信心从低到中等。在大多数情况下,使用记录的字符触发即时响应都是成功的,我们发现所有参与者都非常自信地正确识别了记录字符的性别。在一个使用虚拟镜像的简单设置中,我们探索了人们是否在MVR系统中开发了空间意识。虽然我们没有观察到我们预期的反应,但我们发现人们完全了解空间安排。收集到的自我报告措施加强了这些观察结果。

6.当前应用

在下面,我们想展示我们的VMR系统在不同的应用场景中是如何使用的。第一种场景利用了人们对录制的字符做出反应的效果,并且可以控制体素分辨率的保真度。第二个和第三个应用场景分别基于系统在娱乐和远程呈现原型场景中提供感知到的共存感的能力。

6.1. 人类行为研究

该系统微调抽象层次的能力可用于研究人类在某些可重复、可控和连贯环境中的行为。正如我们在上面的一个场景中所展示的那样,基于体素的MR可以引发用户的反应,比如伸手去拿提供的文档。粗略体素角色的优点在于现实主义和抽象主义之间的可控平衡:一个人可以在光谱上被识别,从一个可以识别的人到“把我带到这个房间的那个女人”这种真实抽象的平衡允许在实验室条件下对人类行为进行研究,在这种条件下,人类(演员)的某些共性特征将被展示(如性别),但其他混淆特征(如同理心)将被控制。最近,我们的MVR系统被行为心理学家用于研究儿童的偏见,在MVR环境中呈现不同的种族特征,并测量儿童的反应。100名父母中有一人在场的儿童参加了一项实验室研究,调查父母对儿童偏见的影响,以了解他们是否倾向于首先帮助自己的种族,以及是否倾向于选择与自己的种族一起玩耍。孩子们戴着一个头戴式显示器,看到不同的场景,其中有两个被记录的角色:一个亚洲人和另一个白人坐在一起,假装与孩子互动(参见图9). 在一项初步研究中确定了角色的体素保真度,以在真实性和抽象性之间找到适当的平衡。观察孩子们的行为,并将其与父母的态度联系起来。这项研究的结果超出了本文的范围,将由我们的同事单独发表。

6.2. 远程呈现

三维远程呈现系统将允许更自然的远程通信和合作。会议参与者可以在3D会议空间中以3D身体表示的形式参与,而不是显示头肩视频会议视图。使用粗略的体素分辨率,我们失去了感知精细面部表情的能力,但我们获得了非语言交流线索,如姿势和手势。体素可以通过网络高效传输,并可能成为可缩放分辨率3D临场感的促成因素。我们的MVR系统允许双方(目前)在相互体素空间中会面。两台基于体素的MR计算机之间建立了基于互联网的连接,参与人员身体的体素数据通过专有的体素格式传输。音频数据的传输留给不同的(现有)通道。

双方可以相互交谈,查看对方的体素表示,因此可以相互交互。图10在我们的实验室环境中,显示了不同房间中两个人之间的虚拟握手。即使没有触觉,我们也观察到一种真正握手的奇怪感觉。此外,我们成功地在数千公里的实际距离上测试了该系统,并将在未来更详细地研究该应用程序。

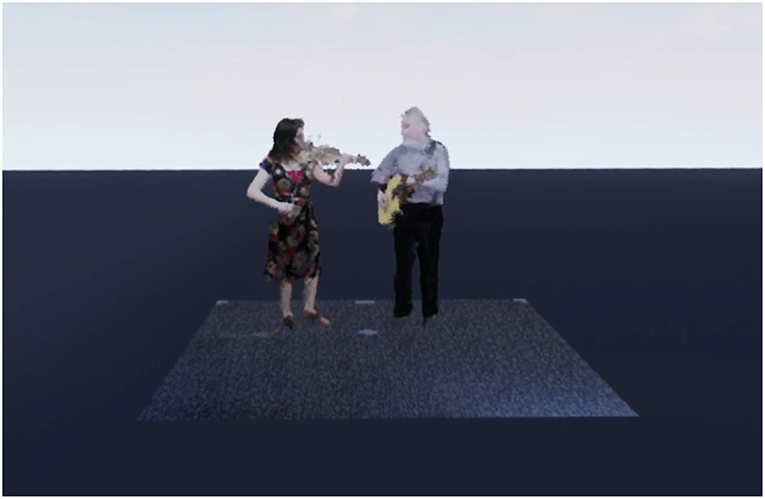

6.3. Voxelvideos视频

MVR允许制作替代的下一代视频剪辑——我们称之为voxelvideos的真正三维视频。在我们这里展示的例子中,我们分别记录了两位民间音乐家演奏爱尔兰民歌的音频流和体素表示(图11). 然后,将体素录制带到虚拟环境中,录制的音频轨迹在空间上定位在虚拟乐器所在的位置(这里是小提琴和吉他),音频最终与体素录制同步。在播放过程中,佩戴带有立体声耳机的头戴式显示器的用户可以通过简单的步行和/或远程传送在整个场景中导航,从而交互式体验3D视频和音频场景。

7.未来工作和结论

我们的应用程序示例说明了现在的基于体素的MR的潜力,即通过低分辨率、早期基于体素技术可以实现的目标。由于基于体素的MR系统尚处于初级阶段,我们甚至没有试图显示出与其他技术相比的任何优势或劣势,我们只是展示了可行性和未来前景。无论是否严格遵循摩尔定律,大规模技术都会扩大规模,但如果我们的预测是正确的,专门的体素解决方案也会发展。例如,制造商可能会提供体素优化系统,而不是网格优化图形系统(就像他们过去对体绘制系统所做的那样),或者开发更专业的算法,而不是优化顶点几何,而是优化体素交互。这种系统甚至不需要是体素特定的-体网格可以被视为(3D)张量,就像图像被视为矩阵一样,因此可以利用现代基于张量的系统。nVidia的体素库GVDB(霍兹林,2017年)或Intel针对NFL的True View技术(视图,2017)表明业界对基于体素的技术感兴趣。

未来用于基于相机的深度传感的商品硬件和软件将允许应用空间约束较小、更便携、更移动、甚至可能无处不在的系统。扩展未来办公室的理念(Raskar等人,1998年)例如,办公室里的所有天花板灯都被电脑控制的摄像机和投影仪所取代,我们设想这些摄像机将用于精细的立体重建办公室里的一切。例如,开创性AR体验的新版本三个愤怒的男人(MacIntyre等人,2002年)可以交付。我们正致力于将许多RGB-D和其他传感器结合起来,以(a)提高体素保真度,(b)扩展捕获范围,以及(c)实现真实物体、人和环境的更完整体素化。

如果这样一个无处不在的传感空间还包含允许捕获里面这样就可以提供真正的实体体素体验,也就是说,人们能够真正观察对象,体验实体和空洞的世界。目前,对于源自实体CAD模型的虚拟体素模型来说,这是可以实现的,比如那些由构造性实体几何建模器生成的模型,或者从三维CT扫描等体积数据中导出的模型。未来的传感系统可能会超越光(视觉,几乎可见),发展普及MRI等技术。目前,我们将专注于将CAD模型转化为实体体素表示,包括“智能”填充仅由外壳给出的几何体的方法。

在构建那些基于外壳或实体的体素对象和环境时,我们可以为每个体素指定意义。这可以而且应该包括每个体素的原点(属于CAD对象X)、其物理属性、与其他体素的关系、其标签等。这可以自动完成,例如在交互转换CAD模型时,例如通过“语义绘制”体素(c.f。Valentin等人,2015年)通过机器学习(识别对象)或任何其他技术或这些技术的组合。这三种方法都取决于我们当前的研究活动。

除了视觉之外,这种基于体素的MR方法还可以扩展到其他感官模式,例如,可以为每个体素和一组体素指定声学或触觉属性,使其成为一个非常优雅和简单的系统来提供多感官体验。目前,我们正在进行早期的研究项目,以证明即使在今天,基于体素的技术也可以提供其他技术的替代品,从而使体素更适合使用,因为它们具有独特的、综合的性质——一切都是体素。体素不仅用于内部(例如,快速3D阵列)表示,还用于外部(例如,八叉树文件格式)、可视化(大规模并行、GPU驱动的渲染)和交互(例如,遮挡处理)目的。

今天的混合现实体素世界是粗糙的,明天的体素世界将是精细的(有意模糊)。本文通过技术和实践论证、举例说明和探索性用户研究,为在MR中使用体素提供了一个案例。我们认为基于体素的MR的潜力尚未释放。然而,我们可以证明,体素在用户交互和技术实现方面是有效的,体素可以带来存在感,体素具有计算效率和可伸缩性。

我们希望,我们已经为研究人员和从业者提供了足够令人信服的论据,让他们考虑将基于体素的混合现实作为设计和开发新用户体验的选项。

道德声明

该研究得到奥塔哥大学伦理委员会的批准(D17/279)。参与者提供了参与本研究的书面知情同意书。

作者贡献

人力资源部构思了这个想法,管理了这个项目,监督了系统的开发、研究和论文,并编写了主要部分。J-WP开发了基础系统的主要部分(基于早期工作),并共同执行了研究。CO负责用户研究,并编写了该部分的主要部分。MC为系统实施的关键部分做出了贡献。SM是相关工作部分的主要作者。TL共同领导该项目的管理,并对文件进行了重大修订。所有作者都参与了手稿的修订,阅读并批准了提交的版本。

基金

该项目的部分资金由奥塔哥大学2016年和2018年研究拨款以及新西兰国家科学挑战(SfTI)资金提供。

利益冲突声明

作者声明,该研究是在没有任何可能被解释为潜在利益冲突的商业或金融关系的情况下进行的。

致谢

我们要感谢Katrin Meng和Arne Reepen对系统早期版本的贡献,感谢我们的参与者和HCI实验室的人员付出的时间和精力,感谢我们研究中使用的CAD模型的制造商,感谢Weta的Kevin鼓励讨论体素。

工具书类

Bailenson,J.N.、Swinth,K.、Hoyt,C.、Persky,S.、Dimov,A.和Blascovich,J.(2005)。在沉浸式虚拟环境中,化身的外表和行为对共同存在的自我报告、认知和行为标记的独立和交互影响。显示Teleoper。虚拟环境。14, 379–393.

谷歌学者

Beck,S.和Froehlich,B.(2017年)。中的“用于3D捕获系统的多个RGBD传感器的扫描式体积校准和注册”2017年IEEE虚拟现实会议记录(加利福尼亚州洛杉矶),167-176。

谷歌学者

Bentley,J.L.(1975)。用于关联搜索的多维二进制搜索树。Commun公司。ACM公司18, 509–517. 数字对象标识代码:10.1145/361002.361007

CrossRef全文|谷歌学者

Chen,J.、Turk,G.和MacIntyre,B.(2008)。“基于水彩的增强现实非真实感渲染”美国计算机学会举办的虚拟现实软件与技术大会(波尔多),231-234。

谷歌学者

Cherabier,I.、Häne,C.、Oswald,M.R.和Pollefeys,M.(2016)。“使用体素块的多标签语义3D重建”,in第四届3D视觉国际会议记录(3DV 2016)(加利福尼亚州斯坦福)。

谷歌学者

Cheung,G.K.、Kanade,T.、Bouguet,J.-Y和Holler,M.(2000年)。《人体运动鲁棒三维体素重建实时系统》IEEE计算机视觉和模式识别会议,2000年,第2卷(南卡罗来纳州希尔顿海德),714-720。

谷歌学者

Cleary,J.G.和Wyvill,G.(1988年)。基于均匀空间细分的快速光线跟踪算法分析。可视化计算。4, 65–83. doi:10.1007/BF01905559

CrossRef全文|谷歌学者

Cohen,D.和Sheffer,Z(1994)。邻近云–一种用于3D网格遍历的加速技术。可视化计算。11, 27–38. doi:10.1007/BF01900697

CrossRef全文|谷歌学者

Cohen-Or,D.和Kaufman,A.(1995年)。曲面体素化基础。图表。模型图像处理。57, 453–461. doi:10.1006/gmip.1995.1039

CrossRef全文|谷歌学者

Collins,J.、Regenbrecht,H.和Langlotz,T.(2017)。混合现实中的视觉连贯:一项系统研究。现场直播。维特。环境。26, 16–41. doi:10.1162/PRES_a_00284

CrossRef全文|谷歌学者

Crassin,C.、Neyret,F.、Sainz,M.、Green,S.和Eisemann,E.(2011年)。使用体素圆锥体跟踪的交互式间接照明。计算。图表。论坛30, 1921–1930. doi:10.1111/j.1467-8659.2011.02063.x

CrossRef全文|谷歌学者

Dai,A.、Nießner,M.、Zollhöfer,M.,Izadi,S.和Theobalt,C.(2017)。BundleFusion:实时全球一致的3D重建,使用飞行表面重新融合。ACM事务处理。图表。(TOG)36:24. 数字对象标识代码:10.1145/3072959.3054739

CrossRef全文|谷歌学者

Dou,M.、Fuchs,H.和Frahm,J.(2013)。中的“使用商品深度摄像头扫描和跟踪动态对象”IEEE混合增强现实国际研讨会,ISMAR 2013(南非阿德莱德),99–106。

谷歌学者

Dou,M.、Khamis,S.、Degtyarev,Y.、Davidson,P.、Fanello,S.R.、Kowdle,A.等人(2016)。Fusion4D:挑战场景的实时性能捕获。ACM事务处理。图表。35:114. doi:10.1145/2897824.2925969

CrossRef全文|谷歌学者

Fischer,J.、Bartz,D.和Straßer,W.(2005)。中的“风格化增强现实,改善沉浸感”IEEE虚拟现实(华盛顿特区)。

谷歌学者

Fuchs,H.、Kedem,Z.M.和Naylor,B.F.(1980)。“通过先验树结构在可见表面生成”,inACM Siggraph计算机图形,第14卷(西雅图,华盛顿州),124–133。

谷歌学者

Haller,M.(2004)。“增强现实中的照片现实主义或/和非照片现实主义”,inACM SIGGRAPH虚拟现实连续体及其工业应用国际会议(新加坡),189-196年。

谷歌学者

Häne,C.、Zach,C.、Cohen,A.、Angst,R.和Pollefeys,M.(2013)。“联合3D场景重建和类分割”IEEE Conf.计算机视觉和模式识别, 97—104.

谷歌学者

Häne,C.、Zach,C.、Cohen,A.和Pollefeys,M.(2017年)。密集语义三维重建。IEEE传输模式分析。机器。智力。39, 1730–1743. doi:10.1109/TPAMI.2016.2613051

PubMed摘要|CrossRef全文|谷歌学者

Ho,C.-C.和MacDorman,K.F.(2017年)。测量不可思议的山谷效应。国际社会机器人。9, 129–139. doi:10.1007/s12369-016-0380-9

CrossRef全文|谷歌学者

Hoetzlein,R.K.(2016)。“GVDB:GPU上的光线跟踪稀疏体素数据库结构”,in高性能图形会议(都柏林),109-117。

谷歌学者

Innmann,M.、Zollhöfer,M.和Nießner,M.,Theobalt,C.,以及Stamminger,M.(2016)。“VolumeDeform:实时体积非刚性重建”,in欧洲计算机视觉会议(阿姆斯特丹:斯普林格出版社),362-379。

谷歌学者

Izadi,S.、Kim,D.、Hilliges,O.、Molyneaux,D.、Newcombe,R.、Kohli,P.等人(2011年)。“KinectFusion:使用移动深度相机进行实时3D重建和交互”,in第24届美国计算机学会用户界面软件与技术年度研讨会论文集(加利福尼亚州圣巴巴拉),559–568。

谷歌学者

Kämpe,V.、Sintrow,E.、Dolonius,D.和Assarsson,U.(2016年)。快速、节省内存的体素阴影构建。IEEE传输。目视检查。计算。图表。22, 2239–2248. doi:10.1145/2699276.2699284

PubMed摘要|CrossRef全文|谷歌学者

Klein,G.和Murray,D.W.(2010年)。模拟低成本摄像头,用于增强现实合成登录或购买。IEEE传输。目视检查。计算。图表。16, 369–380. doi:10.1010/TVCG.2009.210

CrossRef全文|谷歌学者

Kronander,J.、Banterle,F.、Gardner,A.、Miandji,E.和Unger,J.(2015)。混合现实场景的真实感照片渲染。公司。图表。论坛34, 643–665. doi:10.1111/cgf.12591

CrossRef全文|谷歌学者

Lindlbauer,D.和Wilson,A.D.(2018年)。“混合现实:在增强现实中操纵空间和时间”,in2018 CHI计算机系统人为因素会议记录(魁北克省蒙特利尔市),第129页。

谷歌学者

Loop,C.、Zhang,C.和Zhang(2013)。中的“实时高分辨率稀疏体素化及其在基于图像建模中的应用”高性能图形会议(加利福尼亚州阿纳海姆),73-79。

谷歌学者

MacIntyre,B.、Bolter,J.D.、Vaughan,J.、Hannigan,B.、Moreno,E.、Haas,M.等人(2002年)。《三个愤怒的男人:使用增强现实戏剧化视角》ACM SIGGRAPH 2002年会议摘要和应用(德克萨斯州圣安东尼奥),268-268。

谷歌学者

Mahovsky,J.和Wyvill,B.(2004)。使用普吕克坐标进行快速光线轴对齐边界框重叠测试。J.图表。工具9, 35–46. doi:10.1080/1867651.2004.10487597

CrossRef全文|谷歌学者

Meagher,D.(1982)。使用八叉树编码的几何建模。计算。图表。图像处理。19, 129–147. doi:10.1016/0146-664X(82)90104-6

CrossRef全文|谷歌学者

Newcombe,R.A.、Fox,D.和Seitz,S.M.(2015)。“动态融合:实时重建和跟踪非刚性场景”IEEE计算机视觉和模式识别会议记录(马萨诸塞州波士顿),343–352。

谷歌学者

Newcombe,R.A.、Izadi,S.、Hilliges,O.、Molyneaux,D.、Kim,D.、Davison,A.J.等人(2011年)。“KinectFusion:实时密集曲面映射和跟踪”,in2011年IEEE第十届混合增强现实国际研讨会(ISMAR)(马萨诸塞州波士顿),127–136。

谷歌学者

Nießner,M.、Siegl,C.、Schäfer,H.和Loop,C.T.(2013年a)。中的“动态硬件细分对象的实时碰撞检测”欧洲制图(短文)(吉罗纳),33-36。

谷歌学者

Nießner,M.、Zollhöfer,M.,Izadi,S.和Stamminger,M.(2013b)。使用体素哈希进行实时三维重建。ACM事务处理。图表。32, 169:1–169:11. doi:10.1145/2508363.2508374

CrossRef全文|谷歌学者

Raskar,R.、Welch,G.、Cutts,M.、Lake,A.、Stesin,L.和Fuchs,H.(1998年)。《未来办公室:基于图像的建模和空间沉浸式显示的统一方法》第25届计算机图形与交互技术年会论文集(佛罗里达州奥兰多),179-188。

谷歌学者

Regenbrecht,H.、Meng,K.、Reepen,A.、Beck,S.和Langlotz,T.(2017a)。“混合体素现实:在低保真度、视觉相干、混合现实环境中的存在和体现”2017年IEEE混合增强现实国际研讨会(ISMAR)(南特),90-99。

谷歌学者

Regenbrecht,H.、Schubert,T.、Botella,C.和Baños,R.(2017b)。混合现实体验问卷(mreq)-参考。奥塔哥大学。

Reitinger,B.、Bornik,A.和Beichel,R.(2003)。“使用体素化的高效体积测量”,in2003年第19届计算机制图春季会议记录(纽约州纽约市:ACM),第47–54页。

谷歌学者

Roth,H.和Vona,M.(2012年)。中的“移动体积KinectFusion”BMVC,第20卷(萨里郡),1-11。

谷歌学者

Schubert,T.、Friedmann,F.和Regenbrecht,H.(2001)。存在的体验:因素分析洞察力。显示Teleoper。虚拟环境。10, 266–281. doi:10.11162/105474601300343603

CrossRef全文|谷歌学者

Slenbrouck,M.、Van Cauwelaert,D.、Veelaert,P.和Philips,W.(2015)。“具有内置遮挡检测和移除功能的Shape-from-silhouettes算法”,in计算机视觉理论与应用国际会议(VISAPP 2015)(柏林:SCITEPRESS)。

谷歌学者

Sramek,M.和Kaufman,A.(2000年)。使用距离变换对直线体数据进行快速光线追踪。IEEE传输。目视检查。计算。图表。6, 236–252. doi:10.1109/2945.879785

CrossRef全文|谷歌学者

Sridhar,A.和Sowmya,A.(2009年)。“Sparsespot:使用先验三维跟踪进行实时多人体素重建,”2009年VRST第16届ACM虚拟现实软件与技术研讨会论文集,(纽约州纽约市:ACM),135–138。

谷歌学者

Steptoe,W.、Julier,S.和Steed,A.(2014)。“传统和非真实感沉浸式增强现实中的存在性和可辨别性”IEEE混合增强现实国际研讨会(慕尼黑),213-218。

谷歌学者

Valentin,J.、Vineet,V.、Cheng,M.-M.、Kim,D.、Shotton,J.和Kohli,P.等人(2015)。语义绘制:交互式三维标记和指尖学习。ACM事务处理。图表。34, 154:1–154:17. doi:10.1145/2751556

CrossRef全文|谷歌学者

Zeng,M.、Zhao,F.、Zheng,J.和Liu,X.(2012)。中的“使用八叉树的节省内存的KinectFusion”计算视觉媒体(北京:施普林格出版社),234-241。

谷歌学者

Zhou,Y.和Tuzel,O.(2018)。“VoxelNet:基于点云的三维对象检测的端到端学习”,in计算机视觉与模式识别国际会议(犹他州盐湖城)。

谷歌学者