1.简介

遥感图像广泛应用于农业、林业、地质、气象、环境保护等领域[1]. 特别是近年来,使用遥感图像的商业产品(如Google Earth和Bing Maps)越来越多,这推动了对遥感图像的需求。这些图像具有两个重要特性:特定分辨率和空间分辨率。光谱分辨率是指光谱带的数量或最小光谱带宽,而空间分辨率是指可以区分的最小单元的尺寸或大小。理想情况下,遥感应用需要具有高空间和光谱分辨率的图像。然而,由于数据存储和信噪比之间的折衷,这样的理想图像很难由单个传感器获得。因此,许多卫星(如IKONOS、高分二号和世界观二号)携带两个光学传感器,同时捕捉同一地理区域具有不同但互补特性的两种类型的图像。其中一个传感器捕获高空间分辨率的全色(PAN)单波段图像,而另一个传感器采集低空间分辨率的多光谱(MS)图像。虽然PAN图像的空间分辨率高于MS图像,但前者的光谱信息较少。在实际应用中,遥感图像中的光谱信息和目标清晰度对于解释和分析至关重要。因此,在许多不同的场合,通常需要高空间分辨率的MS图像。MS平移[2,三]是使用PAN图像中的细节信息来提高MS图像的空间分辨率(图1). MS平移是各种遥感任务(例如变化检测)的重要预处理步骤[4],目标识别[5],图像分类[6]等。 在过去的几十年里,人们提出了各种方法来实现MS泛锐化。传统泛锐化方法[7]包括部件替换(CS)[8,9,10],多分辨率分析(MRA)[11,12],基于模型的优化[13]和其他方法[14,15,16]. 这些方法大多可以在某些方面有效地融合PAN和MS图像,例如,它们可以提高MS图像的空间分辨率,并在一定程度上保持其原始光谱信息。然而,它们有一些局限性。对于CS和MRA,保留MS图像中的光谱信息与提高其空间分辨率之间存在矛盾,特别是当MS图像和PAN图像的光谱范围不相同时[17]. 基于模型的优化方法在很大程度上依赖于先验知识和超参数。对先验知识和超参数的不当选择将降低其性能。 最近,我们的社区见证了深度学习技术在相关研究领域的重大成功,例如分类、超分辨率、分割[18]. 研究人员已经将这项技术,尤其是卷积神经网络(CNN)应用于泛锐化。Masi等人[17]提出了第一种基于CNN的泛锐化方法(PNN),其结构类似于超分辨率卷积神经网络(SRCNN)[19]. 他们的网络只有三个卷积层,这不足以映射泛锐化领域中的复杂映射关系。Yuan等人[20]设计了一个多尺度、多深度的CNN(MSDCNN),它有两个分支,具有不同数量的可学习层。然而,即使是深度分支也只有五个可学习的层。受PNN启发,Liu等人[21]展示了CNN设计的高度灵活性,并提出了一种两流融合网络(TFNet),将整个网络分为特征提取、特征融合和重构。他们还使用剩余块构建了ResTFNet,并取得了最新成果。然而,他们的网络结构仍需进一步改进。 从上面可以看出,MS泛锐化的CNN越来越深。在计算机视觉社区中,也可以发现同样的趋势。2012年,Alex等人[22]训练了一个只有八层的CNN(AlexNet)。两年后,Simonyan等人[23]引入了VGG-Net,并使用具有非常小(3×3)卷积滤波器的架构对增加深度的网络进行了全面评估,这表明通过将深度提高到16-19层,可以在现有技术配置的基础上实现显著改进。同年,Szegedy等人[24]建议GoogLeNet,一个22层深度的CNN,其质量在分类和检测的背景下进行评估。这是合理的,因为具有较深体系结构的CNN可以映射更复杂的非线性关系。然而,在训练过程中,大量的层会导致梯度消失和爆炸,需要大规模的数据,并且需要大量的计算。许多工作都集中在如何解决或减轻这些问题上。2016年,He等人[25]首先介绍了残差学习的概念,提出了残差神经网络(ResNets)。ResNets可以从显著增加的深度(152层)中获得精度。Huang等人[26]将剩余学习的概念扩展到极致,构造具有稠密连接的密集卷积网络(DenseNets)。建议的密集连接将同一密集块中的所有层连接起来。这种连接有助于梯度流,鼓励功能重用,增强隐式深度监控,而DenseNets需要更少的计算,性能优于大多数最先进的网络。 为了减少梯度消失或爆炸问题的影响并减少计算,我们将稠密连接的概念扩展到泛锐化。此外,还探索了残差学习,以降低构建高空间分辨率MS图像的难度。这项工作的贡献如下:

1.我们引入了一个深度更深的CNN,与其他现有的深度网络相比,它具有密集的块,用于泛锐化。该网络利用稠密连接(稠密块中任意两个卷积层都有连接)来促进梯度流和训练期间的隐式深度监控。该网络具有更深的结构(44个可学习层),可以学习泛锐化领域中源与目标之间的复杂非线性映射关系。

2.研究残差学习以进一步提高所提网络的性能。通过残差学习,可以将原始光谱信息完全注入到融合图像中,而无需进行任何处理。这样,网络只需要学习如何构造残差,而不是高空间分辨率的MS图像,从而降低重建的难度。

3.采用建立指标的定量评估和目视检查的定性评估,将所建议的网络与各种方法进行比较。实验结果表明,该方法可以获得最新的结果。

本文的结构如下。相关工作在第2节.第3节致力于描述拟议的非常深入的CNN。本文介绍了实验结果的描述,并对所得结果进行了一些分析第4节最后,论文总结如下第5节. 2.相关工作

2.1. 传统的全景锐化方法

传统方法促进了MS泛锐化的发展。我们将在下面简要介绍这些方法。

在CS方法中,MS图像被上采样到与PAN图像相同的空间分辨率,然后转换到另一个特征空间。他们假设光谱信息和空间信息是可分离的。因此,可以将上采样的MS图像投影到不同的组件中。然后,PAN图像全部或部分替换MS图像的空间分量,以提高空间分辨率。如果组分之间的相关性很低,而PAN图像与替换组分之间相关性很高,则CS方法可以生成失真很小的高空间分辨率MS图像。在替换之前,PAN图像和替换的分量需要通过它们的直方图进行匹配,这是一个关键的预处理步骤。CS方法的最后一步是通过逆变换将融合图像投影回原始空间。

MRA方法假设MS图像中缺失的空间细节信息可以由PAN图像中的高频空间分量进行补充。MRA的基本思想是将PAN图像的高频信息注入MS图像,同时保留MS图像的所有信息。最常见的MRA方法是高通滤波器(HPF)算法[27]该方法通过高通滤波器直接提取PAN图像的高频信息,然后将高频信息注入MS图像。 基于模型的优化方法使用稀疏表示和压缩感知来查找MS和PAN图像的过完备字典[28]. 过完备字典可以通过优化技术求解稀疏系数得到,然后用于重建高分辨率图像[29]. 在[30]提出了一种基于压缩感知理论和稀疏表示的MS泛锐化方法,利用期望高分辨率MS图像的稀疏性来重建高空间分辨率MS图像。中提出的模型[31]从PAN和上采样MS图像的混合数据集学习字典。该方法不需要大量的训练图像。基于尺度不变性,肖等人[32]假设低分辨率图像和相应的高分辨率图像在一对耦合字典下具有相同的稀疏系数。因此,在低分辨率字典下求解低分辨率图像的稀疏系数后,可以通过将获得的稀疏系数与耦合高分辨率字典的原子相乘来重建相应的高分辨率图像。 其他类型的方法,混合方法,是不同方法的混合[33]. 如前几节所述,CS和MRA方法有其明显的优点和缺点。CS方法在改善融合图像的空间质量方面具有更好的性能,但它们容易出现光谱失真。MRA方法可以更好地保留原始MS图像的光谱信息,但往往会导致空间失真。这些问题自然导致了将CS和MRA结合起来形成混合方法的想法,该混合方法利用了两者的优点,从而可以解决光谱和空间失真问题。 2.2. 基于CNN的全景锐化方法

Masi等人[17]提出了第一种基于CNN的泛锐化方法(PNN)。他们讨论了超分辨率和MS泛锐化之间的内在关系。建议的PNN与SRCNN类似[19],但它们有一些不同的地方,例如,SRCNN只有一个输入,而PNN将PAN和上采样的MS图像堆叠起来,形成一个五波段输入。此外,PNN将特定遥感图像数据的先验知识引入网络,以指导训练过程。PNN比传统方法取得了更好的结果。 最近,一些MS泛细化网络采用了剩余学习的思想来进一步提高其性能。由于PNN的样本结构只有一个简单的三层可学习层,一些作品还尝试使用剩余学习来提高PNN的性能。为了加快PNN的训练并提高性能,Scarpa等人[34]将剩余学习添加到PNN中,与最先进的方法相比,获得了显著的性能提升。 Wei等人[35]引入了剩余学习的概念,形成了深度CNN(11个可学习层),以充分利用深度学习模型的高度非线性。该网络通过跳接将输入图像直接连接到网络的第二层。这种做法可以更好地保存原始MS和PAN图像的信息,并减少潜在的光谱和空间失真。 后来,为了提高融合图像的空间质量,Yang等人[36]设计了一个名为PanNet的MS泛锐化模型。网络的主体是10个堆叠的残差块,它以MS和PAN图像的高通分量作为输入。它通过残差学习传输MS图像的光谱信息。PanNet明确划分了MS泛锐化的两个基本目标,从而降低了问题的复杂性。此外,使用MS和PAN图像的高通分量而不是原始图像作为输入,有利于网络在来自不同卫星的图像数据集之间进行推广 Yuan等人[20]提出了由浅支和深支组成的MSDCNN。浅分支直接使用PNN提取简单特征,而深分支使用两个堆叠块提取不同尺度的图像特征。即使是深度分支也只有五个可学习的深度层次。为了确保信息可以更有效地从前层传输到后层,还将跳过连接添加到Inception块。最后,将浅分支和深分支的输出相加,以生成高空间分辨率MS图像。 最近,Liu等人[21]提出了TFNet,它展示了CNN设计的高度灵活性。受PNN的启发,TFNet的整个网络结构可以分为三个子网络,其功能分别是特征提取、特征融合和图像重建。特征提取子网络由两个分支组成,分别从输入的MS和PAN图像中提取空间和光谱特征。然后将获得的特征映射进行级联并放入特征融合子网络。通过级联和三个卷积层进行特征融合,以获得更紧凑的特征。然后,将特征传输到具有11个卷积层的图像重建子网络,并输出最终的融合图像。然而,还有一些需要改进的地方,例如,每个卷积层后面都有一个批量规范化(BN)层,该层在许多相关任务中可以取得更好的结果[37]在数据集和计算资源有限的情况下,将有大量的参数和大量的计算来增加其网络的深度。 3.拟建网络

拟议的网络包含三个模块。第一个模块从PAN和MS图像中提取空间和光谱特征。第二个模块将提取的特征与稠密块进行融合,最后一个模块利用残差学习重建高空间分辨率MS图像。在本节中,我们将阐述融合问题并介绍模型的体系结构。然后介绍了特征提取、特征融合和重构模块。

3.1. 问题公式化

MS泛锐化问题可分为三个子问题:如何提取PAN和MS图像的特征、如何融合特征以及如何重建高空间分辨率MS图像。这些子问题由三个模块解决:特征提取、特征融合和重建。为了方便起见,我们使用E类(·)表示特征提取模块,其中E类米(·)和E类P(P)(·)可以分别从MS和PAN图像中提取光谱和空间特征。F类(·)和R(右)(·)表示特征融合和图像重建模块。泛锐化模型的公式如下:哪里表示PAN图像,对应的MS图像表示为,和是提取的特征,然后通过F类(·). 重建模块不仅提取融合的特征,还提取提取的特征,这有助于梯度流动。为了降低高空间分辨率MS图像重建的难度,被放入重建模块中以实现残差学习。 3.2. 建筑

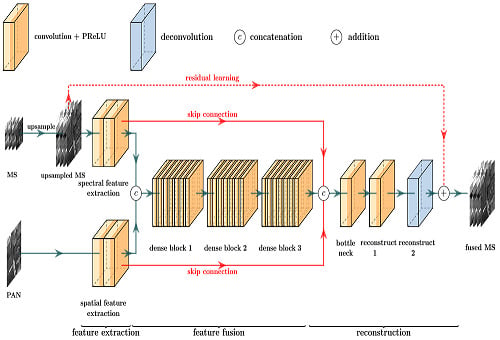

受深度CNN在分类和其他相关任务中的高性能启发,设计了一个用于MS泛锐化的深度完全卷积网络。图2显示了所建议网络的详细信息。图例位于图的顶部:一个卷积层、一个去卷积层和两个融合操作。每个橙色长方体表示一个卷积层,其中深色部分表示激活函数PReLU,浅色部分表示卷积运算。蓝色长方体是一个无暗区的去卷积层,这意味着去卷积中不存在激活函数。 ![远程设置11 02608 i001]() 和

和 ![远程设置11 02608 i002]() 分别是级联和加法融合操作。

分别是级联和加法融合操作。 建议的网络如下图所示,可以端到端的方式进行训练。可以看出,该网络以PAN图像和上采样MS图像为输入,有三个模块,例如特征提取、特征融合和重建。分别提取空间和光谱特征。在特征融合模块中,将提取的特征叠加在一起,由三个连续的密集块进行融合。融合后的特征通过跳跃连接与提取的特征连接,然后通过重构模块中的瓶颈层。高空间分辨率MS图像在网络末端根据这些特征重建。由于三个模块可以合并为一个网络,因此建议的网络以端到端的方式进行训练。

该网络利用深度CNN来模拟输入与目标之间的非线性映射关系。该网络遵循VGG-net的结构,其中具有小核的卷积层被堆叠,例如,卷积核的空间大小不大于3×3。小内核也有助于减少参数数量和减少训练时间。该网络的深度达到44个卷积层,比许多最先进的网络要深得多。一般来说,深度网络优于浅层网络,因为深度网络具有更好的非线性,这有助于模型拟合输入和参考MS图像之间的复杂映射关系,并学习更抽象和有代表性的特征。

3.3. 特征提取

使用两个子网络分别提取空间和光谱特征。这些子网络具有相同的架构,但其参数(例如,权重和偏差)不同。其中一个子网络以MS图像作为输入,而PAN图像则被馈送到另一个子网络。两个特征提取子网络由两个连续的卷积层组成,其卷积核均为3×3,然后将提取的特征放入后续网络中。许多CNN使用最大池或平均池来获得特征的尺度不变性和旋转不变性。然而,纹理和细节信息在MS泛锐化主题中尤其重要。为了避免在图像处理过程中丢失信息,整个网络中不使用下采样操作。这两个子网络的公式如下:其中,*是卷积运算,表示粒重,b条表示偏置,激活函数(参数校正线性单位)表示为预LU(·). 3.4. 特征融合

特征融合模块需要和作为输入,并将它们融合在一起以产生紧凑简洁的功能。融合功能F类需要结合以下优点和。尽管作为空间信息的载体,光谱信息也存在于其中。同样,经验证包含光谱信息,但不能否认它也包含其空间信息(低频)。三个密集块用于融合这些功能,如图2.灵感来自[37]中使用的BN层[38]在配备的密集块中移除。和由三个致密块串联并融合,公式如下:哪里D类(·)表示密集块,“ⓒ”表示串联操作。在这里,拼接操作明确地结合了两个特征映射,并清楚地反映了集成不同图像特征信息的图像融合概念。串联操作的另一个优点是效率相对较高。然后,将级联特征放入稠密块中,稠密块将输出比级联特征更紧凑的融合特征。得到的融合特征可以被视为包含所有空间和光谱信息的特征和. 密集区块易于实施但有效。在传统CNN中,如果网络按L(左)层,将有L(左)+1网络中各层之间的连接。当涉及到密集块时,有L(左)(L(左)+1)/2个连接。图3显示了这些连接,其中任意两个层直接连接。换言之,稠密块的每一层的输入是前一层生成的特征地图的并集,输出的特征地图将通过连接共享给所有后续层。该结构可定义为:其中[x个0,x个1, ⋯,x个L(左)−1]指示功能从0映射到L(左)−1层根据特征尺寸连接。进程[]是一个串联操作,而不是像剩余块那样的加法操作。D类L(左)表示的转换函数L(左)-第th层,包括两个连续卷积层。前一个卷积层是具有1×1核的瓶颈层,后一个卷收层具有3×3核。其输出特征映射的通道数为128和32。瓶颈层是必不可少的,因为密集块中的层越多,就需要连接更多的特征图,这导致大量的特征图通道消耗大量的GPU内存和计算。因此,应将信道数设置为较小,以减少密集块的冗余和计算复杂性。为了进一步减少计算负担,每个3×3卷积层前面的1×1卷积瓶颈层用于减少信道数。它不仅大大减少了计算量,而且在不丢失信息的情况下集成了每个特征地图。为了实现特征图的级联,所有特征图在密集块中具有相同的空间大小,因此步长被设置为1,并且不使用下采样操作。 3.5. 重建

该网络的最后一步是从融合特征重建所需的高空间分辨率MS图像。虽然它位于网络的后部,但最后一个并不是最不重要的。有三个不同的卷积层:1×1卷积层、3×3卷积层和去卷积层。本模块采用剩余学习和跳跃连接。其公式如下:其中ΦR(右)表示重建模块的堆叠层,F类是融合模块的输出特征,和是提取的特征,ⓒ是级联操作。从方程(5)和图2将融合后的特征和提取的特征串联起来,然后重建MS图像和融合图像之间的残差。 模块中有三层。第一个是瓶颈层,具有1×1内核。第二层是3×3核卷积层。需要注意的是,最后一层是反褶积层,也是整个网络的最后一层。因此,去掉了其激活函数PReLU。反褶积是一种特殊的卷积。它在正向和反向传播中的作用正好与普通卷积的作用相反[39]. 也就是说,普通卷积层的正向传播过程是去卷积层反向传播过程,卷积层逆向传播过程是反卷积层正向传播。因此,如果卷积层对应于图像编码过程,那么反卷积层则对应于图像解码过程。 该模块还配备了残差学习功能,以降低MS图像重建的难度。在图2,红色虚线表示剩余学习。该线连接输入和融合的MS图像。实际实现非常简单但有效。它只需要将输入的MS图像与最后一层的输出相加。重建模块只需要重建残差,而不需要重建高空间分辨率MS图像。 在所提出的网络中,模块之间的跳跃连接也促进了梯度流。特征提取模块离重建模块太远。我们有理由在模块之间建立信息高速公路。通过跳转连接,增加了重建模块输入特征的多样性,减轻了网络训练的难度。构建的信息高速公路可以缓解梯度爆炸和梯度消失问题,从而加快网络的收敛速度。

4.实验与分析

我们在三个数据集上进行了实验,以评估该网络的性能。我们的网络和其他方法的结果在中进行了比较和讨论第4.4节和第4.5节分别是。 4.1. 数据集集合

为了彻底比较我们的网络与其他MS泛细化方法,我们基于IKONOS、GaoFen-2和WorldView-2三颗卫星收集的遥感图像构建了三个独立的数据集。其传感器参数列于表1,表2和表3分别是。这些遥感图像的空间分辨率非常高,例如,捕获的PAN图像的空间分辨率甚至小于1米,并且对应的MS图像的空间分辨率为4米。IKONOS和高分-2的MS图像有四个波段,而WorldView-2的图像有八个波段。IKONOS、高分-2和WorldView-2的场景分别是2008年中国四川西部、2016年中国广州和2016年美国华盛顿的山区。 IKONOS、GaoFen-2和WorldView-2数据集是基于上述场景生成的,这些数据集之间没有交集。对这三颗卫星的PAN和MS图像进行无重叠裁剪,得到的样本图像块的空间大小为256×256。这些补丁进一步分为训练集、验证集和测试集。由于GPU内存的限制,训练集的图像大小为128×128,比测试集小。训练集和验证集用于网络训练,而测试集用于评估网络性能。列车组、验证组和测试组的图像分布如所示表4. 4.2. 评价指标

采用建立指标的定量评价和目视检查的定性评价两种方法对MS泛细化方法的质量进行评价。对于定量评价,我们需要制作仿真数据集来评价PAN和MS图像融合方法。由于不存在传感器捕获的高空间分辨率MS图像,因此无法直接评估上一节提到的数据集上的方法。由于数据存储和传感器信噪比之间的折衷,卫星上的传感器无法捕获理想的MS图像,其空间分辨率与PAN图像相同。在学术领域,Wald等人建立的协议[40]通常用于验证融合图像应具有的特征。该协议可以概括为综合标准和一致性标准。合成准则规定,融合图像应尽可能与理想的高分辨率MS图像一致。如果不存在这样的理想图像,通常使用模拟数据进行评估。 模拟数据是通过对原始PAN和MS图像进行下采样获得的。在本研究中,使用双三次插值算法对原始图像进行降采样。原始PAN和MS图像的空间分辨率之比可用作下采样因子。下采样的图像用作输入。因此,原始MS图像可以作为参考图像,对融合图像进行定量评价。该方法的一个重要前提是,图像融合算法的性能不受输入图像分辨率变化的影响。测量单波段数据的标量计算并结合所有波段的矢量计算,用于定量测量融合图像的空间、光谱和全局质量。在这些条件下,融合图像的数值评价指标主要有以下几个方面。

由于光谱向量可用于轻松测量光谱信息的变化,光谱角度映射器(SAM)[41]是能够有效测量融合图像与参考图像相比的光谱失真的指示器。它被定义为融合图像和参考图像中相同位置像素的光谱向量之间的角度。对于理想的融合图像,SAM值越接近0,光谱失真越小[42]是一种广泛用于测量融合图像空间质量的指示器。sCC值表示融合图像和参考图像之间的空间细节相似性。其值范围为−1到+1,理想值为+1。该值越大,融合图像中包含的PAN图像的空间信息越多。相对误差的全球维度内尔-德斯ynth'ese(ERGAS)[43]是用于评估融合图像的全局质量的指示器。ERGAS指数反映了融合图像相对于参考图像的空间和光谱畸变。理想值为0。值越小,融合图像的全局质量越好。通用图像质量指数(UIQI)[44]是评估融合图像整体质量的另一个指标。UIQI值是通过对各个频带的UIQI数值进行平均得到的,其值范围在-1和1之间。理想值为1。较大的值表示融合图像具有更好的整体质量。质量指数Q4[45]是UIQI指数在四波段数据上的扩展,是一种可以综合评价融合图像空间和光谱质量的数值指标。对于八波段融合的MS图像,可以计算出相应的Q8指数[46]. Q4和Q8的值在0到1的范围内,越接近1意味着融合图像具有更好的空间和光谱质量。 4.3. 培训

该网络在PyTorch(一个开源深度学习框架)中实现,并在单个Nvidia GeForce GTX 1080 Ti GPU上进行训练。我们采用L2正则化来减少过拟合和L1损失来约束网络的输出。使用Adam优化算法更新参数以减少以下损失函数:哪里S公司是训练图像的数量,表示参考MS图像,表示泛锐化MS图像,w个表示可学习参数,以及λ是一个平衡参数。 对于每个数据集,网络是成批训练的,每批图像由从训练图像中随机选择的10幅图像组成。在很大程度上,网络训练的效率和准确性取决于超参数,例如学习速率、动量、批量大小等。最重要的是学习速率。学习速率大会导致网络参数更新不稳定,而网络收敛速度慢,学习速率小。初步实验后,初始学习率设置为0.001,每15000次迭代,学习率降低一半。在培训期间,λ设置为0.001,并不断调整网络参数以生成尽可能接近参考图像的融合图像,最终损失函数将达到收敛。训练网络大约需要10个小时。训练后,建议模型在训练集、验证集和测试集上的结果列于表5可以看出,测试集上的结果与车组上的结果相差不大,这表明训练期间没有明显的过拟合。 4.4. 与其他方法的比较

我们将我们的模型与10个代表性算法进行了比较,这些算法属于不同的类别。与带宽相关的空间细节(BDSD)[10]和GS自适应(GSA)[8]是CS方法。工业[11]和ATWT_M3[12]是MRA的成员。PNN公司[17],PNN+[34]、DRPNN[35]、PanNet[36]、TFNet[21],和MSDCNN[20]是基于CNN的方法。这些基于CNN的方法的可学习层数量列于表6,其中ReLU、PReLU和BN层不计在内。PNN、PNN+和MSDCNN是相当浅层的模型,其可学习层的数量分别为三层、三层和五层。DRPNN是PNN系列中最深的CNN之一,有11个可学习层。TFNet是一个具有18个可学习层的双流融合网络。PanNet由一个主干层和10个剩余块组成21层网络。该网络比其他模型更深,其中包含44个可学习层。 我们使用50对测试图像对所有方法进行定量评估。上述所有方法的定量评价结果见表7,表8和表9。最佳结果和次佳结果分别以红色和蓝色显示。可以看出,基于CNN的MS泛细化方法在所有数据集上的结果都优于传统方法。从表中可以看出,CNN方法在所有质量评价指标(空间、光谱和全局)方面明显优于其他传统方法,这表明了CNN作为一种非线性端到端模型与由离散步骤组成的传统线性方法相比的优势。 在这些方法中,我们的模型取得了具有竞争力或优越的结果。在IKONOS数据集上,该网络在所有五个指标上均取得了最佳结果,显著优于其他最先进的方法。在高分2数据集上的实验表明,该网络在三个指标上取得了最佳结果,在两个指标上获得了次优结果。WorldView2数据集的结果与IKONOS相似。综上所述,该网络在15项指标中的13项上取得了最佳结果。

除了使用上述评价指标对算法的融合图像质量进行定量评价外,还对所有算法生成的融合图像进行进一步可视化,以检查各种算法可能产生的光谱失真或空间失真。由于实际数据图像的大小很大,很难用肉眼区分不同融合图像之间的细微差异。本文从IKONOS数据集开始。图4显示了由各种算法生成的融合图像,用于融合INONOS测试集中的一组图像。 如所示图4,所选图像是一个山景,其中所有MS图像通过其红、绿、蓝波段合成为真彩色图像。图4a显示了高空间分辨率MS图像,这是基本事实,并且图4b–l显示不同方法生成的融合图像。在图4可以看出,除了ATWT-M3之外,所有方法都可以重建出视觉上令人满意的MS图像。ATWT-M3的融合图像模糊。造成空间失真模糊效果的主要原因是该方法无法从PAN图像中提取合适的空间信息并将其注入MS图像。相比之下,通过仔细观察,Industion方法生成的融合图像甚至比参考图像具有更多的空间细节,这是过度锐化的,也被认为是空间失真。与参考图像相比,GSA和BDSD方法具有不同程度的色差,这在场景的平坦区域更为明显。相比之下,与其他方法相比,该网络、PNN、TFNet、PNN+、DRPNN、PanNet和MSDCNN可以生成空间和光谱失真较小的融合图像。这些融合图像最接近参考图像。通过定性评估很难区分哪个更好。然而,定量评估已经证明,所提议的网络可以表现得更好。 此外,还选取了高分-2测试集中的一组城市场景,对上述算法生成的融合图像进行了视觉分析。如所示图5在IKONOS测试图像上可以发现类似的现象。首先,ATWT-M3的融合图像仍在模糊,除CNN外的其他方法都有明显的空间失真,这在场景中心较暗的区域尤为明显。这些方法的融合图像具有参考图像中不存在的空间纹理。此外,BDSD和GSA融合图像中某些区域的颜色与参考图像有显著差异,即光谱失真。总之,我们的网络和PNN生成的融合图像相对于参考图像没有明显的光谱和空间失真,数值评估指标表明我们的网络具有最佳的融合性能。WorldView-2数据集上融合图像的视觉对比度类似,如所示图6. 4.5. 讨论

在本节中,我们进一步讨论了稠密块和残差学习在所提出网络中的作用。为了评估稠密块的作用,对具有常用残差块的模型进行了测试。为了比较均匀,每个模型在融合模块中有18个3×3卷积层。因此,每个模型有三个致密块体或九个残余块体。在密集块的3×3卷积层中,信道的数量为32,而残差块的对应数量为128。通过从建议的CNN中删除残差学习,还研究了残差学习的效果。我们有两个条件(例如,选择块和是否使用剩余学习),每个条件有两个选项。因此,我们在每个数据集上进行了四个实验。批量大小设置为10。Adam算法的权重衰减为0.001。初始学习率设置为0.001,在训练期间每5000次迭代乘以0.5。12组定量评估结果如所示表10,表11和表12。在表中,每个索引的最佳结果和次佳结果分别用红色和蓝色表示。 很明显,密集块显著提高了该网络的性能。基于密集块的网络的平均Q8、UIQI、SAM、ERGAS和SCC为0.6922、0.8718、3.8207、3.3和0.9431,而剩余块的对应值为0.6028、0.8116、6.1988、5.3931和0.9。从这些指标可以看出,密集块对提高性能具有重要意义。密集连接具有以下优点。深度CNN可能会受到消失梯度问题的困扰,因为在网络的正向和反向传播中,大量的层阻碍了输入信息和梯度信息的传输。在密集的块中,每个层都直接连接到网络的输入和输出,因此,特征信息和梯度信息在网络中的传递将变得更加有效。密集块使深层卷积层能够重用浅层卷积层生成的特征映射,实现块中所有特征映射的充分利用,有效避免了消失梯度问题。这些优势有助于促进培训过程。此外,尽管密集块中需要处理大量的特征图,但瓶颈层和转换层的应用大大减少了网络计算复杂度参数的数量,每一层致密块不仅可以利用前一层生成的特征,还可以利用所有前一层产生的特征。将密集块应用于MS泛细化的意义在于,可以利用不同深度、抽象程度和表达能力的特征图,并将其集成到高效的特征图中。

还应注意,剩余学习对基于密集块的方法有显著影响。六个实验与致密块相关,其中三个模型配备了剩余学习。这些模型在十五项指标中的十项中取得了最佳结果。特别是,UIQI在表10。残差学习的效果是合理的,因为输入的MS图像与参考图像非常相似。网络很难直接重构期望的输出,但在学习输入和输出之间的残差时,重构模块变得高效。MS图像融合的两个基本目标是光谱信息保留和空间信息增强。残差学习直接带来融合图像原始MS图像的光谱信息,而网络用于生成原始MS图像中缺失的空间信息。与直接构建高空间分辨率MS图像的通用CNN相比,具有残差学习的CNN具有清晰的物理解释,因此学习输入和目标的残差是MS泛增强的自然选择。在表11基于残差块的无残差学习模型在UIQI指数中取得了最好的结果,这也证明了残差学习的效果。这是因为剩余学习存在于该模型的剩余块中。 虽然所提出的网络优于一些最先进的方法,但它不能否认存在一些故障情况,例如图4b是模糊的。这个问题是由高频信息的丢失引起的。为了对抗模糊边缘,可以引入高通滤波器来描述结构相似性,同时最小化光谱失真。然而,由于不恰当的结构限制,融合后的MS图像可能会出现一些退化。 5.结论

在本文中,我们提出了一种用于MS泛锐化的具有稠密块和剩余学习的深度CNN。该网络利用稠密块重用特征图,减少参数,并在训练过程中促进梯度流。这些优点有助于我们的网络有效地学习复杂的非线性映射关系,即使该网络的深度达到44个可学习层。我们还探索了剩余学习来提高绩效。它可以提供互补的细节信息,从而降低MS图像重建的难度。在三个数据集上进行了实验,所提出的网络达到了竞争或优越的性能。我们讨论了密集块和残差学习的影响。实验结果表明,设计密集块的模型优于剩余块的模型,这表明了密集连接的有效性。残差学习带来的改进表明,它可以降低MS图像重建的难度,进一步提高所提出网络的性能。

在未来的研究中,我们计划在其他融合场景中测试该方法,例如,高光谱泛锐化、高光谱和MS图像融合。此外,如何更有效地提取和融合空间和光谱特征仍然是一个活跃的研究课题。

作者贡献

所有作者都对这项工作做出了重大贡献。D.W.和Y.L.设计了方法并分析了数据;J.C.-W.C.帮助设计实验,并为工作的准备和修订提供建议;D.W.和L.M.进行了实验;Z.B.帮助进行了实验。

基金

本研究得到了国家自然科学基金(6187146061761042)、陕西省自然科学基础研究计划(2018JM6066)、中央高校基本科研业务费(3102019ghxm016)和延安市重点研发计划(2017KG-012017WZZ-04-01)的支持。

致谢

作者感谢西北工业大学的郑庆平在编码方面提供的建议。

利益冲突

作者声明没有竞争性的经济利益。创始赞助商在研究设计中没有任何作用;收集、分析或解释数据;撰写手稿时;以及发布结果的决定。

工具书类

- 卡鲁伊,M.S。;本哈卢奇,F.Z。;Deville,Y。;杰里里,K。;布利奥特,X。;Houet,T。;Le Bris,A。;Weber,C.基于部分线性NMF的非混合方法,用于城市高光谱遥感数据中光伏板的检测和面积估计。远程传感器。 2019,11, 2164. [谷歌学者] [交叉参考]

- Garzelli,A。;Aiazzi,B。;Alparone,L.公司。;洛利,S。;Vivone,G.使用基于辐射传输的细节注入模型进行多光谱全景锐化,以保持植被覆盖的变化。远程。传感器。 2018,10, 1308. [谷歌学者] [交叉参考]

- 王,P。;Wang,L。;Wu,Y。;Leung,H.利用全景锐化技术从粗遥感图像中生成亚像素分辨率的专题图。远程。传感器。 2018,10, 884. [谷歌学者] [交叉参考]

- 小苏扎。;费尔斯通,L。;席尔瓦,L.M。;Roberts,D.通过光谱混合模型从SPOT 4绘制亚马逊东部森林退化图。遥感环境。 2003,87, 494–506. [谷歌学者] [交叉参考]

- 穆罕默德扎德,A。;塔瓦科利,A。;Zoej,M.J.V.从泛锐化ikonos图像中提取基于模糊逻辑和数学形态学的道路。照片。记录 2010,21, 44–60. [谷歌学者] [交叉参考]

- 方,B。;李毅。;张,H。;Chan,J.C.基于具有光谱感知注意机制的稠密卷积网络的高光谱图像分类。远程传感器。 2019,11, 159. [谷歌学者] [交叉参考]

- 阿姆罗,I。;马特奥斯,J。;织女星,M。;莫利纳,R。;Katsaggelos,A.K.多光谱图像泛增强的经典方法和新趋势综述。Eurasip J.高级信号处理。 2011,2011, 79. [谷歌学者] [交叉参考] [绿色版本]

- Aiazzi,B。;巴伦蒂,S。;Selva,M.通过MS+Pan数据的多元回归改进成分替代面板锐化。IEEE传输。地质科学。远程传感器。 2007,45, 3230–3239. [谷歌学者] [交叉参考]

- 谢,B。;张,H。;Huang,B.揭示了成分替代泛细化方法的隐含假设。远程传感器。 2017,9, 443. [谷歌学者] [交叉参考]

- Garzelli,A。;Nencini,F。;Capobianco,L.超高分辨率多光谱图像的最佳MMSE平移锐化。IEEE传输。地质科学。远程传感器。 2007,46, 228–236. [谷歌学者] [交叉参考]

- M.M.Khan。;查努索,J。;康达特,L。;Montanvert,A.Industion:使用感应缩放技术融合多光谱和全色图像。IEEE地质科学。遥感快报。 2008,5, 98–102. [谷歌学者] [交叉参考]

- Ranchin,T。;Aiazzi,B。;Alparone,L.公司。;巴伦蒂,S。;Wald,L.图像融合——ARSIS概念和一些成功的实施方案。Isprs J.照片。远程传感器。 2003,58, 4–18. [谷歌学者] [交叉参考]

- Palsson,F。;M.O.Ulfarsson。;Sveinsson,J.R.基于模型的降秩泛锐化。IEEE地质科学。远程。Sens.Lett公司。 2019. [谷歌学者] [交叉参考]

- Choi,J。;Kim,G。;北帕克。;帕克,H。;Choi,S.VHR卫星图像的混合泛锐化算法,使用基于NDVI的注入增益来降低计算成本。远程传感器。 2017,9, 976. [谷歌学者] [交叉参考]

- Choi,J。;帕克,H。;Seo,D.使用引导滤波提高VHR卫星图像的空间清晰度。远程传感器。 2019,11, 633. [谷歌学者] [交叉参考]

- Lillo Saavedra,医学博士。;哥伦比亚特区冈萨洛·马汀。;加西亚·佩德雷罗,a。;Lagos,O.农业破碎景观的尺度感知泛锐化算法。远程传感器。 2016,8, 870. [谷歌学者] [交叉参考]

- 马西,G。;科佐利诺,D。;Verdoliva,L。;Scarpa,G.通过卷积神经网络进行锐化。远程传感器。 2016,8, 594. [谷歌学者] [交叉参考]

- 江,Z。;袁,Y。;Wang,Q.通过自适应深度进行语义分割的轮廓软件网络。神经计算 2018,284, 27–35. [谷歌学者] [交叉参考]

- Dong,C。;罗伊,C.C。;He,K。;Tang,X.使用深度卷积网络的图像超分辨率。IEEE传输。模式分析。机器。智力。 2015,38, 295–307. [谷歌学者] [交叉参考]

- 袁,Q。;魏毅。;X孟。;沈,H。;Zhang,L.一种用于遥感图像泛锐化的多尺度多深度卷积神经网络。IEEE J.选择。顶部。申请。地球目标远程。传感器。 2018,11, 978–989. [谷歌学者] [交叉参考]

- 刘,X。;刘,Q。;Wang,Y.基于两流融合网络的遥感图像融合。信息融合 2020,55, 1–15. [谷歌学者] [交叉参考]

- Krizhevsky,A。;Sutskever,I。;Hinton,G.E.ImageNet使用深度卷积神经网络进行分类。《神经信息处理系统国际会议论文集》,美国内华达州塔霍湖,2012年12月3日至6日。[谷歌学者]

- Simonyan,K。;用于大规模图像识别的极深卷积网络。arXiv公司 2014,预印本。arXiv:1409.1556。[谷歌学者]

- 塞格迪,C。;刘伟。;贾,Y。;Sermanet,P。;里德,S。;安格洛夫,D。;Erhan,D。;Vanhoucke,V。;Rabinovich,A.深入研究卷积。《IEEE计算机视觉和模式识别会议论文集》,美国马萨诸塞州波士顿,2015年6月8日至10日。[谷歌学者]

- He,K。;张,X。;任,S。;Sun,J.图像识别的深度残差学习。《IEEE计算机视觉和模式识别会议论文集》,美国内华达州拉斯维加斯,2016年6月27日至30日。[谷歌学者]

- 黄,G。;刘,Z。;Van Der Maaten,L。;Weinberger,K.Q.密集连接卷积网络。2017年7月21日至26日在美国夏威夷州火奴鲁鲁举行的IEEE计算机视觉和模式识别会议记录。[谷歌学者]

- Gangkofner,U.G。;普拉丹,P.S。;Holcomb,D.W.优化用于图像融合的高通滤波器添加技术。照片。工程师远程传感器。 2007,73, 1107–1118. [谷歌学者] [交叉参考]

- 鲁宾斯坦,R。;布鲁克斯坦,A.M。;Elad,M.《稀疏表示建模词典》。继续。电气与电子工程师协会 2010,98, 1045–1057. [谷歌学者] [交叉参考]

- Kreutz Delgado,K.公司。;J.F.穆雷。;拉奥,B.D。;Engan,K。;Lee,T.W。;Sejnowski,T.J.稀疏表示的字典学习算法。神经计算。 2003,15, 349–396. [谷歌学者] [交叉参考]

- 李,S。;Yang,B.使用压缩传感技术的一种新的全景锐化方法。IEEE传输。地质科学。远程传感器。 2011,49, 738–746. [谷歌学者] [交叉参考]

- Cheng,J。;张,H。;沈,H。;Zhang,L.一种实用的基于压缩感知的全景锐化方法。IEEE地质科学。遥感快报。 2012,9, 629–633. [谷歌学者] [交叉参考]

- X.Z.肖。;Bamler,R.稀疏图像融合算法及其在泛锐化中的应用。IEEE传输。地质科学。远程传感器。 2013,51, 2827–2836. [谷歌学者]

- 钟,S。;Ye,Z。;陈,Y。;Di,W.结合分量替换和多分辨率分析:一种新的广义BDSD全景锐化算法。IEEE J.选择。顶部。申请。地球目标远程。传感器。 2017,10, 2867–2875. [谷歌学者] [交叉参考]

- 斯卡帕,G。;Vitale,S。;Cozzolino,D.基于靶向适应性CNN的泛强化。IEEE传输。地质科学。远程传感器。 2018,56, 5443–5457. [谷歌学者] [交叉参考]

- 魏毅。;袁,Q。;沈,H。;Zhang,L.通过学习深度残差网络提高多光谱图像泛细化的准确性。IEEE地质科学。遥感快报。 2017,14, 1795–1799. [谷歌学者] [交叉参考]

- 杨,J。;Fu,X。;胡,Y。;黄,Y。;丁,X。;Paisley,J.PanNet:泛锐化的深层网络架构。2017年10月22日至29日在意大利威尼斯举行的IEEE计算机视觉国际会议记录。[谷歌学者]

- Lim,B。;儿子S。;Kim,H。;不,S。;Lee,K.M.增强的单图像超分辨深度剩余网络。2017年7月21日至26日,美国夏威夷州火奴鲁鲁,计算机视觉与模式识别研讨会论文集。[谷歌学者]

- 洛夫,S。;Szegedy,C.批处理规范化:通过减少内部协变量偏移来加速深层网络训练。arXiv公司 2015,预印本。arXiv:1502.03167。[谷歌学者]

- 医学博士泽勒。;G.W.泰勒。;Fergus,R.中高级特征学习的自适应反卷积网络。在2018年11月6日至13日于西班牙巴塞罗那举行的IEEE国际计算机视觉会议论文集上。[谷歌学者]

- Wald,L。;Ranchin,T。;Marc,M.不同空间分辨率卫星图像的融合:评估结果图像的质量。照片。工程远程传感器。 1997,63, 691–699. [谷歌学者]

- P.E.丹尼森。;哈利根,K.Q。;Roberts,D.A.多端成员光谱混合分析和光谱角度映射器的误差度量和约束的比较。遥感环境。 2004,93, 359–367. [谷歌学者] [交叉参考]

- 周,J。;Civco,D.L。;Silander,J.A.,一种用于合并Landsat TM和SPOT全色数据的小波变换方法。《国际遥感杂志》。 1998,19, 743–757. [谷歌学者] [交叉参考]

- Ayhan,E.平移锐化过程中的光谱和空间质量分析。J.印度社会遥感。 2012,40, 379–388. [谷歌学者] [交叉参考]

- 王,Z。;Bovik,A.C.通用图像质量指数。IEEE信号处理。莱特。 2002,9, 81–84. [谷歌学者] [交叉参考]

- 曾勇。;黄,W。;刘,M。;张,H。;Zou,B.城市地区卫星图像的融合:评估结果图像的质量。2010年6月18日至20日,中国北京,2010年第18届国际地球信息学会议记录。[谷歌学者]

- Garzelli,A。;Nencini,F.多光谱/高光谱图像的超复杂质量评估。IEEE地质科学。遥感快报。 2009,6, 662–665. [谷歌学者] [交叉参考]