CenterNet姿势估计网 培训时间

MS-COCO数据

训练集信息

-

微软COCO 这是一个用于图像识别、分割和字幕的数据集,由80个不同对象类的30多万张图像组成。

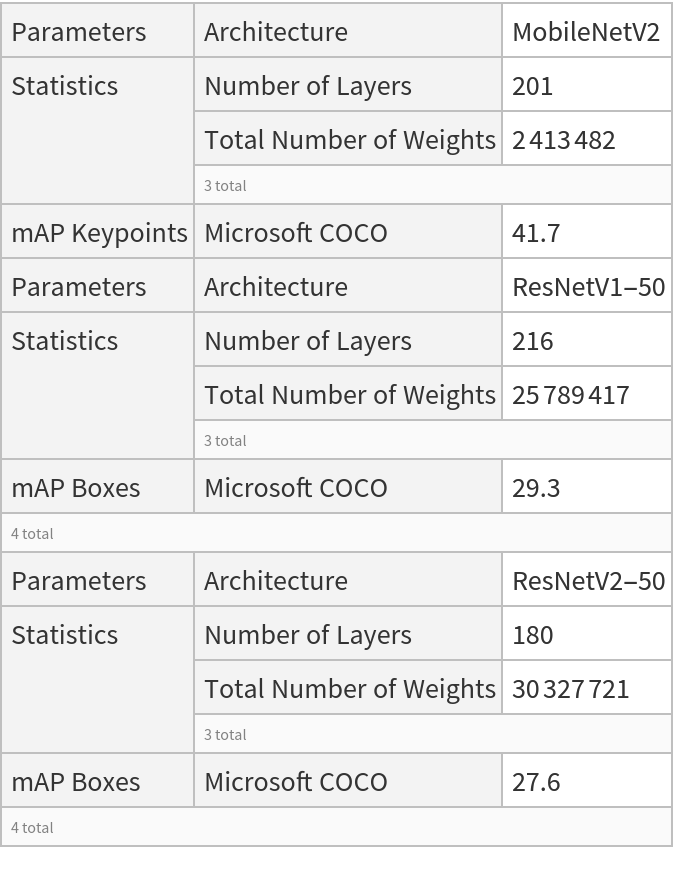

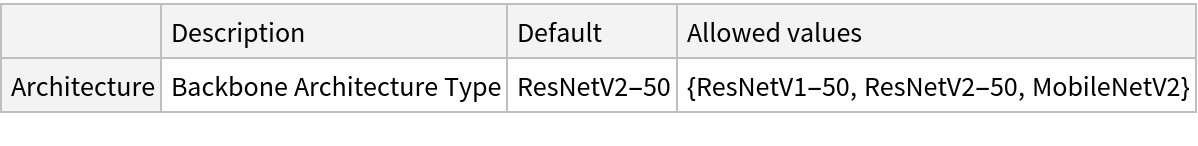

型号信息

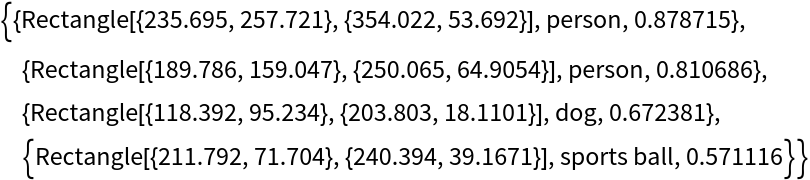

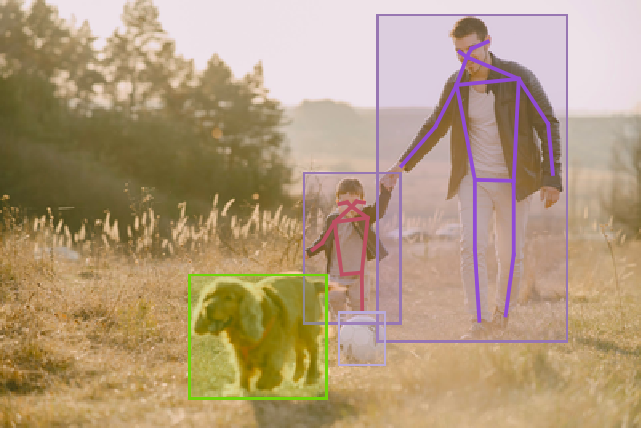

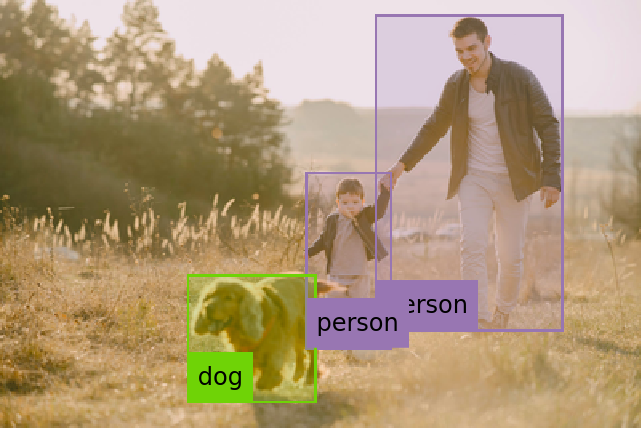

示例

资源检索

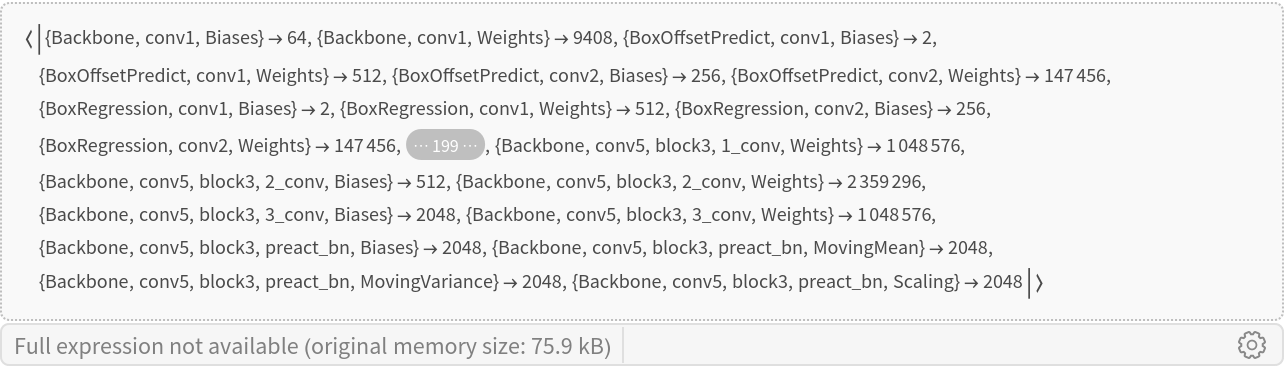

NetModel参数

|

评估功能

![(*评估此单元格以获取示例输入*)CloudGet[“https://www.wolframcloud.com/obj/96ac21ef-3eb3-460b-8ae9-31fa3977a291"]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/0e09cac1643eb1a2.png) |

![Options[netevaluate]=加入[Options[alignKeypoints],Options[decode]];netevaluate[net_,img_Image,opts:OptionsPattern[]]:=块[{比例,预测},预测=解码[net,img,Sequence@@DeleteCase[{opts},“NeighborhoodRadius”|“FilterOutsideDetections”->_]];比例=最大值@N[图像尺寸[img]/反向@静止@NetExtract[net,NetPort[“PosePeaks”]]];alignKeypoints[预测,“FilterOutsideDetections”->OptionValue[“FilterOffsideDeections”],“NeighborhoodRadius”->选项值[“NeighborhoodRadius”]*比例]]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/3b2bf07f18b36d46.png) |

基本用法

![(*评估此单元格以获取示例输入*)CloudGet[“https://www.wolframcloud.com/obj/1ac8b227-06bb-4acf-bf64-123358367291"]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/521fe7842223f455.png) |

|

|

|

|

![{{1, 2}, {1, 3}, {2, 4}, {3, 5}, {1, 6}, {1, 7}, {6, 8}, {8, 10}, {7, 9}, {9, 11}, {6, 7}, {6, 12}, {7, 13}, {12, 13}, {12, 14}, {14, 16}, {13, 15}, {15, 17}};getSkeleton[personKeypoints_]:=行[DeleteMissing[地图[personKeypoints[[#]]&,{{1,2},{1,3},}2,4],{3,5},13}, {12, 13}, {12, 14}, {14, 16}, {13, 15}, {15, 17}}], 1, 2]]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/320fc4e7eac8a0b0.png) |

![HighlightImage[测试图像,追加[AssociationThread[Range[Length[#]]->#]&/@{keypoints,Map[getSkeleton,keypoints]},GroupBy[预测[“ObjectDetection”][[全部,;2]],最后->第一]],图像标签->无]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/001d523a220a2f9f.png) |

|

高级可视化

![(*评估此单元格以获取示例输入*)CloudGet[“https://www.wolframcloud.com/obj/2e67ed23-827d-4440-a269-cb17a44084bb"]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/7d2c155ffaa3464d.png) |

![预测=净评估[NetModel[“基于MS-COCO数据训练的CenterNet姿态估计网络”],testImage2,“ObjectDetectionThreshold”->0.28,“HumanPoseThreshold->0.2”,“FilterOutsideDetections”->True];keypoints=预测[“KeypointEstimation”];](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/4e43bd0047bce481.png) |

![突出显示图像[testImage2,AssociationThread[Range[Length[#]]->#]&/@{keypoints,Map[getSkeleton,keypoints],predictions[[“ObjectDetection”,All,1]]}关联线程[Range[长度[#]]->#]],图像标签->无]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/254183d511f3d625.png) |

|

![网格@列表@表[预测=净评估[NetModel(网络模型)[“在MS-COCO数据上训练的CenterNet姿势估计网”],testImage2,“ObjectDetectionThreshold”->0.28,“HumanPoseThreshold”->0.2,“NeighborhoodRadius”->r,“FilterOutsideDetections”->错误];突出显示图像[testImage2,AssociationThread[Range[Length[#]]->#]和/@{predictives[“关键点估计”],地图[getSkeleton,预测[“关键点估算”]],预测[[“ObjectDetection”,All,1]]},图像标签->无],{r,{1,5,8}}]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/26699bb056324d40.png) |

|

网络对象检测结果

|

![res=映射[Transpose[#,{3,2,1}]&,res];res[“BoxOffsets”]=映射[Reverse,res[“盒偏移”],{2}];res[“BoxSizes”]=映射[Reverse,res[“盒子大小”],{2}];](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/3a1091618fb987c6.png) |

|

![图形[贴图线程[{EdgeForm[Opacity[Total[#1]*0.5]],#2}&,{展平@映射[Max,res[“ObjectHeatmas”],{2}],映射[boxDecoder[#,{128,128},1]&,boxes]}],BaseStyle->{FaceForm[],EdgeForm[{Thin,Black}]}]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/23619b17e8a0a9c6.png) |

|

![图形[MapThread[{EdgeForm[Opacity[#1]],矩形@@#2}&,{扁平[res[“ObjectHeatmaps”][[All,All,idx]]],映射[boxDecoder[#,{128,128},1]&,boxes]}],BaseStyle->{FaceForm[],EdgeForm[{Thin,Black}]}]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/119605e938c34212.png) |

|

![HighlightImage[testImage,图形[映射线程[{EdgeForm[{不透明度[#1]}],#2}&,{展平[res[“ObjectHeatmaps”][[All,All,idx]]],映射[boxDecoder[#,ImageDimensions[testImage],最大值@N[ImageDimensions[testImage]/{128,128}]]&,boxes]}]],BaseStyle->{FaceForm[],EdgeForm[{Thin,Red}]}]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/69fc75d7f1444716.png) |

|

热图可视化

![(*评估此单元格以获取示例输入*)CloudGet[“https://www.wolframcloud.com/obj/cb65e6fb-7b1b-49ea-af60-8df89bc2ec56"]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/58795eb06da65349.png) |

![objectHeatmaps=NetModel[“根据MS-COCO数据训练的CenterNet姿势估计网络”][testImage][“ObjectHeatmaps”];](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/7d8db2e6cdd676db.png) |

|

|

|

![idx=位置[labels,“dog”][[1,1]];strengthArray=对象热图[[idx]];heatmap=ImageApply[{#,1-#,1-#}和,ImageAdjust@图像[strongthArray]];heatmap=图像拍摄[图像大小调整[heatmap,{Max[#]}],{1,Last[#]{,{1&@图像尺寸[testImage]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/321ac81e97038bb0.png) |

|

|

![可视化热图[img_Image,heatmap_]:=块[{strongthArray,w,h},{w,h}=图像尺寸[img];strongthArray=贴图[Max,Transpose[heatmap,{3,1,2}],{2}];strongthArray=图像应用[{#,1-#,1-#}&,图像调整@图像[strongthArray]];strongthArray=ImageTake[ImageResize[strongtharray,{Max[w,h]}],{1,h},{1、w}];图像合成[img,{ColorConvert[strongthArray,“RGB”],0.4}]];](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/3d38b07500ce612a.png) |

![地图[visualizeHeatmap[testImage,#]&,NetModel[“在MS-COCO数据上训练的CenterNet姿势估计网络”][testImage,{“对象热图”,“姿势热图”}]]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/699b75b4dd08ae90.png) |

|

适合任何尺寸

|

![newEncoder=NetEncoder[{“Image”,{320,320},Method->“Fit”,Alignment->{Left,Top},“MeanImage”->NetExtract[encoder,“Mean Image”],“VarianceImage”->NetExtract[编码器,“VaranceImage”]}]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/50fd580537e9aa9d.png) |

![resizedNet=网络替换部件[NetModel[“在MS-COCO数据上训练的CenterNet姿势估计网络”],“Input”->newEncoder]](https://www.wolframcloud.com/obj/resourcesystem/images/ad9/ad9e7395-15c4-4423-b9b5-f3f82e31be30/2024829dd5a45d33.png) |

|

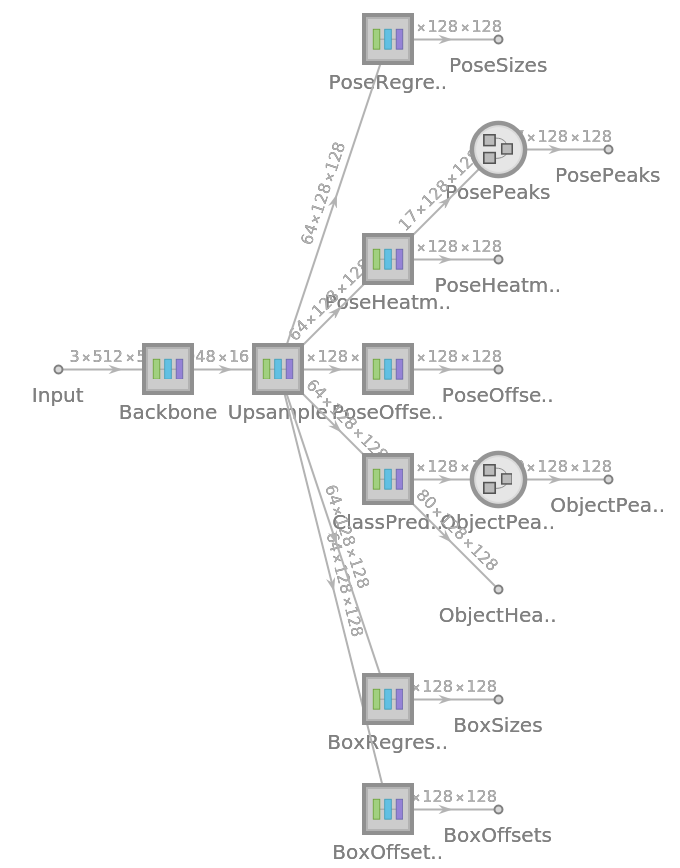

净信息

|

|

资源历史记录

参考

-

X.Zhou,D.Wang,P.Krähenbühl,“物体作为点”,arXiv:1904.07850(2019) 可从以下位置获得: https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/tf2_detection_zoo.md -

权利: 版权所有2022 Google LLC。保留所有权利。 Apache许可证2.0