重要提示: Synaptic 2.x公司 现在正处于讨论阶段! 欢迎参与

npm安装synaptic--保存 凉亭安装突触 < 脚本 型钢混凝土 =" https://cdnjs.cloudflare.com/ajax/libs/synaptic/1.1.4/synaptica.js " > </ 脚本 > 无功功率,无功功率 突触的 = 要求 ( “突触” ) ; //浏览器中不需要此行

无功功率,无功功率 神经元 = 突触的 . 神经元 ,

图层 = 突触的 . 图层 ,

网络 = 突触的 . 网络 ,

教练 = 突触的 . 教练 ,

建筑师 = 突触的 . 建筑师 ; 功能 感知器 ( 输入 , 隐藏的 , 输出 )

{

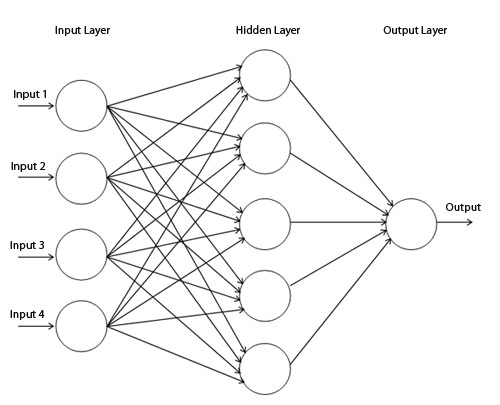

//创建图层

无功功率,无功功率 inputLayer(输入层) = 新的 图层 ( 输入 ) ;

无功功率,无功功率 隐藏层 = 新的 图层 ( 隐藏的 ) ;

无功功率,无功功率 outputLayer(输出层) = 新的 图层 ( 输出 ) ;

//连接图层

inputLayer(输入层) . 项目 ( 隐藏层 ) ;

隐藏层 . 项目 ( outputLayer(输出层) ) ;

//设置图层

这 . 设置 ( {

输入 : inputLayer(输入层) ,

隐藏的 : [ 隐藏层 ] ,

输出 : outputLayer(输出层)

} ) ;

}

//扩展原型链

感知器 . 原型 = 新的 网络 ( ) ;

感知器 . 原型 . 建造师 = 感知器 ; 无功功率,无功功率 我的感知器 = 新的 感知器 ( 2 , 3 , 1 ) ;

无功功率,无功功率 我的培训师 = 新的 教练 ( 我的感知器 ) ;

我的培训师 . 异或 ( ) ; //{错误:0.004998819355993572,迭代次数:21871,时间:356}

我的感知器 . 激活 ( [ 0 , 0 ] ) ; // 0.0268581547421616

我的感知器 . 激活 ( [ 1 , 0 ] ) ; // 0.9829673642853368

我的感知器 . 激活 ( [ 0 , 1 ] ) ; //0.9831714267395621

我的感知器 . 激活 ( [ 1 , 1 ] ) ; // 0.02128894618097928 功能 LSTM公司 ( 输入 , 阻碍 , 输出 )

{

//创建图层

无功功率,无功功率 inputLayer(输入层) = 新的 图层 ( 输入 ) ;

无功功率,无功功率 inputGate(输入门) = 新的 图层 ( 阻碍 ) ;

无功功率,无功功率 遗忘之门 = 新的 图层 ( 阻碍 ) ;

无功功率,无功功率 内存单元格 = 新的 图层 ( 阻碍 ) ;

无功功率,无功功率 outputGate输出门 = 新的 图层 ( 阻碍 ) ;

无功功率,无功功率 outputLayer(输出层) = 新的 图层 ( 输出 ) ;

//来自输入层的连接

无功功率,无功功率 输入 = inputLayer(输入层) . 项目 ( 内存单元格 ) ;

inputLayer(输入层) . 项目 ( inputGate(输入门) ) ;

inputLayer(输入层) . 项目 ( 遗忘之门 ) ;

inputLayer(输入层) . 项目 ( outputGate输出门 ) ;

//来自存储单元的连接

无功功率,无功功率 输出 = 内存单元格 . 项目 ( outputLayer(输出层) ) ;

//自我联系

无功功率,无功功率 自己 = 内存单元格 . 项目 ( 内存单元格 ) ;

//窥视孔

内存单元格 . 项目 ( inputGate(输入门) ) ;

内存单元格 . 项目 ( 遗忘之门 ) ;

内存单元格 . 项目 ( outputGate输出门 ) ;

//闸门

inputGate(输入门) . 大门 ( 输入 , 图层 . 闸门类型 . INPUT(输入) ) ;

锻造闸门 . 大门 ( 自己 , 图层 . 网关类型 . ONE_TO_ONE(一对一) ) ;

outputGate输出门 . 大门 ( 输出 , 图层 . 网关类型 . 输出 ) ;

//输入到输出直接连接

inputLayer(输入层) . 项目 ( outputLayer(输出层) ) ;

//设置神经网络的层

这 . 设置 ( {

输入 : inputLayer(输入层) ,

隐藏的 : [ inputGate(输入门) , 遗忘之门 , 内存单元格 , outputGate输出门 ] ,

输出 : outputLayer(输出层)

} ) ;

}

//扩展原型链

LSTM公司 . 原型 = 新的 网络 ( ) ;

LSTM公司 . 原型 . 建造师 = LSTM公司 ; BTC:16ePagGBbHfm2d6esjMXcUBTNgqpnLWNeK公司 以太币:0xa423bfe9db2dc125dd3b56f215e09658491cc556 LTC:LeeemeZj6YL6pkTTtEGHFD6idDxHBF2HXa XMR:46WNbmwXpYxiBpkbHjAgjC65cyzAxtaaBQjcGpAZquhBKw2r8NtPQniEgMJcwFMCZzSBrEJtmPsTR54MoGBDbjTi2W1XmgM