2023年1月1日原本是一项开创性的新法律的开始日期。在一个技术发展如此迅速以至于政府几乎无法对其进行监管的时代,纽约市议会成功批准了世界上第一项立法,打击招聘和人力资源中使用的人工智能。这标志着朝着企业透明度和负责任的人工智能迈出了一大步。但在12月13日,法律被推迟了。

现在计划于4月生效的202号地方法律第144条将禁止公司使用任何“自动就业决策工具”,除非他们通过了偏见审计。任何用于评估员工或潜在员工的机器学习、统计建模、数据分析或基于人工智能的软件都必须接受公正、独立审计师的审查,以确保不会产生歧视性结果。审计结果必须在公司网站上公开。此外,法律规定,求职者和员工都必须被告知将使用该工具对他们进行评估,并赋予他们请求替代选择的权利。

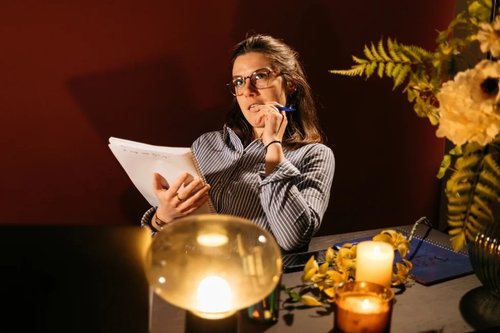

为了找出该法案被推迟的原因,以及如果当前版本发生变化,将面临什么样的风险,我们采访了企业招聘人员出身的AI伦理学家Merve Hickok。作为《财富》500强公司的前人力资源主管,她离开了商界,专注于人权。她是AIethistist.org的创始人,AIethisist.org是一个提供人工智能伦理的策划研究和报告的平台,她还共同创建了一个独立智库人工智能和数字政策中心。

希科克从初稿开始就参与其中,她告诉我们为什么这项法律如此难以实施,她所看到的让她担忧的事情,以及AI偏见如何会产生重大后果——有利和不利就业市场中的平等.

本次采访是在2022年12月23日之前进行的,当时立法的新版本由纽约市消费者和工人保护部提出。该草案的公开听证会定于2023年1月23日举行。

你能告诉我一些你的专业背景吗?是什么让你离开公司招聘去追求道德?你现在在做什么?

我在美林和美国银行的人力资源部门工作了多年。我担任过许多高级人力资源职位:在美国银行,我负责多元化招聘对近30个国家的不同招聘技术等进行基准测试。

当我告诉潜在员工投资银行的不同机会时,我也听到了他们的一些障碍申请这些工作这是我的‘aha’时刻:“好吧,如果你不负责任地做这件事,你可能会把人们关在门外,或者在已经处于不利地位的社区面前设置额外的障碍。”

视频采访技术刚刚问世。我意识到,例如,如果你要求应聘者进行视频面试记录自己,他们可能无法接入宽带互联网,或者没有安静的房间,或者没有照相机。当我离开时,人工智能产品开始变得更加流行,这些问题变得更加关键和普遍。

人工智能如何加剧招聘过程中的偏见?

一些人工智能招募产品的推出没有任何科学依据。然后其中一些是在没有保障的情况下开发的。招聘过程可能会受到多种方式的影响偏置人工智能系统例如,其中一些人工智能模型被编程用来检测简历或面试问题答案中的某些关键词或单词组合。你可能对面试问题有一个非常复杂的答案。然而,如果提供的答案不符合AI开发用于检测的任何要求,那么您的响应将被视为不够好。或者,系统可以扫描你的简历找不到这些关键词;或者算法可能在技能是相关的针对特定角色;或者,如果集成了语音系统,它可以根据系统中被判断为“正常”的内容来判断您声音的音高或音调。

我认为,如果你去面试,招聘人员告诉你,他们会根据你的音调或者你的话很复杂,你会对此有一些问题。这种系统对于有口音的人、非母语的人或有语言障碍的人也没有很好的准确率…就像语音助理一样。

另一个问题是使用计算机视觉系统识别人脸。一些伪科学人工智能系统会观察你的面部结构、身体反应等,并对你的性格进行推断。更糟糕的是,他们通常无法准确识别深色皮肤或女性或者他们在视频中拾取噪音(即其他背景图像)。所以你有这些真正的伪科学系统在对你做出判断。

人工智能偏见比人类招聘人员的偏见更危险吗?

是和否。人工智能的好处是你正在标准化一个过程。你编写代码,然后这条规则适用于所有人。然而,人类创造的数据和代码很有可能会受到其偏见的影响然后,代码会对成千上万的人做出有偏见的决定。如果只是人类的偏见,你所能造成的伤害就只有这么多。如果是两个招聘人员评估简历一整天,也许他们每天都要审查100名候选人。你可以在几分钟甚至几秒钟内在一个人工智能系统中运行数千名候选人。所以规模和速度是非常不同的。

纽约市的新立法本应于1月1日生效,但已移至4月23日。我听说这是因为立法不够明确,企业无法遵守法律。根据你的经验,这是真的吗?

还有一些事情需要进一步发展和澄清。然而,这并不能阻止这项立法被推迟到四月份。

有许多负责任的供应商和雇主。然而,也有很多企业不想对他们使用的人工智能系统的具体结果透明。拟议的规则之一是,雇主需要公布不同申请群体的准确选择率和影响比率例如,这么多黑人和白人候选人,或者男性和女性候选人,已经通过了这个系统,以及与另一组相比,有多少属于其中一组的人被选中。如果拟议的规则获得通过,这将意味着所有这些雇主(那些没有商业必要要求他们做出不同选择的雇主)都必须承认他们可能不会这样做多样化地雇用或者,如果他们一直在回避关于他们使用的人工智能系统的问题,那么现在他们需要采取行动。

我最担心的是,一些企业会给纽约市议会一是缩小立法范围和适用范围,二是取消一些透明度要求。

*你可以阅读由倡导者、企业和行业团体提交给纽约市消费者和工人保护部的关于拟议法律的所有评论在这里.

你认为这项立法最重要的更新是什么?

绝对要确保,按照提议,结果是透明的。第二,审计应独立进行。所以,现在,由于没有任何既定的审计生态系统,许多公司都会选择不同的供应商,这些供应商将自己定位为审计师。他们中的一些人要去内部审计部门。他们中的一些人要去找律师。因此,独立性需要明确。

有足够的独立审计师供这些企业使用吗?

没有。因为没有关于偏见审计的现行立法。然而,不同影响分析[衡量选拔程序是否因种族、肤色、宗教、性别或民族血统而不成比例地排斥人员的计算方法]并不新鲜。它已经存在了几十年。这一直是组织自己进行的事情。

如果这项立法像现在写的那样通过,所有这些公司都突然需要独立审计师,你认为这会刺激一个全新行业的发展吗?

对。

但在纽约市,是否有审计技术偏见的许可证或执照?

现在还没有。这就是为什么每个人都在定义偏见审计,因为它与他们的观点是一致的——有些非常狭隘,有些供应商提出了更深入、更负责的问题。有一个名为“人性化”的伟大组织,它正试图为人工智能系统构建独立审计生态系统,并问道:“广泛接受的审计标准应该是什么?审计师的认证应该是什么样的?”?在薪酬、客户数量、利益冲突和道德规范-看起来像吗?审计师应如何报告?

你认为,审计人工智能偏见应该由什么构成?

其中包含的数据、算法和组织决策。

第一,需要进行审计,以确保您构建算法所依据的数据在开始时没有偏见。它反映了您部署它的环境以及应用它的人群。例如,如果您使用德克萨斯州的人群构建算法,那么在比利时或意大利就不能使用相同的训练集。这些劳动力是不同的。

模型[算法编程的方式]也应进行审核。模型中做出了哪些决策?准确率是多少?其中包含哪些设计决策?结果是否公平分布,或者模型是否为不同组产生了有偏差的输出?

第三件是:谁做的决定?开发人工智能模型的团队是否多样化?雇主如何注意和管理系统中出现的风险?招聘人员是否接受过如何正确使用该系统的培训,这样他们就不会只从表面上看一切了?

你认为大多数大型人工智能招聘软件会通过你理想的审计吗?

不,一把会的。但是,监管真空和缺乏监管带来了很多好处。如果缩小法律和透明度要求的范围,可能会产生不太理想的审计实践,从长远来看,这对任何雇主、供应商和候选人都不有利。我们需要雇主和供应商采取负责任的行动,提高负责任创新的门槛从长远来看,这对雇主和供应商的多样性、利润和品牌都有很大好处。

如果提议的改变生效,你认为求职者会感受到哪些变化?

你可以看到你面对的是什么样的雇主。什么是雇佣实践是你雇主的。你可以看到数据,他们是如何做出决定的,如果结果有很大的偏差,他们是怎么缓解的。作为一名候选人,你将有更好的机会为招聘过程做好准备,并更好地了解情况关于流程中的决策。

有人说,通过审计,人工智能有潜力消除招聘过程中的人为偏见,并使整个招聘系统更加公平。你认为那是真的吗?

我不知道是100%,但它确实提供了可审计的跟踪和可追溯性。你可以回过头来看看是采用了什么样的规则来评估候选人并解决这个问题。你可以回到过去,查看审计跟踪,查看模型,然后对其进行逆向工程并修复它,使其不那么偏向。所以,至少你有审计线索,而且决策更清晰。你不可能在人类身上达到同样的程度。

显然,该评论排除了原本不应存在的伪科学人工智能系统。

你还想补充什么吗?

我想说得很清楚:这项纽约市法律是第一部此类立法。这是世界上第一个授权AI偏见审计的司法管辖区。许多州、城市和国家都将此视为一个可能的例子。如果这在纽约市奏效,那么其他司法管辖区也可以采用。因此,如果某些当事人设法缩小法律的范围,并将其淡化为无用的案件,那么可能会在更大的层面上产生连锁影响。是的,这项法律可以得到显著改进,但我认为纽约市议会有一个极好的机会成为世界上的先驱并领导这项努力。

照片:欢迎来到丛林

关注《欢迎来到丛林》脸谱网, LinkedIn链接、和一款图片分享应用,并订阅我们的时事通讯每天获取我们的最新文章!