标题:过参数神经网络中噪声训练的熵

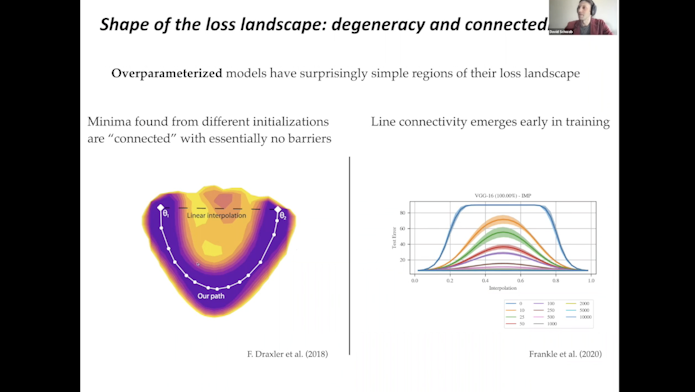

摘要:随机梯度下降(SGD)是深度神经网络的核心优化方法。虽然在理论上取得了一些进展,但仍不清楚为什么SGD会将超参数网络中的学习动力学引入到通用性较好的解决方案中。这里我们表明,对于损失景观中具有退化山谷的超参数网络,SGD平均减少了损失的Hessian轨迹。我们还将这一结果推广到其他噪声结构,并表明Hessian非退化子空间中的各向同性噪声减少了其行列式。接下来,我们将讨论有监督学习的特征描述和最佳表示的发现问题。传统上,这个问题是使用信息瓶颈来解决的,该瓶颈以一种与解码器无关的方式压缩输入,同时保留有关目标的信息。我们提出了可解码信息瓶颈(DIB),该瓶颈从预期预测族的角度考虑信息保留和压缩。经验上,我们表明该框架可以用于在下游分类器上施加较小的泛化间隙,并预测神经网络的泛化能力。

缩放链接