免费解锁编辑摘要

英国《金融时报》(FT)编辑鲁拉·哈拉夫(Roula Khalaf)在本周刊中选择了她最喜欢的故事。

威士忌天生就是女人吗?烧烤有女孩的联想吗?一项研究揭示了人工智能(AI)算法学习将女性与厨房照片联系起来,该算法基于一组照片,厨房里的人更有可能是女性。当它审查了来自互联网上的10万多个标签图像时,它的偏倚关联变得比数据集显示的更强烈——放大而不是简单地复制偏倚。

弗吉尼亚大学(University of Virginia)的这项研究是多项研究之一,这些研究表明,如果不仔细考虑机器学习系统的设计和数据集,它们很容易产生偏差。

波士顿大学(Boston University)和微软(Microsoft)的研究人员利用谷歌新闻(Google News)的数据进行的另一项研究创建了一种算法,该算法通过偏见将女性标记为家庭主妇,将男性标记为软件开发人员。其他实验也检验了翻译软件的偏见,翻译软件总是将医生描述为男性。

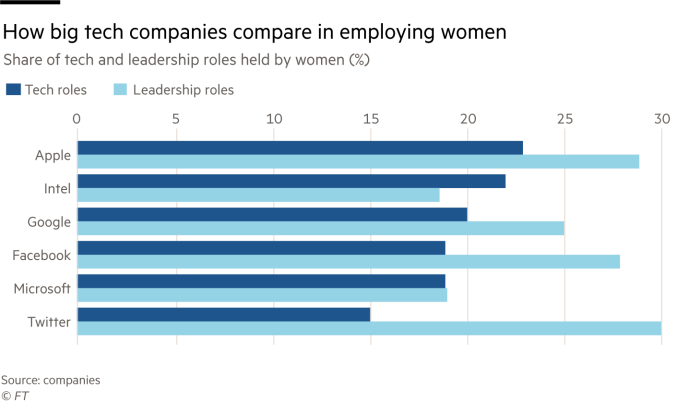

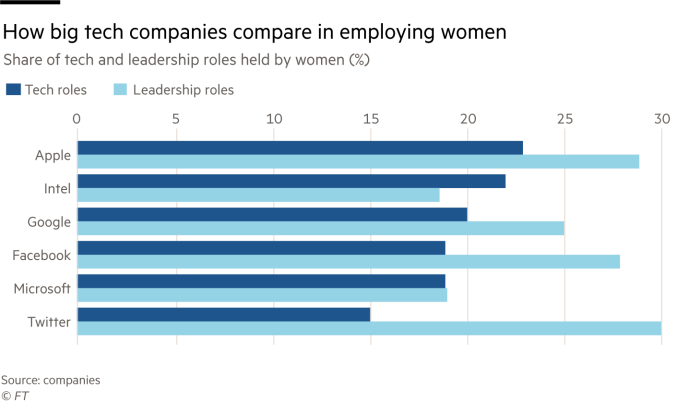

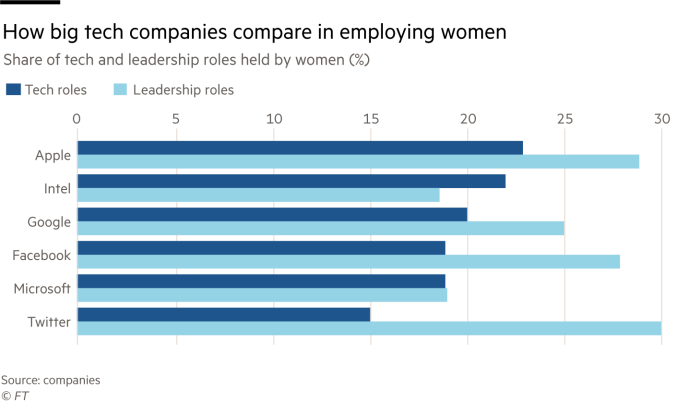

考虑到银行、医疗保健公司和政府部署的算法正在迅速为更多关于我们生活的决策负责,内置的性别偏见令人担忧。然而,人工智能行业雇用的女性比例甚至低于其他技术部门,人们担心没有足够的女性声音影响机器学习。

Sara Wachter-Boettcher是技术上错误,讲述了白人男性科技行业如何创造出忽视女性和有色人种需求的产品。她认为,提高技术多样性的重点不应该只针对技术员工,也应该针对用户。

Wachter-Boettcher女士表示:“我认为,我们并不经常谈论这对技术本身有多不利,而是谈论这对女性职业生涯有多不利。”。“那些正在深刻改变和塑造我们社会的东西,仅仅是由一小部分有着一小部分经历的人创造出来的,这有关系吗?”

她认为,专门研究人工智能的技术人员需要非常仔细地研究他们的数据集来自何处以及存在哪些偏见。他们还应该检查失败率——Wachter Boettcher女士说,有时人工智能从业者会对低失败率感到满意,但如果它总是让同一组人失败,这还不够好。

她说:“特别危险的是,我们正在将所有这些责任转移到一个系统中,然后仅仅相信这个系统是没有偏见的。”她补充说,这甚至可能“更危险”,因为很难知道为什么机器会做出决定,而且随着时间的推移,它可能会变得越来越有偏见。

泰斯·波斯纳(Tess Posner)是AI4ALL的执行董事,这是一家非营利组织,旨在让更多女性和被低估的少数民族对AI职业感兴趣。该组织成立于去年,为在校学生开办夏令营,以便在美国大学更多地了解AI。

去年夏天,学生们正在向他人传授他们所学的知识,传播如何影响人工智能的知识。一名参加过暑期课程的高中生在一次关于神经信息处理系统的会议上获得了最佳论文,其他参赛者都是成年人。

波斯纳女士说:“最有效地吸引女孩和被低估人群的一件事是,这项技术将如何解决我们世界和社区中的问题,而不是作为一个纯粹的抽象数学问题。”。

“一些例子是使用机器人和自动驾驶汽车来帮助老年人。另一个例子是通过使用计算机视觉和自然语言处理(所有人工智能应用程序)来确定自然灾害后向何处发送援助,从而确保医院的安全。”

然而,人工智能发展的速度意味着它不能等待新一代来纠正潜在的偏见。

Emma Byrne是伦敦金融科技初创公司10x Banking的高级和人工智能数据分析主管。她认为,重要的是让女性在房间里指出产品的问题,对于一个每天都没有感受到歧视“本能”影响的白人男性来说,这些问题可能不会那么容易发现。她说,人工智能领域的一些男性仍然相信技术是“纯粹的”和“中立的”。

然而,她说,推动减少人工智能中的偏见不应该总是被低估群体的责任。

她说:“对于年轻女性和有色人种进入这条职业道路,我担心的一件事是,我不想让我们把20%的精力花在组织的良知或常识上。”。

她认为,这项技术可能需要某种法律框架,而不是让女性来推动雇主实现无偏见和合乎道德的人工智能。

她说:“找出并纠正这种偏见的代价是高昂的。如果你能迅速进入市场,这是非常诱人的。你不能指望每个组织都有这些强大的价值观来确保消除产品中的偏见。”。