1.简介

直觉上,在向读者介绍文本特征方面,文本的某些元素比其他元素更重要。在语料库语言学中,这个直观的概念已经发展成为一种被称为关键词分析的方法(最近的综述见Gabrielatos和Marchi,2011年;Egbert和Biber,2019年;格里斯,2021年). 多年来,关键词分析已经成为语料库语言学中定量文本分析的一个重要组成部分,通过词汇或其他语言元素的贡献来检查从新闻文章到色情叙事的各种文本变体的特征(参见Gabrielatos和Marchi,2011年;Egbert和Biber,2019年,以全面了解研究)。

最近,关键字分析的方法学发展引起了人们的兴趣,例如Egbert和Biber(2019)和格里斯(2021).本研究正是在这种背景下进行的。我们提出了一种基于预测而非统计计算的关键字分析新方法。我们通过研究包含两种文本类型(新闻和博客)的语料库的特征来例证这种方法。通过使用线性支持向量机作为分类器,该方法不仅可以预测与给定文本相关的文本变化,还可以基于文本变化与其语言特征之间的学习映射构建推理。

尽管语料库语言学中的关键词分析有着悠久的传统,但令人惊讶的是,还没有多少人尝试建立一种系统的方法来评估特定方法中提取的关键词。在定量研究中,提供一些拟合优度的测量是一种常见的做法。最近,这种情绪得到了Egbert和Biber(2019)当他们说:“虽然我们相信这些简单的方法对评估各种关键字方法很有用,但未来的研究可以探索更复杂的指标来评估和比较关键字列表。”类似的情况也可以在基于NLP的研究中找到(有关最近的讨论,请参阅Rönnqvist等人,2022年). 同时,大量研究考察了不同的方法,考虑到从语料库中提取关键词的不确定性,而不是提取过程本身的质量。关键字分析中使用的各种统计数据的出色摘要见Pojanapunya和Todd(2018年)为了评估关键词的质量,我们根据机器学习中应用的变量的有用性和相关性之间的明确区别,制定了严格、正式的指标来评估关键词(参见Guyon和Elisseeff,2003年)同时与以下人员讨论的评估保持对话Egbert和Biber(2019).

在详细讨论我们提出的方法之前,我们简要概述了关键词分析的核心概念以及它在语料库语言学中是如何操作的。这为我们提供了更好地定位拟议方法的机会。

1.1. 语料库语言学中的关键词和关键词

关键词分析为文本内容的定量语言分析提供了一种手段。迈克·斯科特(Mike Scott)提出了一个简单但有效的定义,该定义仍然提供了关键字分析的基本构件:关键字是指与参考语料库相比,在目标语料库中出现频率“异常”的单词(斯科特,1997年:236,有关关键字的各种定义的讨论,请参见斯塔布斯,2010年). 因此,当以这种方式定义时,关键词分析的目的是识别与其他集合相关的文本集合特征信息最丰富的单词。在关键词分析中,前一组文本被称为目标语料库,后一组被称为参考语料库。

文本特征的概念在关键词分析中起着至关重要的作用。它可以被广泛理解,涵盖了目标语料库中表达的风格、话语域或功能特征的各种差异,也可以从更狭义上解释,侧重于目标语料的“大约性”,即其主要概念、主题或态度(参见。威廉姆斯,1976年;菲利普斯,1989年;Scott和Tribble,2006年;邦迪和斯科特,2010年;Gabrielatos和Marchi,2011年).

最近,Egbert和Biber(2019)认为关键词分析的重点应该放在aboutness上,aboutnessy尤其通过内容词来表达&与文本中表达的主题相关的名词和动词。然而,关于文本分类的研究表明,仅仅关注主题词往往缺乏对新文本的概括能力,因为即使在新闻或百科全书文章等文本类别中,主题也会有很大差异(参见Petrenz和Webber,2011年;Laippala等人,2021年). 这得到了以下研究结果的支持Laippala等人(2021年)who表示,语法信息的包含可以提高文本分类中模型的泛化能力。因此,仅关注关于性可能会限制关键字分析对刚好属于目标语料库并共享类似主题的文本的泛化。另一方面,如果分析主要基于语法和虚词,则关键词分析不太可能捕捉到文本的所有相关特征,因为内容词也需要对其进行充分描述。因此,我们认为,关键词分析需要仔细考虑关于性和其他文本特征,以提供文本重要方面的完整视角——我们将在整个当前研究中提出这一点,并在一般讨论部分进行详细讨论。

除了aboutness和其他文本特征之间的区别之外,关键字分析的另一个最近受到广泛关注的方面是如何度量关键字,即如何从目标语料库中的大量单词中提取关键字并确定关键字的相对排名。有两个与传统关键字分析相关的重要方面。首先,传统的关键词分析依赖于简单的统计数据,例如,一个chi-squared测试(阿尔茨,1971年),对数似然比(Rayson和Garside,2000年)和频率差异(Gabrielatos和Marchi,2011年)等等。其次,传统的关键词分析依赖于频率。然而,有许多不同的方法可以计算单词的频率。传统上,频率是根据给定单词在目标语料库和参考语料库中的出现来计算的。然而,作为Egbert和Biber(2019)已经指出,以这种方式计算频率并不考虑编译目标语料库和参考语料库所用的单个文本(另请参阅Gries,2008年). 因此,这些方法仅在目标语料库和参考语料库的层面上分析潜在差异,而不参考可能显示出广泛差异的文本。为此,Egbert和Biber(2019)建议基于离散度(即给定单词出现在文档中的数量)来确定关键性,并使用目标语料库和参考语料库的这些离散度度量进行对数似然估计(有关离散度的讨论,另请参阅格里斯,2021年). 他们将这一措施称为文本分散注释(TDK)。中的分析Egbert和Biber(2019)证明了TDK能够提取高质量的关键词。因此,我们将此方法用作当前研究中提出的基于预测的方法的比较点。

尽管TDK考虑了由目标语料库和参考语料库组成的各个文本,但并非给定语料库中的所有文本都是其预期类别的好例子。相反,文本的情景和语言特征可能会有所不同,例如,并非所有的新闻文章都是新闻类别的最佳范例。这一观察结果不仅出现在文本分类研究中,其中分类性能可以反映这种变化,而且也可以在文本注释任务中的语际协议中观察到(例如。,Egbert等人,2015年). 据我们所知,目前在关键字分析中使用的方法都没有将不确定性作为提取过程或关键性分数计算的一部分。在我们提出的方法中,由于其预测性,我们可以考虑这种变化,从而潜在地提高关键字的质量。重要的是,尽管关键词分析在语料库语言学中得到了广泛的应用,但目前的文献中还没有通用的方法来评估提取的关键词的质量(参见Egbert和Biber,2019年,用于最近关于该问题的讨论)。可以设计许多不同的方法来评估提取的关键字。然而,问题的关键在于为评估中使用的方法奠定基础。通过这种方式,也可以精确地定义关键字的质量的概念。只有通过量化这个概念,我们才能更好地理解描述特定文本特征时关键字的准确性。我们将在下一节探讨这些主题,在这里我们将介绍关键字分析的建议方法。

1.2. 目前的研究

在当前研究中,我们建议将关键字分析视为预测问题(有关预测的一般讨论,请参阅布雷曼,2001b;Shmueli,2010年而不是计算文本中单词的频率,然后进行统计测试来评估“异常频繁”的单词。因此,该方法的目标从比较目标语料库和参考语料库之间的频率计数转移到将单个文本分类为目标语料和参考语料。这种方法允许我们将关键词定义为那些有助于区分两个文本类别(即目标语料库和参考语料库)的单词。因此,关键性的概念也自然而然地作为给定关键字的辨别力而出现。重要的是,在这种方法中,目标语料库和参考语料库不被视为同质文本集合,而是将每个单独的文本分开分类。

如上所述,当前的关键字分析实践缺乏评估关键字质量的通用方法,这一点也由Egbert和Biber(2019)。将该方法理解为一个预测问题,使我们能够使用机器学习中常用的度量和概念来进行评估。这些是有用性和相关性的概念(Guyon和Elisseeff,2003年)其具有在机器学习中评估变量选择的悠久传统(例如。,Blum和Langley,1997年;Kohavi和John,1997年). 一般来说,有用变量是指保持高预测能力的变量子集,而相关变量是指对所调查类别具有高度描述性充分性的变量子集。

在本研究中,我们将有用性和相关性结合到Egbert和Biber(2019)专门评估关键性。因此,我们通过四个概念来检验估计关键字的有用性:1)可区分性,2)稳定性,3)显著性,和4)可概括性。我们在下面介绍这些概念,并讨论相关性及其与关键词分析的关系。

首先,预测模型的区分性能——模型在多大程度上区分了目标语料库和参考语料库中的文本——为量化关键词的有用性提供了直接方法。传统的基于计数的关键性评估方法不允许进行这种评估。从纯技术的角度来看,在机器学习中可以有许多标准度量来执行这样的评估。第5.2节对此进行了讨论。

第二,稳定性是指在目标语料库和参考语料库中,关键字对细微变化的一致性。这一点至关重要,因为估计的关键字是语料库编译过程的副产品,这可能会导致偏差和偏见,从而影响关键字(有关讨论,请参阅Pojanapunya和Todd,2018年;Geluso和Hirch,2019年以及其中的引文)。我们认为,面对语料库构成的细微变化(例如。,Laippala等人,2021年). 我们证明,在基于预测的关键性方法中,纳入稳定性度量是简单明了的,详见第5.2节。

在当前的研究中,有用性的第三个方面是独特性。这是指关键字相对于参考语料库反映其目标语料库特征的程度。此外,关键字并不仅仅代表一个无结构的单词列表;它们的排序应该反映它们与目标语料库的关系。有趣的是,Egbert和Biber(2019)他们提倡这种关系,称之为内容差异。他们按照以下方式定义:

内容确定性是指关键词与目标语料库所代表的话语域内容之间的关系强度[…]。(Egbert和Biber,2019年: 236)

与所提取关键字的有用性相关的第四个方面是可泛化性。关键词分析的主要重点是不仅深入了解目标语料库中特定文本的特征,而且深入了解与目标语料集代表相同话语域的新文本。对于基于预测的方法,通过评估模型对新文本的区分性能,可以很容易地量化泛化性,但这种评估不能用于传统的关键字分析。为了比较传统方法和基于预测的方法估计的关键词的可泛化性,我们提出了一个新的度量标准——词汇覆盖率,以反映在与目标语料库相同的话语域的新文本中证明的关键词的比例。

最后,有用性是理解和评估关键词质量的一个重要方面,但同时,它只是硬币的一面,另一面是相关性。在关键词分析中,相关性是指关键词相对于其对应的目标语料库及其所代表的语篇领域具有代表性和意义的程度。类似的论证可以在Egbert和Biber(2019)其中,他们强调相关性在评估关键词质量时的重要性,特别是内容词相对于功能词的重要性。

重要的是,在机器学习研究中,有用性和相关性可以被视为优化给定方法信息性的竞争策略(例如。,Blum和Langley,1997年;Kohavi和John,1997年;Guyon和Elisseeff,2003年). 原则上,一种方法可能非常有用,即显示出高辨别性能,同时显示出低相关性。例如,Ribeiro等人(2016)表明仅凭有用性无法判断一种方法的优点。他们训练了两个分类器,从广泛使用的20个新闻组数据集中区分两个文本类别——“基督教”和“无神论”(http://qwone.com/~jason/20新闻组/)一个基于原始未处理语料库,另一个基于预处理版本。在预处理版本中,删除了相关性低的元素。其中包括作者姓名和网页标题信息等。

在预处理的语料库上训练的分类器的性能为88.6%,而在未处理的语料上训练的模型的性能为94.0%。仅基于区分性能(即有用性),基于未处理数据训练的模型将被选为“最佳”。然而,性能更好的分类器基于与“基督教”和“无神论”类别无关的特征当分类器根据一个新的数据集进行评估时,这一点得到了证实,该数据集由相似的新闻组文本组成,但来自不同的站点。在这种情况下,辨别能力被逆转了——预处理模型的准确度达到69.0%,而根据原始未处理数据训练的模型的准确率为57.3%。这清楚地表明了我们评估方法背后的动机。模型的区分性能不能单独作为评估其优度的指标:必须考虑到泛化性和相关性。

到目前为止,我们已经制定了一个评估关键词质量的通用方法。然而,为了实现基于预测的关键性方法,需要一种机器学习算法。当前研究中提出的方法是灵活的,不限于特定的机器学习算法。有数百种算法可供选择,仅用于分类任务(Fernández-Delgado等人,2014年). 即使在以语言为导向的研究中,也有许多经典的机器学习算法,例如随机森林,它们往往能够很好地对表格数据进行建模(Fernández-Delgado等人,2014年). 它们还被用于建模语言数据,如方言变异(塔利亚蒙特和巴扬,2012年),阅读过程中的眼动(Matsuki等人,2016年)和语音变异(Arnhold和Kyröläinen,2017年). 在NLP中,深度学习神经网络,特别是基于变换器的体系结构,已有效地成为语言数据建模的标准方法(Devlin等人,2018年;Conneau等人,2020年).

然而,当围绕机器学习框架进行关键词分析时,不仅依赖于区分性能,而且还需要检查所实现体系结构的决策。虽然当代的机器学习算法可以提供出色的判别性能,但它们的使用面临的挑战之一是了解哪些变量以及它们如何影响判别性能(Samek等人,2017年). 事实上,为了解释给定模型的决策,已经提出了大量不同的方法(Montavon等人,2018年;Linardatos等人,2020年). 然而,这些方法往往侧重于解释单个数据点,而不是寄存器等类别(有关最近的概述,请参阅Rönnqvist等人,2022年).

在这种背景下,我们使用线性支持向量机(SVM)实现了所提出的方法(Vapnik和Vapnik1998年). SVM在许多不同的科学领域中得到了广泛的应用,从分类问题到回归问题都表现出了优异的性能(Schölkopf等人,2002年). 它们在文本分类方面也有着悠久的传统,因为由于第5.1节中数据的维数极高,这项任务往往会给机器学习算法带来困难,但是SVM可以独立于数据的维数进行学习(参见约阿希姆,1998年). 虽然SVM通常主要用于预测,但线性SVM也可以用于推理(请参见Guyon等人,2002年;Zhang等人,2006年;Richardson和Campbell,2007年;Sharoff等人,2010年;Wang等人,2019年).Laippala等人(2021年)使用线性SVM探索词汇和语法对英语文本变体建模的重要性。

在这里,我们继续这一调查路线,其中分析使用线性SVM。从方法学的角度来看,我们证明了用线性SVM获得的估计可以直接链接到特定的文本变体,从而在没有后处理的情况下提供精确的推断。第2节描述了当前研究中使用的数据。鉴于线性SVM的模型架构更简单(参见第3节),与其他机器学习算法相比,所提出的方法可能具有更低的识别性能。为了更好地定位实现的方法,我们还使用随机森林和深度语言模型BERT对数据进行建模,见第4节。第5节详细说明了数据预处理和模型拟合的步骤。为了巩固与传统关键词分析相关的结果,我们使用TDK分析了研究中使用的数据。第7节对关键词的有用性和相关性进行了评估。

2.数据

本研究中使用的数据摘自英语在线注册语料库(CORE)Biber和Egbert(2015).CORE是目前最大的英语在线文本集合(N个=48571),带有与文本种类相关的手动注释信息。CORE中的文本是基于大量的伪随机谷歌搜索收集的,目的是获取在线语言使用变化的代表性样本。重要的是,CORE并不局限于一组预定义的文本变体,而是试图涵盖在线发现的所有语言变体。注释方案是一种以数据驱动方式创建的层次分类法,由八个一般类别和33个子类别组成。每一文本都由四名注释人进行分类,以多数票决定特定文本的最终类别。中提供了注释过程和分类的详细讨论和描述Biber和Egbert(2015)和Biber和Egbert(2018)分别是。

一般来说,文本变体与特定的情景语境相关,并在语言使用中产生重要差异(比伯,2012年). 在本研究中,我们关注两种类型:新闻文章和个人博客,或者简称新闻和博客。使用这两种文本变体有很多好处。首先,这使我们能够直接将结果与传统关键字分析进行比较,即由Egbert和Biber(2019)并在第6节中进行了讨论。其次,以往的研究表明,这两种文本变体在情景和语言特征方面都有很好的定义。这确保了评估关键字的相关性变得更容易,因为它们可以相对于以前的研究进行锚定(例如。,Biber和Egbert,2016年,2018). 反过来,这允许对提议的方法进行更可靠的评估(Biber和Egbert,2018年;Laippala等人,2021年). 为了本研究的目的,我们编译了两个基于CORE的语料库。初级语料库较大,用于训练线性SVM和计算TDK。此外,该数据集允许我们评估提取关键字的有用性和相关性。二级语料库专门用来测试提取的关键词对新文本的泛化能力。下面我们分别描述这些语料库的组成。

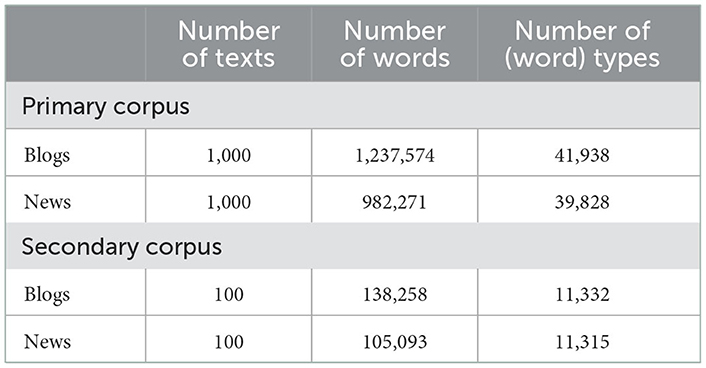

在初级语料库的情况下,我们随机抽取了每种类型的1000篇文本。基于我们先前在文本分类方面的经验,数据的大小足够大以提供稳定的估计(例如。,Laippala等人,2021年). 然而,在传统的关键词分析中,参考语料库通常由比目标语料库大得多的文本集合组成,我们平衡了这两种类型之间的文本数量。我们这样做是因为在分类任务中,分类类别之间的严重不平衡会影响模型性能,我们的目标是确保文本种类之间的分类性能可能存在的差异不归因于各自语料库的大小。在语料库语言学中,这种设置有时被称为跨语料库比较。本研究中使用的数据集的摘要信息见表1.

如第1.2节所述,我们从CORE中提取了另一个随机文本样本,以检查关键字的通用性。该二级语料库仅用于第7.3节中的预测。第二个样本包括总共200篇新文本,在新闻之间平均分配(n个=100)和博客(n个= 100). 该二级语料库的摘要信息见表1.

3.支持向量机

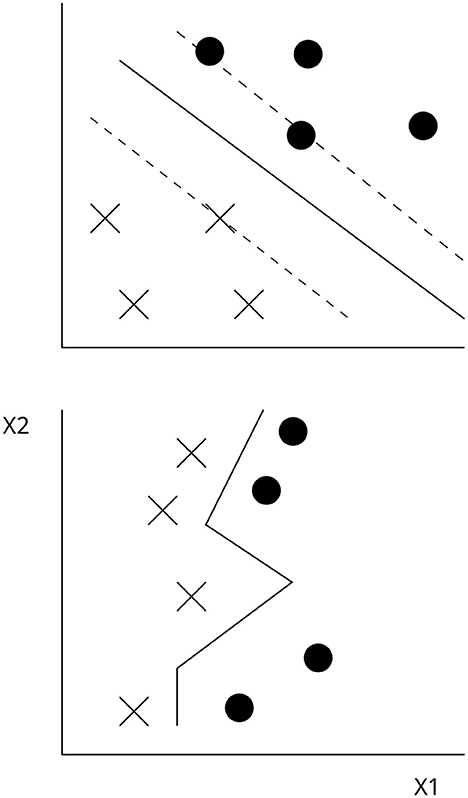

在本节中,我们概述了SVM在二进制分类中使用时的概念基础,特别是它们如何有助于关键字分析。支持向量机的学习机制基于寻找最优边界的基本思想,该边界通过最大距离将两个类别分开。这被称为最优超平面(2D中的线、3D中的平面和三维以上的超平面)。然而,在给定的数据集中,可能有几个不同的超平面可用于分离这两个类别。为了找到最优的超平面,SVM使用最接近超平面的两个类别的观测值。这些观察结果及其特征被称为支持向量,因为它们支持超平面,并被视为其相应类别的代表性示例(Vapnik和Vapnik1998年;Schölkopf等人,2002年).

该算法的目标是最大化两个类别之间的距离,这两个类别被称为给定数据的边界和最优超平面。支持向量机的概念基础如图1(上部),其中由点和十字组成的二进制响应变量被建模为两个预测因子(X1和X2)的函数。实线代表超平面,虚线对应最大边距。

在文本分类中,给定文本被表示为由特征-响应对组成的向量,其中每个单词对应一个特征,给定特征的值是其在给定文本中的频率,给定文本的文本变体是响应。详见第5节。为了学习特征和响应之间的映射,SVM将根据这些特征-响应对进行训练。从形式上讲,SVM需要解决以下优化问题(Boser和Guyon,1992年;Cortes和Vapnik,1995年):

功能如下x个我响应变量为年我∈{−1, +1}. 对于线性SVM,决策函数是以下内容的组合w个,b条和ξ我。我们在下面分别讨论了决策函数中使用的术语,因为它们对使用线性SVM构建精确推断具有重要影响。

SVM中的一个特殊术语是偏差(b条)通过将决策函数向下或向上移动,确保以最大裕度估计分离超平面。因此,偏差是标量,并计算为满足严格不等式的权重的平均值,这里对于给定的权重α,0<α<C类(Guyon等人,2002年). 决策函数中使用的第三项是ξ我也就是说,在非线性可分离数据的情况下,确保算法收敛的松弛变量(Schölkopf等人,2002年).

在公式中,术语C类是一个超参数,用于控制模型的分类精度和泛化性之间的权衡。过于紧跟数据的模型可能具有较高的准确性,但可能无法很好地推广到新数据。相反,灵活性较差的模型对训练数据的精确度可能较低,但对新数据的精确度较高。这个想法在图1(下)决策边界的摆动受C影响。重要的是,因为这是一个超参数,模型无法从数据中学习它。因此,它必须由建模者进行调整,其值取决于手头的数据。有关这方面的讨论,请参阅第5节。

在推理和建议的关键字分析方面,权重向量w个具有首要利益。在本研究中,权重向量的给定特征对应于建模中使用的单词。矢量中的大多数权重——特定文本中特征的频率——为零,只有非零权重才能影响SVM中的决策函数(Guyon等人,2002年). 重要的是,权重的方向(无论是正值还是负值)指示给定观测将位于超平面的哪一侧,从而确定这两个类别中的哪一个将成为该特定实例的模型预测。这使我们能够将给定的特征与当前研究中的特定文本变体相关联。

就本研究而言,SVM的最后一个重要方面涉及SVM学习的映射。该映射是根据模型训练中使用的观察结果学习的(x个我)函数。此函数称为内核函数。在线性函数的情况下,该核如下所示.

总之,我们对线性SVM进行了概述,并介绍了该算法如何学习特征和响应变量之间的映射。我们认为,线性SVM的这个概念基础可以导致关键字分析,其中给定的权重对应于关键字,其大小对应于关键性。在实证检验这个假设之前,我们转向使用SVM建模数据的实际方面。最后,由于我们只使用线性SVM,因此我们将其简单地称为SVM。

4.随机森林和深度语言模型

为了确定线性SVM的判别性能,我们还使用随机森林和深度语言模型BERT对数据进行了建模。由于本研究的主要重点是评估关键字的方法学方法,因此我们在本节中仅简要介绍这两种算法。

随机森林由布雷曼(2001a)和基于大量分类和回归树(CART)。它们是一种非参数方法,非常适合对与线性SVM相比的非线性数据进行建模。语言数据也是如此。虽然CART基于二进制分割递归地将数据划分为越来越同质的类别,但随机森林给这个过程带来了随机性。首先,给定的树是在随机数据样本上训练的。其次,在用于划分数据的给定分割中,只随机选择预先定义的潜在预测数。这是模型的主要超参数。与其他经典的机器学习算法相比,随机森林广泛应用于不同的科学研究领域,在对模型进行最小微调的情况下,往往会产生出色的结果(参见Fernández-Delgado等人,2014年).

BERT,来自变压器的双向编码器表示(Devlin等人,2018年)是遵循转换器架构的语言模型(Vaswani等人,2017年)并根据维基百科和书籍中的大量数据进行训练。该模型可以对下游NLP任务进行微调,例如文本分类,并且已经证明它在寄存器识别等方面取得了重要的改进和最先进的结果(Repo等人,2021年). 然而,这种性能优势确实伴随着计算时间和模型复杂性的增加而来。

最后,值得一提的是,与BERT不同,随机森林为估计相对变量重要性提供了一种内置机制。然而,这是一个全球性的衡量标准,它没有提供有关影响方向的信息。作为一个缺点,随机森林和BERT都需要实施一些后处理技术,以便得出对特定类别敏感的可变重要性度量。对于深度神经网络来说,这是一个特别复杂的问题(有关讨论,请参阅Rönnqvist等人,2022年). 因此,我们训练这些模型只是为了确定线性SVM的区分性能。

5.方法解决方案

在本节中,我们将讨论在数据预处理和模型拟合期间采取的方法解决方案。首先讨论数据的选定表示,因为它涉及分析的基本基础。本节的第二部分介绍了已实现SVM的建模过程。在当前的研究中,Scikit learn(版本0.21.1)与Python3一起使用。在R版本4.1.1中进行了统计分析和数据可视化(R核心团队,2021年).

5.1. 数据预处理

原则上,关键字分析可以基于文本中证明的任何单位。事实上,在之前的研究中,已经对一些不同的单位进行了研究,包括单词、词缀、,n个-将克和部分语言信息转换为更大的词汇语法模式(请参阅加布里埃拉托斯,2018供讨论和引用)。

在本研究中,我们只关注单词的贡献,特别是bagof-words(BOW)表示,其中每个不同的单词都被视为一个特征。做出这一决定有两个原因。第一,Laippala等人(2021年)比较了从单词和语法特征到字符的七种不同特征集n个-grams表明,尽管语法信息和词汇信息的组合在文本变体之间提供了最佳的区分性能,但仅单词级信息就具有很强的竞争力。其次,传统的关键词分析主要关注单词级的BOW信息。这使得将结果与之前关于文本特征的关键字研究进行比较更加容易。为了排除语言上无意义的特征并降低BOW表示的维度,我们删除了数字和标点符号,并将字母规范化为小写。生成的BOW由1935316个单词(54693种类型)组成,用于训练SVM。

虽然单词级特征的值通常与频率相对应,即给定单词在特定文本或语料库中出现的次数,但它对不同的量化是开放的。因为Egbert和Biber(2019)最近提出了以不同方式量化频率的优点(参见格里斯,2008年为了进行全面总结),我们还考虑调整绝对词频,但在我们的示例中使用了术语频率-反向文档频率(tf-idf)加权。Tf-idf广泛应用于自然语言处理和信息检索(斯波克,1972年). 在这里,当一个单词在少量文本中频繁出现时,该值增加;当一个词在大量文本中出现时,其值减少。因此,这种调整后的频率对可能在数据集中区分文本的单词更加重要。为了比较频率加权的有用性,我们使用Scikit学习中可用的矢量器创建了两个不同版本的数据:CountVectorizer用于获取绝对单词频率,TfidfVectorize用于获取tf-idf-weighted单词频率。最后,两个BOW都进行了L2标准化。

执行最后的预处理步骤,以检查提取的关键词中内容和虚词的分布。最近,这个问题被提出Egbert和Biber(2019)在他们对传统关键词方法的比较研究中(见第1节)。这使我们可以检查特定关键字方法对文本特征差异而不是对aboutness差异的敏感程度。为了检查内容词和功能词在关键词中的比例,我们使用Turku Neural Parser分析数据(Kanerva等人,2018年),此处遵循通用依赖关系架构(Nivre等人,2016年). 解析后的输出用于确定第7.4节中使用的关键字的半言(POS)类。

与特定单词相关联的POS可能因英语上下文而异。因此,分析基于与给定单词相关联的主要POS(最常见的标记),这类似于Brysbaert等人(2012年)根据POS信息,我们形成了由广告词、连词、代词和助词组成的词类虚词。最后,名词、动词和形容词被保留为自己的词类,其余的POS被合并为一个标记为other的类别。

5.2. 模型拟合与评估

为了用SVM对数据进行建模以提取关键词,将预处理的BOW数据分为训练集(80%)和测试集(20%)。除了产生极高维的空间外,BOW还生成了一种极为稀疏的表示,因为大多数单词并不出现在每个文本中。因此,在这些情况下,它们的频率为零。为了减少这种稀疏性,删除了训练数据中分散度小于5%的所有单词。虽然这是一个任意的选择,并且应用截止点会影响关键字(Egbert和Biber,2019年;Pojanapunya和Watson Todd,2021年),我们在第7.1节中证明,即使当前5%的截止点也会生成高度不稳定的关键字。

模型拟合过程是用带有线性核的SVC包实现的。在训练SVM之前,超参数C类必须对线性内核的性能进行调整,因为它会显著影响性能。对于绝对频率数据和加权频率数据C类两种模型的结果均为0.1通过在0.001和10范围内进行网格搜索。相同的值C类在重采样过程中使用。

然后,按照以下方式执行模型拟合程序:(a)SVM分别根据绝对频率BOW和加权频率BOW的训练数据,使用最佳值C类(b)SVM的判别性能在测试数据上用三个指标进行评估:精确度、召回率和F1分数(精确度和召回率的调和平均值)。(c) 从模型中提取了前1000个正负权重。(d) 数据被随机重采样到训练(80%)和测试(20%)集。模型拟合过程从一开始就开始了,该过程重复了1000次。

重新采样使我们能够直接量化模型和提取的关键字对于数据中微小变化的稳定性。此外,Laippala等人(2021)已经表明,提取1000个权重在实践中就足够了,因为此过程已经产生了大量倾向于不稳定的关键字(有关类似结果,请参见第7.1节)。我们将此度量称为选择频率。虽然关键字分析通常仅基于排名靠前的关键字的子集,但这些关键字通常仅限于排名靠前100的关键字(请参阅Pojanapunya和Todd,2018年,对于之前的研究进行综合分析),使用1000个正负权重提供了更多的关键字。这使我们能够评估关键字的稳定性。较低的选择频率意味着关键字仅取决于数据的某些部分,例如数据的主题或特性。另一方面,较高的选择频率表明关键词代表了其相应文本多样性的稳定特征,并且可以推广到整个语料库。

以下过程用于使用随机森林和BERT调整超参数。对于BERT,我们使用Huggingface库(PyTorch版本)中批量大小为8的大版本BERT,并从0.00001到0.01进行网格搜索,以优化学习率。对于随机森林,我们在Scikit学习中使用了RandomForestClassifierPedregosa等人(2011年),优化网格在500到2000之间的树的数量。

6.文本分散键

为了评估使用SVM提取的关键字,我们使用最近引入的TDK作为比较点。该方法在Egbert和Biber(2019)最近还讨论了格里斯(2021)这一测量基于文本离散度,通过比较类型频率,即一个单词在目标语料库和参考语料库中出现的文本数量。虽然TDK基于观察到的类型频率(哦),关键性得分基于对数似然比(LLR)(参见邓宁,1993年). 因此,预期频率按以下方式计算:

LLR计算如下:

由于该方法代表了传统的关键词分析方法,即计算目标语料库相对于参考语料库的关键性,因此我们分别计算了新闻和博客的LLR分数,改变了它们作为参考语料体和目标语料体的角色。这样就可以直接比较TDK和SVM的结果。同时,应该注意的是,在传统的关键词分析中,参考语料库往往比目标语料库大得多(有关参考语料影响的最新讨论,请参阅Pojanapunya和Watson Todd,2021年). 例如,Biber和Egbert(2018)提出了一种关键词分析方法,其中参考语料库由CORE中证明的所有文本变体组成,但用作目标语料库的文本变体除外。这使得他们的研究设计与我们的二进制设置略有不同,也会影响估计的关键字。然而,我们希望使用TDK提取关键字的设置尽可能与SVM相似,以比较结果。

7.结果

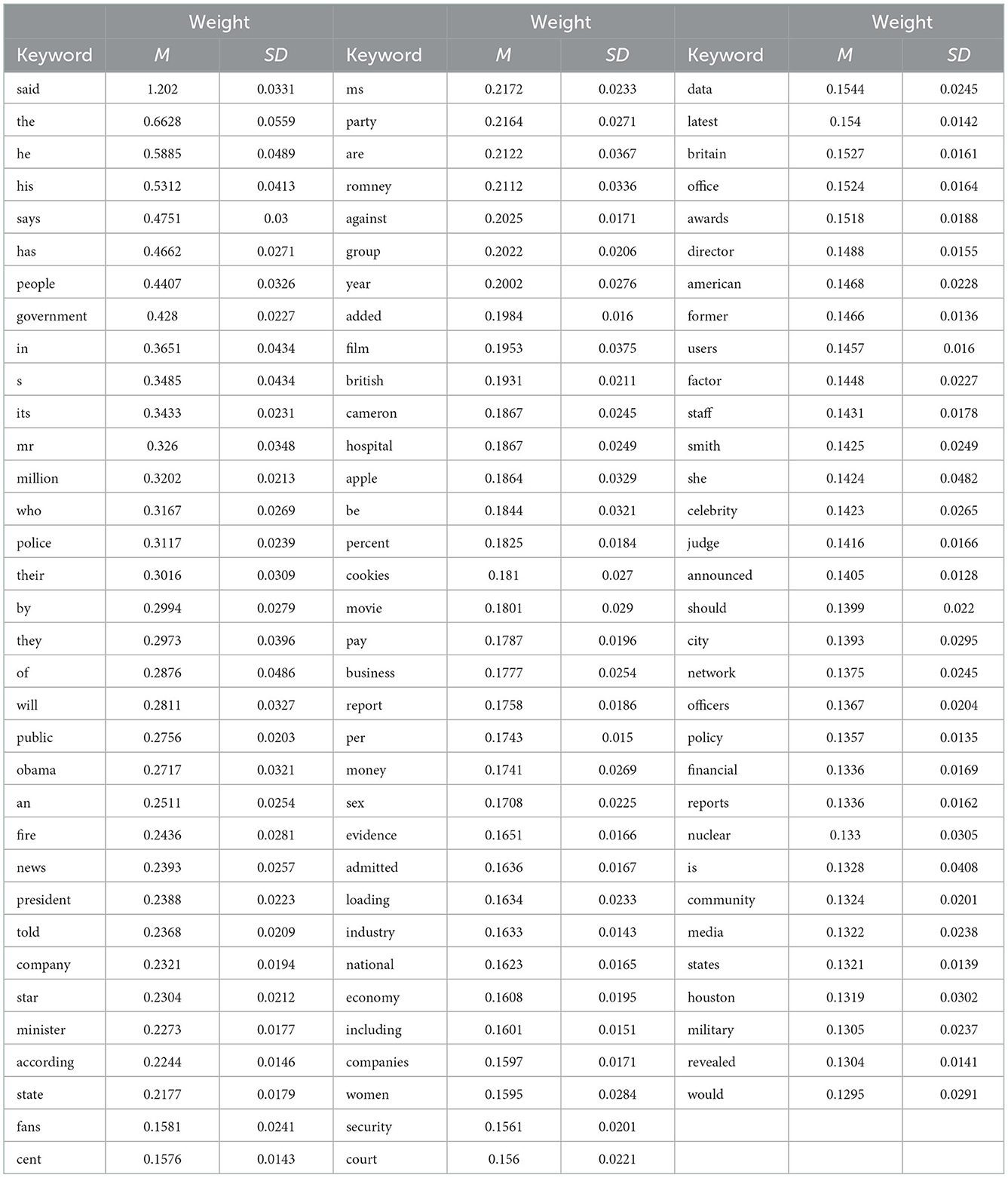

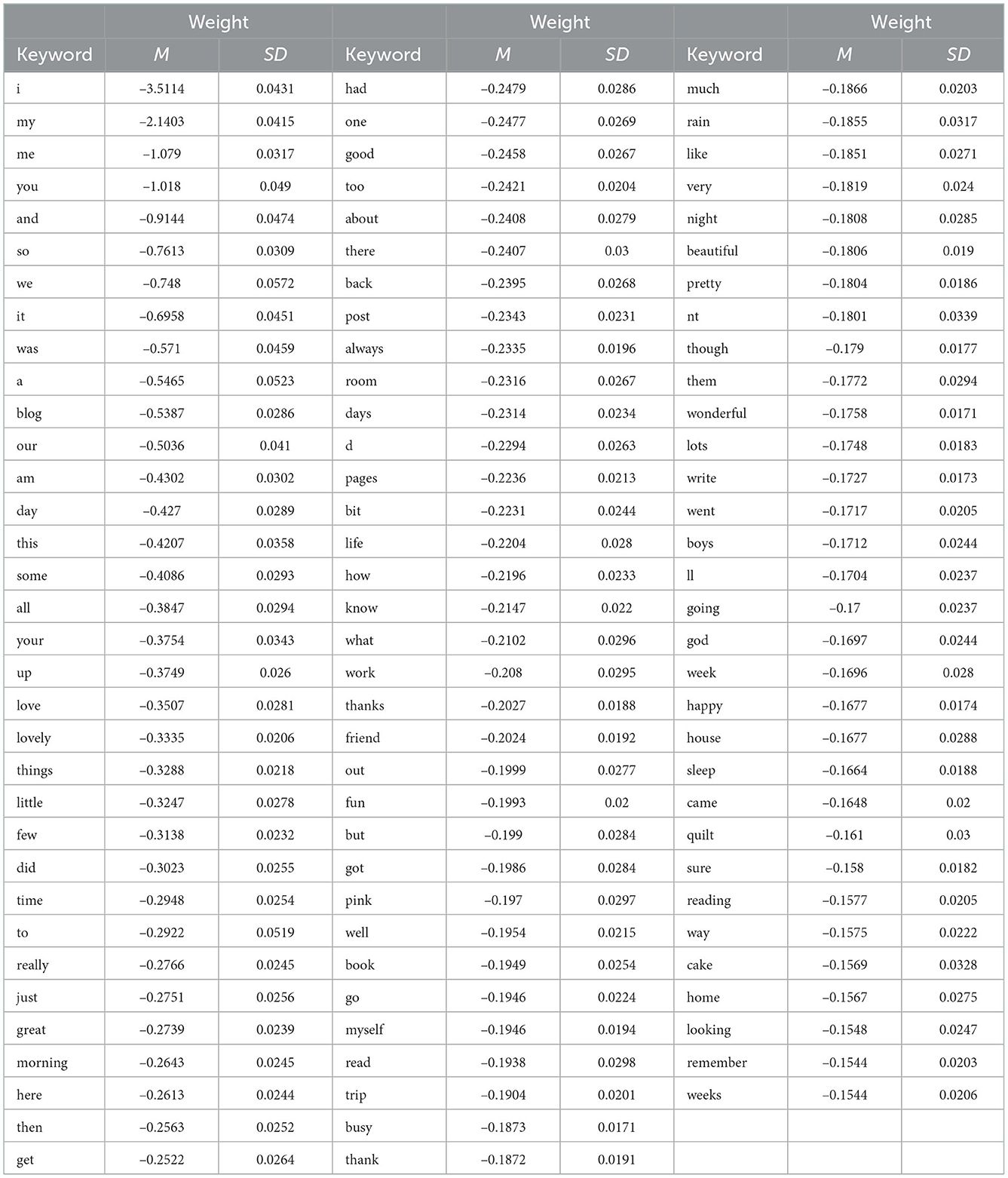

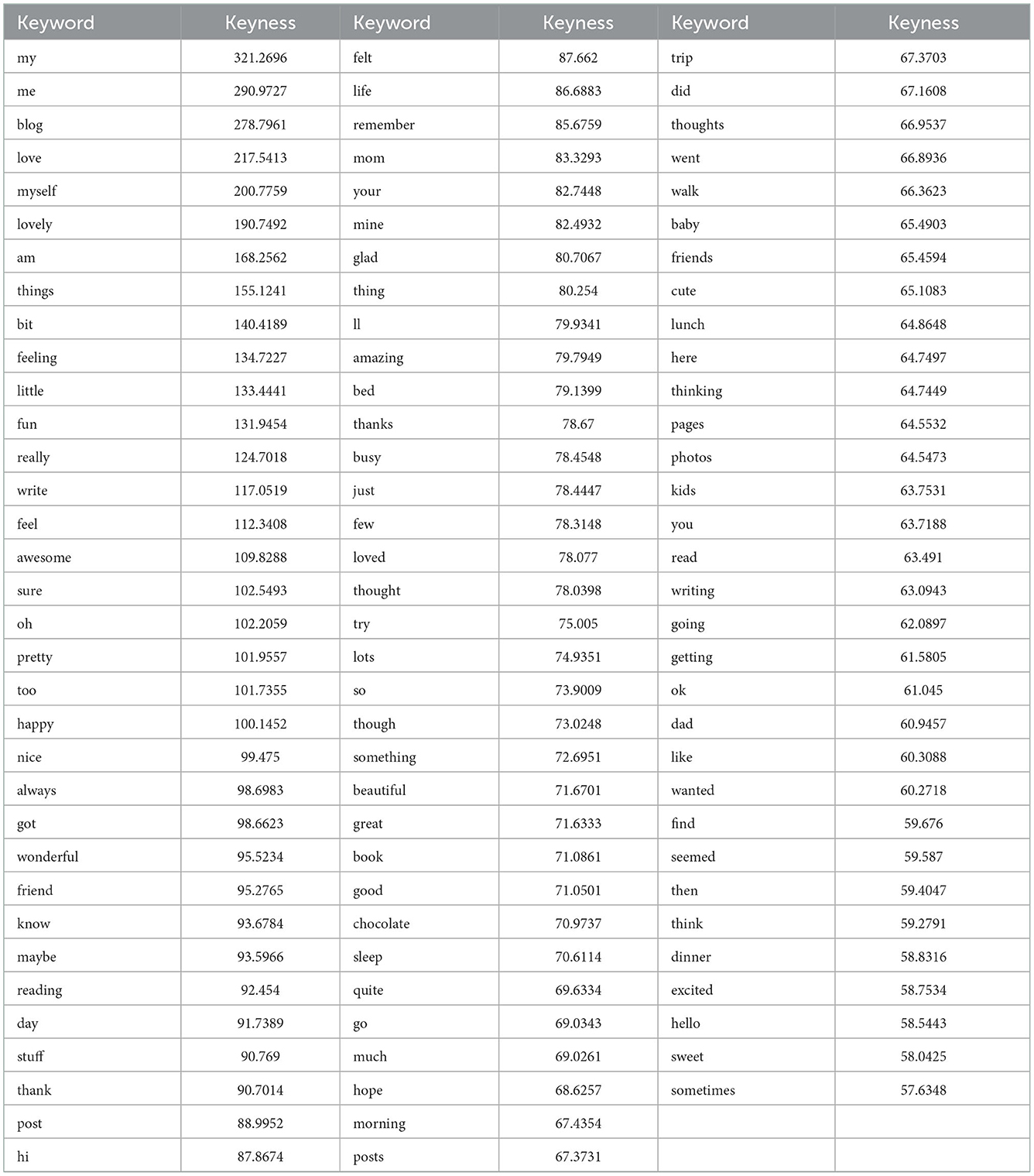

通过实现的重采样过程,使用SVM(tf-idf)估计了总共4524个关键字。其中,2243个与新闻相关,2281个与博客相关。为了说明关键字及其估计权重,新闻的前100个关键字如下所示表2和中的博客表3可以看出,关键字似乎是出于语言动机。

为了使用TDK生成关键词列表,以前的研究使用了LLR量表上的不同截止值来调整提取的关键词数量,例如,LLR分数3.84对应显著性水平0.05或6.63对应显著性级别0.01(参见Stubbs and Tribble,2006年). 本研究采用了不同的方法,因为分析的目的之一是评估估计关键词的稳定性。为此,我们需要更多的关键字。因此,使用了五的切点。通常,关键字分析的结果基于前100个关键字。在这种情况下,应用截止点不会影响排名靠前的关键字的选择,但自然会影响提取的关键字总数。TDK共提取了2134个博客关键词和1906个新闻关键词。

为了呈现关键词,只有排名前100位的关键词及其关键性得分被提供给中的博客表4以及中的新闻表5。关键字的完整列表作为单独的文件提供,可在以下网址公开获取:https://osf.io/mxrt5/?view_only=3f4ceb05dc81413aaf1ff6c0d4b71aab.

7.1. 用途:可辨别性和稳定性

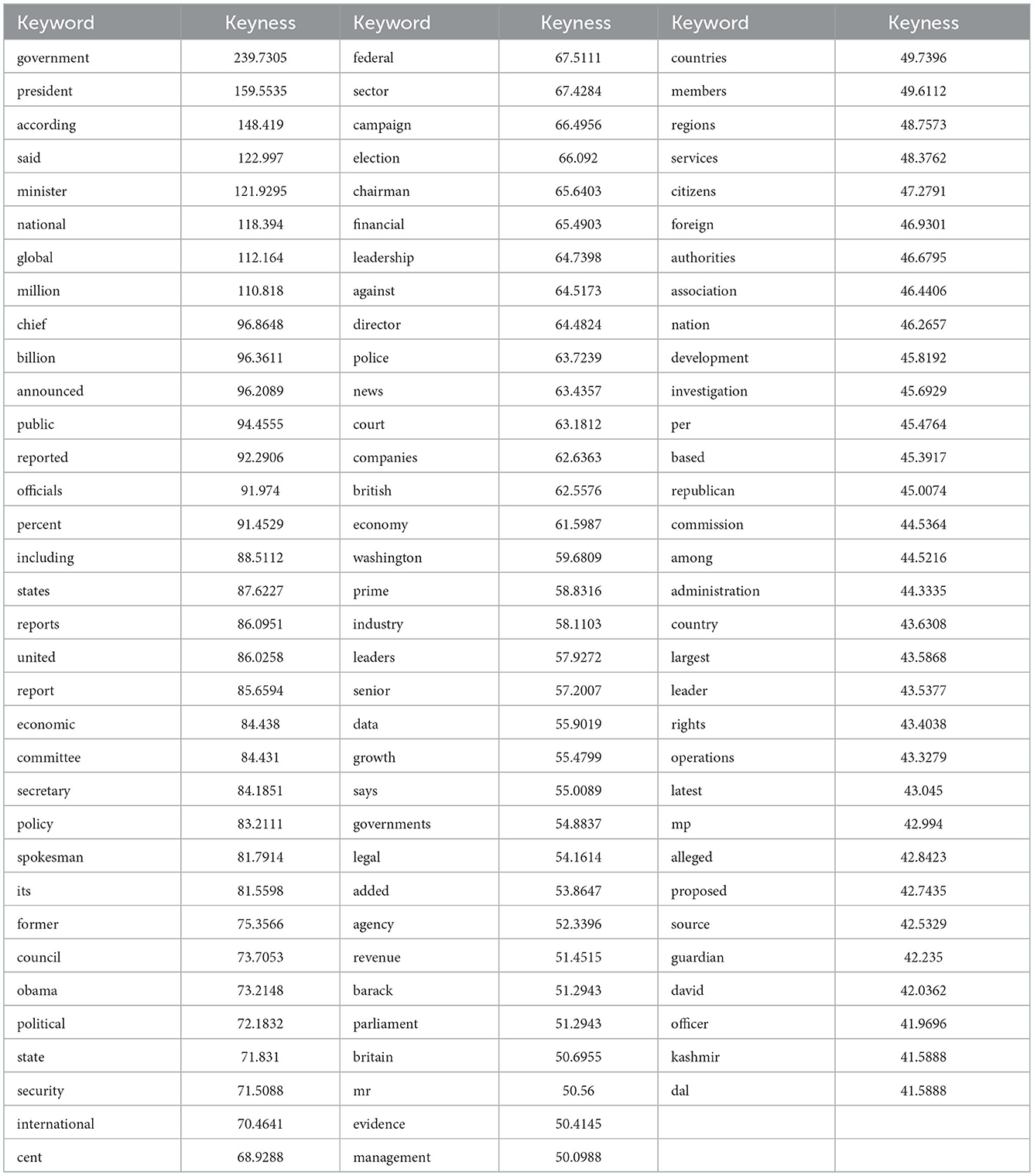

可辨别性指的是数据表示(关键字)在区分类方面的有用程度,稳定性指的是表示的稳定性,因此,关键字针对1000轮重采样所引入的数据中的微小变化。作为数据表示,我们比较了我们在第5.1节中介绍的两个BOW设置,一个使用绝对词频,另一个使用tf-idf加权的词频。我们评估了两种BOW表示中哪一种更适合数据,因此,在区分博客和新闻方面更有用。两个安装的SVM的模型性能如所示表6虽然两种模型在区分博客和新闻方面的差异不大,但f1得分的差异仍具有统计学意义:博客:t吨(−14.938)= 1984.8,第页<0.0001,新闻:t吨(1959.1)= −18.89,第页<0.0001,总平均数:t吨(1, 974)= −16.92,第页< 0.0001. 因此,结果表明,基于加权词频训练的支持向量机能够更好地区分两种文本类型。这是第一个支持加权词频SVM可以导出比绝对词频更有用的关键词集的证据。

然而,数据表示对模型性能的影响只是可区分性的一个方面。另一个方面是表示和估计关键字的稳定性。为此,我们转向选择频率,即在重采样过程中估计的前1000个正负权重中,给定权重及其对应单词被包括的次数。选择频率的增加表明,给定的关键词更频繁地被包括在这些最高权重中,因此,在数据发生微小变化时更稳定。

有趣的是,根据绝对频率训练的SVM产生了更多排名靠前的权重(w个=5030)与加权词频SVM相比(w个= 4,524). 仅这一差异就表明,加权词频SVM能够估计出更多有用的关键词——它们在数据变化中保持更稳定,因此是文本多样性稳健特征的更有用指标。稳定性方面,平均选择频率为397.61(标准偏差=337.88,范围:1–1000),对于绝对频率SVM和442.09(标准偏差=391.5,范围:1–1000)。差异也具有统计学意义:t吨(8985.9)= 5.9125,第页< 0.0001. 结果表明,加权词频SVM不仅估计的权重较少,而且这些相同的权重也更稳定。

重要的是,绝对词频和加权词频之间的稳定性差异不仅限于整组关键字,而且当关键字集限于前100个权重时,差异在统计学上也很显著。这是相关的,因为关键字分析通常仅限于前100个关键字。当考虑这部分分布时,加权词频SVM的平均选择频率为999.1(标准偏差=4.54)和920.6(标准偏差=15125)。这种差异在统计学上也很显著:t吨(99.18)= −5.19,第页< 0.0001. 因此,对使用SVM提取的关键词的有用性的评估表明,加权词频不仅提供了更好的区分性,而且还提供了估计权重的更高稳定性,从而产生了更稳定的关键词。

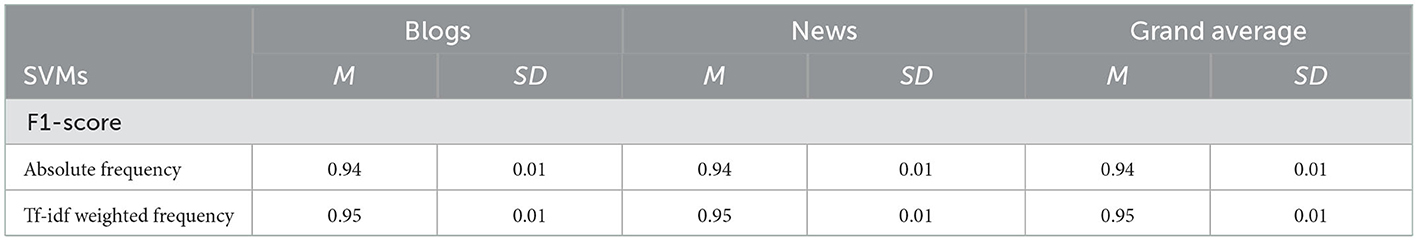

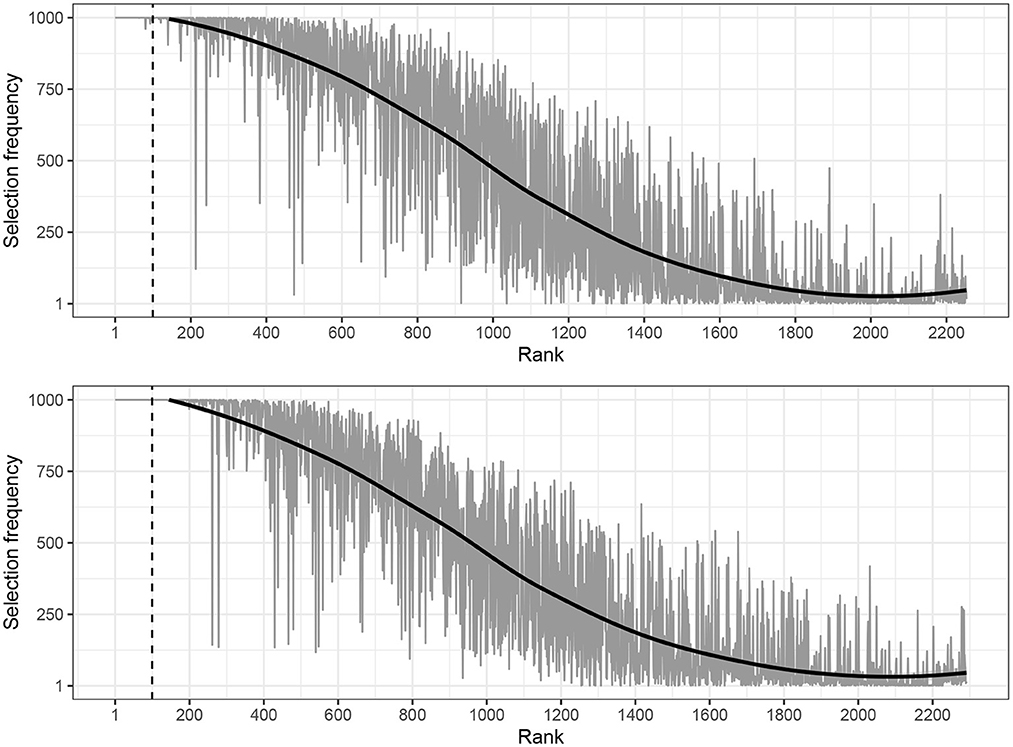

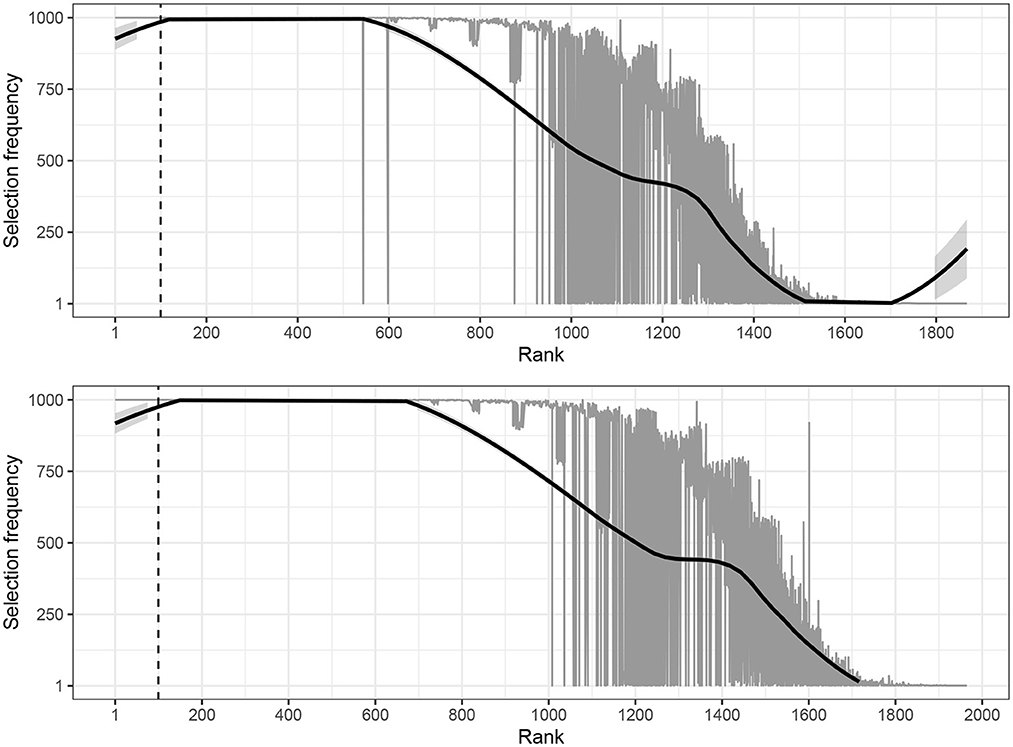

tf-idf模型生成的所有关键字的选择频率分布如所示图2其中,估计权重按秩顺序位于x轴上,选择频率位于y轴上。对于这些数据,平均选择频率为445.96(标准偏差=445.96)用于新闻,438.28用于博客(标准偏差= 438.28). 正如所料,文本变体之间的差异在统计上并不显著。对于这两个文本类,我们可以看到前100个关键字的选择频率几乎完美,这表明它们在数据变化中非常稳定。在100个排名靠前的关键词之后,稳定性开始下降。这也促使了在随后的分析中使用前100个关键字。

简而言之,我们提供的证据表明,加权BOW表示不仅在区分两种文本类型方面提供了一个小但明显更好的性能,而且还伴随着估计权重以及关键字的显著更好的稳定性。这些结果对于提供关键字有用性的定量评估很重要。此外,考虑到加权词频表示被评估为更有用,我们将在随后的分析中仅使用此格式报告结果。在下一节中,我们将进一步验证估计的权重是否是对注释记号的正确估计。

据我们所知,提取的关键字的稳定性尚未用传统的关键字方法进行评估。结果清楚地表明,SVM在选择频率和秩之间产生了一个平滑的函数形式,这与高性能鉴别算法的预期一致。原则上,抽样过程可以使用传统的关键字方法来实现,但需要注意的是,没有明显的方法来确定给定的抽样大小是过大还是过小。我们基于覆盖80%原始数据的随机样本,重复了使用TDK提取关键词的过程1000次。结果显示在中图3.

由于提取的关键字未针对样本大小进行优化,因此这些结果可视为暂定结果。尽管如此,与SVM(tf-idf)相比,TDK的选择频率和等级之间的函数形式显示出根本不同的形状。具体来说,分布的尾部与TDK的不稳定性表现出更强的亲和力。然而,新闻的平均选择频率之间的差异(M(M)= 401.12,标准偏差=406.88)和博客(M(M)= 428.61,标准偏差=411.49)与SVM(tf-idf)相比,无统计学意义。

与可辨性有关的最后一个问题涉及我们对模型体系结构的选择及其对可辨性的潜在影响,即与更复杂的模型(特别是随机森林和BERT)相比,使用更简单的线性SVM时,辨别力的潜在损失是什么。编码模式的选择不会影响随机森林的性能:平均f1核为0.92(标准偏差=0.01),绝对频率和平均f1-score为0.92(标准偏差=0.01),tf-idf加权频率。这是意料之中的,因为连续变量是基于等级而非观察值建模的。对于这些数据,随机森林的f1-score(总平均值)低于具有tf-idf权重的SVM,并且差异具有统计学意义:t吨(1875.3)= −59.57,第页< 0.0001. 正如预期的那样,BERT提供了更好的区分能力(M(M)= 0.97,标准偏差=0.01)。差异也具有统计学意义:t吨(9.3255)= −17.59,第页< 0.0001. 简言之,这些结果表明,线性SVM的使用以简单的架构提供了高性能,用于提取关键词,而不需要对数据进行任何后处理。

7.2. 用途:独特性和关键性

在这一节中,我们从显著性的角度来检验关键词的有用性,即关键词在多大程度上反映了与其在目标语料库中表示的相应文本多样性相关的语言使用。如果关键字是独特的,那么它们的分布属性应该反映出与特定文本变体相关的语言使用。作为第一步,我们检查了两种文本类型的关键字之间的重叠。这可以被认为是将估计权重视为基调指数的先决条件。关键字列表之间的重叠表明区别性较弱,因为该方法很难反映相应文本变体的语言使用。SVM能够为这两种文本类型估计完全不同的关键字,因为它们之间没有共享任何关键字。同时,值得指出的是,这种区别也适用于使用TDK估计的关键字。简言之,这表明权重的方向为两种文本类型建立了索引,并且可以将估计的权重视为关键字分析的有效候选。

在传统的关键词分析中,关键性本身的质量很重要,因为它用于对关键词进行排序;也就是说,关键字的排名还应该反映其相应文本种类所代表的语言使用(Gabrielatos和Marchi,2011年). 因此,基于键性的给定关键字列表的排名顺序预期与其对应的文本种类相关。从这个角度来看,如果关键字因其关键性而相互分离,则可以认为关键字是独特的。

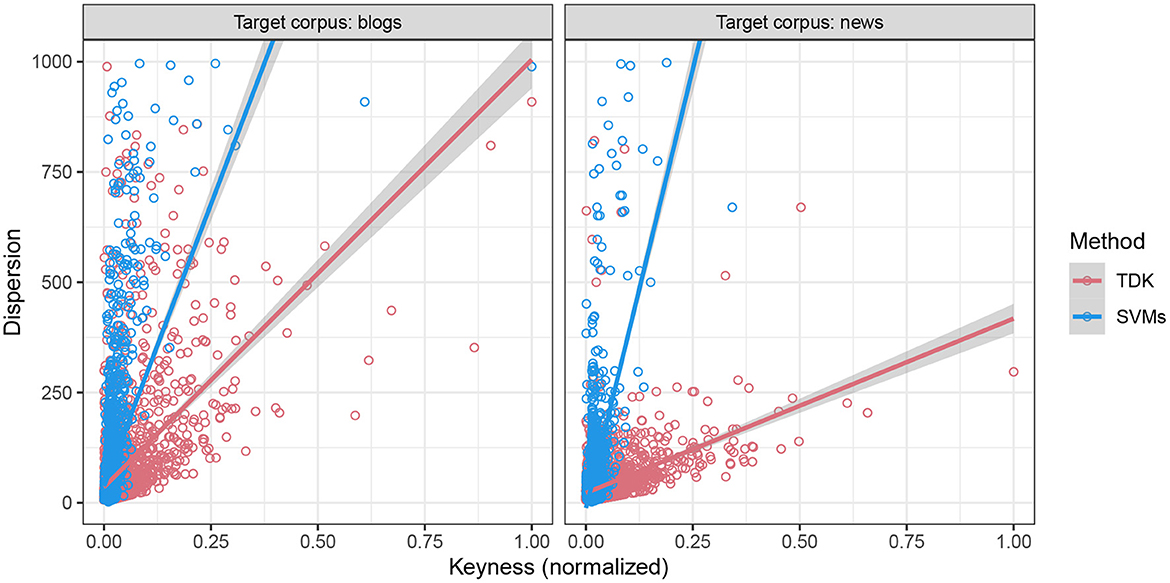

为了加深我们对作为关键性度量的估计权重的属性的理解,我们进一步分析了SVM估计权重与使用TDK估计LLR分数之间的离散度差异。此外,由于TDK是专门设计用来对其敏感的,因此我们重点关注分散性(有关分析,请参阅Egbert和Biber,2019年). 对于使用SVM或TDK估计的每个关键字,我们计算了相应的文本分散度。分散量化了特定文本种类(新闻)中给定关键字在文本中的出现次数=M(M)= 58.78,标准偏差= 95.63; 博客:M(M): 81.88,标准偏差= 140.48). 每个文本种类有1000个文本,理论上最大离散度为1000。然而,这一分析有一个复杂的因素,因为这些分数在很大程度上不同。因此,我们使用了线性归一化,其中关键性得分在分析之前归一化为0到1之间的范围。此外,在SVM的情况下,估计权重的绝对值用于归一化,因为它们的方向仅指示估计的文本变化,如博客或新闻。

在分析中,我们侧重于比较不同方法之间的差异,这里基于目标语料库,因为这是比较不同方法时进行分析的关键部分。数据在中可视化图4.

为了正式测试这两个关键性度量和离散度之间的关系差异,我们对数据拟合了一个线性回归模型,其中离散度被建模为三方交互的函数:(标准化)关键性、文本多样性(博客或新闻)和方法(SVM或TDK)。这使我们能够避免对数据进行单独的子集分析,因为这会降低功耗并扩大误差。线性回归模型的结果表明,基于ANOVA的数据完全支持三元交互作用[F类(1, 8556)= 155.04,第页<0.001],提供了证据表明两个凯恩斯主义得分在其独特性方面存在差异。为了更好地理解这种分歧,我们进行了事后的,事后的线性趋势分析第页-使用Tukey方法针对多次比较调整的值(Tukey,1994年),如在R包emmeans版本1.6.3中实现的(Searle等人,1980年).

趋势分析检验了当语料库和文本多样性重合时,关键性和离散性之间关系的强度。这种类型的分析对于显示关键性得分在多大程度上反映了他们各自文本多样性的语言使用是很重要的。在博客(左面板)的情况下,SVM显示出更强的分散敏感性(估计值=2558,东南方=65.4)比LLR得分(估计值=969,东南方=29.6),并且他们的差异(LLR得分−估计体重)也具有统计学意义[估计值=−1,589,t吨(8, 556)= −22.11,第页< 0.001]. 新闻中也出现了类似的模式(右面板),SVM的趋势是3986(东南方=140.3)和395(东南方=31.8)对于TDK。重要的是,他们的差异(LLR得分−估计体重)也具有统计学意义[估计值=−3,591,t吨(8, 556)= −24.96,第页< 0.001]. 即使从数据中删除了离群值,即基于方差分析的绝对残值>2.5标准偏差的数据点,这种交互作用仍具有统计意义[F类(1, 8271)= 439.34,第页< 0.001].

总之,我们在本节中提供了证据,证明了使用SVM估计的关键字具有高度的独特性。首先,SVM可以生成一个彼此不同的关键字列表,类似于传统关键字分析生成的那些列表,即TDK。其次,SVM的估计权重可以作为关键性的度量,而分数本身反映了相应文本变体的分布特性。有趣的是,估计重量与离散度密切相关。总的来说,估计权重的这些属性表明了显著性。通过这种方式,我们证明了估计的权重不仅有助于区分文本变体(见第7.1节),而且有助于描述与文本变体相关的语言使用特征。因此,与TDK相比,它们能够提取出语言使用的更具特色的方面。

7.3. 有用性:对新文本的概括

概括性是与关键词分析相关的核心问题之一。关键词不仅适用于描述最初用于估计它们的目标语料库的特征,而且适用于相同话语域的新文本的特征吗?在下面概述的两个步骤中,对模型性能和关键字本身进行了评估。

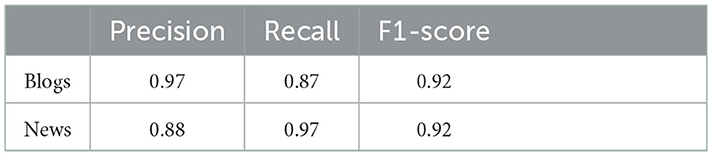

首先,我们开始评估SVM在预测新文档的文本多样性方面的分类性能。因为我们使用的是机器学习,所以拟合的SVM可以用来预测新文档的文本变化。相反,传统的关键字分析不能基于分类性能进行评估,因为每个文档都具有同等的地位。TDK专门设计用于考虑文件的潜在贡献。SVM的使用使我们能够进一步评估分类性能。如果使用不同的机器学习算法来估计密钥,这是一个需要考虑的重要指标。尽管SVM获得了很高的分类性能,表明所学习的映射在博客和新闻之间有很大的区别,但它不一定能翻译成新的文本。为了测试这一点,我们从CORE(二级语料库)中总共抽取了200篇新文本。这些文档以前没有用于SVM的训练或测试。文本在新闻之间平分(n个=100)和博客(n个= 100). 使用第5.2节中描述的管道对它们进行预处理后,使用SVM预测给定文档的文本变化。模型性能总结如下表7.

正如预期的那样,SVM的分类性能略低于表6但结果表明,SVM非常适合新文本,表明该模型根本没有超出原始数据。这进一步证明了SVM学习的映射有助于区分文本变体的特征。

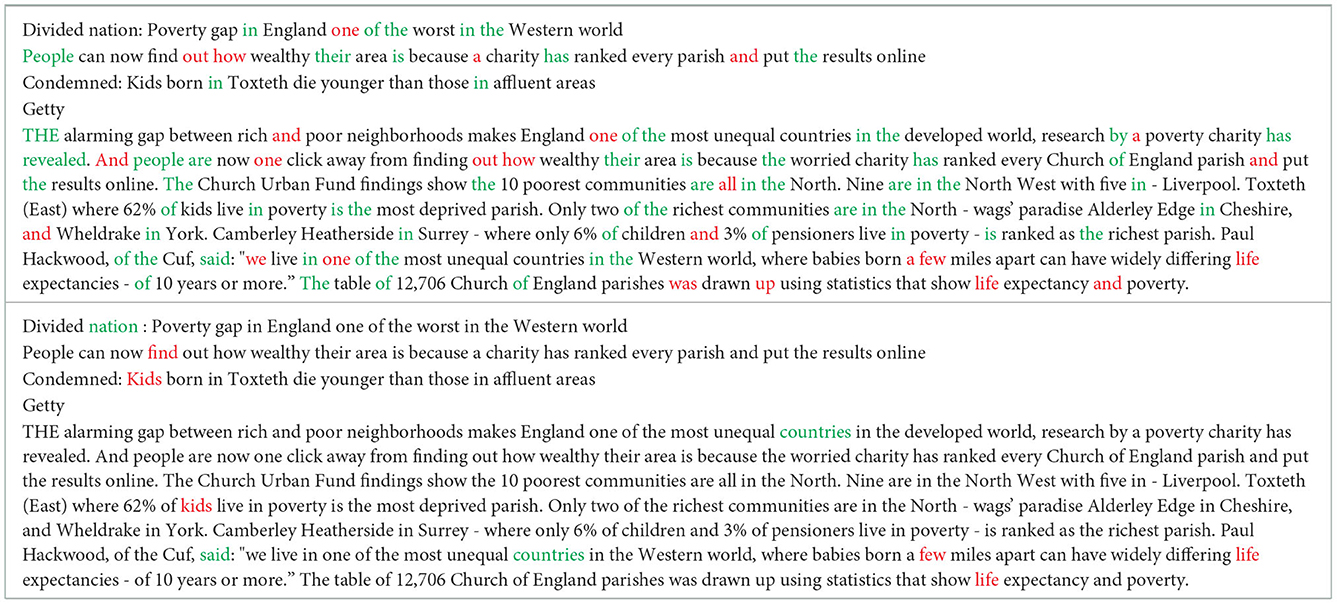

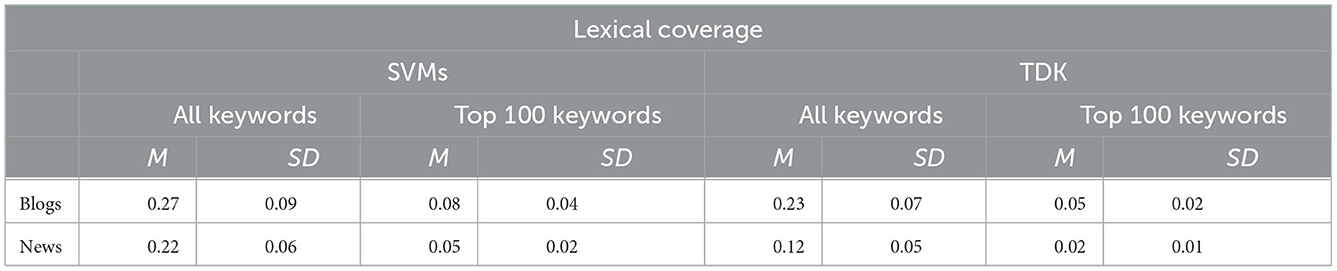

其次,我们开始检查提取的关键字。具体来说,我们关注词汇覆盖率,即关键词在新文本中的使用程度。重要的是,该指标也适用于评价传统的关键词分析方法。

关键字的存在如所示表8用于SVM(上部)和TDK(下部)。这篇文章是一篇关于英国贫困差距的新闻报道。作为一篇典型的新闻文章,文本中包含了经常使用过去式的频繁转述动词,例如说,完美方面,例如已透露和介词短语,例如在北方(请参见Biber和Egbert,2018年;比伯和康拉德,2019年更多信息)。

为了从数字上评估看不见文本中关键词的词汇覆盖率,我们将其计算为一个比例,即给定文本中证明的关键词数量除以该文本的总单词数量。此外,作为计算的一部分,我们只包括那些正确预测的文本(92%的数据)因为分类错误的文本不能用来评估关键词的质量,因为我们确信模型的学习映射不足以区分与这些文本相关的文本类型。尽管TDK没有提供文本种类之间的区别信息,但使用了相同的文本集来保持比较设置不变。基于词汇覆盖率的分布结果如下所示表9并按文本多样性和关键词数量进行细分(全部与前100名相比)。

我们聚焦于全套关键词,并使用线性回归评估了两种方法之间的差异,其中词汇覆盖率被建模为方法(SVM和TDK)与文本多样性(博客和新闻)之间交互作用的函数。相互作用具有统计学意义[F类(1, 362)= 16.19,第页<0.001]包含全套关键字,但不包含前100个关键字[F类(1, 362)= 0.32,第页= 0.57]. 在后一种情况下,只有一些对比具有统计学意义,我们在下文讨论时指出了这一点。重要的是,a事后的,事后的基于全套关键词的对比结果表明,经过多次比较调整后,两种方法在文本变体的平均词汇覆盖率上的差异具有统计学意义(结果未显示)。因此,一般来说,SVM估计的关键词在新闻文本中的词汇覆盖率高于TDK。有趣的是,TDK显示所有关键词和新闻前100个关键词之间的词汇覆盖率急剧下降,此处估计差异为-0.10[t吨(362)= −10.43,第页< 0.001]. 对于排名前100的关键词,这种差异在统计上也很显著[估计= −0.03,t吨(362)= −8.08,第页< 0.001]. 因此,无论提取关键词的截止点是什么,SVM都为新闻文本提供了更强大的可推广性。例如,只有12%的TDK关键词或2%的前100个关键词在新闻文本中得到了证实。这是一个低词汇覆盖率,尤其是与这些文本中证明的平均单词类型数相比(M(M)= 803.74,标准偏差= 1523.61).

简而言之,我们提供了证据表明,使用SVM估计的关键字的泛化性不仅限于训练中使用的文本的特征描述,而且还扩展到了不属于训练和评估所用原始语料库的新文本。此外,我们还引入了一种称为词汇覆盖率的度量方法,以评估新闻文本中估计关键字的概括性。这个度量很容易计算,而且很有希望,因为它能够区分不同的关键字集和方法。

7.4. 相关性和关键词

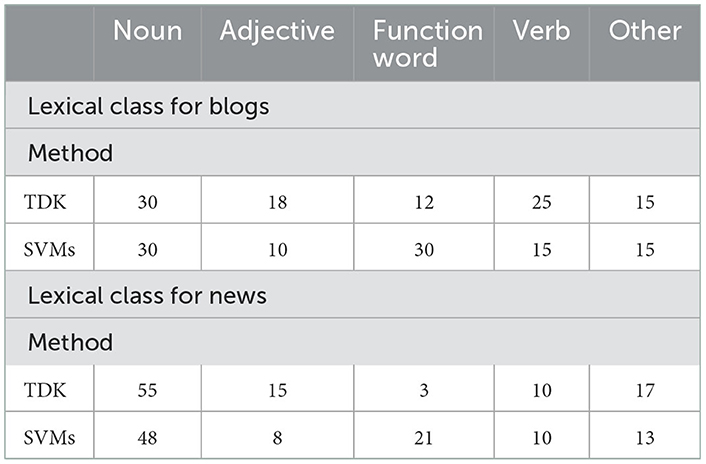

在前面的部分中,我们已经演示了使用SVM提取的关键字是有用的,它们允许我们区分新闻和博客,并引用这些文本变体的稳定和可概括的特征。然而,这些关键词的有用性并不一定意味着这些关键词将与描述新闻和博客文本作为其各自文本种类的实例高度相关。因此,在本节中,我们将重点检查提取的关键字与SVM的相关性,并将其与TDK进行比较。此外,为了进一步分析关键词在多大程度上反映了aboutness和其他文本特征,我们比较了提取的关键词的词汇类别。该分析还提供了有关上一节中讨论的TDK关键字的泛化程度较低的更多信息。与之前对关键词分析的研究类似,我们将重点放在与每个文本变体相关的100个顶级关键词上,因为该分析依赖于SVM和TDK之间的定性(差异)相似性(参见Pojanapunya和Todd,2018年;Egbert和Biber,2019年以及其中的引文)。

7.4.1. 博客和新闻的关键词和特点

以往的研究将个人博客描述为个人叙事,频繁表达与参与和互动的话语元素以及温和的过去取向有关(Titak和Roberson,2013年;Biber和Egbert,2016年).

有趣的是,当比较用SVM提取的关键词和用TDK识别的关键词时(参见表3,4),这两种方法之间的词汇重叠率为55%,相对较高,这表明两种方法至少提取了部分相同的关键字集。这两种方法都将重点放在与博客相关的口头和叙事方面。尤其是,第一人称代词在关键词列表中排名第一,这就证明了这一点:(i、 我的,我)使用SVM和我的,我使用TDK。同时,值得指出的是,这两种方法都无法完全恢复前100个关键字中英语第一人称单数代词的完整范式:1)使用SVM,关键字矿排名215,2)使用关键字TDK我排名1668。对于提取所有相关关键字的方法,人们希望能够完整提取特定类别。用SVM提取的关键词也较好地涵盖了Biber和Egbert(2018)博客:姿态、时间/测量、描述、人称代词、博客和其他。明确地,爱,真的,很可爱和伟大的可以包括在Stance中,天,小时间/测量,东西在“说明”中,i、 我的,我在人称代词中,博客在博客中,以及是的,是的其他。此外,TDK关键字很好地遵循了这些分组,这是合乎逻辑的,因为这些分组是从使用相同TDK方法提取的关键字中进行的,尽管设置略有不同(参见第6节)。

TDK和SVM之间的一个显著区别是后者提取的关键字中功能词的出现更多。事实上,对于博客来说,SVM提取的几乎所有排名靠前的关键词都是功能性的,其中包括第一人称代词i、 我的,我,其他代词你,我们,我们,你,它,这个,和过去时助词或连词过去、过去相反,使用TDK提取的最热门关键字包括第一人称代词和第一人称是,但也包括与立场相关的词语,例如爱,可爱,感觉,乐趣和博客相关的单词,如博客,写作,事情。在使用SVM提取的关键字中,这些关键字排名较低,因为排名靠前的是虚词。

为了进一步研究两个前100个关键字列表之间的差异,我们比较了与它们相关的词汇类。有关估计词汇类别的更多信息,请参阅第2节。结果显示在表10.

两种方法在词汇类别分布上的差异具有统计学意义[]. 对单元格的残差分析表明,SVM提取的前100个关键词是由与虚词的正相关驱动的。因此,结果表明,尽管两个关键字列表之间的词汇重叠程度很高,但它们之间的差异是由SVM前100个关键字中的虚词贡献较高所致。这也可以解释上一节中TDK关键字的覆盖率较低和泛化性较小的原因。与虚词相反,TDK关键词中典型的内容词往往反映文本的主题元素,即使是同一文本类型的不同样本也不太可能共享这些主题元素。我们将在一般性讨论中回到这一发现。

新闻文本是一种非常典型的文本类型,包含在广泛的语言资源中。以往对其语言特征的比较研究将新闻与报道传播、信息聚焦和书面语篇领域联系起来(Titak和Roberson,2013年;Biber和Egbert,2016年). 这些都反映在非常常见的名词成分上,如名词、名词前名词和修饰语、交际动词、,那个从句和过去时。文本分散性分析Biber和Egbert(2018)为新闻关键词确定了九个类别:人民、政府、报道、数字/细节、政治、地点、新闻和其他。

SVM新闻的前100个关键字如下所示表2和中表5用于TDK。与博客类似,SVM为新闻提取的顶级关键词包括非常常见的虚词:代词他,他的,它,谁,他们,他们、限定词或介词在中,由,的和辅助设备有这些词确实符合先前对新闻的分析,因为人称代词与叙事、报道语篇联系在一起,很像助词有可以与过去时动词连用。限定词和介词是指与以信息为中心的语篇相关的名词和介词结构(另请参阅比伯和康拉德,2019年: 218). 在使用反映aboutness的SVM提取的关键字中,排名靠前的包括Reporting动词说,说,告诉、与人民和政府有关的词语人民、政府、先生、警察、公众、奥巴马、总统、和数字单词百万因此,使用SVM提取的关键字显然与作为文本变体的新闻相关,尽管有一些关键字,例如限定符这个,也很一般。

与基于SVM的关键字相比,使用TDK提取的关键字提供了一组略有不同的关键字,两个列表之间的词汇重叠仅为39%。与博客类似,TDK关键字比SVM提取的关键字包含更多的主题词。如第7.3节所示,使用TDK提取的关键词的主题性预计会增加;与SVM提取的关键词相比,它们在新闻中的泛化能力较低。在TDK排名前100位的关键词中,只有三个虚词,例如根据,而其他大部分都是名义上的,例如政府、总统、部长和报告动词,例如说,宣布为了测试两个关键词列表和新闻虚词之间的积极关联,我们比较了与关键词相关的词类分布;有关词汇类的讨论,请参阅第2节。数据见表10.

两种方法的分布差异具有统计学意义[]. 我们对细胞进行了残差分析,结果表明,分布上的差异主要是由虚词和SVM之间的正向关联和形容词和SVMs之间的负向关联驱动的。与博客相似,我们可以得出结论,SVM提取的关键词比TDK提取的关键词有更强的包含虚词的倾向。然而,至少在这些数据中,内容词分布的这种差异与形容词有关。

总之,我们已经证明SVM能够提取与其对应的文本种类相关的关键字。此外,与使用TDK提取的关键词相比,它们在词汇上的重叠程度更大。同时,本文的分析也表明,SVM倾向于提取关键词,包括前100个关键词中相对较大比例的虚词,而不是TDK,尤其是在新闻方面。我们将在一般性讨论中回到这一点。

8.一般性讨论

在当前的研究中,我们从预测建模的角度探讨了关键词分析。具体来说,我们引入了线性SVM作为一种探索关键性的方法,并证明了它们作为语料库语言学中文本分析的一部分的实用性。它们提供了可解释的、语言激励的结果,并具有很强的辨别能力。我们已经演示了如何使用预测建模来提取关键字,即预测关键字。这种方法有两个明显的好处。第一个好处与预测模型本身的过程有关;也就是说,它允许我们评估与目标语料库相关的文本与参考语料库的区别程度。这一点很重要,因为它为我们提供了文本的典型性信息,作为相对于参考语料库的相应话语域的范例。传统的关键词分析假设所有文本的典型性都相同,即给定的文档或多或少代表其相应类别。虽然TDK基于分散性,因此对与单个文档相关的分布属性敏感,但只有预测建模允许我们采取步骤来评估单个文档作为其类别成员的代表性,这是一个有助于更严格定量文本分析的方向。

第二个好处是与特定话语领域相关的关键性及其评估。在关键词分析以及如何评估提取的关键词的质量方面存在许多挑战。尽管关键词分析的使用在语料库语言学中有着悠久的传统,但大多数先前的研究都没有对其进行系统的评估。有关更多信息,请参阅简介。为了解决这个问题,我们从机器学习中变量选择的角度探讨了评估,特别是将其与有用性和相关性的概念联系起来。在这种方法中,有用性可以理解为指保持高预测能力的一组变量。相反,相关变量可以被理解为与一组变量相关,这些变量提供了所调查类别的描述性充分性。采用这种方法为我们提供了一种直接的方法来对比不同方法提取的关键字。为了比较使用SVM提取的关键字的质量,我们使用了Egbert和Biber(2019)作为比较点,因为它已经被证明可以提取高质量的关键字。最后,评估关键字的方法不仅可以提供有关其质量的信息,还可以用于揭示使用不同方法提取的关键字之间的差异。

在当前的研究中,我们证明,尽管SVM和TDK提取的关键字部分相同(参见第7.4节),但它们之间存在显著差异。这表明这两种方法侧重于语篇领域的不同方面,正如目标语料库和参考语料库所证明的那样。一般来说,SVM比TDK具有更高的实用性。有用性具体涉及四个概念:1)可区分性,2)稳定性,3)区分性,4)可概括性。因为SVM学习一种映射来区分目标语料库和参考语料库中的文本,所以使用SVM提取的关键字的属性也反映了这一过程,并倾向于显示那些最大限度地发挥有用性的特性。在本研究中,我们提出了评估有用性的一般概念。在未来的研究中,可以很容易地纳入其他测试,例如根据词频评估辨别能力,或者根据词类频率评估词汇覆盖率。

在与有用性相关的四个概念中,稳定性是之前研究中实际上没有的一个属性。基于稳定性的分析提出了一个有趣的发现。具体来说,无论数据分布有多小变化,SVM提取的前100个关键字实际上都保持不变。这是一个理想的质量,因为它确保了关键词可能适用于与给定话语领域相关的新文本。重要的是,关键字的稳定性与关键字的排名相关,并且不稳定性随着排名的增加而稳定增加。

在相关性方面,分析表明,SVM和TDK都提取了具有语言动机的关键词,反映了先前报道的博客和新闻相关文本的特征。然而,与SVM相比,使用TDK提取的关键字往往包含更多的内容词。这一特性也可以用来激发这两种方法在可泛化性上的差异,因为我们表明,与TDK相比,SVM对同一话语域中的新文本保留了更好的可泛化能力。以前的研究表明,主题元素往往缺乏概括性(参见Laippala等人,2021年以及其中的引文)。相比之下,使用SVM时,功能词在按键中的比例略高。这表明TDK更可能提出与文本相关的话语域的近似性相关的方面,而SVM也反映了话语域的句法和功能特征。

总之,我们已经表明,所提出的方法不仅允许评估提取的关键字的质量,而且还提供了更好地了解给定方法及其提取关键字的能力的机会。虽然我们已经证明,使用SVM提取的关键字往往具有许多理想的属性,但有一个关键的限制应该记住。此限制与使用机器学习提取一般关键字有关,并不特定于SVM。传统的关键词分析使用的参考语料库往往比目标语料库大得多。在机器学习环境中,首先选择一个特定的模型,然后利用该模型从参考语料库中区分与目标语料库相关的文本。两个语料库之间的巨大不平衡可能会使数据建模变得困难。例如,该模型可能在两个语料库之间显示出较差的区分能力。如果模型无法将与两个语料库相关联的文本彼此分离,那么从模型中提取的关键词很可能缺乏质量。同时,使用传统方法(如TDK)提取的关键字在这种设置下是否能保持较高的质量尚不清楚。在利用关键词分析的研究中,很少采用对提取的关键词质量的综合分析。这本身就是一个有趣的问题,应该在未来的关键字分析研究中继续探讨。未来研究的另一个潜在方向是关注关于性和话题性之间的关系。这种类型的分析将牢牢地置于相关性的概念之内。

数据可用性声明

本文/补充材料中包含了研究中的原始贡献,可向相应作者进行进一步查询。

作者贡献

A-JK和VL对当前研究做出了同等贡献,并批准了最终版本。这两位作者都对文章作出了贡献,并批准了提交的版本。

基金

这项工作得到了芬兰科学院在无限制网络上大规模多语言注册项目(第331297号拨款)下的资助,埃米尔·奥尔顿基金会在“一条新闻、一个观点或其他东西?不同的文本及其从多语言互联网上的检测”项目下的资助。

利益冲突

作者声明,该研究是在没有任何可能被解释为潜在利益冲突的商业或金融关系的情况下进行的。

出版商备注

本文中表达的所有声明仅为作者的声明,不一定代表其附属组织的声明,也不一定代表出版商、编辑和审稿人的声明。任何可能在本文中进行评估的产品,或制造商可能提出的索赔,都不受出版商的保证或认可。

作者免责声明

一条新闻、一个观点或其他什么?多语言互联网上的不同文本及其检测。

工具书类

Aarts,F.G.A.M.(1971)。英语句子结构中名词短语类型的分布。爱尔兰语26, 281–293. doi:10.1016/0024-3841(71)90013-1

CrossRef全文|谷歌学者

Arnhold,A.和Kyröläinen,A.-J.(2017)。模拟韵律焦点标记中多个线索的相互作用。实验室音素. 8, 4. doi:10.5334/labphon.78

CrossRef全文|谷歌学者

Biber,D.和Conrad,S.(2019年)。中的“注册、流派和风格”剑桥语言学教材,第二版(剑桥:剑桥大学出版社)。

谷歌学者

Biber,D.和Egbert,J.(2015)。使用语法功能在开放网络的无限制文档语料库中自动注册标识。J.Res.设计统计语言学家。Commun公司。科学. 2, 3–36. doi:10.1558/jrds.v2i1.27637

CrossRef全文|谷歌学者

Biber,D.和Egbert,J.(2016)。在可搜索网页上注册变体:多维分析。J.英语语言学家. 44, 95–137. doi:10.1177/0075424216628955

CrossRef全文|谷歌学者

Biber,D.和Egbert,J.(2018)。在线注册变更剑桥:剑桥大学出版社。

谷歌学者

Blum,A.L.和Langley,P.(1997年)。机器学习中相关特征和示例的选择。Artif公司。Intell公司. 97, 245–271. doi:10.1016/S0004-3702(97)00063-5

CrossRef全文|谷歌学者

Bondi,M.和Scott,M.(2010年)。文本中的基调.阿姆斯特丹;宾夕法尼亚州费城:约翰·本杰明斯出版公司。

谷歌学者

Boser,B.E.、Guyon,M.和Vapnik,V.N.(1992年)。“最佳边缘分类器的训练算法”,in第五届计算学习理论年度研讨会论文集第144-152页。

谷歌学者

Breiman,L.(2001a)。随机森林。机器。学习. 45, 5–32. doi:10.1023/A:1010933404324

CrossRef全文|谷歌学者

Breiman,L.(2001b)。统计建模:两种文化。统计师。科学. 16, 199–231. doi:10.1214/ss/1009213726

CrossRef全文|谷歌学者

Brysbaert,M.、New,B.和Keulers,E.(2012年)。在SUBTLEX-US词频中添加部分语言信息。行为。研究方法44, 991–997. doi:10.3758/s13428-012-0190-4

PubMed摘要|CrossRef全文|谷歌学者

Conneau,A.,Khandelwal,K.,Goyal,N.,Chaudhary,V.,Wenzek,G.,GuzmáN,F.等人(2020年)。《非监督跨语言表征学习量表》计算语言学协会第58届年会会议记录(计算语言学协会),8440–8451。

PubMed摘要|谷歌学者

Cortes,C.和Vapnik,V.(1995年)。支持向量网络。机器。学习. 20, 273–297. doi:10.1007/BF00994018

CrossRef全文|谷歌学者

Dunning,T.E.(1993)。统计意外和巧合的准确方法。计算。语言学家. 19, 61–74.

谷歌学者

Egbert,J.和Biber,D.(2019年)。将文本分散纳入关键词分析。Corpora公司14, 77–104. doi:10.3366/cor.2019.0162

CrossRef全文|谷歌学者

Egbert,J.、Biber,D.和Davies,M.(2015)。开发一种自下而上、基于用户的web注册分类方法。J.协会信息科学。Technol公司. 66, 1817–1831. doi:10.1002/asi.23308

CrossRef全文|谷歌学者

Fernández-Delgado,M.、Cernadas,E.、Barro,S.和Amorim,D.(2014)。我们需要数百个分类器来解决实际的分类问题吗?J.马赫。学习。雷斯. 15, 3133–3181. doi:10.5555/2627435.2697065

CrossRef全文|谷歌学者

Gabrielatos,C.(2018年)。“关键性分析:性质、指标和技术”语料库话语研究方法述评,编辑C.Taylor和A.Marchi(伦敦:Routledge),225-258。

谷歌学者

Geluso,J.和Hirch,R.(2019年)。参考语料很重要:比较不同参考语料对关键词分析的影响。寄存器螺柱. 1, 209–242. doi:10.1075/rs.18001.gel

CrossRef全文|谷歌学者

Gries,S.T.(2008)。语料库中的离散度和调整频率。英语特定用途13, 403–437. doi:10.1075/ijcl.13.4.02gri

CrossRef全文|谷歌学者

格里斯,S.T.(2021)。一种新的(关键)关键词分析方法:使用频率,现在也使用分散度。Res.语料库语言学家. 9, 1–33. doi:10.32714/ricl.09.02.02

CrossRef全文|谷歌学者

Guyon,I.和Elisseeff,A.(2003年)。变量和特征选择简介。J.马赫。学习。雷斯. 3, 1157–1182. doi:10.5555/944919.944968

CrossRef全文|谷歌学者

Guyon,I.、Weston,J.、Barnhill,S.和Vapnik,V.(2002)。使用支持向量机进行癌症分类的基因选择。机器。学习. 46, 389–422. doi:10.1023/A:1012487302797

CrossRef全文|谷歌学者

Joachims,T.(1998)。“使用支持向量机进行文本分类:使用许多相关功能进行学习”,in第十届欧洲机器学习会议记录(施普林格·弗拉格),137–142。

谷歌学者

Kanerva,J.、Ginter,F.、Miekka,N.、Leino,A.和Salakoski,T.(2018年)。“Turku神经解析器管道:2018年conll共享任务的端到端系统”CoNLL 2018共享任务会议记录:从原始文本到通用依赖的多语言分析.

谷歌学者

Kohavi,R.和John,G.H.(1997年)。特征子集选择的包装器。Artif公司。Intell公司. 97, 273–324. doi:10.1016/S0004-3702(97)00043-X

CrossRef全文|谷歌学者

Laippala,V.、Egbert,J.、Biber,D.和Kyröläinen,A.-J.(2021年)。探索词汇和语法在不受限制的网络文档语料库中稳定识别语域的作用。语言资源。评估. 55, 757–788. doi:10.1007/s10579-020-09519-z

PubMed摘要|CrossRef全文|谷歌学者

Linardatos,P.、Papstefanopoulos,V.和Kotsiantis,S.(2020年)。可解释人工智能:机器学习可解释性方法综述。熵23, 18. doi:10.3390/e23010018

PubMed摘要|CrossRef全文|谷歌学者

Matsuki,K.、Kuperman,V.和Van Dyke,J.A.(2016年)。随机森林统计技术:阅读研究价值的检验。科学。螺柱读数. 20, 20–33. doi:10.1080/10888438.2015.1107073

PubMed摘要|CrossRef全文|谷歌学者

Montavon,G.、Samek,W.和Müller,K.-R.(2018年)。解释和理解深度神经网络的方法。数字。信号处理. 73, 1–15. doi:10.1016/j.dsp.2017.10.11

CrossRef全文|谷歌学者

Nivre,J.、de Marneffe,M.-C.、Ginter,F.、Goldberg,Y.、Hajić,J.和Manning,C.D.等人(2016年)。“通用依赖项v1:一个多语言树库集合,”第十届国际语言资源与评价会议记录,eds N.Calzolari、K.Choukri、T.Declerck、S.Goggi、M.Grobelnik、B.Maegaard、J.Mariani、H.Mazo、A.Moreno、J.Odijk和S.Piperidis(波托罗兹:欧洲语言资源协会,ELRA),1659–1666年。

谷歌学者

Pedregosa,F.、Varoqueux,G.、Gramfort,A.、Michel,V.、Thirion,B.、Grisel,O.等人(2011年)。Scikit-learn:Python中的机器学习。J.马赫。学习。雷斯. 12, 2825–2830.

谷歌学者

Phillips,M.A.(1989)。文本的词汇结构伯明翰:英语语言研究。

谷歌学者

Pojanapunya,P.和Todd,R.W.(2018年)。对数似然和比值比:用于关键字分析的不同目的的关键性统计。语料库语言学家。语言学家。理论14, 133–167. 文件编号:10.1515/cllt-2015-0030

CrossRef全文|谷歌学者

Pojanapunya,P.和Watson Todd,R.(2021)。基准语料库对关键词分析的影响。寄存器螺柱. 3, 88–114. doi:10.1075/rs.19017.poj,

CrossRef全文|谷歌学者

R核心团队(2021年)。R: 统计计算语言与环境维也纳:R统计计算基金会。

谷歌学者

Rayson,P.和Garside,R.(2000年)。中的“使用频率分析比较语料库”比较语料库研讨会第1-6页。

谷歌学者

Repo,L.、Skantsi,V.、Rönnqvist,S.、Hellström,S.,Oinonen,m.、Salmela,A.等人(2021年)。《超越英语网络:语域的零快照跨语言轻量级单语分类》计算语言学协会欧洲分会第16届会议记录:学生研究研讨会(计算语言学协会),183-191。

谷歌学者

Ribeiro,M.T.、Singh,S.和Guestrin,C.(2016)。“我为什么要相信你?”解释任何分类器的预测第22届ACM SIGKDD知识发现和数据挖掘国际会议论文集(ACM),1135-1144年。

谷歌学者

Richardson,F.和Campbell,W.(2007年)。中的“使用支持向量机的鉴别关键字选择”神经信息处理系统进展,第20卷。第9-216页。

谷歌学者

Rönnqvist,S.、Kyröläinen,A.-J.、Myntti,A.、Ginter,F.和Laippala,V.(2022)。中的“通过稳定的单词属性解释类”计算语言学协会的研究结果:ACL 2022(都柏林:计算语言学协会),1063-1074。

谷歌学者

Schölkopf,B.、Smola,A.J.和Bach,F.(2002)。使用内核学习:支持向量机、正则化、优化及其他。马萨诸塞州剑桥:麻省理工学院出版社。

谷歌学者

Scott,M.(1997)。电脑关键词分析——以及关键词。系统25, 233–245. doi:10.1016/S0346-251X(97)00011-0

CrossRef全文|谷歌学者

Scott,M.和Tribble,C.(2006年)。语篇模式:语言教育中的关键词和语料库分析。阿姆斯特丹:约翰·本杰明斯。

谷歌学者

Searle,S.R.、Speed,F.M.和Milliken,G.A.(1980年)。线性模型中的人口边际均值:最小二乘均值的替代方法。美国统计局. 34, 216–221. doi:10.1080/00031305.1980.10483031

CrossRef全文|谷歌学者

Sharoff,S.、Wu,Z.和Markert,K.(2010年)。《巴别塔网络图书馆:评估流派收藏》LREC程序。

谷歌学者

Shmueli,G.(2010年)。解释还是预测?统计科学. 25, 289–310. doi:10.1214/10-STS330

CrossRef全文|谷歌学者

Stubbs,M.(2010年)。“关键字的三个概念”,in文本中的基调:语料库语言学研究,编辑M.Bondi和M.Scott(阿姆斯特丹;宾夕法尼亚州费城:John Benjamins),21–42。

谷歌学者

Stubbs,M.和Tribble,C.(2006年)。语篇模式:语言教育中的关键词和语料库分析阿姆斯特丹:约翰·本杰明斯。

谷歌学者

Tagliamonte,S.A.和Baayen,R.H.(2012)。约克英语的模型、森林和树木:过去/过去变异作为统计实践的案例研究。语言变化24, 135–178. doi:10.1017/S0954394512000129

CrossRef全文|谷歌学者

Titak,A.和Roberson,A.(2013)。网络注册的维度:探索性多维比较。下士8, 235–260. doi:10.3366/cor.2013.0042

CrossRef全文|谷歌学者

Tukey,J.W.(1994)。中的“多重比较问题”约翰·W·塔基作品集,第八卷,ed H.I.Braun(纽约:查普曼和霍尔),1–300。

谷歌学者

Vapnik,V.N.和Vapniks,V.(1998年)。统计学习理论纽约州纽约市:Wiley Interscience。

谷歌学者

Vaswani,A.、Shazeer,N.、Parmar,N.和Uszkoreit,J.、Jones,L.、Gomez,A.N.等人(2017年)。“注意力是你所需要的”神经信息处理系统进展,第30卷编辑I.Guyon、U.V.Luxburg、S.Bengio、H.Wallach、R.Fergus、S.Vishwanathan和R.Garnett(Curran Associates,Inc.)。

谷歌学者

Wang,X.,Yang,Z.,Chen,X.和Liu,W.(2019)。线性支持向量机的分布式推理。J.马赫。学习。雷斯. 20, 1–41.

谷歌学者

Zhang,K.、Xu,H.、Tang,J.和Li,J.(2006)。中的“使用支持向量机提取关键字”网络时代信息管理国际会议第85-96页。

谷歌学者