1.简介

传统的摄像系统往往受到视野狭窄的限制,而全景摄像机的引入正在缓解这一问题(Svoboda等人,1998年). 全景视觉相机主要有四种类型:平移旋转、鱼眼镜头、多摄像机拼接和折反射。特别是,折反射全景相机使用一种特殊类型的反射镜,称为折反射镜,将不同角度的光引导到单个图像传感器上,从而捕捉全景图像(Jaramillo等人,2016年). 主要由凸面反射镜、成像透镜和光敏元件组成(贝克和纳亚尔,1998年,1999)折反射全景相机避免了与光学透镜结构相关的复杂设计,解决了图像失真问题(刘等,2016). 此外,它消除了对图像拼接的要求,从而保证了360°全景视图的实时捕获。

视觉系统研究的快速发展日益使全景视觉系统成为相关领域研究人员的一个重要兴趣点。该技术在机器人导航、物联网(IoT)和自动驾驶等领域得到广泛应用(山泽等人,1995年;刘和梁,2013;Khurana和Armenakis,2018年). 全景视觉系统旨在捕捉环境的360°视图(Nichols等人,2010年). 在全景视觉的深度估计领域中,为图像中的每个像素计算深度值,以便于近似场景中对象与相机本身之间的距离。图像深度估计的研究领域主要有两种方法:有监督学习和无监督学习。

对综合标记了关键深度信息的数据集进行监督学习,为单目深度估计提供了一种有效的方法(Eigen等人,2014年). 结合一个独特的图像重建损失函数来评估生成的深度图和输入图像之间的差异(Li等人,2017年)从而支持网络对图像深度信息的学习。此外,利用数据增强技术对训练数据进行放大和变换,使网络训练样本多样化,有效提高网络的泛化能力(Eldesokey等人,2020年;Kusupati等人,2020). 尽管这些方法已被证明能够提供高质量的深度估计结果,但它们在很大程度上依赖于负责注释过程的人员的大量时间和技能,使得注释错误或不一致的潜在发生几乎无法控制。

随着深度学习技术的进步,无监督端到端深度估计方法已成为研究热点之一。端到端的神经网络模型可以完成从输入到输出的整个过程,而无需在中间步骤进行人工干预。这些模型分为两类:第一类是通过立体匹配技术进行同化学习;第二种方法利用连续帧之间的位移来推断与场景中对象相关的深度数据(Garg等人,2016年). 使用未标记的单目视频序列作为网络输入,以无监督的方法训练卷积神经网络(CNN),使得深度估计模型独立于标记的深度信息数据集(Zhou等人,2017年). 该方法扩展了深度估计模型的潜在应用场景。然而,该方法的一个局限性是深度估计的精度相对较低。因此,人们采用了各种方法来提高深度估计的性能和鲁棒性。其中包括使用重建图像损失函数来提高左右视差图之间的一致性(Godard等人,2017年)以及集成三维几何约束以约束无监督深度学习(Mahjourian等人,2018). 通过在训练过程中使用二进制深度分类,可以快速预测附近的目标(Badki等人,2020年). 此外,即使对深度估计进行相对粗糙的量化,也可以保持较高的精度。为了解决普遍存在的无监督尺度问题,通过利用立体图像中与立体图像之间运动相关的深度信息,对单目深度估计和立体视觉里程计进行联合训练(Zhan等人,2018年). 无监督学习方法可以自动发现图像中的深度结构,而无需任何手动干预。然而,真实室外场景中的复杂现象,如照明变化、遮挡等,给图像深度估计带来了潜在的挑战。在图像深度估计过程中,这些因素可能会导致诸如预测深度图中精细细节丢失和深度图中精度较低等问题,从而妨碍准确深度信息的获取。

本文提出了一种利用折反射全景相机进行全景图像深度估计的新方法。该摄像头的独特设计有助于以360°的方式实时监控环境,并缓解了多个摄像头系统遇到的失真和缺失补丁的挑战,最终降低了成本。本文提出的无监督端到端深度估计方法系统地解决了现有模型中常见的精细细节预测不够准确的问题。考虑到这个目标,我们的方法采用了非局部注意机制来捕获图像中复杂的上下文依赖。此外,我们引入了深度平滑损失,以提高深度估计算法的准确性和效率。

2.建议方法

2.1. 折反射全景相机图像预处理

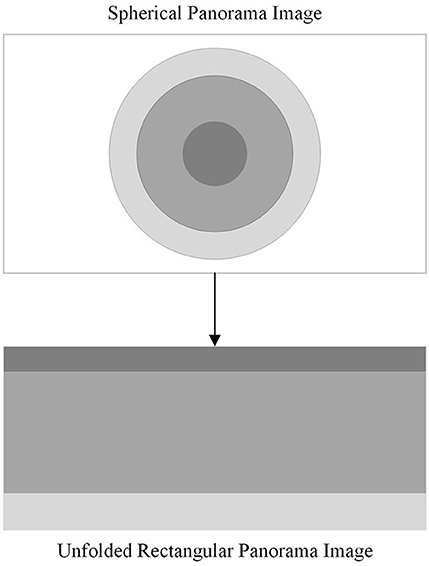

在为折反射全景成像系统选择反射镜时,需要考虑各种曲面反射镜的成像原理、制造成本和复杂性。双曲镜可以在更宽的范围内捕获图像,并且具有降低生产成本的优势。因此,本文选择双曲镜作为折反射全景成像系统的反射元件。由于折反射全景相机成像原理的特殊性,折反射全景摄像机拍摄的全景图像具有较大的畸变。为了解决这个问题,有必要将全景图像展开为二维矩形图像,以便全景图像中的每个像素对应于展开图像中的一个位置。这称为全景扩展。如所示图1.

传统的折反射全景图通常采用同心圆近似展开算法进行展开,但展开后的图像失真明显,影响后续的深度估计处理。针对这一问题,本文改进了同心圆近似展开算法,降低了展开图像的失真度。图2显示了改进算法的原理。

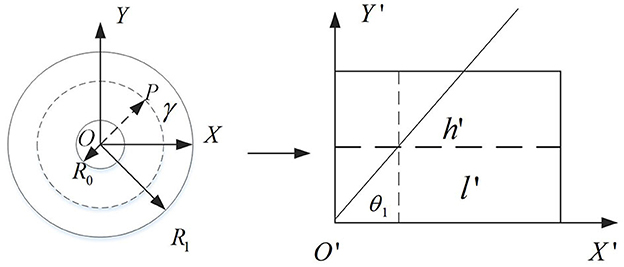

以折反射全景图中心为原点的直角坐标系O(运行)水平和垂直方向为X(X)-轴和Y(Y)-轴。右图中的虚线图2如图所示。让虚线所代表的环作为其全景展开。因此,在全景图展开后,可以获得二维矩形的长度和宽度。如下公式所示:

穿过中心点的光线O(运行)在一点处与虚线表示的圆环相交P(P)(x1,年1). 展开后,光线和X(X)-轴用θ表示1,因此:

使用光线操作作为极轴,围绕极点旋转360°O(运行)通过计算,可以获得圆周上的所有像素值,并按一定的顺序排列。计算公式为:

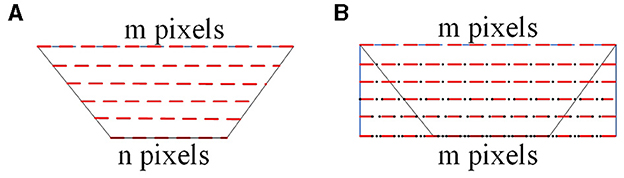

如所示图3描述了全景图像的插值过程。在图3A,红色虚线表示折反射全景图像展开后的像素值。在图3B,黑点表示插入的像素值。在图3A,梯形的最长边对应于离折反射全景图像中心最远的区域。基于此最长边,构造一个二维矩形,确保每一行的插值像素数与最长边的长度相同。如果梯形图像的最长边有m个像素,最短边有n个像素,那么最短边需要插入m-n个像素以确保二维矩形中的每一行与最长边具有相同的像素数。当执行插值处理时,第一像素x我,我= 1, 2, ⋯米梯形图像的最短边应放置在矩形对应边的第一个位置。因为我们需要插入米−n个像素位于最短边,这意味着需要在相邻像素之间插入(米−n个)/n个像素以在插值过程中保持所需的一致性。通过插值,我们在折反射全景图像最短边的相邻像素之间插入n个插值像素值。这一过程对每一行都是一致的,从而得到折反射全景图的最终矩形展开图像。最后,通过使用插值,我们插入(米−n个)/n个折反射全景图像最长边的相邻像素之间的像素值,导致折反射全景视图的最终矩形展开图像。

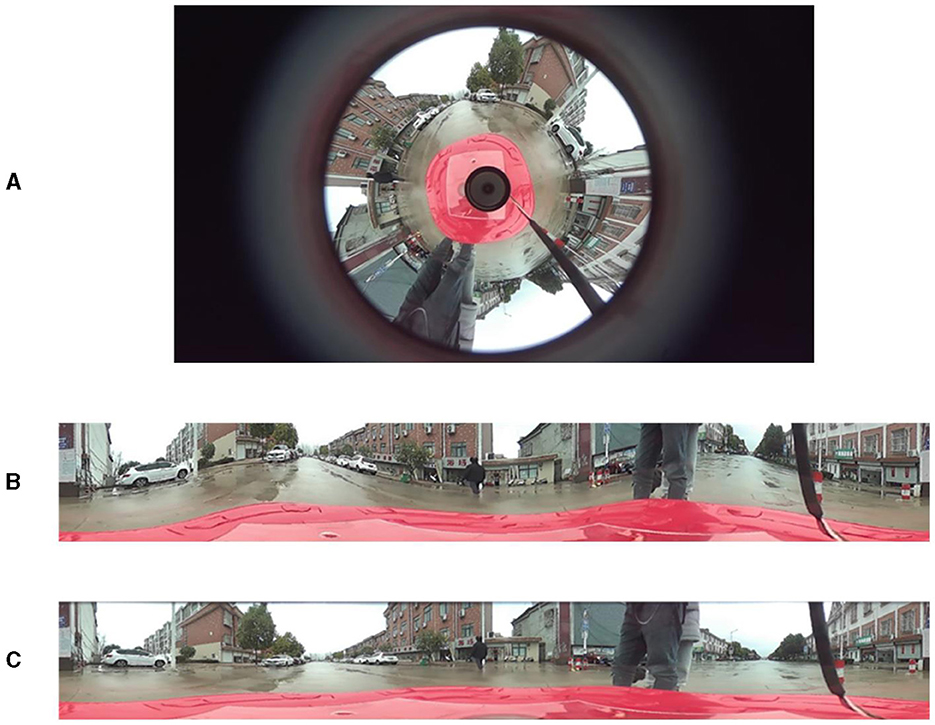

如所示图4两种方法的仿真结果表明,与传统方法相比,改进的方法具有更好的实时性。比较中的展开图像图4B,C类改进的同心圆近似展开算法显示出较小的失真,更准确地再现了原始场景。

展开的全景图像包含完整的场景360°全景信息。实际上,只需要图像中直接位于对象前面的部分。因此,有必要从展开的全景图像中有效地提取相关区域。从中展开的图像图4C可以观察到,车辆的正面视图位于展开图像的左侧,车辆顶部的高度约为整个图像高度的三分之一。因此,有效感兴趣区域位于展开图像的从左到右一半以及展开图像高度的从上到下三分之二范围内。如所示图5,该有效区域是后续深度估计的关键区域。事实上,这可以减少计算量,提高检测速度,甚至消除一些误报。

2.2. 改进的无监督单目深度估计模型

为了解决监督学习方法中难以标注的问题,本文采用非监督学习方法进行图像深度估计。无监督端到端深度估计方法的一个常见问题是在预测精细细节时缺乏准确性。现有的非监督图像深度估计方法很少关注图像空间上下文对深度信息的影响。因此,本文提出了一种改进的无监督学习算法框架,将非局部注意机制模块引入到编码器和解码器的网络结构中。这有助于网络对图像中的不同区域执行自适应上下文建模。该方法使网络能够更好地理解图像中的各种对象、背景和纹理,从而增强其对图像内容的理解和表示能力。

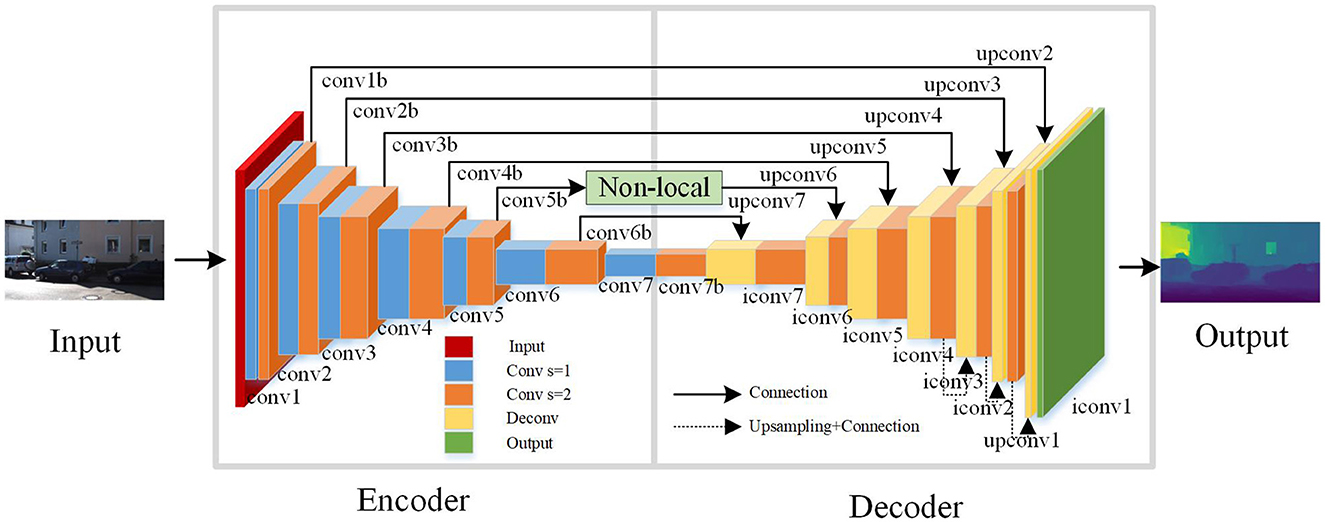

如所示图6,这是改进的无监督学习深度估计网络模型。该网络基于端到端编码器-解码器框架,允许它对多尺度图像进行深度估计。为了更好地捕获图像中的上下文信息,在网络框架中加入了非局部操作注意机制模块。在编码器的每一层中,非局部操作关注机制模块用作第二个操作,并使用步长为2的卷积。网络结构由三部分组成:编码器、解码器和非本地操作模块。编码器用于特征提取,负责将输入图像转换为高维特征向量。卷积神经网络(CNN)通常用于实现编码器部分。解码器用于深度估计,其主要作用是将编码器提取的特征向量解码为深度图。非局部操作模块用于从图像中提取上下文信息,并在输入特征图的空间维度上实现全局交互。这允许融合全局上下文信息,帮助模型更好地理解图像中对象之间的关系,从而提高性能。

在本文中,Disp-Net框架(Mayer等人,2016年)用于设计编码器的结构。并且,通过将长距离跳跃连接与非长距离操作相结合,增强了网络的表达能力,以获得更精确的深度图。卷积层主要用于神经网络中的特征提取。激活层将非线性引入神经网络,这对于网络学习数据中的复杂非线性模式至关重要。池层在降低特征图的空间维数方面起着至关重要的作用,这有助于减少网络中的计算负载和参数数量。在这种网络结构中,除了输出层之外,在所有卷积层之后都使用ReLU激活函数。这是因为该激活函数具有计算速度快、易于优化和避免消失梯度问题等优点。这种设计策略有助于提高网络的性能和稳定性,使深度估计模型更加可靠和实用。

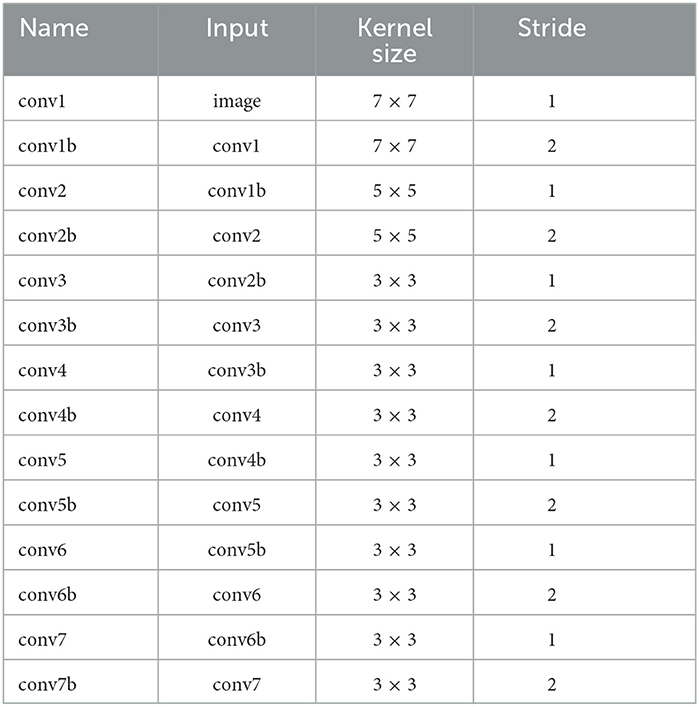

在编码器中,使用步长为2的卷积运算旨在更有效地提取特征。这种卷积运算有助于减少特征图的大小,增加感受野,减少通道的数量,从而降低计算复杂度,降低内存消耗,提高网络的计算效率。增加接受域有助于网络更好地理解输入数据中的上下文信息,从而提高网络的预测精度。减少特征图中的通道数有助于降低数据的维数,从而降低计算和存储成本。通过在编码器中组合这些操作,可以有效地优化神经网络的性能和效率。最后,使用函数1/(α*sigmoid)约束预测深度值(x)+β) ,其中α=8,β=0.1。如所示表1,编码器网络模型的特定结构是端到端编码器-解码器体系结构的一部分。

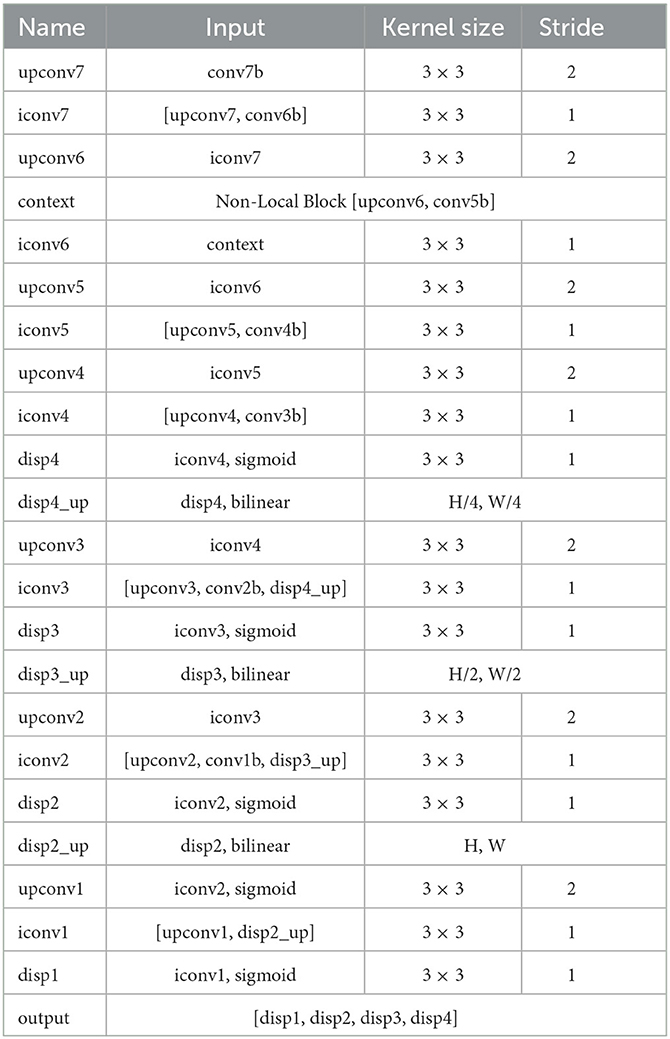

如所示表1本文中的端到端网络解码器采用反褶积运算,将编码器最后一层第二次运算的输出作为其输入。在解码器的其他层中,采用了融合级联操作,第二个操作的输出位于编码器的第二到最后一层。这种融合允许解码器访问并合并来自编码器的更多图像特征。解码器其他层中的融合级联操作遵循类似的原理。具体来说,解码器中的每一层都包含两个操作:反褶积和级联。反褶积过程从编码器对特征映射进行上采样,以获得更高分辨率的图像特征。在级联操作中,通过去卷积获得的上采样特征图与来自编码器的相应层的特征图相组合。通过在解码器中结合反褶积和级联操作,网络可以获得更详细和上下文丰富的特征图。这使得解码器可以生成更准确、更具视觉吸引力的图像结果。

在反褶积过程中,缺少上下文信息可能会导致RGB图像中一些精细细节的丢失,从而影响图像深度估计的结果。为了解决这个问题,本文引入了非局部操作注意机制,该机制计算每个像素的相似度,以加权每个像素的上下文信息。通过这样做,网络可以在反褶积过程中捕获和利用更丰富的上下文信息,减少精细细节的丢失,提高图像深度估计的准确性。

端到端网络的解码器网络模型的具体结构如所示表2.实验结果表明,在[上变频器6,卷积和多项式相乘5b条]产生最佳性能。在图像深度估计中,为了获得四个不同尺度的深度图并对前三个尺度进行升采样,通常使用双线性插值。执行双线性插值时,前三个尺度的采样率分别为1/4、1/2和1。最后,通过融合三种比例的深度图,该网络得到了四种不同比例深度图的最终集[显示1,显示2,显示三,显示4].

2.3. 非本地注意机制

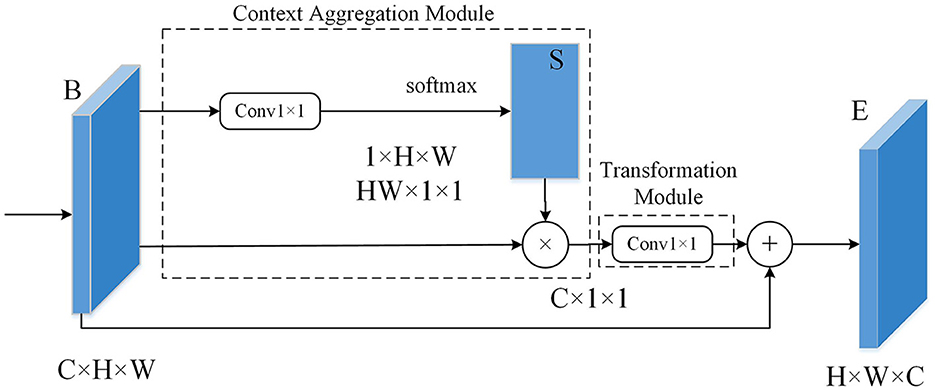

在计算机视觉中,结合注意机制可以帮助模型将注意力集中在图像中更重要的区域,从而减少不相关背景的影响。非局部操作是一种注意机制,它使用全局信息捕获图像中像素之间的长期相关性。与本地操作相比,非本地操作具有更广的接受域和更强的建模能力。非局部操作背后的基本概念是计算图像中每个像素和所有其他像素之间的相似性。然后利用这些相似性对整个图像进行自适应加权,使模型能够更好地理解图像的全局结构。

图7显示了非本地操作模块的示意图。本文中,上下文聚合模块和转换模块都加入了1×1卷积,可以在不丢失信息的情况下降低输入特征图的维数。上下文聚合模块是实现非本地操作的核心组件。它的主要功能是通过计算欧几里得距离或余弦相似度等度量来测量两个像素之间的关系。通过计算这些度量,上下文聚合模块可以确定输入特征映射中像素之间的相似性或差异性。这允许模块捕获长期依赖关系并在图像中建立全局上下文,使模型能够理解不同像素之间的关系并提取重要的上下文信息。转换模块用于将输入的特征映射转换为新的特征映射以进行进一步处理。转换模块的输出作为下一层的输入,支持跨不同层的数据通信和集成。1×1卷积有两个主要目的:第一,减少维数和信道数;其次,引入非线性元素来增强神经网络的表达能力。

非局部操作的数学定义如下:

在上述方程式中:(1)x是特征地图;(2)我表示输入上点的空间位置x或输出年; (3) 位置处的响应值我由表示年我; (4) 变量j个迭代输入x或输出上所有点的空间坐标年; (5) 变量xj个表示位置处的值j个关于输入数据;(6) 功能(f)(x我,年j个)计算位置之间的相似性我和位置j个输入数据的数量;(7) 功能克(xj个)计算位置处输入数据的表示j个,可以理解为相似性函数的权重(f)(x我,年j个); 和(8)最终响应值年位置处的非对数操作我通过加权相似度求和得到(f)(x我,年j个)克(xj个)每个位置的j个相对于当前位置我。然后使用归一化因子对该总和进行归一化C类(x),这导致所有位置的特征加权和用作该特定位置的响应值。

2.4. 深度平滑损失函数

为了减少误差和结果的不确定性,可以在深度估计中使用平滑约束。平滑约束是指通过限制相邻像素深度之间的差异来减少深度贴图中的噪声和不连续性。这可以通过将平滑项添加到深度估计模型的损失函数来实现。为了进一步提高深度估计的精度和效果,本文改进了模型的损失函数,并采用了深度平滑损失。该损失函数的平滑误差可以通过计算深度图的梯度得到。为了更好地表示深度变化,在深度图的对数域中执行梯度计算。根据经验,深度图中的不连续深度值通常出现在图像的边缘。因此,将待估计图像的边缘作为惩罚因子来限制平滑损失。本文构造的深度平滑损失包括以下三个方面:

(1) 基于深度图梯度计算的平滑损失。通过在对数域中计算深度图的梯度,我们可以获得深度变化的信息,从而提高深度图的平滑度。

在上述方程式中Z轴日志表示深度图的对数梯度,∏xZ轴日志表示梯度的水平分量,以及年Z轴日志对应于梯度的垂直分量。指数我和j个分别表示深度图的行索引和列索引,而W公司和H(H)表示深度贴图的宽度和高度。

(2) 基于边缘信息的平滑损失。通过利用输入图像的边缘信息作为约束,深度图可以进行更精确的平滑处理。

在方程式中,我灰色表示从RGB图像获得的灰度图像,其中每个像素值位于0到255的范围内x我灰色表示水平梯度,以及年我灰色表示垂直梯度。

(3) 最终深度贴图平滑损失。如式(9)所示:

在方程式中,N个表示图像中的像素总数。

3.实验

3.1. 实验环境和过程

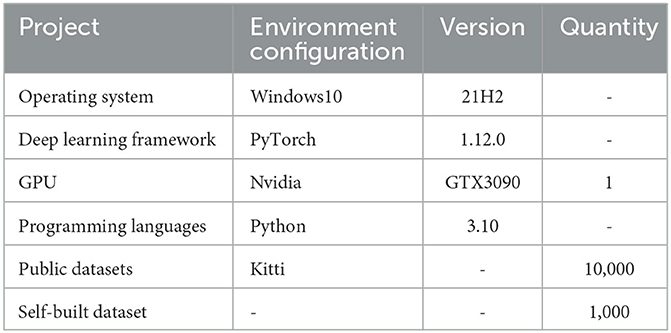

在本研究中,使用PyTorch深度学习框架在NVIDIA GTX3090 GPU上实现并训练改进的无监督深度估计网络模型。通过实验评估了该模型在深度估计方面的性能。除了使用公开可用的KITTI数据集之外(Geiger等人,2013年)本研究还利用了折反射全景相机采集的数据集进行实验。在实验过程中,除了输入层之外,所有层都应用了批量规范化层和Adam优化器。在Adam优化器中,设置β1= 0.95, β2=0.994,学习率为0.001,迷你背带尺寸为3。除了输入层之外,每个层都应用了批量规范化层,这有助于加快网络的训练并提高其准确性。此外,还选择了一个相对较小的迷你背带,以促进网络更快地融合。表3本章显示了实验环境的参数。

3.2. 评价指标

本文使用四个评估指标来评估模型的性能,即绝对相对误差(AbsRel)、平方相对误差(SqRel),均方根误差(RMS)和对数误差(Log)。具体形式如下:

绝对相对误差:绝对相对误差是用于评估模型预测值和地面真实值之间差异的指标。其计算公式是预测值与地面真值之间的绝对差值除以地面真值,反映出相对于地面真值的误差大小。

SqRel:平方相对误差的计算方法是,取预测值与地面真值之差的平方,然后除以地面真值。

均方根误差:均方根误差是一种计算预测误差平方平均值平方根的度量。它测量预测误差的平均大小,通常用于评估模型预测的准确性。

对数误差是一种度量,它首先取预测值和真值的对数,然后计算这些对数之间的误差。当处理值之间存在较大范围或显著差异的数据时,此度量非常有用。

在上述表达式中,N个表示用于评估所有RGB图像的有效像素总数。D类我表示预测的深度我-RGB图像中的第个像素,以及表示相同像素的真实深度。

3.3. 结果和分析

采用改进的同心圆近似展开算法对全景图进行处理,提取有效区域。从这些图像片段创建数据集并执行深度估计,这验证了本文所提改进算法的鲁棒性。

图8显示了深度估计的结果。在图8,第一列为原始图像,第二列表示深度估计结果Zhou等人(2017),最后一列显示了使用本文提出的方法获得的深度图。深度贴图中的深色表示距离较近,而浅色表示距离更远。通过对不同场景图像的实验,原算法的深度估计结果是模糊的,在大多数情况下不能得到准确的结果。本文改进的方法可以生成更清晰的深度图。特别是在目标边缘分割的情况下,该方法的效果更为明显。

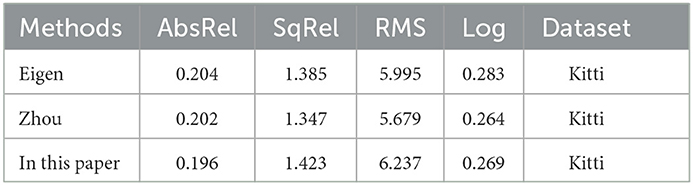

为了验证本文提出的改进深度估计算法的有效性,在Kitti数据集上进行了实验和分析。通过与Eigen等人(2014)和Zhou等人(2017)实验结果比较如表4.

如所示表4与监督方法相比,我们提出的方法具有更低的绝对相对误差和对数误差Eigen等人(2014)分别下降0.8%和1.4%。与无监督学习方法相比Zhou等人(2017)我们的方法在绝对相对误差方面表现更好,减少了0.6%,但总体误差略高。总之,本文改进的方法在误差方面表现出更好的性能,具有更高的精度,并且能够解决图像深度估计中的模糊问题。

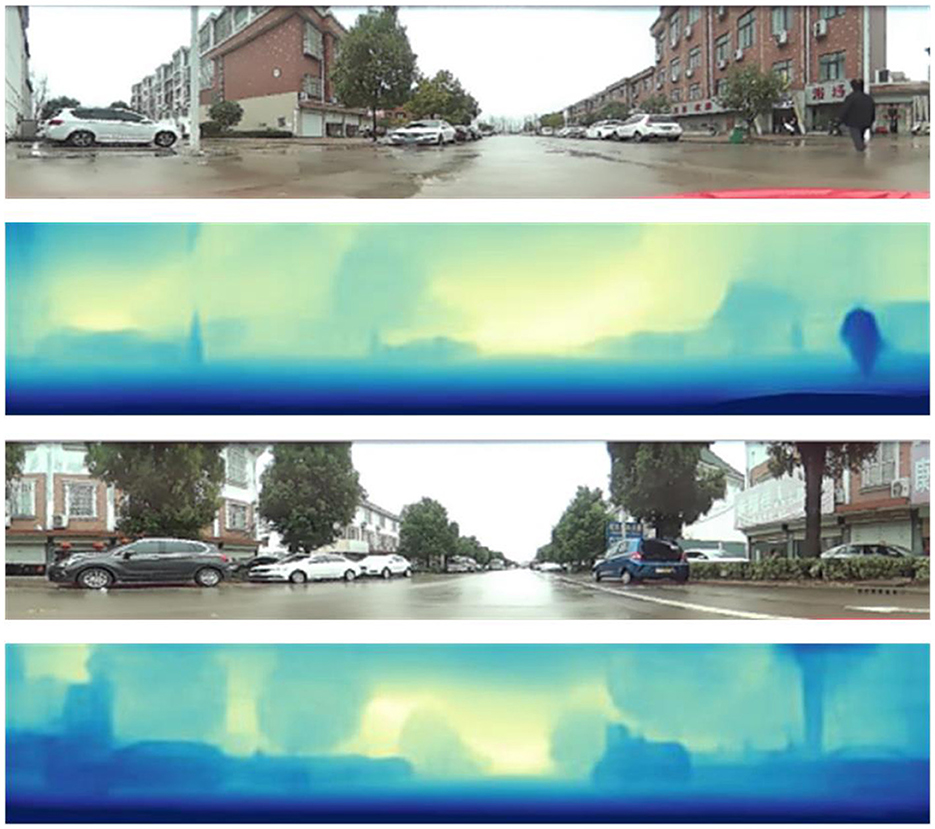

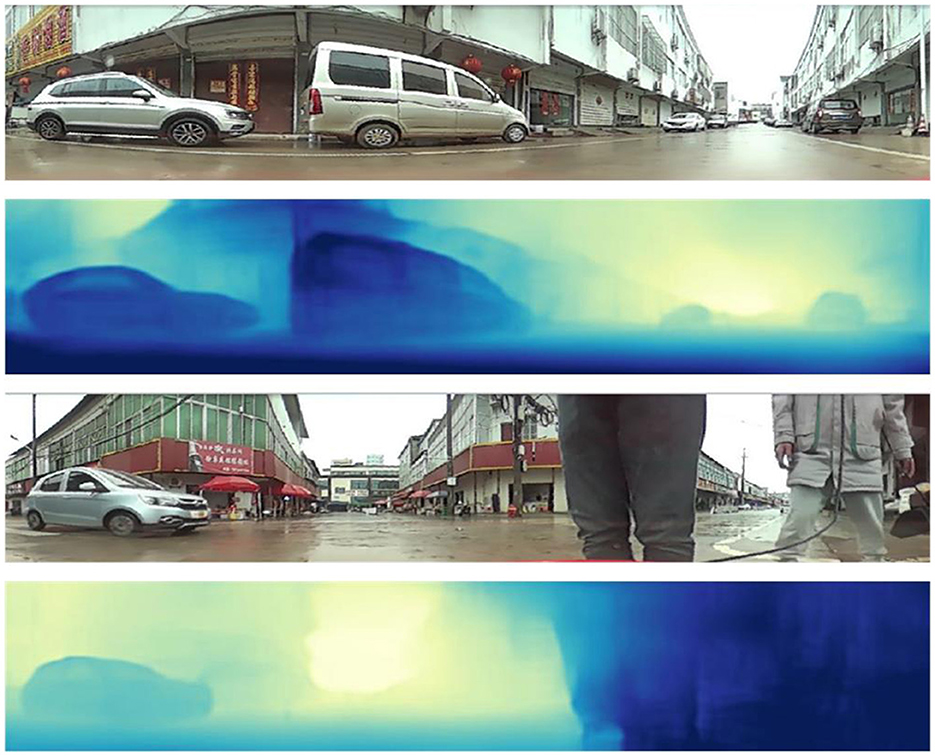

为了进一步验证算法的有效性,我们对折反射全景相机在不同场景中拍摄的200幅图像进行了测试。图9,10展示了不同场景的一些实验结果。

在图9,10,第一行和第三行显示原始测试图像。第二行和第四行显示深度估计结果。深度估计图像中像素的颜色表示距离,其中深色表示距离较近,浅色表示距离更远。

从实验结果可以看出,本文改进的图像深度估计算法能够相对准确地估计图像中物体的深度范围。考虑到图像采集过程中相对于车辆的距离分析,对于距离小于2.5米的对象,例如车辆和行人,其在深度图中的相应深度值在0到80之间,这表示深度图中最暗的颜色;对于距离为2.5到4米的物体,深度图结果中的灰度值在81到150的范围内;对于距离大于4米的对象,深度图结果中的灰度值在151到255之间,这导致深度图中的颜色相对较浅。

总之,本文提出的基于折反射全景相机的研究方法证明了其在深度估计方面的有效性。

4.结论

提出了一种基于折反射全景相机的单目深度估计算法。提出了一种改进的同心圆近似展开算法,用于处理折反射全景相机拍摄的全景图像。该算法用于将扭曲的全景图像展开为更有用的格式,以便进一步分析和深度估计。该方法提高了全景数据的质量和准确性。根据展开后的矩形全景图特征提取有效区域。最后,本文提出了一种新的无监督端到端深度估计网络模型。实验结果表明,该算法的深度估计结果优于现有算法。

数据可用性声明

作者将毫无保留地提供支持本文结论的原始数据。

作者贡献

FY:写原稿,写评论和编辑。噢,写原稿,写评论和编辑。XD:写原稿。QZ:撰写评论和编辑。YL:写评论和编辑,写原稿。

基金

作者声明获得了对本文的研究、作者身份和/或出版的财政支持。吉林省科技厅项目,批准号:20210203039SF。

利益冲突

作者声明,该研究是在没有任何可能被解释为潜在利益冲突的商业或金融关系的情况下进行的。

出版商备注

本文中表达的所有声明仅为作者的声明,不一定代表其附属组织的声明,也不一定代表出版商、编辑和审稿人的声明。任何可能在本文中进行评估的产品,或制造商可能提出的索赔,都不受出版商的保证或认可。

工具书类

Badki,A.、Troccoli,A.、Kim,K.、Kautz,J.、Sen,P.和Gallo,O.(2020年)。“Bi3d:通过二进制分类进行立体深度估计”,inIEEE/CVF计算机视觉和模式识别会议记录(西雅图,华盛顿州),1600-1608。doi:10.1109/CVPR42600.2020.00167

CrossRef全文|谷歌学者

Baker,S.和Nayar,S.K.(1998年)。《折反射成像理论》第六届计算机视觉国际会议(IEEE分类号98CH36271)(孟买:IEEE),35-42。

谷歌学者

Baker,S.和Nayar,S.K.(1999年)。单视点折反射成像理论。国际计算机杂志。视觉. 35, 175–196. doi:10.1023/A:1008128724364

CrossRef全文|谷歌学者

Eigen,D.、Puhrsch,C.和Fergus,R.(2014)。“使用多尺度深度网络从单个图像进行深度图预测”神经信息处理系统研究进展27

PubMed摘要|谷歌学者

Eldesokey,A.、Felsberg,M.、Holmquist,K.和Persson,M.(2020年)。“深度完成的不确定性感知cnns:从头到尾的不确定性”,inIEEE/CFF计算机视觉与模式识别会议论文集12014–12023. doi:10.1109/CVPR42600.2020.01203

CrossRef全文|谷歌学者

Garg,R.、Bg,V.K.、Carneiro,G.和Reid,I.(2016)。《用于单视图深度估计的无监督cnn:拯救几何体》,in2016年10月11日至14日在荷兰阿姆斯特丹举行的第十四届欧洲会议,计算机愿景-ECCV,第八部分14(施普林格),740-756。doi:10.1007/978-3-319-46484-845

CrossRef全文|谷歌学者

Geiger,A.、Lenz,P.、Stiller,C.和Urtasun,R.(2013)。视觉与机器人:基蒂数据集。国际J机器人。雷斯. 32, 1231–1237. doi:10.1177/02783649113491297

CrossRef全文|谷歌学者

Godard,C.、Mac Aodha,O.和Brostow,G.J.(2017年)。“左右一致性的无监督单目深度估计”,inIEEE计算机视觉与模式识别会议论文集(夏威夷州火奴鲁鲁),270-279。doi:10.1109/CVPR.2017.699

CrossRef全文|谷歌学者

Jaramillo,C.、Valenti,R.G.和Xiao,J.(2016)。“牙龈:立体全向视觉的通用统一模型(通过折叠折反射系统演示)”,in2016 IEEE/RSJ智能机器人和系统国际会议(IROS)(大田:IEEE),2528–2533。doi:10.1109/IROS.2016.7759393

CrossRef全文|谷歌学者

Khurana,M.和Armenakis,C.(2018年)。使用非中心折反射相机系统进行定位和绘图。ISPRS年鉴照片。剩余敏感度。信息科学. 4, 145–152. doi:10.5194/isprs-annals-IV-2-145-2018年

CrossRef全文|谷歌学者

Kusupati,U.、Cheng,S.、Chen,R.和Su,H.(2020年)。“正常辅助立体深度估计”,inIEEE/CVF计算机视觉和模式识别会议记录(西雅图,华盛顿州),2189–2199。doi:10.1109/CVPR42600.2020.00226

PubMed摘要|CrossRef全文|谷歌学者

Li,J.、Klein,R.和Yao,A.(2017年)。“一个两流网络,用于从单个rgb图像估计精细刻度深度图”,inIEEE计算机视觉国际会议记录3372–3380. doi:10.1109/ICCV.2017.365

CrossRef全文|谷歌学者

Liu,M.和Liang,N.(2013)。《使用改进的光流法检测运动目标》2013年第四届世界软件工程大会(IEEE),311-315。doi:10.1109/WCSE.2013.57

CrossRef全文|谷歌学者

Liu,Y.、Tian,C.和Huang,Y.(2016)。鱼眼镜头畸变校正方法的关键评估。国际建筑。照片。剩余敏感度。信息科学. 41, 221–228. doi:10.5194/isprsarchives-XLI-B1-221-2016年

CrossRef全文|谷歌学者

Mahjourian,R.、Wicke,M.和Angelova,A.(2018年)。“使用三维几何约束从单眼视频中无监督地学习深度和自我运动,”IEEE计算机视觉和模式识别会议记录(西雅图,华盛顿州),5667–5675。doi:10.1109/CVPR.2018.00594

CrossRef全文|谷歌学者

Mayer,N.、Ilg,E.、Hausser,P.、Fischer,P.和Cremers,D.、Dosovitskiy,A.等人(2016年)。“用于训练卷积网络以进行视差、光流和场景流估计的大型数据集”IEEE计算机视觉和模式识别会议记录(内华达州拉斯维加斯),4040-4048。doi:10.1109/CVPR.2016.438

CrossRef全文|谷歌学者

Nichols,J.M.、Waterman,J.R.、Menon,R.和Devitt,J.(2010年)。高性能中波红外全景潜望镜的建模与分析。选择。工程. 49, 113202–113202. doi:10.117/1.3505866

CrossRef全文|谷歌学者

Svoboda,T.、Pajdla,T.和Hlavánch,V.(1998年)。全景相机的外极几何,“in计算机视觉–ECCV'98:第五届欧洲计算机视觉会议,德国弗莱堡,6月1998年2月6日,《程序集》(Springer),218–231。doi:10.1007/BFb0055669

CrossRef全文|谷歌学者

Yamazawa,K.、Yagi,Y.和Yachida,M.(1995年)。“全向图像传感器超全向视觉障碍检测”,in1995年IEEE机器人与自动化国际会议记录(名古屋:IEEE),1062–1067。doi:10.10109/机器人.1995.525422

PubMed摘要|CrossRef全文|谷歌学者

Zhan,H.、Garg,R.、Weerasekera,C.S.、Li,K.、Agarwal,H.和Reid,I.(2018年)。《无监督学习单目深度估计和深度特征重建视觉里程计》IEEE计算机视觉和模式识别会议记录(犹他州盐湖城),340–349。doi:10.1109/CVPR.2018.00043

CrossRef全文|谷歌学者

Zhou,T.、Brown,M.、Snavely,N.和Lowe,D.G.(2017)。《非监督学习视频中的深度和自我意识》IEEE计算机视觉和模式识别会议记录(夏威夷州火奴鲁鲁),1851-1858年。doi:10.1109/CVPR.2017.700

CrossRef全文|谷歌学者