1.简介

近年来,大量研究集中于深度强化学习(DRL),它将强化学习与深度学习相结合。强化学习是一个框架,用于获得一种行为策略,即使在未知条件下,也可以通过尝试和错误来实现价值最大化。深度学习是一种高级模式识别方法,它在各种图像处理问题中表现出了高效的性能。DRL已经应用于各种优化问题,例如机器人(Levine等人,2016年)和无人机控制(Kahn等人,2017年)和游戏学习(Mnih等人,2013年). Alpha Go(Alpha Go)(Silver等人,2016年)是DRL最著名的应用之一。Alpha Go创建于2016年,后来击败了世界上最好的围棋选手Lee Sedol(9段或9级)和Ke Jie(9段)。最新版本的Alpha Go超越了之前的版本,它事先不知道石头的位置,也不知道游戏中人类行为的历史记录(Silver等人,2017年). 然而,日间行车灯的使用仍然面临着几个尚未解决的问题。这些问题包括对大量样本的需求,无法规划长期战略,以及在实际实验中采取冒险行动的倾向。

最初的DRL是一个深度Q网络(DQN)(Mnih等人,2013年,2015)由谷歌Deep Mind提出,该公司学习通过游戏屏幕玩49种不同的Atari 2600游戏。Q学习(沃特金斯和大雁,1992年;萨顿和巴托,1998年)是一种典型的强化学习方法。在Q学习中,通过学习一个动作值函数(又称Q函数),得到一个最优的动作策略。DQN使用卷积神经网络(CNN)从屏幕上提取特征,Q学习学习游戏。已经对DQN的扩展版本进行了大量研究,例如双Q学习(van Hasselt,2010年;van Hasselt等人,2016年)这减少了对动作值的高估,优先体验重放(Schaul等人,2015年)优先考虑用于学习、决斗网络架构的经验数据(Wang等人,2016年),从状态值和优势值输出动作值,以及使用多个代理的异步学习方法(Mnih等人,2016年). 彩虹DDQN(Hessel等人,2017年)结合了几个DQN扩展:双DQN、优先体验回放、决斗网络、多步骤引导目标、噪音网络(Fortunato等人,2018年)它将噪声注入网络的权重以供探索,并将分布DQN建模为期望值为行动值的分布。Ape-X DDQN公司(Horgan等人,2018年)是一种分布式DQN体系结构,在该体系结构中,分布式参与者与价值学习者分离,它采用双DQN、决斗网络体系结构、分布式优先体验回放和多步骤引导目标。递归重播分布式DQN(R2D2)是一种最先进的分布式体系结构,它在用递归神经网络逼近值函数时,提出了分布式优先体验重播(Kapturowski等人,2019年).

当试图在一类非线性函数(如神经网络)中找到最优Q函数时,学习变得不稳定或在某些情况下不收敛(Tsitsiklis和Van Roy,1997年). 在DQN中,通过一种称为经验重播的启发式方法来稳定学习(林,1993年)以及目标网络的使用。体验回放是一种将时间序列数据保存在称为回放内存的缓冲区中的技术。在经验回放中,使用缓冲区中随机采样的数据执行小批量学习。因此,减少了训练样本之间的相关性,从而稳定了学习。目标网络是一个神经网络,用代表Q函数的神经网络的较慢周期进行更新。通过使用固定目标网络计算目标值,我们可以期望整个学习过程稳定。一般来说,目标网络更新频率越低,学习过程越稳定。例如,埃尔南德斯·加西亚(2019)和Hernandez-Garcia和Sutton(2019年)报告称,将更新频率从2000降低到500,稳步降低了算法的不稳定性。van Hasselt等人(2016)将目标网络的更新频率从10000提高到30000,以减少对行动值的高估。众所周知,使用目标网络技术会中断在线强化学习并减慢学习速度,因为除非更新目标网络,否则不会传播价值(Lillicrap等人,2016年;Kim等人,2019年). 因此,学习所需的样本数量变得极其庞大。

为了稳定DQN中的学习过程,Durugkar和Stone(2017)利用梯度投影技术,提出了约束时间差分(CTD)算法,以防止平均目标值在更新后发生变化。通过Baird反例的收敛性验证了CTD算法(贝尔德,1995年)和网格世界导航任务,尽管CTD算法不需要目标网络。但是,Pohlen等人(2018)和Achiam等人(2019年)表明CTD算法在更复杂的问题中不能很好地工作。Pohlen等人(2018)提出了时间一致性损失(TC-loss)方法,该方法试图通过最小化目标网络的变化来防止每个目标状态-动作对的Q函数发生实质性变化。虽然使用高折扣因子通常会导致错误和不稳定性的传播,结果表明,带TC-loss的DQN即使在高折扣因子下也能稳定学习。

在本研究中,我们重点关注这一问题,并提出了一种实际提高样本效率的方法。在我们提出的方法中,采用标准TD误差进行引导,而学习网络和目标网络的最佳动作值之间的差值作为稳定学习过程的约束。我们称此方法为约束DQN。当Q函数的最大值与目标网络的对应值之间的差值较大时,约束DQN会更保守地更新Q函数,当这个差值足够小时,约束的DQN表现为Q学习的方式。随着学习的进行,约束被激活的次数减少,DQN逐渐接近传统的Q学习。使用此方法,我们期望通过减少更新Q函数的延迟,在学习的早期阶段加快收敛,因为目标值是在不使用目标网络的情况下计算的。此外,我们期望在学习完成时,结果与无约束的Q学习的结果相等。我们将约束DQN应用于几个任务,例如一些Atari游戏和两个分别具有离散状态空间和连续状态空间的控制问题。因此,与DQN相比,约束DQN收敛的样本数更少,并且它对目标网络中更新频率的波动具有鲁棒性。尽管与集成方法(如Rainbow)或分布式方法(如R2D2)相比,仅约束DQN并没有表现出更好的性能,实验结果表明,约束DQN可以作为这些方法的附加组件。

2.背景

在本节中,我们概述了Q学习,它是一种典型的基于值的强化学习方法,是所提方法的基础。这里还讨论了Q学习的变体。

2.1. 强化学习

代理被放置在一个未知的环境中,在每个时间点观察环境的状态,并在所选操作之后收到奖励。将状态映射到操作称为策略。强化学习的目标是确定最佳策略,使代理人能够选择一个行动,使未来获得的预期回报最大化。环境状态表示为秒,代理概率地选择一个操作一基于随机策略π(一∣秒)=优先级(一∣秒). 操作选择后,状态更改为秒'根据转移概率Pr(秒′ ∣s、 一个)因此是一种奖励第页(s、 a,s′)。

当状态转移具有马尔可夫特性时,此问题集称为马尔可夫决策过程(MDP)。另一方面,环境状况秒可以不直接观察到或者可以仅部分观察到。在这种情况下,代理必须预测状态秒根据观察哦。映射时秒到哦是随机的,此问题设置称为部分可观测马尔可夫决策过程(POMDP)。作为POMDP的解决方案,我们使用过去观察的历史哦作为伪状态,然后应用强化学习方法,就像伪状态构成普通MDP一样。最早应用DQN的雅达利游戏是一个POMDP问题,因为当前的游戏屏幕本身无法唯一地代表游戏状态。然而,在Mnih等人(2015),最近的一组连续四次观察结果被用作伪状态,以近似地将Atari游戏作为MDP处理。

2.2. 函数逼近的Q学习

为了说明Q学习和DQN之间的区别,我们在这里简要解释了基本算法。我们定义了一段时间后获得的折扣奖励的总和t吨作为回报R(右)t吨如下:

其中0≤γ<1是未来奖励的贴现率。γ值越小,在不久的将来就越重视奖励。动作值函数(Q函数)定义如下

哪里E类π{…}表示随机策略π下的期望。Q函数问π(s、 一个)代表代理人选择行动时的预期折扣奖励总额一处于状态秒然后根据策略π选择操作。Q函数描述为以下递归公式:

哪里S公司和A类分别是状态集和操作集。从这个公式中,我们可以确定最优策略π下的Q函数*即最优Q函数满足以下方程,即Bellman最优方程:

在Q学习中,通过使用基于经验数据的(1)迭代更新Q函数,Q函数可以随机收敛到问*(s、 一个),因此最优策略可以确定为相对于问*:在实践中,学习代理必须探索环境,因为Q函数不可靠,贪婪行为选择被广泛用作概率选择行为的随机策略一对于输入状态秒更具体地说,ϵ贪婪策略选择在状态下最大化Q函数的操作秒概率为1−ϵ,\1013∈[0,1],并用剩余概率选择一个随机动作。ϵ最初设置为1.0,随着学习的进展逐渐减少,在变成像0.1这样的小值后,它被固定。因此,在学习开始时,随机搜索各种动作,随着学习的进行,根据动作值函数选择性地执行好的动作,动作值函数变得更加可靠。

当状态和作用是离散和有限的时,表示Q函数的简单方法是使用所有状态和作用对的值表。该表被任意初始化,并使用代理体验的数据进行更新,如下所示:

其中,0<α≤1是学习率,学习率越大,新数据对更新的影响越大。利用该学习算法,在随机逼近收敛条件下,Q表收敛到最优Q函数。另一方面,由于这是基于随机近似方法,因此对于所有成对的(s、 一个)是必需的。

在表格Q学习中,当状态或动作空间中的元素数量巨大或状态或动作空间连续时,我们经常将Q函数表示为参数函数问(s、 一个; θ) 使用参数θ,然后根据梯度法更新参数:

这里,“target问“是基于最佳Bellman方程(1)的目标值,计算如下:

Q函数根据其自洽方程进行更新。Q学习是一种自举方法,其中Q函数逼近器回归到目标值,这取决于自身。这意味着当学习网络更新时,目标值会自动更改。因此,当使用非线性函数(如神经网络)进行近似时,由于目标的动态变化,此学习过程变得不稳定,在最坏的情况下,Q函数发散(萨顿和巴托,1998年).

3.Q学习的扩展

3.1. 深度Q网络

为了防止Q函数发散,DQN引入了一个单独的目标网络,它是Q函数的副本,用于计算目标值。在这种情况下,Q函数更新如下:

这里,目标德奎因是由计算得出的目标值

哪里T型(s、 一个)表示目标网络。可以选择三种替代方案来更新目标网络。第一种是定期更新,即目标网络在每个C类满足以下条件时的学习步骤:

其中total_steps表示到目前为止应用于Q函数的更新总数。该方法基于神经拟合Q迭代(Riedmiller,2005年),这是一种采用神经网络的批量Q学习方法。在目标网络的前一次更新到下一次更新的间隔期间,对学习进行监督,其中目标由不可变网络给出T型第二种方法是对称更新,将目标网络作为学习网络进行对称更新,这在双Q学习中引入(van Hasselt,2010年;van Hasselt等人,2016年). 第三种可能的选择是Polyak平均更新,其中目标网络的参数通过学习网络过去参数的加权平均值进行更新,例如,在Lillicrap等人(2016)在我们的实验中,我们使用目标网络的定期更新来检查DQN。

除了使用目标网络外,DQN还使用了先前建议的体验重播(ER)(林,1993),这是一种启发式方法,它临时存储一定数量的步骤中的状态转换记录,并从内存中随机选择一个数据点进行学习,以便通过重用数据降低样本之间的相关性,提高样本效率。具体而言,当代理选择操作时一在一个州秒并获得奖励第页然后状态转变为秒',此数据点(s、 a、r、s')存储在回放存储器中D类用于迷你背带学习。在微型备份学习中,参数根据从回放存储器中随机选择的一定数量的数据点进行更新D类,此过程重复多次。这使得在保持一步马尔可夫特性的同时,可以防止由于数据点之间的相关性而导致的学习停滞。因此,使用ER更新DQN的规则如下所示

其中(s、 a、r、s′) ~U型(D类)表示经验丰富的样本(s、 a、r、s′)从回放缓冲区中随机均匀绘制D类。DQN的学习过程比Q学习过程更稳定,因为DQN更新规则在以下时间之间引入了延迟问(s、 一个; θ) 更新以及更新时间T型(s、 一个)已更新。尽管目标网络的使用对稳定学习至关重要,但由于这种延迟,它阻碍了快速学习。

3.2. 技术与DQN

在DQN工作之后,进行了额外的修改和扩展,以提高DQN的速度或稳定性。一个是决斗网络架构(Wang等人,2016年)它有一个神经网络结构,由两部分组成,用于产生状态值函数的单独估计V(V)(秒)和优势函数A类(s、 一个). 更具体地说,动作值函数被分解为

其中θV(V)和θA类分别是状态值函数和优势函数的参数,θ={θv(v), θA类}. 实验表明,决斗网络结构比传统的单流网络结构收敛得更快(Wang等人,2016年;Tsurumine等人,2019年).

另一个重要的技术进步是基于熵的正则化(Ziebart等人,2008年;Mnih等人,2016年)已经证明,通过将策略熵添加到奖励函数中,可以提高探索性和鲁棒性。熵的作用是阻止过早的趋同,并鼓励政策将概率集中于所有行动。软Q学习(Haarnoja等人,2017年)是一种最大化熵正则化期望报酬目标的非策略算法,其更新规则由下式给出

where目标SQL语言是软Q学习的目标值,由

这里,β是一个预定义的超参数。注意,ln∑exp()是最大函数的平滑替代,软Q学习(6)的目标值收敛于DQN(3)的目标,为β→∞。

3.3. 时间一致性损失

Pohlen等人(2018)指出当贴现因子γ接近1时,DQN仍然不稳定,因为无报酬后续状态之间的时间差趋于~0。这也使得学习过程不稳定,尤其是在长时间MDP中,因为在时间相邻的目标值之间会发生不必要的泛化。Fujimoto等人(2018)指出当γ较大时,目标值的方差会随着每次更新而快速增长。为了解决这个不稳定性问题,Pohlen等人(2018)添加了以下称为时间一致性(TC)损失的辅助损失函数:

哪里虽然原始论文中采用了Huber损失,但本文使用L2损失对不同方法进行了公平比较。使用TC-loss更新DQN的规则如下所示

其中λ是预定义的正超参数。请注意Pohlen等人(2018)将TC-loss与转换后的Bellman算子结合使用,减少了目标的规模和方差,而不是将奖励分布限制在区间[-1,1];然而,我们没有采用转换后的Bellman算子,因为学习算法的超参数应该针对每个任务单独调整。

4.受限DQN

DQN使用目标网络计算更新Q函数所需的目标。目标网络T型与Q功能同步问在每一个学习步骤。尽管这种启发式方法成功地稳定了学习过程,但学习通常很耗时,因为除非更新目标网络,否则不会传播价值。

在本研究中,我们提出了约束DQN,它不仅用电流计算目标问与传统Q学习的情况一样,但也基于电流之间的距离限制参数更新问并将目标网络作为稳定学习的一种方式。当Q函数和目标网络的输出差异较大时,约束DQN会保守地更新其参数,就像DQN的情况一样,但当输出差异较小时,它会积极地更新参数,就像传统Q学习的情况一样。

在约束DQN中,考虑了以下与TC-loss类似的损失函数:

哪里。等式(7)和(8)之间的区别在于,我们的损失函数考虑了学习网络的最大值,而TC-loss使用目标网络的值。当满足以下约束时,约束DQN通过标准Q学习算法(2)更新参数:

其中η是约束的正阈值。否则,损失函数(8)最小化。因此,受约束DQN通过以下方式更新参数

哪里我(秒′,一*; θ、 η)是正则化项的梯度,定义为

如果满足约束条件,则我(秒′,一*; θ、 η)=0,约束DQN的更新规则与带经验重放的Q学习的更新规则相同。与定期更新的DQN类似,目标网络在每个C类学习步骤。

约束DQN可以与前面描述的技术一起使用。当目标值由以下公式计算时

更新规则被解释为约束软Q学习,也可以被视为带有不等式约束的软Q学习(9)。

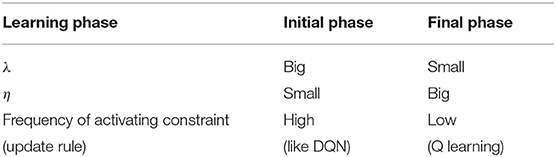

表1给出了每个学习阶段和超参数的约束激活频率。随着学习的进展和接近收敛,Q函数和目标网络之间的差异往往很小,因此激活约束的频率降低,更新规则接近普通Q学习。随着λ值的增加,约束项的影响增加,因此更新规则变得像DQN一样保守。随着η值的增加,激活约束变得更加困难,因此更新规则接近于普通Q学习的规则。

5.实验结果

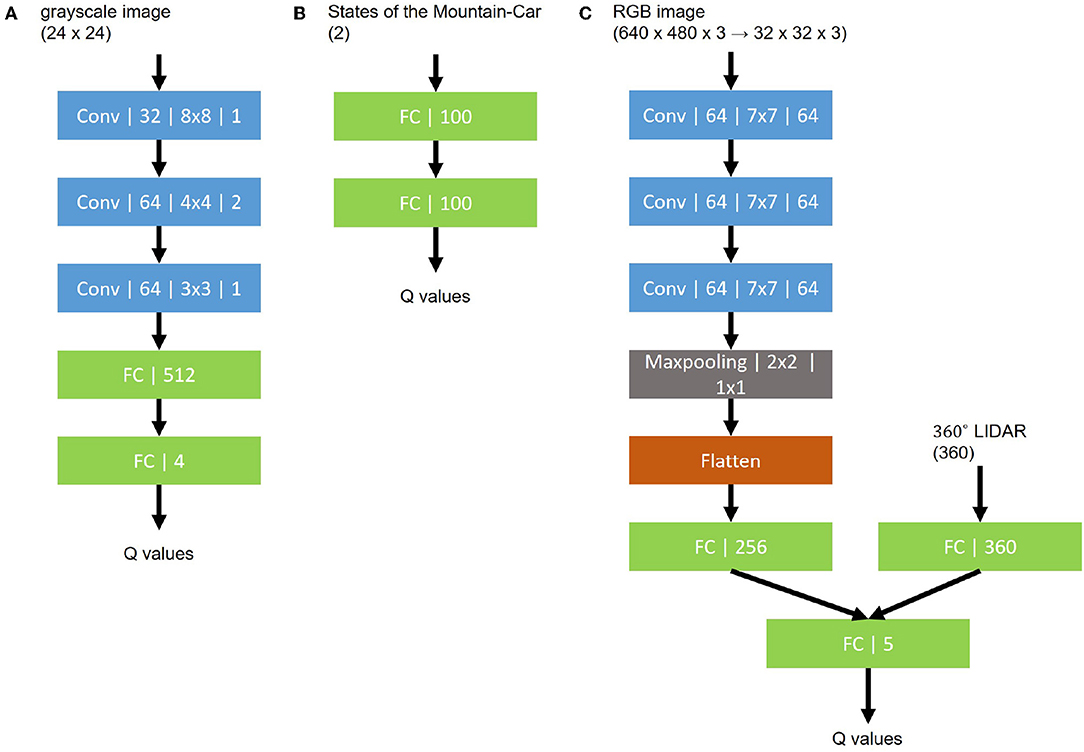

在本节中,我们比较了所提出的方法和使用MNIST迷宫任务、基于OpenAI Gym的Mountain-Car任务的传统方法(Brockman等人,2016年),一个机器人导航任务,以及两个雅达利游戏。MNIST迷宫、Mountain-Car和机器人导航的状态空间分别是灰度图像、二维连续实值向量以及RGB图像和360维LIDAR向量的串联。稍后将解释Atari游戏的状态空间。

5.1. MNIST迷宫

5.1.1. 任务设置

MNIST迷宫是一个3×3迷宫(Elfwing等人,2016年)平铺来自MNIST数据集的手写数字图像,如所示图1迷宫中的图像是从MNIST中随机抽取的,但每个迷宫方块上的数字对于所有学习片段都是固定的。代理的初始位置是“1”(迷宫的左上角)。在每个步骤中,代理都会观察其所在的图像,然后根据其观察结果根据行为策略选择向上、向下、向左或向右的动作。然后,代理以确定的方式向其选择的方向移动;然而,不可能穿过粉色的墙,因此,如果代理选择穿过粉色墙的方向,移动将被忽略,代理位置也不会改变。如果代理越过绿线达到“5”而没有穿过任何红线,则会获得+1奖励,如果代理越过红线达到“五”,则会得到-1奖励。当代理达到“5”时,或者当代理执行了1000个行为步骤而没有达到“5”时,该事件结束。在后一种情况下,将给予0的奖励。该任务需要MNIST手写字符识别和基于强化学习的迷宫搜索。

我们将Q学习、DQN、DQN+TC-loss和约束DQN应用于这项任务以进行比较。我们使用了由三个卷积层和两个完全连接层组成的网络架构,如所示图2A。输入维度与MNIST图像相同,输出维度为4,表示此任务中可能的操作数。根据贪心方法,在前1000步中减少了贪心。我们设置其他参数,例如重播内存的大小和优化器RMSProp的参数[更具体地说,RMSPropGraves(格雷夫斯,2013)中描述的附录],到DQN中使用的(Mnih等人,2015年). 对于超参数,λ设置为0.5、1、2或5,η设置为10−2, 10−3, 10−4, 10−5, 10−6,或0。在单个NVIDIA Tesla K40 GPU上进行每种设置的培训大约需要4小时。

5.1.2. 结果

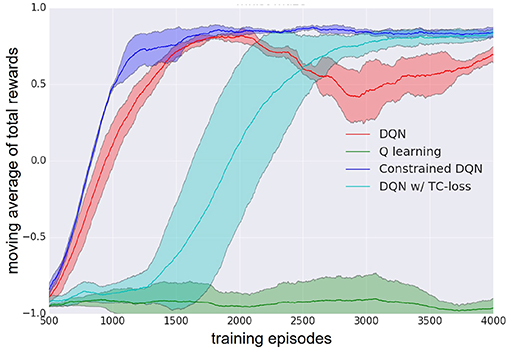

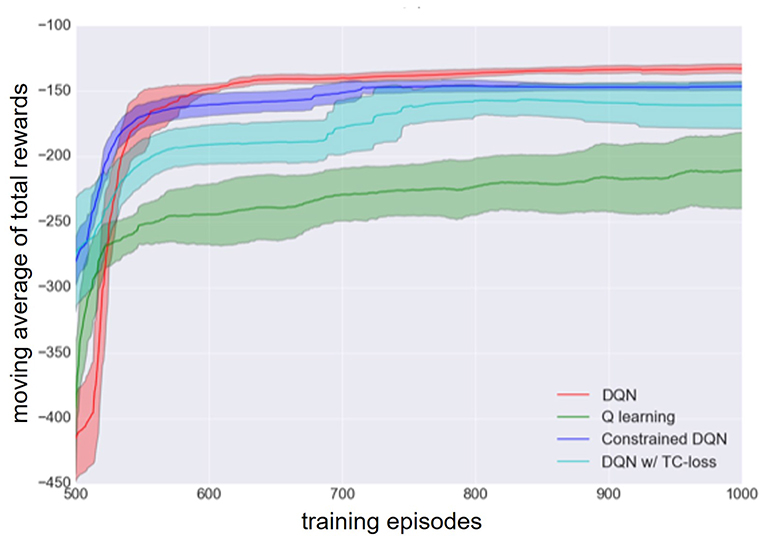

图3给出了Q学习、DQN、带TC-loss的DQN和约束DQN的学习曲线。约束DQN的最佳超参数为λ=2,η=10−5、和C类=10,具有TC-loss的DQN的值为λ=1C类=10000,DQN的值为C类= 10, 000. 我们发现,约束DQN中收敛所需的样本数量小于基线中的样本数量。我们还发现,在大约2000次训练之后,DQN的学习曲线不稳定。带TC-loss的DQN产生了一条稳定的学习曲线,但它的学习速度比DQN或约束DQN慢得多。我们没有发现Q学习在MNIST迷宫任务中起作用。请注意,我们一直使用相同的网络架构,包括CNN,甚至在Q学习的情况下也是如此。

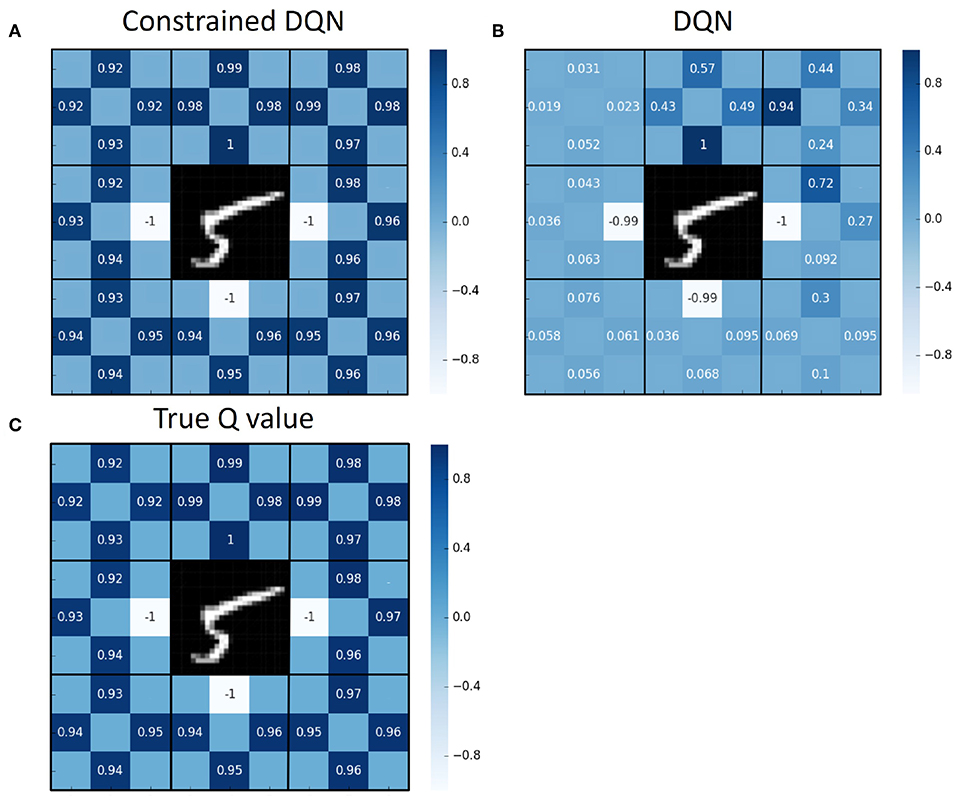

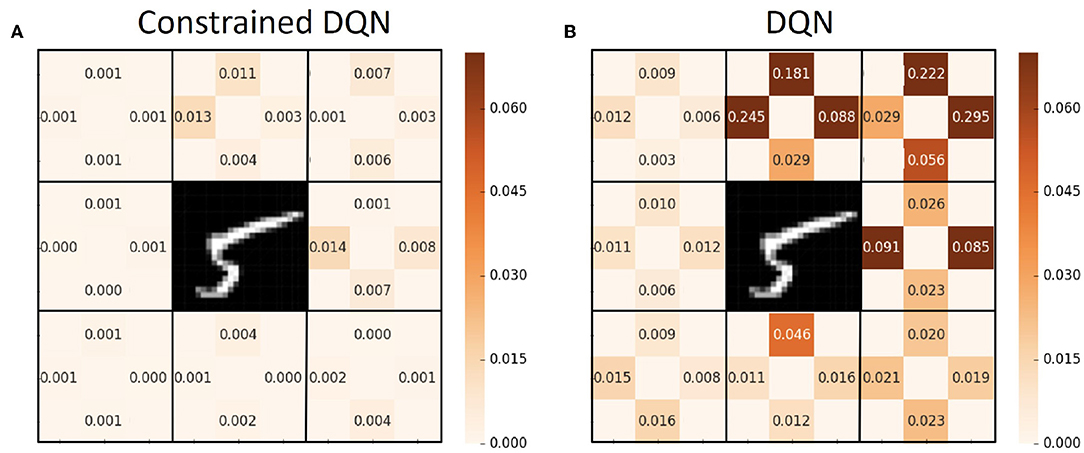

图4显示50000个学习步骤后的平均Q值,以及每个状态和动作对的真实Q值。我们执行了100个片段进行评估,每个状态和动作对都显示了这些片段的平均Q值。这里,我们通过完整的动态规划获得了真实的Q值。图5说明了50000个学习步骤后Q值的变化。这些数字表明,约束DQN估计的平均Q值与真实Q值几乎相同,并且约束DQNQ估计的Q值的方差小于DQN。虽然DQN获得的学习策略是最优的,但估计的Q函数与真实的Q函数相差甚远。

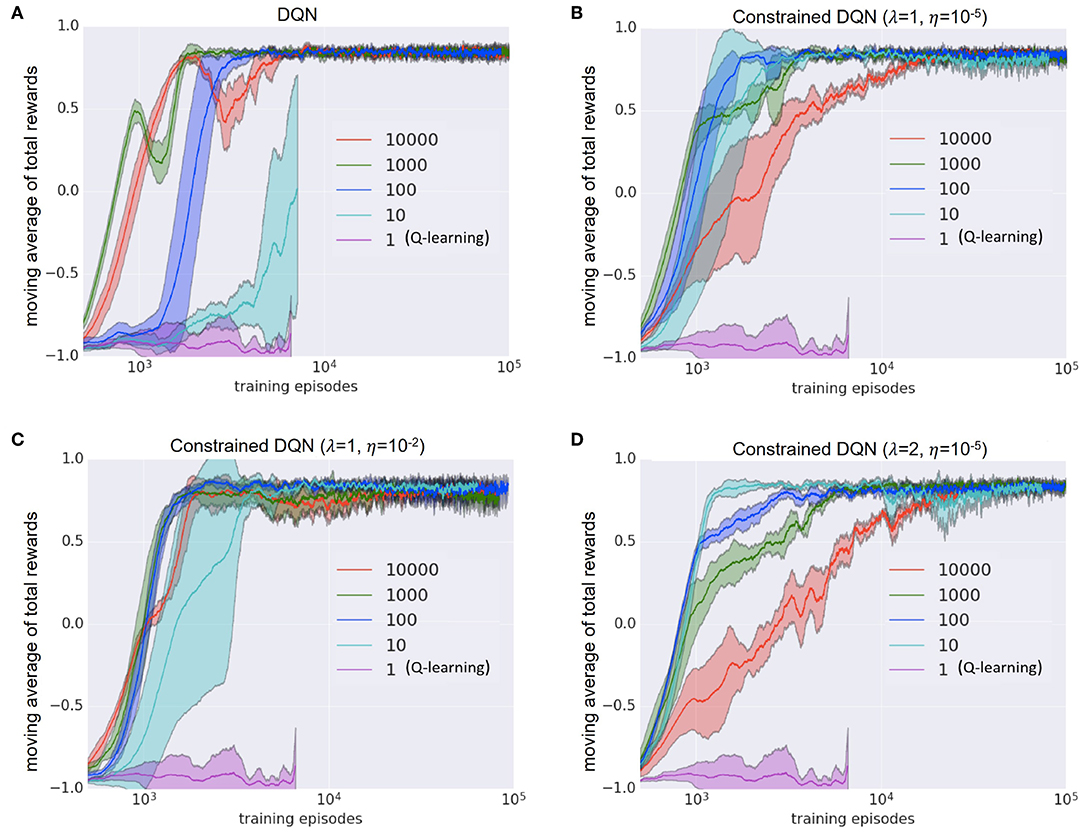

图6给出了更改目标网络更新频率时的结果。我们使用三个超参数设置检查了DQN和我们的约束DQN。当目标网络的更新频率为一个学习步(即Q学习)或10个学习步时,DQN不收敛,但当目标网络每10个学习步骤更新一次时,无论λ和η的设置如何,约束DQN收敛。由于Q学习进展不好,每集的平均步数很大;这就是为什么即使在100万步的后期,剧集数也小于10000集的原因。从这个结果来看,我们认为约束DQN比DQN对目标网络更新频率的变化更鲁棒。

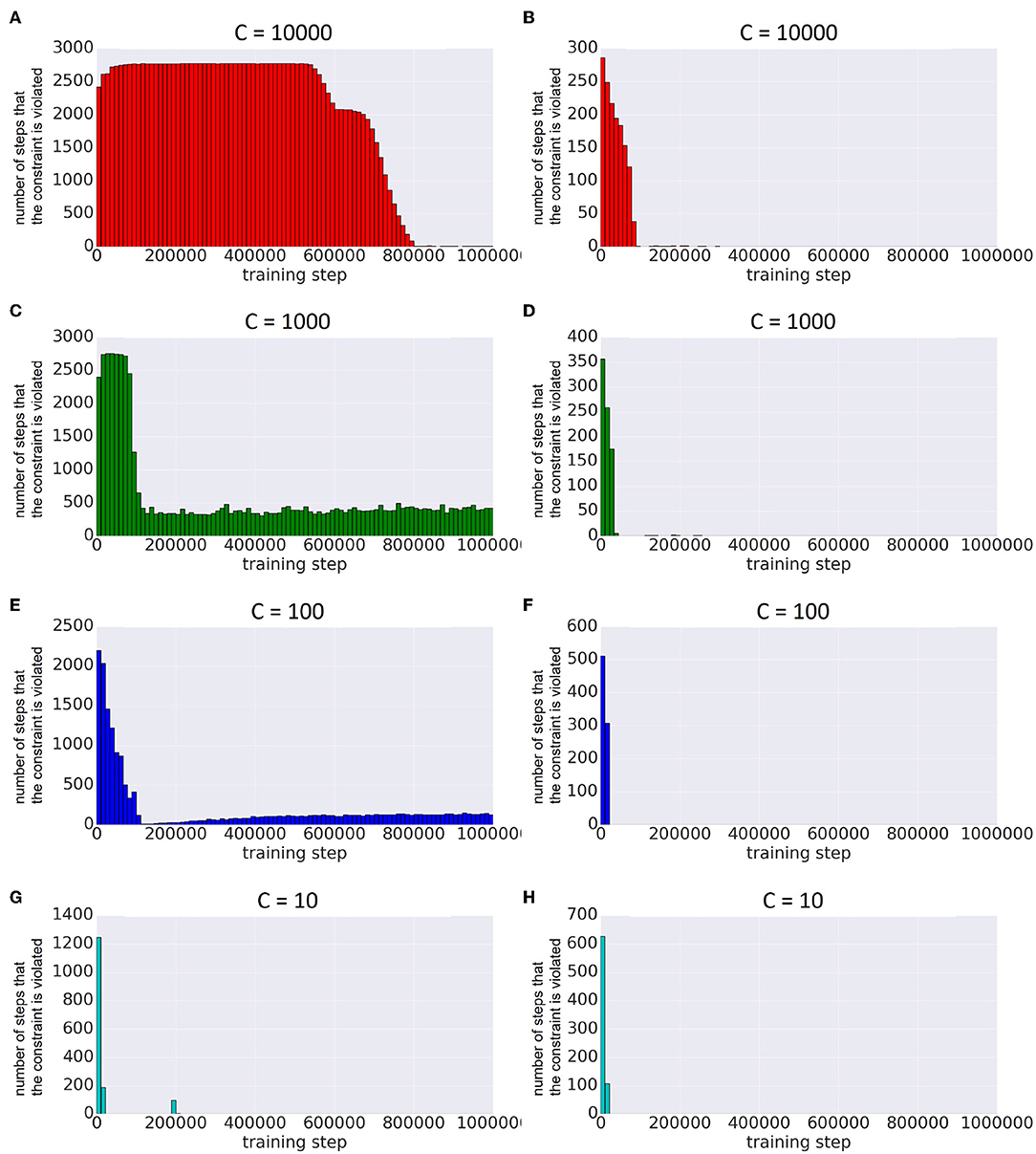

图7显示了约束DQN沿学习步骤激活约束的次数。该图显示了超参数η的两种不同设置的结果。在这两种情况下,约束在学习的早期阶段被多次激活,但随着学习的进展,激活的次数减少。从这个结果可以清楚地看出,约束在早期学习阶段是有效的,并且学习相当于后期的无偏Q学习。当η较大时,很容易满足约束:η越小,约束越被激活。

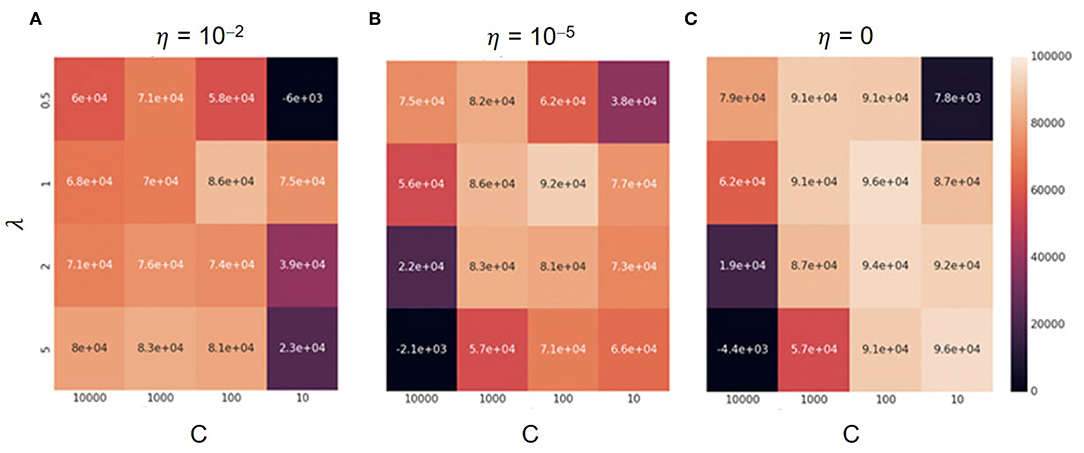

图8是在学习过程中,λ、η的每个组合所获得的奖励总和的热图,以及约束DQN中目标网络的更新频率。当目标网络的更新频率较大时,Q函数与目标网络之间的平方距离可能较大。在这种情况下,约束经常被激活,导致收敛延迟,特别是当阈值η较小时。另一方面,当更新频率较小时,平方距离几乎不会增加,特别是当η较大时。在这种情况下,即使在学习的早期阶段,更新方法也接近于传统Q学习,这使得学习不稳定。然而,当λ=1时,无论超参数设置如何,结果都相当好。

5.2. 山地车

5.2.1. 任务设置

山地车是一项经典的控制任务,它经常用于评估强化学习算法。代理人(即汽车)旨在实现固定目标x个从固定起始位置=0.5(坡顶)x个=−0.5(几乎位于山谷底部)。该代理可以观察其当前位置和速度。位置限制在范围[−1.2,0.6],速度限制在范围[−0.07,0.07],时间被离散化。每个离散时间的可用动作包括“左加速度”(一=0),“无加速度”(一=1)和“右加速度”(一= 2). 确定行动后(一),速度计算如下:

哪里v(v)是速度和x个是位置。即使代理继续从起始位置选择“右加速”,代理也无法达到目标,因为运动能量不足。要达到目标,代理必须先选择“左加速”,并在左侧斜坡上积累足够的势能,然后转化为运动能量,爬上右侧的山丘。代理在每个离散的时间步长都会获得-1的奖励。如果代理人达到了目标,这一集就结束了;也就是说,该问题被定义为一个随机最短路径问题。

我们将Q学习、DQN、DQN+TC-loss和约束DQN应用于该任务并进行了比较。我们使用的网络架构由两个完全连接的层组成,如图2B。输入维度为2,即当前位置和速度,输出维度为3,对应于可能的操作数。根据贪婪方法,在前10000步中减少了ϵ,然后固定为一个常量值。我们将重播内存大小设置为10000,目标网络更新频率设置为100,λ设置为2,η设置为10−3。我们将其他参数,如RMSProp参数(ξ除外)设置为DQN中使用的参数(Mnih等人,2015年). 在标准多核CPU(16核/32线程、2.4 GHz和256 GB RAM)上训练每种方法大约需要6小时。

5.2.2. 结果

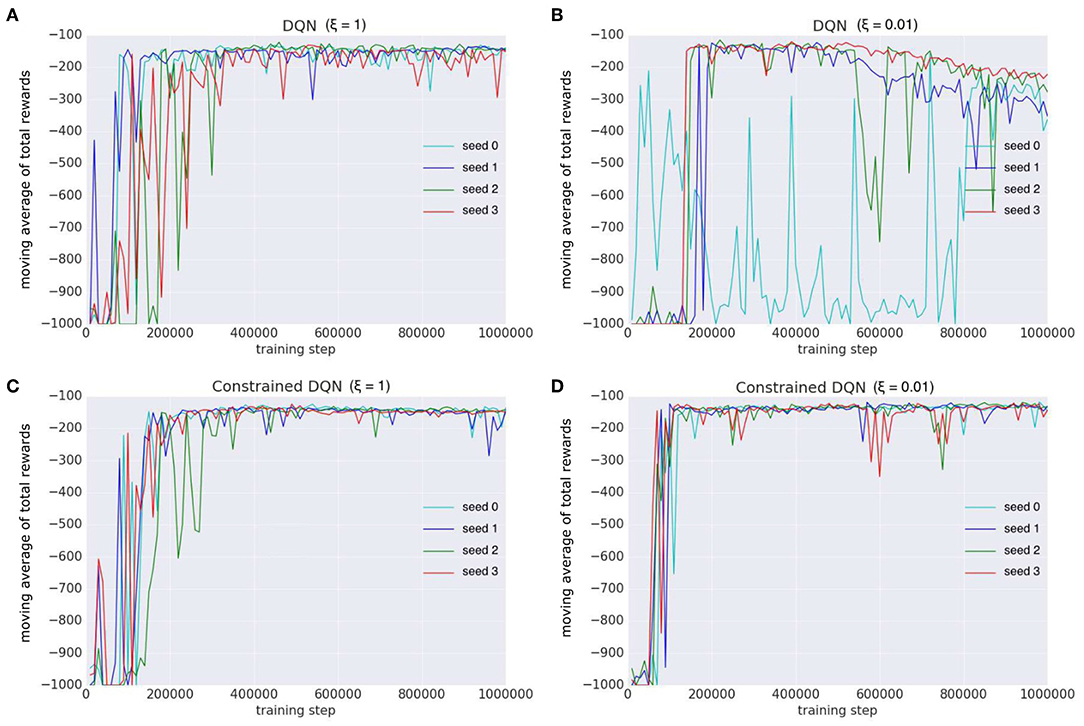

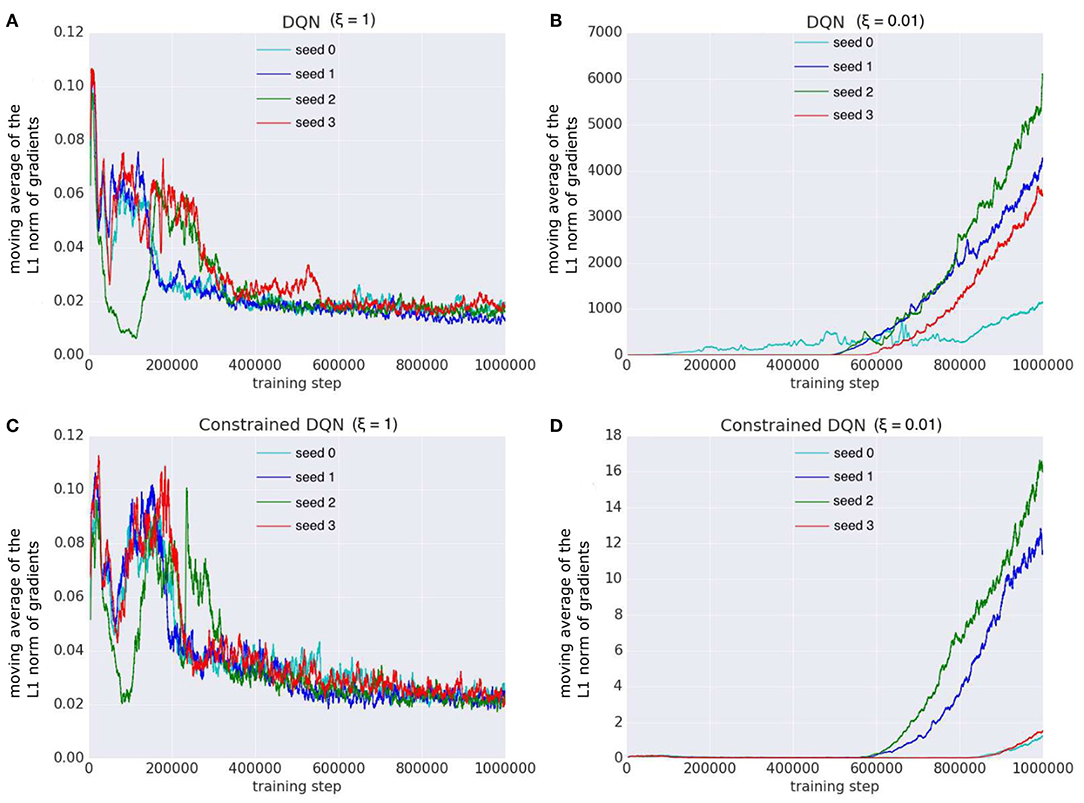

图9显示了Q学习、DQN、带TC-loss的DQN和约束DQN的学习曲线。我们对每个算法进行了四次独立运行。除DQN外的线表示四个独立运行的移动平均值。一次运行DQN被排除在外,因为它无法学习。我们发现,在TC损失和Q学习方面,约束DQN比DQN表现更好,并且学习速度比DQN快,尽管其性能低于DQN。与Q学习相比,带TC-loss的DQN收敛更快,学习更稳定。虽然DQN获得了最高的总回报,但其学习过程并不稳定。图10显示了DQN和约束DQN的学习曲线,其中两个不同的ξ设置是RMSProp参数之一。我们观察到,对于ξ的两种设置,约束DQN中收敛所需的样本数小于DQN。我们还可以观察到,当ξ=0.01时,原始DQN在达到暂时收敛后不稳定甚至退化。另一方面,我们的约束DQN表现出了相对良好的稳定性。DQN与TC-loss和Q-learning的学习曲线如所示图S1.

图11显示了在学习过程中最后一个完全连接层的梯度的L1-形式是如何变化的。当ξ=1时,在原始DQN和约束DQN中,参数更新的次数很少。另一方面,当ξ=0.01时,原始DQN的更新次数远大于约束DQN。我们认为这是原始DQN不稳定的原因。因为目标值是固定的C类在原始DQN的学习步骤中,梯度方差在C类步骤,使其非常小,尤其是在C类步骤。另一方面,由于约束DQN中的目标值每一步都在变化,因此在整个学习过程中梯度的方差平稳地变小。ξ仅在梯度方差很小时才起作用。在这种情况下,ξ越小,参数更新的次数就越大。因此,人们认为在最初的DQN中,ξ工作得太频繁,因此产生的大量更新使学习不稳定。实际上,如果ξ较小(ξ=0.01),DQN学习是不稳定的。另一方面,无论ξ的设置如何,约束DQN都更加稳健,因为梯度方差在整个学习过程中平稳下降。

5.3. 机器人导航任务

5.3.1. 任务设置

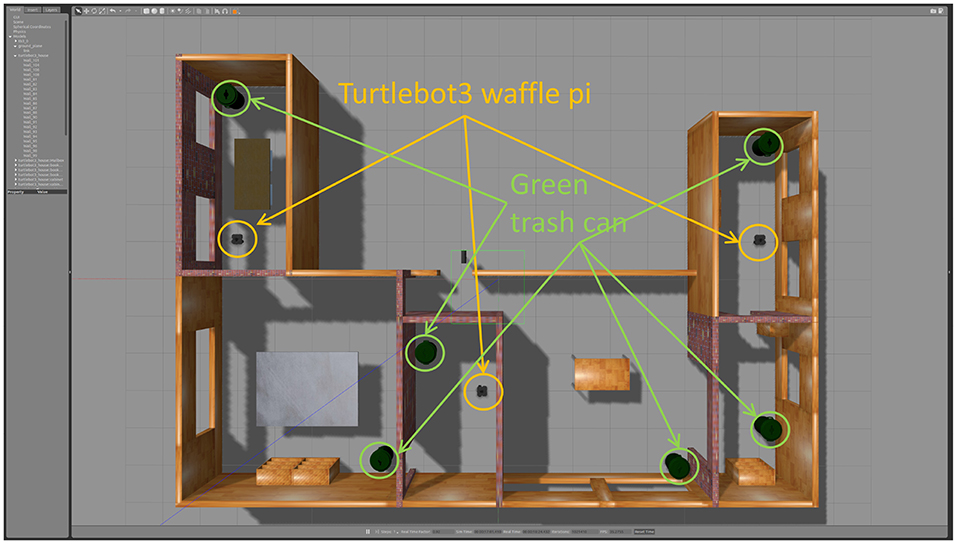

约束DQN在机器人导航任务上进行评估,如所示图12,其中环境模型由任务的官方网站提供(机器人电子手册,2019年). 环境由六个房间组成,其中有六个绿色垃圾桶、三张桌子和三个书架。我们使用配备360°激光雷达的Turtlebot 3 waffle-pi平台。机器人每一步都有五个可能的动作:(1)向前移动,(2)左转,(3)右转,(4)左转和(5)右转。目标是导航到放置在环境中的一个绿色垃圾桶。机器人到达垃圾桶时获得+10的正奖励,但碰到障碍物时获得-1的负奖励。如果机器人碰到障碍物,它将保持在当前位置。如果机器人到达垃圾桶,机器人的位置将在环境中随机重新初始化。

我们应用了Q学习、DQN、带TC-loss的DQN,双DQN(DDQN)、软Q学习(SQL)和约束DQN。Q函数由如下所示的两流神经网络实现图2C,其中输入是RGB图像和LIDAR测量的值,输出是表示动作值的五维向量。为了有效地收集经验,我们使用了三个共享Q函数的机器人,即从Q函数派生的一个贪婪策略独立控制三个机器人,它们收集发送到回放缓冲区的经验。从这个意义上说,这是大规模分布式优化的简化实现,众所周知,这种优化可以加速价值学习(Levine等人,2016年). 我们对每种方法进行了五次独立运行。每次跑步包括100集,每集最多有10000步。回放缓冲区的内存大小为30000步。目标网络每3000步更新一次。训练批大小为32,从内存缓冲区均匀采样。超参数为α=0.01,γ=0.99,ε=0.1,β=10。我们使用Ubuntu Linux 16.04 LTS作为操作系统,使用NVIDIA专有驱动程序的375.66版本以及CUDA Toolkit 8.0和cuDNN 6。在一台NVIDIA Tesla P100 GPU上进行一次训练大约需要1天。

5.3.2. 结果

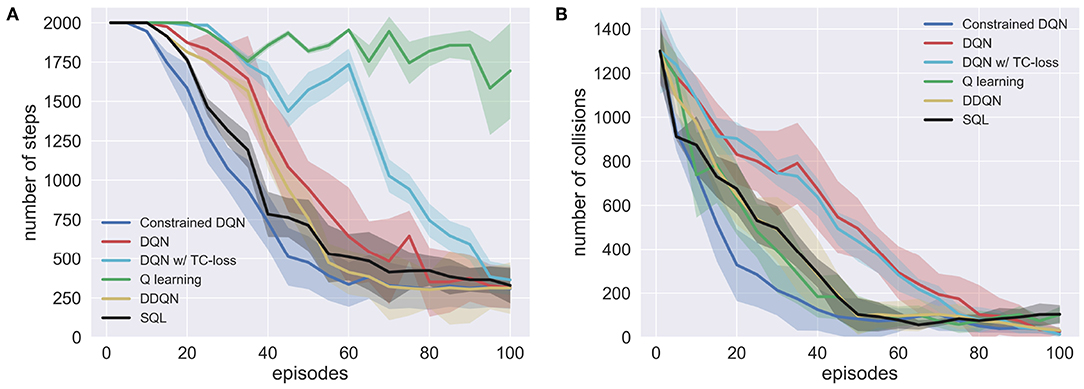

由于奖励有两个来源,经验是由多个机器人异步收集的,因此我们通过执行贪婪策略每五集评估学习的Q函数。图13显示了前往其中一个绿色垃圾桶的步骤数和碰撞次数。这表明约束DQN在这里比较的方法中获得了几乎最少的步骤、最低的碰撞率和最快的学习收敛性。虽然有和没有TC-loss的DQN的步长没有太大差异,但DQN比有TC-lossDQN减少的步长更快。Q学习学习防撞行为的速度比DQN快,但它完全没有学会靠近垃圾桶。DDQN在节目结束时的表现与约束DQN相当,但DDQN的学习速度相对较慢。

5.4. Atari游戏公司

最后,我们研究了约束DQN是否可以与有用的现有技术相结合来提高样本效率。在这里,我们研究了两种技术。一种是决斗网络结构,另一种是基于熵的正则化。

5.4.1. 任务设置

我们在两个Atari 2600游戏中评估了Constrained DQN,即Pac-Man女士和Seaquest,这两个游戏也由Pohlen等人(2018)Pac-Man女士的目标是通过吃小球来赚取积分,同时避免鬼魂。Seaquest是一款水下射击游戏,其目标是摧毁鲨鱼和敌方潜艇,以营救海上潜水员。在这些实验中,将约束DQN和带TC-loss的DQN作为标准算法进行评估。对于每种算法,选择决斗网络结构和熵正则化来检查约束DQN是否可以与开发用于改进学习过程的这些有用技术一起使用。因此,我们在Atari游戏中应用了六种算法。注意,带熵正则化的TC-loss和带对偶网络架构的TC-los分别与带TC-los斯的软Q学习和带TC-los的对偶DQN相同。

虽然最初的游戏是确定性的,但通过在初始化时执行随机数目的no-op操作,增加了随机性,从而给启动状态带来了不确定性。我们使用的网络架构与Mnih等人(2015)对于标准算法和具有熵正则化的算法,以及Wang等人(2016)针对具有决斗网络架构的算法。每个时间步的输入都是当前帧的预处理版本。预处理包括灰度缩放、按因子2向下采样、将游戏空间裁剪为80×80的正方形并将值归一化为[0,1]。我们将四个连续的帧堆叠在一起,作为网络的状态输入,并将奖励剪辑为范围[-1,1]。我们采用了优化器和超参数Pohlen等人(2018)熵正则化的β=1。

5.4.2. 结果

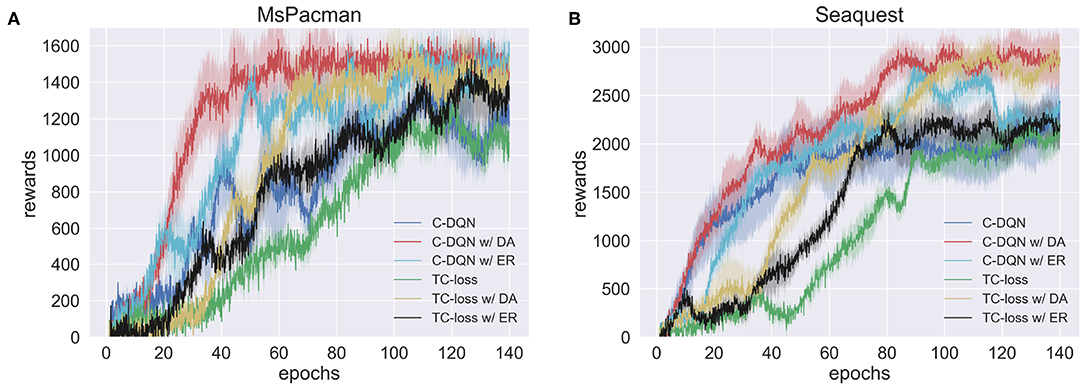

图14结果表明,在这两款游戏中,采用决斗网络结构的约束DQN比其他方法更快地获得更高的奖励。在学习的早期阶段,具有熵正则化的约束DQN的学习速度与具有决斗网络架构的约束DQN的学习速度相当,但其学习过程在PacMan女士身上不太稳定。然而,熵正则化的使用并没有提高Seaquest的性能,并且在学习结束时,它获得了与常规约束DQN几乎相同的性能。这可能是因为熵正则化的超参数β在学习期间是固定的。

实验结果还表明,TC-loss及其变体的性能比相应的约束DQN差。在学习结束时,具有决斗网络架构的TC-loss的性能与约束DQN的性能相当,但需要更多时间才能收敛。

6.讨论

我们进行了四种任务的实验,包括MNIST迷宫、山地车、机器人导航和两个Atari游戏。通过这些实验,我们证明了约束DQN比有无TC-loss和Q学习的DQN收敛的样本更少,此外,约束DQN对目标更新频率的变化和优化器的重要参数(即ξ)的设置更具鲁棒性。

由于该方法是DQN的正则化方法,因此可以更有效地解决DQN应用到的任何问题。Atari游戏的实验结果表明,约束DQN可以与决斗网络结构和熵正则化一起使用。我们认为,受限DQN可以与使用目标网络的其他技术相结合,例如改进的经验回放技术(Schaul等人,2015年;Andrychowicz等人,2017年;Karinpanal和Bouffanais,2018年),噪声的参数函数(Fortunato等人,2018年;Plappert等人,2018年)和修改的Bellman运算符(Bellemare等人,2016年;Pohlen等人,2018年). 建议将Rainbow约束DQN和Ape-X约束DQN分别视为Rainbow DDQN的替代方案(Hessel等人,2017年)和Ape-X DQN(Horgan等人,2018年),其中DDQN替换为约束DQN。最近,van Hasselt等人(2019年)研究表明,数据高效的Rainbow在Atari游戏中广泛使用回放缓冲区来训练和改进强化学习代理,其表现优于基于模型的强化学习。他们的研究令人印象深刻,因为在实现过程中不需要更改算法。在相同的van Hasselt等人(2019年).

然而,将约束DQN与DDQN及其扩展(称为加权双Q学习)集成并非易事(Zhang等人,2017)因为在这些方法中,目标网络用于将最大操作分解为操作选择和操作评估。为了减少高估的问题,mellowmax运算符(Kim等人,2019)很有希望,这是软Q学习的一种变体。

快速Q学习(Azar等人,2011年)基于与我们的研究相似的想法。快速Q学习使用当前Q函数输出与上一步Q函数输出之间的差异作为约束。由于该方法的作者只研究了离散状态空间的任务,人们可能会怀疑它是否可以应用于函数逼近的学习。在我们的研究中,使用深度/浅层神经网络进行函数逼近,从而可以通过离散状态空间和连续状态空间的任务验证结果。He等人(2017)是向Q学习添加约束的另一种方法。在这种方法中,将累积奖励添加到存储在回放存储器中的数据中,以便在每个学习步骤中估计Q函数的上限和下限。平均DQN(Anschel等人,2017年)与我们的方法类似,因为这两种方法都使用过去的Q函数。平均DQN使用过去几个步骤的Q函数来计算其输出,即动作值,作为过去Q函数的输出的平均值。这种平均方法可以有效地减少近似误差的方差,从而稳定学习。这种方法的一个可能缺点是需要维护多个Q函数,这些函数通常表示为代价高昂的神经网络。另一方面,我们的方法只需要两个网络,即当前的Q函数和目标网络,就像DQN一样,因此参数的数量不太大。

7.结束语

在本研究中,我们提出了约束DQN,它利用当前Q函数和目标网络输出之间的差异作为约束。基于几个实验,包括离散状态空间MNIST迷宫、连续状态空间Mountain-Car、模拟机器人导航任务和两个Atari游戏,我们表明约束DQN比基线需要更少的样本来收敛。此外,与DQN相比,所提出的方法对目标网络的更新频率和重要优化器参数(即RMSProp的ξ)的设置的变化更具鲁棒性。

本研究中使用的几个任务有一个离散的动作空间,但所提出的方法可以与适用于具有连续动作空间的问题的其他方法相结合,例如深度确定性策略梯度(Lillicrap等人,2016年)和归一化优势函数(顾等人,2016). 如果所提出的方法还可以减少连续动作空间问题中的样本数量,那么它将适用于广泛的应用,例如机器人控制和自动驾驶,因为现实世界的应用在收集足够数量的样本以训练深度强化学习者方面涉及到复杂性。

本研究未来可能的方向包括以下方面。虽然我们已经在实验中证明了我们提出的方法是有效的样本,但我们还没有建立任何理论上的理由使约束DQN能够正常工作。最近,对DQN进行了理论分析(Yang等人,2019年)和保守值迭代(Kozuno等人,2019年). 为了更好地理解约束DQN,我们将建立算法和统计收敛速度。此外,在本研究中,超参数λ固定在启发式值,但λ也可以在约束优化的公式下进行优化;我们可以期望通过应用此扩展来提高性能。

作者贡献

SO和EU构思了这项研究。SO、EU、KN、YYas和SI开发了该算法。SO和YYam进行了计算机模拟。SO、YYam和EU分析了数据。于是起草了草案。SI和欧盟修改了手稿。所有作者都准备了提交的版本。

基金

这项工作基于新能源和工业技术发展组织(NEDO)委托的一个项目的结果,并得到了JSPS KAKENHI拨款编号JP16K12504、JP17H06042和19H05001(欧盟)以及JP17H006310和JP19H04180(SI)的部分支持。计算机资源由本田研发有限公司提供。

利益冲突

SO、EU、KN和YYas分别受雇于松下有限公司、ATR计算神经科学实验室、本田研发有限公司和本田研发公司。SI部分由ATR计算神经科学实验室使用。这些公司在商业或财务上相互独立。

另一位作者声明,该研究是在没有任何可能被解释为潜在利益冲突的商业或金融关系的情况下进行的。

补充材料

本文的补充材料可以在以下网站上找到:https://www.frontiersin.org/articles/10.3389/fnbot.2019.00103/full#补充-材料

工具书类

Achiam,J.、Knight,E.和Abbeel,P.(2019年)。深入Q学习中的差异表征。arXiv[前置]。arXiv:1903.08894。

谷歌学者

Andrychowicz,M.、Wolski,F.、Ray,A.、Schneider,J.、Fong,R.、Welinder,P.等人(2017年)。中的“后视体验重播”神经信息处理系统进展,第30卷编辑:I.Guyon、U.V.Luxburg、S.Bengio、H.Wallach、R.Fergus、S.Vishwanathan和R.Garnett(加州长滩:Curran Associates,Inc.),5048–5058。

谷歌学者

Anschel,O.、Baram,N.和Shimkin,N.(2017年)。“平均-DQN:深度强化学习的方差减少和稳定”,in第34届国际机器学习大会论文集(新南威尔士州悉尼),176-185。

谷歌学者

Azar,M.G.、Munos,R.、Ghavamzadeh,M.和Kappen,H.J.(2011年)。中的“快速Qlearning”神经信息处理系统进展,第24卷,eds J.Shawe-Taylor、R.S.Zemel、P.L.Bartlett、F.Pereira和K.Q.Weinberger(格拉纳达:Curran Associates,Inc.),2411-2419。

谷歌学者

Baird,L.(1995)。《剩余算法:函数逼近强化学习》,in第十二届机器学习国际会议论文集(魁北克省蒙特利尔市),30–37。doi:10.1016/B978-1-55860-377-6.50013-X

CrossRef全文|谷歌学者

Bellemare,M.G.、Ostrovski,G.、Guez,A.、Thomas,P.S.和Munos,R.(2016)。《增加行动差距:强化学习的新操作员》,in第30届AAAI人工智能会议记录(亚利桑那州凤凰城)。

谷歌学者

Brockman,G.、Cheung,V.、Pettersson,L.、Schneider,J.、Schulman,J.和Tang,J.等人(2016)。OpenAI健身房。arXiv[预打印]。arXiv:1606.01540。

谷歌学者

Durugkar,I.和Stone,P.(2017年)。“带约束梯度的TD学习”,in2017年NIPS深度强化学习研讨会会议记录(加利福尼亚州长滩)。

谷歌学者

Elfwing,S.、Uchibe,E.和Doya,K.(2016)。从自由能到期望能:改进强化学习中基于能量的值函数逼近。神经网络。84, 17–27. doi:10.1016/j.neunet.2016.07.013

PubMed摘要|CrossRef全文|谷歌学者

Fortunato,M.、Azar,M.G.、Piot,B.、Menick,J.、Osband,I.、Graves,A.等人(2018年)。“嘈杂的勘探网络”第六届国际学习代表大会会议记录(不列颠哥伦比亚省温哥华)。

谷歌学者

Fujimoto,S.、van Hoof,H.和Meger,D.(2018年)。“actor-critic方法中的寻址函数近似错误”,in第35届机器学习国际会议论文集(斯德哥尔摩)。

谷歌学者

Graves,A.(2013)。用递归神经网络生成序列。arXiv【预印本】。arXiv:1308.0850。

谷歌学者

Gu,S.、Lillicrap,T.、Sutskever,I.和Levine,S.(2016)。“基于模型加速的连续深度Q-学习”,in第33届机器学习国际会议论文集(纽约州纽约市),2829-2838。

谷歌学者

Haarnoja,T.、Tang,H.、Abbeel,P.和Levine,S.(2017年)。《深度能源政策强化学习》第34届国际机器学习大会论文集(新南威尔士州悉尼),1352-1361年。

谷歌学者

He,F.S.、Liu,Y.、Schwing,A.G.和Peng,J.(2017)。“学会在一天内玩耍:通过优化收紧加快深层强化学习”,in第五届国际学习代表大会会议记录(土伦)。

谷歌学者

Hernandez-Garcia,J.F.(2019年)。统一n步时间差分作用值方法(硕士论文),加拿大埃德蒙顿阿尔伯塔大学统计机器学习科学硕士。

谷歌学者

Hernandez-Garcia,J.F.和Sutton,R.S.(2019年)。理解多步骤深层强化学习:对DQN目标的系统研究。arXiv【预印本】。arXiv:1901.07510。

谷歌学者

Hessel,M.、Modayil,J.、van Hasselt,H.、Schaul,T.、Ostrovski,G.、Dabney,W.等人(2017年)。《彩虹:结合深度强化学习的改进》第32届AAAI人工智能会议记录(洛杉矶新奥尔良)。

谷歌学者

Horgan,D.、Quan,J.、Budden,D.、Barth-Maron,G.、Hessel,M.、van Hasselt,H.等人(2018年)。中的“分布式优先体验重播”第六届学习表征国际会议论文集(不列颠哥伦比亚省温哥华)。

谷歌学者

Kahn,G.、Zhang,T.、Levine,S.和Abbeel,P.(2017年)。“PLATO:使用自适应轨迹优化的策略学习”,inIEEE机器人与自动化国际会议论文集(新加坡),3342-3349。

谷歌学者

Kapturowski,S.、Ostrovski,G.、Quan,J.、Munos,R.和Dabney,W.(2019年)。“分布式强化学习中的重复体验回放”,in第七届学习代表国际会议记录(洛杉矶新奥尔良)。

谷歌学者

Karinpanal,T.G.和Bouffanais,R.(2018年)。使用过渡序列体验重播。正面。神经机器人。21:32. doi:10.3389/fnbot.2018.00032

CrossRef全文|谷歌学者

Kim,S.、Asadi,K.、Littman,M.和Konidaris,G.(2019)。“Deepmellow:在深度Q-learning中消除对目标网络的需求”,in第28届国际人工智能联合会议记录(澳门)。

谷歌学者

Kozuno,T.、Uchibe,E.和Doya,K.(2019年)。“softmax和gap-increased算子在强化学习中的效率和鲁棒性的理论分析”,in第22届国际人工智能与统计会议记录(冲绳),2995-3003。

谷歌学者

Levine,S.、Pastor,P.、Krizhevsky,A.和Quillen,D.(2016)。《通过大规模数据采集学习机器人抓取的手眼协调》实验机器人国际研讨会论文集(东京:施普林格出版社),173-184年。

谷歌学者

Lillicrap,T.P.、Hunt,J.J.、Pritzel,A.、Heess,N.、Erez,T.、Tassa,Y.等人(2016年)。“通过深度强化学习进行持续控制”第四届学习代表国际会议记录(加利福尼亚州圣地亚哥)。

谷歌学者

林林杰(1993)。使用神经网络的机器人强化学习。宾夕法尼亚州匹兹堡卡内基梅隆大学计算机科学学院技术报告。

谷歌学者

Mnih,V.、Badia,A.P.、Mirza,M.、Graves,A.、Lillicrap,T.、Harley,T.等人(2016年)。《深度强化学习的异步方法》第33届机器学习国际会议论文集(纽约州纽约市),1928-1937年。

谷歌学者

Mnih,V.、Kavukcuoglu,K.、Silver,D.、Graves,A.、Antonoglou,I.、Wierstra,D.等人(2013年)。与雅达利进行深度强化学习。arXiv[预打印]。arXiv:1312.5602。

谷歌学者

Mnih,V.、Kavukcuoglu,K.、Silver,D.、Rusu,A.A.、Veness,J.、Bellemare,M.G.等人(2015)。通过深度强化学习进行人性化控制。自然518, 529–533. doi:10.1038/nature14236

PubMed摘要|CrossRef全文|谷歌学者

Plappert,M.、Houthooft,R.、Dhariwal,P.、Sidor,S.、Chen,R.Y.、Chen、X.等人(2018年)。“勘探参数空间噪声”,in第六届国际学习代表大会会议记录(不列颠哥伦比亚省温哥华)。

谷歌学者

Pohlen,T.、Piot,B.、Hester,T.,Azar,M.G.、Horgan,D.、Budden,D.等人(2018年)。观察并进一步观察:在Atari上实现一致的性能。arXiv[预印].arXiv:1805.11593。

谷歌学者

Riedmiller,M.(2005)。《神经拟合Q迭代——首次体验数据高效的神经强化学习方法》第16届欧洲机器学习大会论文集(波尔图:斯普林格),317-328。

谷歌学者

Schaul,T.、Quan,J.、Antonoglou,I.和Silver,D.(2015)。中的“优先体验重播”第四届学习代表国际会议记录(加利福尼亚州圣地亚哥)。

谷歌学者

Silver,D.、Huang,A.、Maddison,C.J.、Guez,A.、Sifre,L.、Van Den Driessche,G.等人(2016年)。通过深度神经网络和树搜索掌握围棋游戏。自然529, 484–489. doi:10.1038/nature16961

PubMed摘要|CrossRef全文|谷歌学者

Silver,D.,Schrittwieser,J.,Simonyan,K.,Antonoglou,I.,Huang,A.,Guez,A.等人(2017年)。在没有人类知识的情况下掌握围棋游戏。自然550, 354–359. doi:10.1038/nature24270

PubMed摘要|CrossRef全文|谷歌学者

Sutton,R.S.和Barto,A.G.(1998年)。强化学习:简介(自适应计算和机器学习系列)。马萨诸塞州剑桥市;伦敦:麻省理工学院出版社。

谷歌学者

Tsitsiklis,J.N.和Van Roy,B.(1997年)。基于函数逼近的时间差分学习分析。IEEE传输。自动。控制42, 674–690.

谷歌学者

Tsurumine,Y.、Cui,Y.、Uchibe,E.和Matsubara,T.(2019)。深度强化学习与平滑的政策更新:应用于机器人布料操作。机器人。自动。系统。112, 72–83. doi:10.1016/j.robot.2018.11.004

CrossRef全文|谷歌学者

van Hasselt,H.(2010)。“双Q学习”,in神经信息处理系统进展,第23卷编辑J.D.Lafferty、C.K.I.Williams、J.Shawe-Taylor、R.S.Zemel和A.Culotta(不列颠哥伦比亚省温哥华:Curran Associates公司),2613–2621。

谷歌学者

van Hasselt,H.、Guez,A.和Silver,D.(2016)。《深度强化学习与双Q学习》第30届AAAI人工智能会议记录第16卷(亚利桑那州凤凰城),2094-2100。

谷歌学者

van Hasselt,H.、Hessel,M.和Aslanides,J.(2019年)。“何时在强化学习中使用参数模型?”神经信息处理系统研究进展第32卷,编辑H.Wallach、H.Larochelle、A.Beygelzimer、F.d'Alché-Buc、E.Fox和R.Garnett(不列颠哥伦比亚省温哥华:Curran Associates公司)。

谷歌学者

Wang,Z.、Schaul,T.、Hessel,M.、Van Hasselt,H.、Lanctot,M.和De Freitas,N.(2016)。《深度强化学习的决斗网络架构》第33届机器学习国际会议论文集(纽约州纽约市)。

谷歌学者

Watkins,C.J.C.H.和Dayan,P.(1992年)。Q学习。机器。学习。8, 279–292.

谷歌学者

Yang,Z.,Xie,Y.和Wang,Z..(2019年)。深度Q学习的理论分析。arXiv[预打印]。arXiv:1901.00137。

谷歌学者

Zhang,Z.,Pan,Z.和Kochenderfer,M.J.(2017)。“加权双Q学习”,in第26届国际人工智能联合会议记录(维多利亚州墨尔本),3455-3461。

PubMed摘要|谷歌学者

Ziebart,B.D.、Maas,A.、Bagnell,J.A.和Dey,A.K.(2008年)。“最大熵逆强化学习”第23届AAAI人工智能会议记录(伊利诺伊州芝加哥),1433-1438年。

谷歌学者

附录

优化器

在本研究中,RMSPropGraves(格雷夫斯,2013)用作优化器。当梯度(f)我关于θ我给定θ我更新如下:

哪里n个我和克我是梯度的一阶矩和二阶矩,ρ和β给出指数衰减率。α表示学习率,Δθ我是θ的更新量我.在(1)中,近似地指梯度方差的移动平均值。当该项很小(很大)时,参数的变化很大(很小)。ξ是防止Δ的较小值我在我们所有的实验中,除非另有说明,否则我们设置α=0.00025,ρ=0.95,β=0.95,ξ=0.01。