1.简介

兴趣是最重要的情感之一,但尚未得到充分研究。兴趣驱动我们的注意力,同时对文化传播起着至关重要的作用(Clément and Dukes,2013年). 我们评价和理解环境的方式深受他人评价的影响。我们利用有关他人兴趣和欣赏的信息建立自己的判断,了解我们所处的社会及其文化价值观。这对于宗教等非常重要的维度来说都是正确的——什么是对的,什么是错的——但对于世俗活动来说——什么是最流行的运动,什么是最受欢迎的歌曲。在较小的范围内,兴趣检测对于从学习到娱乐的大量领域来说都是至关重要的。学习者的情绪状态会影响学习活动的承诺和结果;媒体消费者的兴趣可以预测其未来的偏好。因此,用户兴趣的自动识别具有广泛的应用也就不足为奇了。例如,推荐系统可以使用兴趣级别作为隐含反馈来更新其建议,并提高用户的满意度和参与度。兴趣的非侵入式识别不仅适用于多媒体推荐和检索,例如广告的头像和视线跟踪(Kurdyukova等人,2012年),自动识别教育中的兴趣和无聊(卡普尔和皮卡德,2005年;Jaques等人,2014年)和视频摘要(Gygli等人,2013年,2015)。

大多数研究者都认为兴趣是一种情感,因此它具有特定的认知评价结构、一致的身体表情和探索的行动倾向(2009年,伊扎德;Mortillaro等人,2011年;Campos等人,2013年;Dukes等人,2017年). 评估是指当一个人面对一个事件或物体时,在有意识或没有意识的情况下进行的认知评估。例如,当一个人看到一幅图像时,他/她会根据其相关性、新颖性、愉悦性、与个人和社会规范的兼容性以及是否可以理解来评估内容。根据评估情绪理论,评估结果的模式决定了人所经历的情绪(谢勒,2009年). 例如,恐惧通常是由一个相对出乎意料、相关和消极的事件引发的,而这个人对此缺乏应对意识(谢勒,2005年). 西尔维亚将应对潜能和创新复杂性的评估确定为定义兴趣体验的典型评估(Silvia,2005年). 人们对新颖的、复杂程度适当的事物或事件感兴趣,也就是说,不太容易或太复杂而难以理解。一般来说,更熟悉这个主题的人对更复杂的刺激形式有更高的兴趣,这可能是因为更高的专业知识需要更高的复杂性才能获得最佳的应对感(Silvia等人,2009年). 就评估而言,同样重要的是要注意兴趣并不总是关于积极的事物或事件,不愉快的经历可能会引起兴趣(Silvia,2008年). 即使在某些情况下,感兴趣的对象本质上可能是令人不快的,但大多数作者认为兴趣是一种积极的情绪:感兴趣的体验在主观上是令人愉快的,或者至少伴随着对对象的接近倾向(埃尔斯沃思和史密斯,1988年;Mortillaro等人,2011年;Campos等人,2013年)。

1.1. 意向书

对兴趣表达的研究主要集中在面部。在其开创性工作中Izard(2009)假设对可能的典型感兴趣面部表情的唯一描述是“眉毛可以抬起,呈正常形状,或并拢和/或略微降低;眼睛可以加宽,外观圆润,或斜视;面颊可以抬起;嘴巴可以张开放松,舌头可以伸到牙龈线以外,嘴唇可以撅起”(Matias等人,1989年). 最近,里夫和同事调查了参与者观看电影或玩空间关系谜题时,哪些面部动作与兴趣自我报告持续相关(里夫,1993年;里夫和尼克斯,1997年). 尽管一些行为似乎与兴趣相关,例如闭目和眼球暴露,但他们得出结论认为,没有稳定的面部特征群来表达兴趣。相反,在最近的一项研究中,Campos等人(2013年)列出了两个与兴趣表达密切相关的面部动作单元(AU)(内眉毛抬起和眉毛降低),以及五个弱相关的面部和头部动作。总之,关于兴趣表情原型存在的证据似乎很薄弱。然而,这一结论并不意味着面部或身体中没有与体验和兴趣交流持续相关的运动。Mortillaro等人(2011年)建议在表情的展开过程中,在表情的动态中,而不是在静态的面部形态中,寻找能够区分积极情绪的特定动作。Dukes等人(2017)探索了这种可能性,发现添加动态信息确实显著提高了他人识别感兴趣的面部表情的准确性,而且这种影响对兴趣的影响大于对其他情绪的影响。重要的是,当观众只能看到静态面部表情时,准确率只有29%(这一数字应该与其他情绪的平均准确率68%相比)。这证实了兴趣的表达不能通过一张静态照片来掌握,但可能需要动态信息。研究人员调查了面部表情以外的其他表达方式,尤其是伴随感兴趣体验的身体运动。身体在传达特定的积极情绪方面可能确实发挥着特殊的作用(特蕾西和罗宾斯,2004年;Gonzaga等人,2006年;Dukes等人,2017年;Mortillaro和Dukes,2018年). 一项关于身体表情和感知的调查发现,身体姿势和头部姿势与兴趣和厌倦的表达有关(Kleinsmith和Bianchi-Berthouze,2013年). 在Campos及其同事之前报道的研究中(Campos等人,2013年),兴趣与两个头部运动(头部倾斜和头部向前)和一个姿势改变(向前倾斜)有关。其他研究已经证实,兴趣的表达和对新刺激的反应包括定向反应和对兴趣对象的接近倾向。例如,在婴儿和儿童身上,一种新的刺激可能会产生一种冻结反应:婴儿停止所有其他动作,并将注意力转向刺激(Scherer等人,2004年;Camras等人,2006年)。Kleinsmith和Bianchi-Berthouze(2013)发现在观看视频游戏回放的受试者中,身体姿势和头部姿势可以用来识别注意力。在他们的工作中,注意力包括兴趣和注意力。

最近,Dael等人(2012年)调查了12种情绪的身体表达,这是迄今为止关于这一主题的最大研究之一。关于兴趣,他们发现了一个非常独特的模式,这可能与兴趣体验中的定向反应有关。更准确地说,这种模式包括双臂侧卧、躯干前倾和不对称的单臂动作。Dukes等人(2017)比较了对身体兴趣的非言语表达,以及与五种基本情绪的识别准确性。结果表明,当观察者除了面部表情外还能看到身体时,兴趣和其他情绪同样被识别。因此,兴趣,如自豪感,可能需要比面部动作更多的信息才能有效地表达和识别(例如头部倾斜和前倾姿势Campos等人,2013年). 特别是,人们可以推测,兴趣的表达始于一个冻结反应,然后是一个接近动作。

1.2. 检测

在数百篇描述实现基于计算机的情绪自动检测系统的研究和论文中,只有少数尝试将兴趣作为目标情绪之一。Kurdyukova等人(2012年)设置一个显示器,通过检测过路人的面部表情和头部姿势来检测他们的兴趣。Gatica-Perez等人(2005年)提出了一种从视听数据中识别小组会议兴趣级别的系统。为感兴趣的时刻,例如人们专心致志并做笔记的时刻,对脚本化或姿势化会议的视听记录数据集进行了注释。在他们的背景和数据集中,音频频道是信息最丰富的形式。

在在线辅导和教育的背景下,研究了兴趣和知识相关情绪的检测,如好奇心和厌倦感。卡普尔等人(卡普尔等人,2004);Kapoor和Picard,2005)使用游戏状态、身体姿势、面部表情和头部姿势来检测儿童玩教育游戏的兴趣。身体姿势由安装在孩子坐的椅子上的压力传感器网格感知。他们可以准确地检测到游戏中有趣的情况,识别率为86%。身体姿势是兴趣检测中信息最丰富的方式。姿势、面部表情和言语被用来识别学习场景中的无聊和好奇(D'Mello等人,2007年)。Sabourin等人(2011年)使用动态贝叶斯网络和多个用户的显式输入和交互日志来识别好奇和无聊。Jaques等人(2014)使用眼神凝视模式来识别学习场景中的好奇心和无聊感。Bixler和D'Mello(2013)使用按键、停顿行为、任务持续时间和任务评估来检测论文写作任务中的参与度和无聊度。

关于利益确认的最全面研究由Schuller等人(2009)他录制了一组视听自发性兴趣表达语料库(AVIC)。在他们的研究中,实验者和参与者坐在桌子的对面。实验者扮演营销人员向参与者展示产品的角色。鼓励参与者进行对话并提出问题。记录视听数据,并用五分制的兴趣度标注分段扬声器和次扬声器的转弯。五种兴趣从无私到好奇。语音和非语言发声由人类转录员转录和标记。在不同的模式下,声学特征表现最佳。尽管有少数几个显著的例外,但现有的基于面部和身体反应的自动情绪识别工作主要集中于识别少数具有典型表情的情绪(卡尔沃和德梅洛,2010年;Weninger等人,2015年). 还探索了使用连续维度(如效价和唤醒)识别情绪,但这些尝试不包括兴趣(Hatice等人,2011年;Sariyanidi等人,2015年)。Mortillaro等人(2012年)提出情感识别应该通过认知评价来实现。如果我们把评价看作是情感的构成因素,我们就可以超越目前主要基于原型表达自动识别的方法。该方法的进一步支持来自De Melo等人(2014)世卫组织进行了一系列实验,证明评价得到观众的认可,并在情绪表现对他人意图期望的影响中起到了中介作用。在讨论这些结果的含义时,作者认为基于评估的方法对于设计人机交互系统非常有用(另请参阅Scherer等人,2018年)。

在这项工作中,我们想首先研究兴趣的行为模式与其他积极情绪的区别。然后,我们旨在分析与兴趣相关的兴趣、好奇心和评价的生理和行为反应,即在观看视觉内容的背景下的应对潜力和新颖性复杂性(Silvia,2006年). 我们尝试通过行为和生理反应自动检测兴趣及其相关评估。为此,我们使用了一种多方法方法,其中我们结合了自我报告、参与者观看刺激物时的表情视觉记录、眼睛注视跟踪和生理测量。我们训练了一个集合回归模型,即随机森林,用于从面部表情、眼神和GSR中检测评价、好奇心和兴趣。这些模式在决策层进行了融合,以创建一个用于检测评估和兴趣的多模式模型。据我们所知,我们是最早报告评估自动识别的公司之一。

2.数据收集

2.1. 刺激物含量

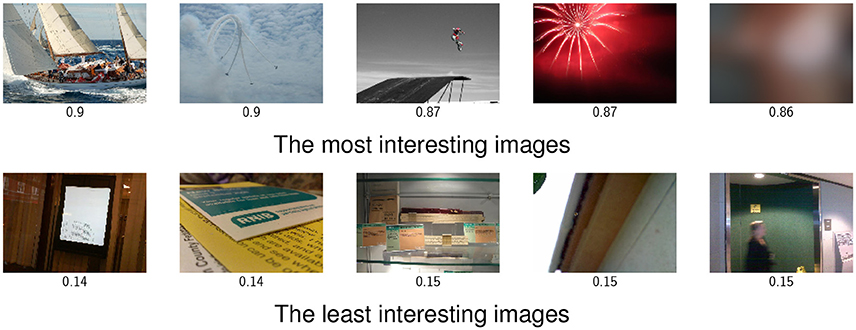

在一项初步研究中,从Flickr中选择了1005张不同的知识共享许可图片涵盖各种主题和情感内容,包括人物、风景、色情图片、动物和名人(索莱马尼,2015年). 我们特别注意收集内容、美学和质量各异的图片。我们通过Amazon Mechanical Turk(MTurk)上的众包为图片贴上标签20名参与者对每张图片进行了趣味性、可理解性(应对潜力)、愉悦性、审美唤起性、复杂性和新颖性评分。选择了80幅图像作为当前工作的刺激物,以涵盖平均兴趣度、愉悦度和应对潜力方面的整个范围。图像从最大版本调整为1440×1080像素。刺激示例如图所示1.

来自Video2GIF数据集的132个GIF格式的微视频(Gygli等人,2016年)被随机选择并在MTurk上以类似的比例标注。在我们的实验中,我们以全屏模式显示图像。当以全屏模式显示时,GIF没有足够的分辨率。因此,我们从源YouTube视频中提取了质量更高的等效视频,并将其重新编码为我们想要的格式(1920×1080),没有声音。从平均趣味性、愉悦性和应对潜力方面,选择了40个微视频覆盖整个范围。我们选择使用GIF是因为它们持续时间短、形式单一(仅视觉)且参与程度较高(Bakhshi等人,2016年). GIF并不总是以与原始视频相同的帧速率进行编码,并且包含循环,因此我们以1.5倍的速度重新编码它们,并将序列重复两次。微视频平均长11秒。

2.2. 仪器和协议

该实验已获得日内瓦大学心理与教育科学学院伦理审查委员会的伦理批准。通过校园海报和脸书招募了52名视力正常或矫正至正常的健康参与者。在这52名参与者中,19名男性,33名女性。参与者平均年龄为25.7岁(标准偏差= 5.3). 参与者被告知了他们的权利和实验的性质。然后,他们在录音前签署了知情同意书。他们因参与而获得40瑞士法郎。

实验在一个有控制照明的隔音实验室中进行。使用Allied Vision录制视频Stingray相机,60.03帧/秒,780×580分辨率。刺激物放在23英寸的屏幕上(1920×1080),参与者坐在离屏幕约60厘米的位置。两个电梯日光点LED投影仪被用来照亮参与者的脸,以减少可能的阴影。透镜上安装了一个红外阻挡滤波器,以消除眼睛凝视跟踪器对红外光的反射。视频由Norpix Streampix软件录制使用Tobii记录眼睛注视、瞳孔直径和头部距离TX300凝视跟踪器,300 Hz。使用Biopac记录GSRMP-36,125Hz,通过附着在食指和中指远端指骨上的电极。实验方案由Tobii Studio运行,录音由声音触发器同步,该触发器标记相机每次刺激前的帧。使用Brain Products StimTrak将相同的触发器转换为TTL触发器并与GSR信号一起记录。为了简化界面,我们只为参与者提供了一个带有数字按钮的键盘,他们可以使用数字按钮进行评分(1-7)。实验装置的图片如图所示3图中给出了极端感兴趣和无兴趣条件下的面部表情示例2.

参与者首先在模拟运行中熟悉协议和评级。参与者看每幅图像五秒钟,然后使用七点语义差异量表来评定他们的兴趣(从无趣到有趣),激发好奇心(他们喜欢看多少相似的内容),感知到的应对潜力(两个量表的平均值,易于理解、易于理解和不可理解)、新颖性(从不新颖到新颖)和复杂性(从简单到复杂)。在研究的第二部分,他们观看了40个微视频,并回答了同样的自我报告问题。

2.3. 自我报告

计算评分一致性以检查量表的可靠性。计算出的Chronbachα值显示了所有自我报告分数的高度可靠性。表中给出了80幅图像的不同评级与其可靠性得分之间的相关系数1如预期,兴趣和好奇心具有很高的相关性。应对潜力和复杂性也高度相关,这意味着参与者发现更复杂的刺激更难理解。尽管发现西尔维亚(2006)这种应对潜力是对兴趣的重要评估,在我们目前的数据中,应对潜力与兴趣没有正相关。评分者一致性得分和评分之间的相关系数遵循与微视频评分非常相似的模式。

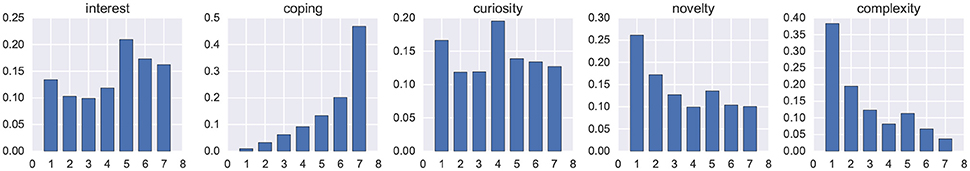

图中给出了自我报告得分到图像的直方图4我们成功地引起了广泛的兴趣、好奇心和新颖性。然而,应对潜能和复杂性得分的分布更不均衡。这可能是由于我们的刺激(图像)的性质,在大多数情况下,这些刺激是可理解的,并不复杂。对微视频的回应遵循着非常相似的分布。

实验时间很短(约25分钟),但任务是重复的。为了控制厌烦或疲劳的潜在影响,我们计算了兴趣得分与向受试者显示内容的顺序之间的相关性。我们没有发现它们之间有任何显著的相关性,这表明疲劳对自我报告的视觉内容兴趣没有系统影响。

除受试者脸上的视频外,数据库记录可用于学术研究,网址为[http://cvml.unige.ch/resources网站]. 对于人脸视频,将为社区提供地标、特征和动作单元。

3.兴趣和评价的表达和身体反应

3.1. 面部表情

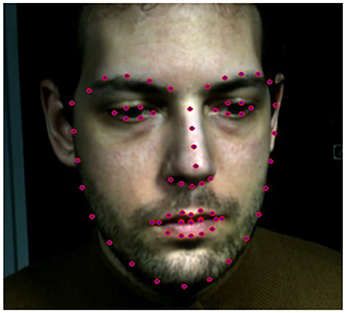

由于记录和同步方面的技术故障,两位参与者的数据不得不被丢弃。除了面部动作单元外,还提取了头部姿势、头部比例和眼睛注视坐标(埃克曼和弗里森,1978年). OpenFace在帧级别检测到以下动作单元的强度(Baltrusaitis等人,2015年,2016):AU1(内眼眉提升器)、AU2(外眼眉提升器,AU26(下颚下降)和AU45(闪烁)。OpenFace在脸上跟踪68个地标(见图5). 在将二维地标从面部旋转到正面位置并丢弃其三维后,我们通过对每个帧的形状进行Procrustes分析计算的刚性变换将其注册到标准面部。我们提取了眼睛、嘴唇和眉毛上的47个动态点,并将它们的坐标用作每个帧的特征。以下七个函数应用于每个试验的特征,用于合并:平均值、标准差、中位数、最大值、最小值、第一和第三四分位数。这导致每个试验都有658个元素的特征向量。我们选择使用地标作为功能,因为自动动作单元检测的准确性较低。

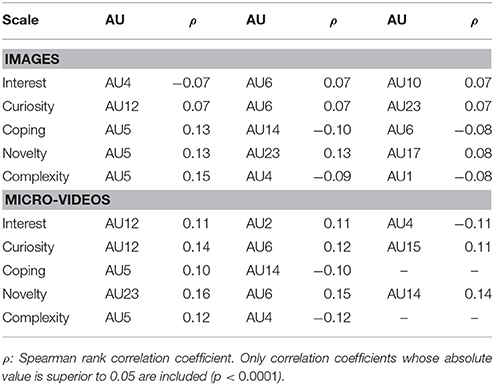

我们计算了行动单元(每个试验的平均值)和评分之间的皮尔逊等级相关性。总体而言,相关性较低。表中给出了每种刻度的三个最相关的动作单位2兴趣与积极情绪(快乐微笑,AU6+AU12)相关的动作单位的相关性最高,与消极情绪(皱眉)相关的动作单位的相关性最高。好奇心也有类似的模式。我们的结果证实了最近的其他研究,这些研究发现兴趣与微笑行为相关,通常是积极情绪的一部分(Mortillaro等人,2011年;Campos等人,2013年;Dukes等人,2017年). 另一种解释是,我们没有极度令人不快的刺激,这些刺激本可以引起兴趣,但不会引起微笑行为。

应对潜力和复杂性与AU5相关,AU5是眼睑提升器。刺激越复杂或越具有挑战性,眼睛就越宽:眼球暴露可能与寻找更多视觉信息有关,先前的研究表明,这可能与兴趣体验有关(里夫,1993年;里夫和尼克斯,1997年). 令人惊讶的是,除了AU5之外,AU14(酒窝)和AU23唇部紧致剂还具有新颖性。AU14的出现可能只是由于AU检测中的偶然性或错误。同样值得注意的是,我们使用的软件在检测所有动作单元时并没有很高的准确性,这些结果与使用手动动作单元编码的心理学研究不可比较(Mortillaro等人,2011年;Campos等人,2013年;Dukes等人,2017年)。

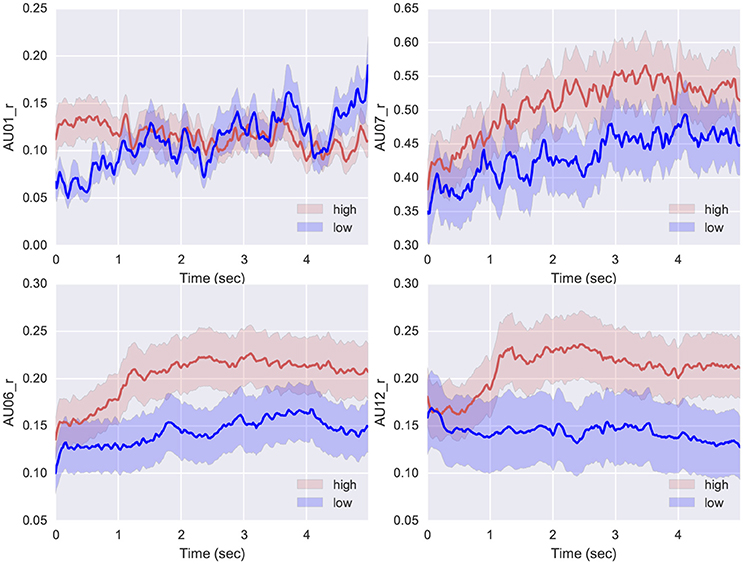

最近关于表达兴趣的研究清楚地发现,表达的动态性在识别兴趣方面很重要(Dukes等人,2017年). 因此,我们观察了在图像观看试验中面部表情如何展开,最高(>5,七点销售评级),最低的自我报告兴趣(<3)(见图6). 关注度较高的样品包括AU6和AU12的较高激活度(图的下半部分6),清楚地表明有趣的刺激与微笑行为有关。与Campos不同(Campos等人,2013年)在整个任务中,我们没有观察到AU1(内眉毛提升者)的更高激活。与非感兴趣刺激相比,仅在图像观看任务的第一秒,AU1在感兴趣刺激中更为活跃;我们可以把这解释为对一个新的有趣刺激的第一反应,随着刺激变得“已知”,这种反应往往会消失。重要的是,在整个表达过程中,AU7(眼睑紧致剂)对高度有趣的刺激的反应平均比低级有趣的刺激更为活跃,这证实了Mortillaro及其同事之前的发现,他们发现AU7存在于他们分析的90%的兴趣表达中(Mortillaro等人,2011年). AU7与闭眼非常相似,这是由里夫(1993)并且可能与注意力的集中和兴趣体验所带来的认知努力有关(Silvia,2008年)。

3.2. 眼睛注视和姿势

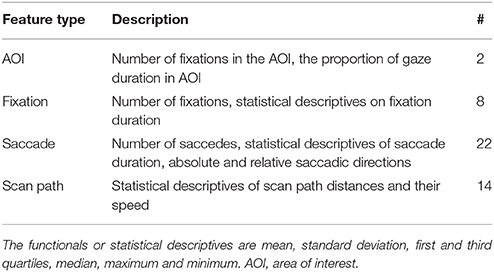

光学眼睛注视跟踪器跟踪注视方向并提供投射的注视。凝视分析软件Tobii Studio提取凝视和眼跳等凝视特征。注视点是眼睛凝视保持至少100毫秒的时间。眼跳是注视之间的眼球运动。眼跳的绝对方向(通过绝对角度测量)和相对于最后一次眼跳的相对方向由Tobii工作室计算。通过简化直线扫视运动的假设,我们将扫描路径定义为连续注视之间的直接路径。在眼睛凝视分析中,通常定义感兴趣区域(AOI)来局部研究凝视模式。我们将AOI定义为所显示照片的精确坐标;视频没有AOI,因为它们是全屏显示的。眼睛注视跟踪器还可以记录头部与屏幕的距离。我们使用头部距离作为身体姿势的测量,因为它表明了相对于标准休息姿势,这个人是前倾还是后倾。受到有关兴趣、无聊和情绪的相关文献的启发(D'Mello等人,2012年;Soleymani等人,2012年;布兰查德等人,2014年),提取了60个特征(见表3)。

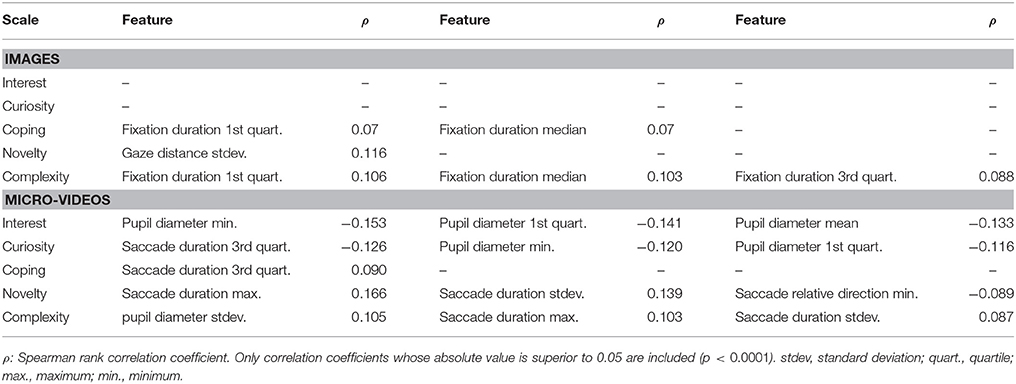

我们计算了兴趣、好奇心、应对方式、新颖性和复杂性与凝视行为特征的相关性(见表4). 新颖性和好奇心与较长的扫视有关;有趣且新颖的刺激需要更多的视觉探索,这一结果与我们在面部分析中的发现一致,在面部分析中将眼睑抬起器动作单元与新颖性评估相关联。

我们比较了最有趣(7分制>5)和最不有趣(<3)图像中头部(或凝视)距离随时间的变化。我们发现,最有趣的图像的特征是眼睛和屏幕之间的距离较短,这意味着头部前倾和/或上身姿势(见图7). 头部距离可以通过向前学习和头部姿势变化来改变,但这两种动作都表明有接近趋势;这些结果与Campos之前的发现完全一致(Campos等人,2013年)世卫组织发现兴趣与两种头部运动(头部倾斜和头部前倾)和一种姿势转变(前倾)有关。重要的是,在试验开始时,高兴趣和低兴趣刺激之间的注视距离没有差异,只有在1秒后,当参与者向后移动,脱离低兴趣刺激时,才出现差异。在有趣的刺激中观察到的动态行为似乎与最近观察到的Dukes等人(2017)世卫组织建议,身体的兴趣表达包括两个随后的动作,即静止然后靠近。

3.3. 电刺激皮肤反应(GSR)

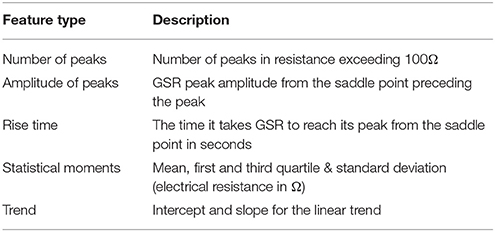

Lang等人(1993年)研究发现,对图像的兴趣与唤起强烈相关。GSR是一种通过一对电极测量皮肤电导的方法,广泛用于心理学和情感计算,以评估某人的身体激活(或唤醒)水平(珍妮弗和罗莎琳德,2000年;Kim和André,2008年;卡尔沃和德梅洛,2010年;克里比,2010年). 事实上,由GSR测量的皮肤电导随交感神经系统驱动的汗腺活动而波动。GSR反应包括紧张(缓慢)和阶段性(快速且通常与事件相关)反应。重要的是,GSR不能直接用于区分不同的情绪,例如兴高采烈和厌恶,但它提供了一种检测情绪存在和强度的方法。我们使用了开源的TEAP工具箱(Soleymani等人,2017年)从GSR信号中提取九个特征。为了捕获相位响应,我们提取了GSR信号中出现的峰值,并计算了它们的出现频率、振幅和上升时间。还提取了统计描述性数据,这些数据既反映了皮肤电刺激反应的强直特征,也反映了其阶段性特征。特性列表如表所示5.

我们计算了GSR特征与参与者自我报告测量之间的相关性。我们只发现兴趣和好奇心与GSR特征之间存在显著相关性。平均GSR与利息呈负相关(ρ=−0.09,第页<0.0001),并且峰值数量与观看微视频时的兴趣相关(ρ=0.09,第页< 0.0001). 同样值得注意的是,由于GSR信号的长度有限(图像仅为5秒,微视频约为11秒),我们无法记录在此时间窗口之外发生的可能较慢的皮肤电反应。

4.评估和利益检测

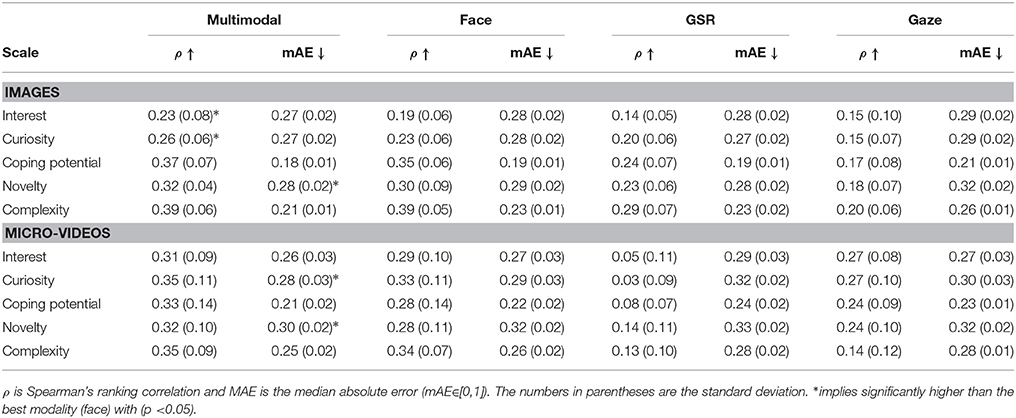

在本节中,我们分别报告对图像和微视频响应的评估和兴趣检测结果。我们使用了一个集合回归模型,即随机森林(Random Forests),该模型有100棵树,最小叶子大小为5片,用于检测兴趣、好奇心和评价水平。这种集成方法的优势在于其较低的过拟合敏感性。在我们的初步实验中,随机森林的表现优于带有径向基函数核的支持向量回归。由于分数的顺序性,我们选择了对每个参与者的标签进行等级标准化。在等级归一化中,对所有值进行排序,然后将排名转换为0到1之间的值。特征通过减去其平均值并除以其标准偏差进行标准化。以同样的方式,GSR信号首先对每个人进行标准化,以缓解参与者之间的差异。我们使用了一个20折的参与者间(非参与者依赖)交叉验证策略,在五个不同的尺度上评估回归结果,即兴趣、好奇心、应对潜力、新颖性和复杂性。由于分数的有序性,使用Spearman秩相关系数和中值绝对误差(mAE)对结果进行评估。Spearman秩相关的随机基线为零,归一化mAE(∈[0,1])具有均匀分布的随机基线在0.32到0.35之间。图像和微视频中的结果分别报告。

我们对三种模式进行了相同的回归程序,即面部表情、眼神和GSR。然后,我们使用单峰输出的加权和进行融合(后期融合)。根据训练集计算融合权重,如下所示。训练回归模型后,我们预测了训练集的结果,并拟合了一个线性模型,该模型结合了模态结果来预测训练集上的目标。图像和微视频的回归评估结果如表所示6从单模态结果来看,面部表情优于其他模态。由于试验持续时间短,GSR的表现并不特别好。正如所料,兴趣和好奇心的结果非常相似。对于在趣味性或愉悦性方面可能提供更多内容的视频,兴趣检测结果更好。

总的来说,与图像观看实验中的兴趣相比,应对潜力和复杂性的检测具有更高的准确性。应对潜力和复杂性的卓越表现可能与它们的偏斜分布有关(见图4)。

我们表演了一个单尾t吨-测试从最佳模态即面部表情测试多模态检测改进的重要性。参与者间交叉验证中的一些多模态结果在MAE方面优于其他结果,出于对图像的兴趣和好奇心,我们在多模态融合中获得了显著更高的相关性。

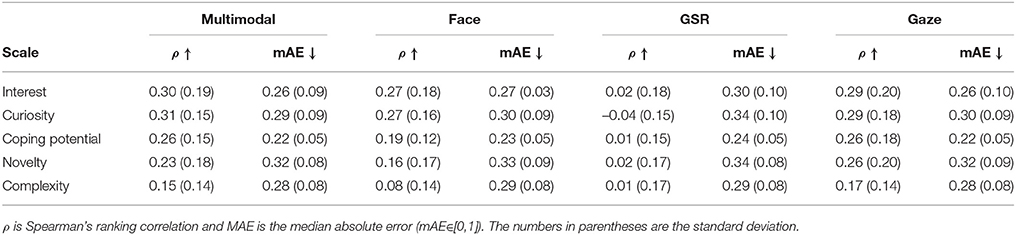

我们还进行了一次单参与者的交叉验证。微视频的结果如表所示7图像结果较差,接近随机(ρ<0.10),这表明参与者对图像的反应没有足够的相似模式。参与者独立的微视频结果不如参与者独立的结果,但仍然显著。识别复杂性的结果在参与者依赖性评估和独立评估之间的表现下降幅度最大。

5.讨论

我们的研究目标是双重的。一方面,我们希望为越来越多的文献做出贡献,这些文献试图区分积极情绪并研究每种积极情绪的特殊性(Campos等人,2013年;Shiota等人,2017年). 为了实现这个目标,我们选择了对它的许多应用和对我们社会的相关性感兴趣(Clément and Dukes,2013年). 另一方面,我们想测试多模式方法是否有助于自动检测感兴趣的内容,并因此成为未来应用的基础。此外,我们想测试一个模型,该模型将面向检测兴趣情绪及其构成评估(Mortillaro等人,2012年)。

在表达方面,我们的结果证实了最近的研究,即兴趣体验通常与微笑行为有关。这是积极情绪常见的一个表达特征,很明显,这并不是一个可以单独用来定义兴趣表达的特征。相反,当考虑运动的动力学时,有趣的刺激与非有趣的刺激有显著差异:第一秒内眉毛(AU1)对有趣刺激的反应更高,第一秒后眼睑紧绷剂(AU7)的激活更高,这可能是立即注意(AU1和认知努力(AU7)(Silvia,2008年). 与这一发现一致,我们发现新颖有趣的刺激可以通过较长的扫视来探索,这是一种持续注意力的指标。兴趣还与不同的姿势有关,这是由眼球跟踪器测量的更近的头部距离表示的。当屏幕上出现新的图像时,所有参与者都向屏幕倾斜(注意新的刺激),但只有当刺激有趣时,他们才保持姿势并保持专注;当刺激不感兴趣时,他们会回到休息位置,与屏幕保持距离。这与最近的研究一致,该研究指出动力学和身体运动在定义积极情绪的非言语表达方面的重要作用(Mortillaro等人,2011年;Dael等人,2012年;Dukes等人,2017年;Mortillaro和Dukes,2018年). 值得注意的是,在评估方面,我们发现与行动单位的相关性符合最新的经验证据(Scherer等人,2018年)。

在自动识别方面,来自GSR和凝视的兴趣和评价检测在图像中的表现比面部表情差。然而,人脸与任何其他模态的融合略优于单峰回归结果。眼睛凝视的结果也优于GSR和微视频面部表情的结果。模型,例如Papandreou等人(2009年),可以考虑多模态融合中模态的确定性,这可能会改进此融合结果。

现有的兴趣自动识别工作没有发现面部表情是信息量最大的形式(Gatica-Perez等人,2005年;Schuller等人,2009年). 兴趣不同于所谓的基本情绪(埃克曼,1993),没有证据表明有一个独特和一致的面部表情。这些关于表情和头部姿势的时间模式的发现是由机器学习方法驱动的,这些方法可以学习时间依赖性。为此,我们尝试了长短期记忆递归神经网络(RNN),但由于该数据集中的样本数量较少,RNN未能取得更好的结果。计算机视觉的最新进展是实现基于视觉的凝视跟踪(Wood等人,2015年)来自单个网络摄像头。这些发现激励了人们进一步研究基于音频和视觉的方法,这些方法在自然主义或“在野外”的情况下也更加实用。

我们的结果与Schuller等人(2009)然而,在实验和分析中存在一些差异。首先,中的协议Schuller等人(2009)包含在积极的社交互动中,而我们的录音是在非社交环境中进行的,参与者的表达能力较差。第二,他们的底线是由第三人称贴标者生成的,与具有参与者依赖性偏见的自我报告相比,第三人称贴标者的底线更加一致。尽管性能相对较低,但我们的结果表明,兴趣检测可以从多种模式的集成中获益。如果只应使用一种形式——用于技术限制或实际应用——面部表情是一个很好的选择。然而,考虑到动作的动态,如果可能的话,还要考虑头部动作,这样做会更好。

在这项研究中,我们还测试了另一种情绪识别方法。根据以下建议Mortillaro等人(Mortillaro等人,2012年;Scherer等人,2018年)我们探索了自动检测评估的可能性。我们将注意力集中在与利益最相关的评估上,并取得了可喜的结果。对于图像,应对、潜力、新颖性和复杂性比对所有单峰检测程序和多峰方法的兴趣得到更好的识别。这种结果模式建议将评估视为情感表达的构建块,并将其用作情感检测算法的一级目标(Mortillaro等人,2012年;De Melo等人,2014年;Scherer等人,2018年). 我们没有发现微视频的结果模式相同,但这主要是由于参与者观看微视频时在检测兴趣方面表现更好。人们可以推测,当刺激物信息丰富,人们具有表达能力时,由于其与积极表达的强烈联系,兴趣可以被直接识别。相反,当情绪不太强烈且表达非常微妙时,系统可能应该以评估为目标,因为这些可能是区分微妙不同情绪状态(如积极情绪)的最佳因素(Mortillaro等人,2011年)。

从视觉内容中自动识别视觉兴趣的前期工作(Gygli等人,2013年;索莱马尼,2015年;Gygli和Soleymani,2016年)据报道,检测平均兴趣的性能更高,相关性达到0.71英寸Gygli等人(2013)用于图像,0.53用于微视频(Gygli和Soleymani,2016年). 识别评价的进一步尝试可以与内容分析相结合,从表达和内容中检测兴趣。例如,如果内在愉悦和美学与对图像的兴趣有关,如索莱马尼(2015)和Gygli和Soleymani(2016)视觉内容可以根据其愉悦性和美学程度进行分析或标记。然后,可以将公认的评价(如新颖性)与内在愉悦性一起用于兴趣检测。

在这项研究中,我们发现兴趣和微笑之间存在联系。然而,值得注意的是,我们只研究了对被评定为有趣或不有趣的刺激作出反应时的行为。我们没有将兴趣的表达与其他情绪的表达进行比较。在后一种情况下,我们可能会发现微笑是最积极的情绪(埃克曼,1992年,1993;Campos等人,2013年). 微笑是我们实验框架中的一个兴趣指标,但它不是唯一的,也不是最具定义性的。微笑不是一种反映一种真实情感的简单行为,而是一种可以具有多种社会和情感功能(例如。,Ryclowska等人,2017年). 例如,微笑可以是其他积极情绪的表达,也可以用来培养凝聚力或支配力。正是出于这个原因,我们建议使用基于评估的方法进行情感识别,这比传统的模式匹配方法具有更大的灵活性。在我们的研究中,我们将微笑与内在愉悦感的评价联系起来,并且我们不能完全排除其他积极情绪与兴趣体验同时发生的可能性。研究兴趣的研究人员应该意识到微笑的特殊作用,并考虑他们的研究范式和模型应用的所有限制和影响。

在这项工作中,内容仅限于视觉内容,与参与者没有任何个人联系。然而,在实践中,内容的相关性或与用户的个人联系是决定其趣味性的一个重要因素。一张心爱的人的粒状照片可能比一张随机场景的清晰且美观的图像更有趣。未来可以通过添加与个人相关和无关的内容来评估相关性来解决此限制。

这项工作的另一个局限性是,参与者没有任何特定的任务或目标,而且此人只是被动地看着刺激物。这种被动的角色加上缺乏社会互动,限制了参与者表达的数量。

在我们的研究中,我们只使用了80张图片和40个短片。拥有更大的数据集也将有助于训练能够学习时间相关性的模型,例如递归神经网络。

最后,微视频在参与者之间引发了更一致的行为模式,这在参与者独立的结果中是可以观察到的。我们认为,静止图像不能像运动图像那样引发强烈的情绪和反应,因此我们建议在未来的工作中使用视频。

当前的工作涉及短期和情景兴趣(也称为情景兴趣)的自动检测。这与当前大多数推荐系统所做的不同,即根据内容分析确定长期个人兴趣。显然,使用面部表情等行为信号来检测情景兴趣需要捕获面部图像,我们应该知道,用户可能会发现这种干扰,至少有两个原因。首先,用户可能不想共享使他们在系统中可识别的信息。其次,一个人可能不一定想要分享他/她的内心状态,例如对给定内容的兴趣。只有在用户完全知情同意的情况下才能部署此类系统,并且用户应完全控制如何以及在何处使用数据。此类系统的设计不应传输或存储可识别信息,在本例中为面部图像。一个现有的解决方案是在用户设备上执行面部跟踪,并且只传输或存储分析结果。

6.结论

一种自动检测兴趣的方法在不同领域都有应用。例如,视觉兴趣可以用于在推荐或检索系统中重新存储图像(Walber等人,2014年). 类似的方法也可以应用于在线教育(D'Mello等人,2007年)和市场营销(Kurdyukova等人,2012年)。

在这项工作中,我们进行了一项实验,旨在评估参与者观看视觉刺激时的兴趣、好奇心及其相关评价。我们发现了与兴趣相关的面部表情、姿势和头部姿势的时间模式。对GSR的分析表明,兴趣可能与较高的唤醒有关。兴趣水平较高的用户的注视模式包含较长的眼跳,这可能与探索的动作倾向有关。对面部表情的分析表明,兴趣与睁眼和微笑有关,这是新奇和愉快的标志。微笑和兴趣之间的相关性与我们之前在类似背景下的研究结果一致,该研究表明愉快和兴趣之间存在正相关(Mortillaro等人,2011年;索莱马尼,2015年)。

我们关于评价和面部动作单元之间关系的结果通常与最新的实证结果一致(Scherer等人,2018年). 我们的研究还表明,评价与眼睛注视有关(对被评价为新颖刺激的较长扫视),并且皮肤电反应或波动也与较高的兴趣水平有关。检测算法的结果反映了这些结果,即评估的检测效果优于对所有模式和多模式方法的兴趣。总而言之,我们建议,未来检测微妙或非基本情绪的尝试可能侧重于检测评估,并采用多模式方法。然后,评估应该被用作检测兴趣或其他没有典型表达的情绪的构建块。

作者贡献

MS设计了实验,收集了数据并进行了定量分析。MM为手稿的制定、讨论和写作做出了贡献。

基金

MS的工作得到了瑞士国家科学基金会Ambizione拨款的支持。MM的工作得到了国家研究能力中心(NCCR)的支持:情感科学:个人行为和社会过程中的情感,由瑞士国家科学基金会资助[赠款编号:SNSF,51NF40-104897],由日内瓦大学主办。

利益冲突声明

作者声明,该研究是在没有任何可能被解释为潜在利益冲突的商业或金融关系的情况下进行的。

致谢

我们要感谢Danny Dukes对兴趣心理学的讨论。我们感谢David Sander在协议伦理审查过程中提供的善意协助。我们感谢日内瓦大学生物技术基金会对实验设施和计算机科学系的慷慨支持,感谢他们为实验运行提供了必要的物质支持。

脚注

工具书类

Bakhshi,S.、Shamma,D.A.、Kennedy,L.、Song,Y.、de Juan,P.和Kaye,J.J.(2016)。《快速、廉价、优质:为什么动画GIF吸引我们》2016年CHI计算机系统人为因素会议记录(加利福尼亚州圣何塞),575-586。doi:10.1145/2858036.2858532

交叉引用全文|谷歌学者

Baltrusaitis,T.、Mahmoud,M.和Robinson,P.(2015)。《自动动作单元检测的跨数据学习和特定人员归一化》(Cross-dataset learning and person-specific normalization for automatic Action Unit detection),in2015年IEEE第11届自动人脸和手势识别国际会议和研讨会(FG)(新泽西州皮斯卡塔韦),1-6。doi:10.1109/FG.2015.7284869

交叉引用全文|谷歌学者

Baltrusaitis,T.、Robinson,P.和Morency,L.-P.(2016)。“OpenFace:一个开源面部行为分析工具包”,in2016年IEEE计算机视觉应用冬季会议(WACV)(新泽西州皮斯卡塔韦),1-10。doi:10.1109/WACV.2016.7477553

交叉引用全文|谷歌学者

Bixler,R.和D'Mello,S.(2013)。“通过击键分析、任务评估和稳定的特征来检测写作过程中的无聊和投入”2013年智能用户界面国际会议记录(纽约州纽约市:ACM),225–234。doi:10.1145/2449396.2449426

交叉引用全文|谷歌学者

Blanchard,N.、Bixler,R.、Joyce,T.和D’Mello,S.(2014)。《基于生理学的学习期间思维游荡自动检测》第12届国际会议,ITS 2014,会议记录(夏威夷州火奴鲁鲁:斯普林格国际出版公司),55-60。

谷歌学者

Calvo,R.A.和D’Mello,S.(2010年)。情感检测:模型、方法及其应用的跨学科综述。IEEE传输。影响。计算。1, 18–37. doi:10.1109/T-AFFC.2010.1

交叉引用全文|谷歌学者

Campos,B.、Shiota,M.N.、Keltner,D.、Gonzaga,G.C.和Goetz,J.L.(2013)。什么是共享的,什么是不同的?核心关系主题和八种积极情绪的表达。认知。埃莫特。27, 37–52. doi:10.1080/02699931.2012.683852

PubMed摘要|交叉引用全文|谷歌学者

Camras,L.A.、Bakeman,R.、Chen,Y.、Norris,K.和Cain,T.R.(2006)。文化、种族和儿童面部表情:对欧美、中国大陆、美籍华人和被收养的中国女孩的研究。情绪6, 103–114. doi:10.1037/1528-3542.6.1.103

PubMed摘要|交叉引用全文|谷歌学者

Clément,F.和Dukes,D.(2013)。利益在社会价值观传播中的作用。前面。精神病。4:349. doi:10.3389/fpsyg.2013.00349

PubMed摘要|交叉引用全文|谷歌学者

Dael,N.、Mortillaro,M.和Scherer,K.R.(2012年)。身体动作和姿势中的情绪表达。情绪12, 1085–1101. doi:10.1037/a0025737

PubMed摘要|交叉引用全文|谷歌学者

De Melo,C.M.、Carnevale,P.J.、Read,S.J.和Gratch,J.(2014)。在相互依赖的决策中,从情感表达中解读人们的想法。《社会心理学杂志》。106, 73–88. doi:10.1037/a0034251

PubMed摘要|交叉引用全文|谷歌学者

D'Mello,S.、Olney,A.、Williams,C.和Hays,P.(2012)。凝视导师:凝视反应智能辅导系统。国际期刊休谟计算。螺柱。70, 377–398. doi:10.1016/j.ijhcs.2012.01.004

交叉引用全文|谷歌学者

D'Mello,S.、Picard,R.W.和Graesser,A.(2007年)。走向情感敏感的自动导师。IEEE智能。系统。22,53–61。doi:10.1109/MIS.2007.79

交叉引用全文|谷歌学者

Dukes,D.、Clément,F.、Audrin,C.和Mortillaro,M.(2017)。在情绪识别中超越静态面孔:兴趣的信息案例。视觉。认知。25, 575–588. doi:10.1080/13506285.2017.1341441

交叉引用全文|谷歌学者

Ekman,P.(1992)。基本情绪的论据。认知。埃莫特。6169–200之间。doi:10.1080/0269939208411068

交叉引用全文|谷歌学者

Ekman,P.(1993)。面部表情和情绪。美国心理医生。48, 384–392. doi:10.1037/0003-066X.48.4.384

PubMed摘要|交叉引用全文|谷歌学者

Ekman,P.和Friesen,W.V.(1978年)。面部动作编码系统手册,加利福尼亚州帕洛阿尔托:咨询心理学家出版社。

Ellsworth,P.C.和Smith,C.A.(1988年)。快乐的阴影:区分愉悦情绪的评估模式。认知。埃莫特。2, 301–331. doi:10.1080/02699938808412702

交叉引用全文|谷歌学者

Gatica-Perez,D.、McCowan,I.、Zhang,D.和Bengio,S.(2005年)。中的“检测会议中的小组兴趣级别”IEEE声学、语音和信号处理国际会议论文集(新泽西州皮斯卡塔韦),489–492。doi:10.1109/ICASSP.2005.1415157

交叉引用全文|谷歌学者

Gonzaga,G.C.、Turner,R.a.、Keltner,D.、Campos,B.和Altemus,M.(2006)。亲密关系中的浪漫爱情和性欲。情绪(华盛顿特区)6163-179。doi:10.1037/1528-3542.6.2.163

PubMed摘要|交叉引用全文|谷歌学者

Hatice,G.、Björn,S.、Maja,P.和Roddy,C.(2011年)。《连续空间中的情感表征、分析和合成:一项调查》2011年IEEE国际会议自动面部手势识别与研讨会(FG 2011)(新泽西州皮斯卡塔韦),827-834。doi:10.1109/FG.2011.5771357

交叉引用全文|谷歌学者

Gygli,M.,Grabner,H.,Riemenschneider,H.、Nater,F.和Van Gool,L.(2013)。“图像的趣味性”IEEE国际计算机视觉会议(ICCV)(新泽西州皮斯卡塔韦)。doi:10.1109/ICCV.2013.205

交叉引用全文|谷歌学者

Gygli,M.、Grabner,H.和Van Gool,L.(2015)。“通过学习子模块混合目标进行视频摘要”IEEE计算机视觉和模式识别会议(CVPR)(新泽西州皮斯卡塔韦)。doi:10.1109/CVPR.2015.7298928

交叉引用全文|谷歌学者

Gygli,M.和Soleymani,M.(2016)。中的“分析和预测gif的趣味性”2016年ACM多媒体会议记录,2016年MM(纽约州纽约市:ACM),第122–126页。doi:10.1145/2964284.2967195

交叉引用全文|谷歌学者

Gygli,M.、Song,Y.和Cao,L.(2016)。中的“Video2GIF:从视频自动生成动画GIF”2016年IEEE计算机视觉和模式识别会议(CVPR)(内华达州拉斯维加斯)。doi:10.1109/CVPR.2016.114

交叉引用全文|谷歌学者

Jennifer,H.和Rosalind,P.(2000)。“SmartCar:检测驾驶员压力”,in第15届模式识别国际会议论文集。ICPR-2000型(巴塞罗那),218-221。doi:10.1109/ICPR.2000.902898

交叉引用全文|谷歌学者

Izard,C.E.(2009)。情绪理论和研究:重点、未回答的问题和新出现的问题。每年。精神病牧师。60, 1–25. doi:10.1146/annurev.psych.60.110707.163539

PubMed摘要|交叉引用全文|谷歌学者

Jaques,N.、Conati,C.、Harley,J.M.和Azevedo,R.(2014)。《预测与智能辅导系统交互期间凝视数据的影响》第12届国际会议,ITS 2014,会议记录,第8474卷LNCS(夏威夷州火奴鲁鲁:斯普林格国际出版公司),29-38。doi:10.1007/978-3-319-07221-04

交叉引用全文|谷歌学者

Kapoor,A.和Picard,R.W.(2005年)。《学习环境中的多模态情感识别》2005年第13届ACM多媒体国际年会会议记录(纽约,NY:ACM出版社),677。doi:10.1145/101149.1101300

交叉引用全文|谷歌学者

Kapoor,A.、Picard,R.W.和Ivanov,Y.(2004)。“检测兴趣的多种模式的概率组合”2004年第17届模式识别国际会议论文集。ICPR 2004年,3,(新泽西州皮斯卡塔韦),969–972。doi:10.1109/ICPR.2004.1334690

交叉引用全文|谷歌学者

Kim,J.和André,E.(2008)。基于音乐听力中生理变化的情感识别。IEEE传输。帕特。分析。机器。智力。2067年至2083年。doi:10.1109/TPAMI.2008.26

PubMed摘要|交叉引用全文|谷歌学者

Kleinsmith,A.和Bianchi-Berthouze,N.(2013)。情感身体表达感知与识别:一项调查。IEEE传输。影响。计算。4, 15–33. doi:10.1109/T-AFFC.2012.16

交叉引用全文|谷歌学者

Kreibig,S.D.(2010年)。情绪中的自主神经系统活动:综述。生物、心理。84, 394–421. doi:10.1016/j.biochetic.2010.03.010

PubMed摘要|交叉引用全文|谷歌学者

Kurdyukova,E.、Hammer,S.和André,E.(2012)。“公共显示内容的个性化是由对群体背景的识别驱动的”《环境情报》第7683卷,编辑F.Paternó、B.de Ruyter、P.Markopoulos、C.Santoro、E.van Loenen和K.Luyten(柏林;海德堡:施普林格),272-287。

谷歌学者

Lang,P.J.、Greenwald,M.K.、Bradley,M.M.和Hamm,A.O.(1993)。看图片:情感、面部、内脏和行为反应。心理生理学30, 261–273. 文件编号:10.1111/j.1469-8986.1993.tb03352.x

PubMed摘要|交叉引用全文|谷歌学者

Matias,R.、Cohn,J.F.和Ross,S.(1989年)。两种编码婴儿情感表达的系统的比较。发展心理学。25, 483–489. doi:10.1037/0012-1649.25.4.483

交叉引用全文|谷歌学者

Mortillaro,M.和Dukes,D.(2018年)。欢跃:身体和动力学在表达和识别积极情绪中的重要性。前面。精神病. 9:763. doi:10.3389/fpsy.2018.00763

PubMed摘要|交叉引用全文|谷歌学者

Mortillaro,M.、Mehu,M.和Scherer,K.R.(2011年)。不同的积极情绪可以通过他们的面部表情来区分。Soc.精神科。人文科学。2, 262–271. 数字对象标识代码:10.1177/1948550610389080

交叉引用全文|谷歌学者

Mortillaro,M.、Meuleman,B.和Scherer,K.R.(2012年)。倡导一种成分评价模型来指导情绪识别。国际期刊综合。埃莫特。第3页,第18页至第32页。doi:10.40018/jse.2012010102

交叉引用全文|谷歌学者

Papandreou,G.、Katsamanis,A.、Pitsikalis,V.和Maragos,P.(2009年)。基于不确定性补偿的自适应多模态融合及其在视听语音识别中的应用。IEEE传输。音频语音语言处理。17, 423–435. doi:10.1109/TASL.2008.201515

交叉引用全文|谷歌学者

Reeve,J.(1993)。兴趣的面孔。动机。埃莫特。17, 353–375. doi:10.1007/BF00992325

交叉引用全文|谷歌学者

Reeve,J.和Nix,G.(1997年)。通过探索行为和面部表情表达内在动机。动机。埃莫特。21, 237–250. doi:10.1023/A:1024470213500

交叉引用全文|谷歌学者

Ryclowska,M.、Jack,R.E.、Garrod,O.G.、Schyns,P.G.、Martin,J.D.和Niedenthal,P.M.(2017年)。功能性微笑:爱、同情和战争的工具。精神病。科学。28, 1259–1270. doi:10.1177/0956797617706082

PubMed摘要|交叉引用全文|谷歌学者

Sabourin,J.、Mott,B.和Lester,J.C.(2011年)。《利用理论基础动态贝叶斯网络建模学习者的情感》情感计算与智能交互(田纳西州孟菲斯:施普林格-柏林-海德堡),286-295。doi:10.1007/978-3-642-24600-532

交叉引用全文|谷歌学者

Sariyanidi,E.、Gunes,H.和Cavallaro,A.(2015)。面部情感的自动分析:注册、表征和识别的调查。IEEE传输。帕特。分析。机器。智力。第371113页至第1133页。doi:10.1109/TPAMI.2014.2366127

PubMed摘要|交叉引用全文|谷歌学者

Scherer,K.R.(2005)。什么是情绪?如何测量它们?社会科学。通知。44, 695–729. doi:10.1177/0539018405058216

交叉引用全文|谷歌学者

Scherer,K.R.(2009)。情感的动态架构:组件过程模型的证据。干邑。埃莫特。231307–1351。doi:10.1080/02699930902928969

交叉引用全文|谷歌学者

Scherer,K.R.、Mortillaro,M.、Rotondi,I.、Sergi,I.和Trznadel,S.(2018年)。评价驱动的面部动作是情绪推理的基石。心理学心理学杂志. 114, 358–379. doi:10.1037/pspa0000107

PubMed摘要|交叉引用全文|谷歌学者

Scherer,K.R.、Zentner,M.R.和Stern,D.(2004)。出乎意料的是:婴儿对预期违背的表达反应之谜。情绪4, 389–402. doi:10.1037/1528-3542.4.4.389

PubMed摘要|交叉引用全文|谷歌学者

Schuler,B.、Müller,R.、Eyben,F.、Gast,J.、Hörnler,B.、Wöllmer,M.等人(2009年)。无聊吗?通过对真实应用的广泛视听集成来识别自然兴趣。图像可视性。计算。27, 1760–1774. doi:10.1016/j.imavis.2009.02.013

交叉引用全文|谷歌学者

Shiota,M.N.、Campos,B.、Oveis,C.、Hertenstein,M.J.、Simon-Tomas,E.和Keltner,D.(2017)。超越幸福:建立离散积极情绪的科学。阿默尔。精神病。72, 617–643. doi:10.1037/a0040456

PubMed摘要|交叉引用全文|谷歌学者

Silvia,P.J.(2005)。什么有趣?探索兴趣的评估结构。情绪5, 89–102. doi:10.1037/1528-3542.5.1.89

PubMed摘要|交叉引用全文|谷歌学者

Silvia,P.J.(2006)。探索兴趣心理学纽约州纽约市:牛津大学出版社。

谷歌学者

Silvia,P.J.(2008年)。兴趣好奇的情绪。货币。直接。精神病。科学。17, 57–60. doi:10.1111/j.1467-8721.2008.00548.x

交叉引用全文|谷歌学者

Silvia,P.J.、Henson,R.A.和Templin,J.L.(2009)。每个人的兴趣来源都一样吗?使用多层次混合模型探讨评价结构中的个体差异。认知。埃莫特。231389-1406年。doi:10.1080/0269930902850528

交叉引用全文|谷歌学者

Soleymani,M.(2015)。《视觉兴趣的追求》第23届ACM多媒体年会会议记录,(纽约州纽约市),919-922。

谷歌学者

Soleymani,M.、Pantic,M.和Pun,T.(2012年)。响应视频的多模式情感识别。IEEE传输。影响。计算。3, 211–223. doi:10.1109/T-AFFC.2011.37

交叉引用全文|谷歌学者

Soleymani,M.、Villaro-Dixon,F.、Pun,T.和Chanel,G.(2017年)。用于从生理信号中提取情感特征的工具箱(teap)。前面。信息通信技术4:1. doi:10.3389/fict.2017.0001

交叉引用全文|谷歌学者

Tracy,J.L.和Robins,R.W.(2004)。展示你的自豪感:离散情绪表达的证据。精神病。科学。15, 194–197. doi:10.1111/j.0956-7976.2004.01503008.x

PubMed摘要|交叉引用全文|谷歌学者

Walber,T.C.、Scherp,A.和Staab,S.(2014)。“智能照片选择:将凝视视视为个人兴趣”SIGCHI计算机系统人为因素会议记录,CHI'14(纽约州纽约市:ACM),2065-2074。doi:10.1145/2556288.2557025

交叉引用全文|谷歌学者

Weninger,F.、Wöllmer,M.和Schuler,B.(2015)。《自然主义言语和语言中的情感识别——一项调查》情绪识别(新泽西州霍博肯:John Wiley&Sons,Inc.),第237–267页。

谷歌学者

Wood,E.、Ballocuitis,T.、Zhang,X.、Sugano,Y.、Robinson,P.和Bulling,A.(2015)。中的“用于眼睛形状配准和凝视估计的眼睛渲染”2015 IEEE国际计算机视觉会议(ICCV)(新泽西州皮斯卡塔韦),3756–3764。doi:10.1109/ICCV.2015.428

交叉引用全文|谷歌学者