作者:Bala Siva Sashank Jujjavarapu

编者按:这是我们的最新帖子NVIDIA DRIVE Labs系列,它以工程为中心,着眼于单个自动驾驶汽车的挑战以及如何NVIDIA大道解决这些问题。赶上我们所有的汽车帖子在这里.

为了使自动驾驶技术超越自动辅助驾驶,它必须具有可靠的360度环绕障碍感知。

检测车辆周围物体并对其作出反应的能力使其能够提供舒适、安全的驾驶体验。自动驾驶汽车通常配备一组不同配置的传感器,以提供可靠的环绕感知。由于大规模采购的可行性,全方位车身摄像头和雷达传感器设置是汽车行业主要的全方位车身感知系统选项之一。

尽管这些传感器可以单独使用,但每种传感器类型都有其自身的局限性。相机数据可以提供场景的语义表示,但它在3D信息方面固有的不足。另一方面,雷达数据可以很好地估计障碍物的距离和速度,但缺乏语义表示。在这个DRIVE Labs视频,我们解释了为什么必须有一个传感器融合管道,可以将这两种传感器类型的感知信号结合起来,以提供强大的周围感知。

环绕摄像头雷达融合是建立在环绕摄像头和环绕雷达感知管道之上的传感器融合层。它旨在利用每种传感器类型的互补优势,提供高质量的语义信息以及准确的位置、速度和加速度估计。每个摄像头都重新使用了核心摄像机-雷达融合功能,因此整个管道很容易扩展。

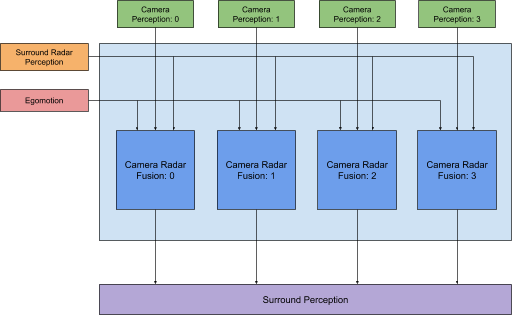

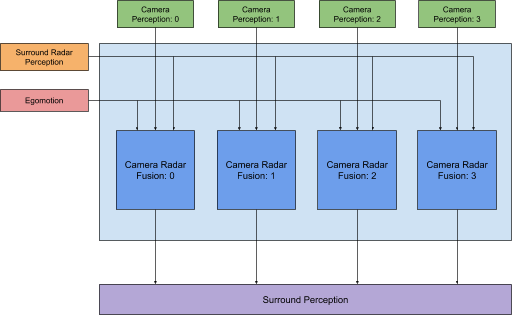

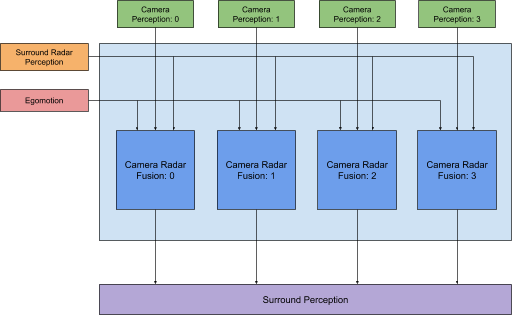

图1。四摄像头、八雷达传感器配置中的环绕摄像头-雷达融合处理管道。摄像机雷达融合

相机与雷达融合模块是环绕相机与雷达的融合管道的主要组成部分(图1)。它将单个摄像头生成的物体与环绕雷达感知的物体融合在一起。这背后的核心思想是一种有效的方法,通过传感器匹配物体,并以提高物体三维信息质量的方式组合其感知信号。

预处理

预处理对于识别匹配(即融合)过程中正确的摄像机对象和雷达对象集是必要的。这可以通过使用一种简单的技术来实现,例如考虑摄像机视场和雷达感知视场交叉处的物体。这种方法在过滤掉一般场景中出现的无关物体方面非常有效。

在这一步中,我们还更新对象数据以帮助融合过程。在这种情况下,摄像机和雷达感知管道各自运行在单独的线程上尤为重要。此外,与雷达感知相比,相机感知通常以不同的更新频率生成对象测量值。事实上,相机感知更新频率往往高于雷达感知更新频率。出于这个原因,为了正确地融合测量结果,将两个传感器中的物体带入一个共同的更新频率是至关重要的。

对象融合

融合过程从两个传感器之间的对象匹配或关联开始。它本质上是一个二部匹配问题。对于摄像机感知产生的每个物体,我们希望从雷达感知中找到其对应的物体,反之亦然。

提出启发式或成本度量来确定潜在匹配是融合管道中此步骤的最重要方面。通过分析来自两个传感器的个人感知信号的行为,以数据驱动的方式设计成本度量。它解释了来自不同传感器的物体的位置、速度、碰撞时间和方位角等信号如何相互比较。它还考虑了对象在检测历史中的时间匹配程度。

此成本度量适用于两种传感器类型的所有对象对。与至少有一个公共对象的所有其他对中成本最低的一对对应的对象被确定为匹配。一旦目标匹配,通过使用不确定性估计融合感知信号,为下游规划和控制模块生成可靠的3D信号。

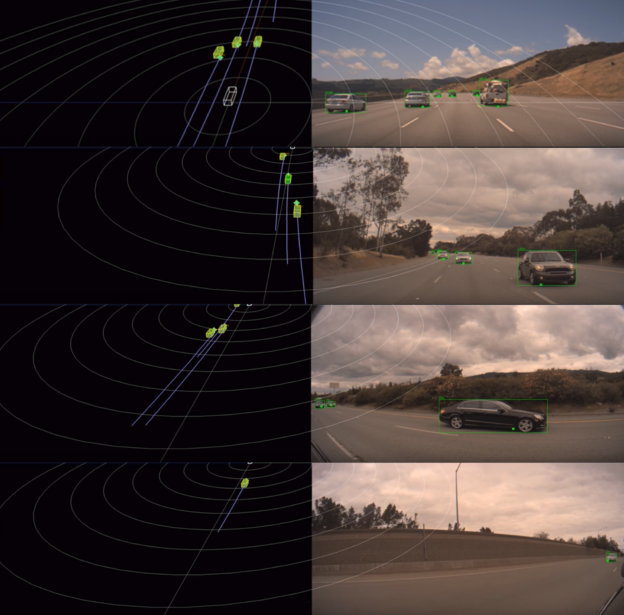

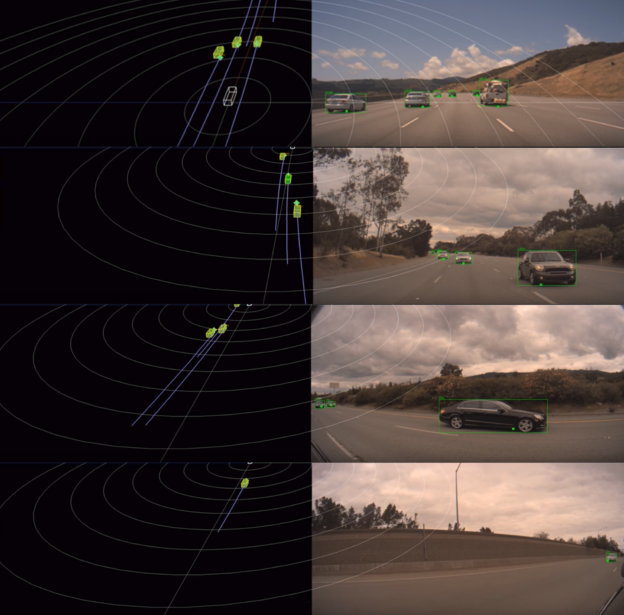

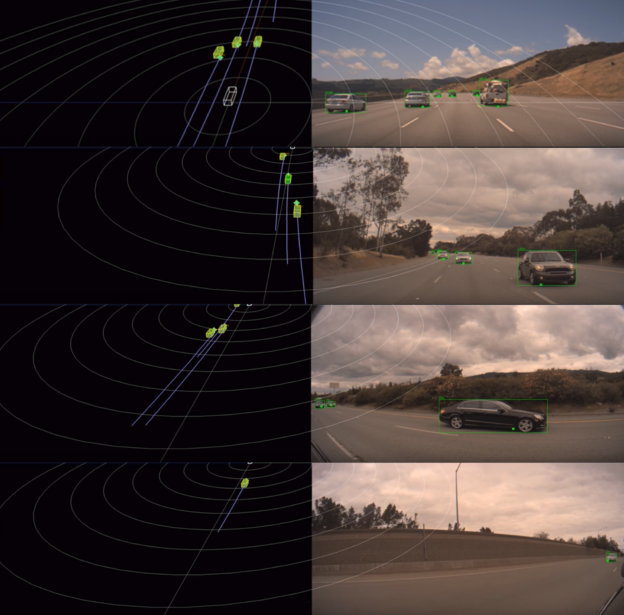

图2。摄像机-雷达融合以4摄像机、8雷达传感器配置显示每个摄像机。在摄影机视图中,摄影机对象显示在绿色边界框中,其对应的雷达对象显示为绿色方形点。在3D视图中,摄影机对象显示为黄色长方体,其对应的雷达对象显示为绿色八面体。紫罗兰色的痕迹显示了融合物体移动时的运动补偿历史。

图2。摄像机-雷达融合以4摄像机、8雷达传感器配置显示每个摄像机。在摄影机视图中,摄影机对象显示在绿色边界框中,其对应的雷达对象显示为绿色方形点。在3D视图中,摄影机对象显示为黄色长方体,其对应的雷达对象显示为绿色八面体。紫罗兰色的痕迹显示了融合物体移动时的运动补偿历史。全方位车身影像雷达融合功能非常灵活,支持多种传感器配置,包括6摄像头、8雷达;4个摄像头,8个雷达;2个摄像头,4个雷达;1个摄像头,1个雷达;等