1.简介

多亏了对多任务学习和可迁移性的研究(鲁德尔,2019年)目前,自然语言理解的趋势是建立“通用模型”:在多个任务上预先训练模型,在下游任务上微调模型,将获得的概念知识和技能转移到下游任务上。这些步骤对人工智能做出了非常重要的贡献,但通用模型并不能模拟人类智能的多样性。目前基于这种通用编码器的会话模型已经显示出惊人的结果。然而,在人类中,并没有一种“普遍模式”是所有人都共享的。我们可能分享我们神经结构的显著方面,但我们在生活中经历的任务、获得的概念知识以及我们的专业知识或文化背景方面存在差异。因此,我们认为使用具有不同先前经验的会话模型非常重要。

为了有效地交流,说话人和听话人必须协调他们对语言的使用和解释。例如,它们用来引用实体或事件的引用表达式取决于它们共享的信息(克拉克和马歇尔,1981年;Horton和Keysar,1996年;Brennan等人,2010年). 由讨论Garrod和Pickering(2004),对话的成功取决于说话者和倾听者对他们所谈论的元素的相似表达程度(例如,当使用相同的名字时,他们应该指代同一个人)。此外,人类能够理解他人的目标和意图,以及他人的信仰、怀疑等。他们被称为“心智理论”(ToM)(普雷马克和伍德拉夫,1978年). 在过去的一年里,计算语言学界发表了几篇文章,指出使用ToM开发模型的重要性(Bisk等人,2020年;Bara等人,2021年;Zhu等人,2021年). 一个智能对话系统应该知道它知道什么,并且能够在满足对其信念有用的反证时快速修改其知识。此外,它应该能够根据对话者的知识以不同的方式使用语言,并且应该能够预测对话者的期望,并根据这些期望调整交流。在本文中,我们将重点放在ToM的观众设计方面,以实现这样一个雄心勃勃的长期目标。

通过心理语言学的研究,人们对人类为对话者量身定制语言使用的能力进行了长期而深入的研究。人类伴侣被设置为玩迭代参考游戏:他们被给予一组物体,其中说话人被私下指定一个目标来描述,听话人必须在给定的对比集中识别它(克劳斯和温海默,1964年;Clark和Wilkes-Gibbs,1986年;Gann和Barr,2014年;霍金斯等人,2020b;洛伊和史密斯,2021年). 人们提出了各种语言生成的理论模型来解释通过这些实验产生的观众设计过程(例如。,Horton和Keysar,1996年;Brennan等人,2010年;Gann和Barr,2014年). 最近,通过对话实现的人类结盟也引起了神经科学家的注意(Hasson等人,2012年;Kuhlen等人,2017年). 在会话代理的发展中,这一核心方面是前神经时代的议程(例如。,Janarthanam和Lemon,2010年)但是,由于主要的挑战是获得能够产生至少在表面上与人类相似的话语和对话的会话神经模型,所以这项研究被搁置了好几年。既然已经达到了这一里程碑,那么在几篇立场论文中,就提倡关注语言的动态和自适应交互方面的重要性(Bisk等人,2020年;Benotti和Blackburn,2021;Chandu等人,2021年). 受语言涌现研究线内开展的多智能体设置开创性工作的启发(Lazaridou等人,2017年,2020)社区也面临着挑战,需要考虑多智能体交互,在这种交互中,演讲者必须进行交互并适应具有不同视觉效果的听众群体(Corona等人,2019年),或不同的语言(Zhu等人,2021年)能力。在这篇文章中,我们关注的是演讲者如何适应不同背景知识的对话者。以下Hawkins等人(2020a),我们的模型经历了一个预训练阶段,通过该阶段,它们通过学习描述图像来获得基础知识(图像字幕,IC),以及一个自适应阶段,通过该阶段,说话者和听者进行重复的参考游戏。霍金斯等人(2020a)研究会话模型如何创建新的约定。相反,我们感兴趣的是研究演讲者是否从听众的错误中学习以适应他的背景知识。

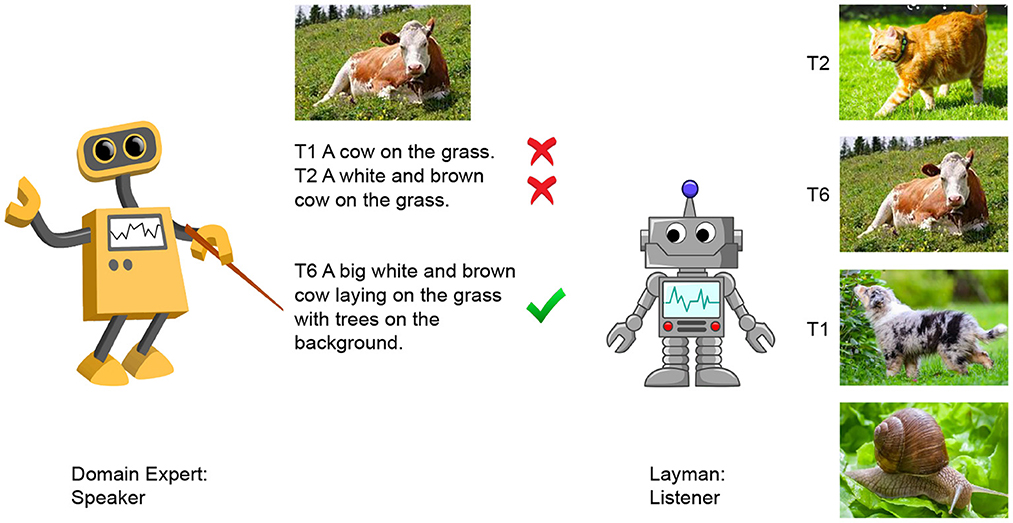

如所示图1,我们模拟了领域专家与非专家(外行)交互的情况;为了使交流成功,专家必须了解外行不知道什么,并学会相应地调整她的语言。具体来说,演讲者是知道某一领域内所有概念的专家,而外行则缺乏其中一些概念。例如,他知道什么动物意思是,因为他见过狗和猫,但他缺乏奶牛因为他在训练前从未见过这样的球员。我们通过控制模型在IC预培训期间看到的概念来模拟专家与外行的不同背景;我们通过控制外行不知道的概念的存在来创建对比集。符合心理语言学研究(Horton和Keysar,1996年)我们假设,如果说话人通过反复的互动,了解到听话人不知道的东西,她最终会用更多的视觉细节描述属于未知类别的对象,因为仅仅命名是不够的。在写论文时,我们发现Bao等人(2022)他们也解决了知识差异的问题,但从我们所了解的情况来看,他们关注的是听者在词汇中遗漏了一些单词,而不是遗漏了相应对象的实际经验。

为了解决这一问题,我们提出了一个模型,该模型结合了霍金斯等人(2020a)使用Rational Speech Act(RSA)模型(弗兰克和古德曼,2012年;Cohn-Gordon等人,2018年). 该模型经过训练,可以通过利用监听器的错误来描述监听器未知的概念。我们的主要目的是提请注意沟通的动态、渐进方面,特别是发言人适应对话者知识的能力。我们表明,RSA框架可以促使演讲者与听众保持一致,我们认为需要做更多的工作,以获得稳健的模型,这些模型以更稳健的方式学习RSA通过交互式交互支持所取得的成就。

2.相关工作

我们的工作结合了两条研究路线:使用迭代游戏来模拟重复的交流,通过这种交流,演讲者可以适应他们的伙伴,以及对实用主义演讲者进行建模,在与他们互动时考虑到伙伴的推理。

2.1. 适应性

在认知科学中,人们早就认识到沟通是一种共同努力(例如。,格莱斯,1975年;Clark和Wilkes-Gibbs,1986年;克拉克,1992年)在这段时间里,两个或多个对话者将他们的心理状态对齐(例如。,布伦南和克拉克,1996年). 研究表明,人类使用受众设计过程,换句话说,他们会根据对话者的需要调整语言(克拉克和马歇尔,1981年). 有人认为,对语言教师的研究应该与对表现他人心理状态的能力的研究紧密联系在一起(心理理论)(例如。,Brennan等人,2010年). 心理语言学文献中有很多有趣的研究,研究人类如何根据对话者的特点和先前的经历(全球层面)以及对话展开时出现的线索(地方层面)或这两个层面之间的相互作用来调整语言。这些研究是通过让受试者通过重复的参考游戏进行互动来进行的(克劳斯和温海默,1964年;Clark和Wilkes-Gibbs,1986年;克拉克,1992年;Gann和Barr,2014年). 基于这些实验,提出了几种人类适应能力的理论模型。如中所述Brennan等人(2010年)大多数都依赖于共同点的概念,即对话者有理由相信的信息是相互共享的)(Stalnaker,1978年;克拉克和马歇尔,1981年)尽管在语言制作过程中,这种信念如何影响受众设计方面存在分歧(参见例如。,Horton和Keysar,1996年;Horton和Gerrig,2005年,2016;Brennan等人,2010年;Gann和Barr,2014年). 例如,一些模型认为它在说话人的初始话语设计中发挥作用(“初始设计”),而其他模型则认为它只是在稍后才开始(“监控和调整”):如果说话人没有时间压力,他会考虑共同点,利用他的记忆力修改违反计划的最初计划(Horton和Keysar,1996年).

在过去几年里,计算语言学界发表了几部著作,指出了用心智理论(ToM)开发模型的重要性(Bisk等人,2020年;Bara等人,2021年;Zhu等人,2021年);ToM受到更多关注的一个方面是会话模型应具备的适应对话者的能力。考虑到迭代参考游戏,适应性已经过测试(霍金斯等人,2020a)或语言导航任务(Zhu等人,2021年)通过持续学习或少量学习范式进行建模。在这两种情况下,代理都会为N个希望演讲者适应听众的游戏。特别地,霍金斯等人(2020a)引入一个通信任务和一个通用的持续学习框架,用于在与其他代理进行实时交互时调整语言模型。本文中提出的任务是一个重复参考游戏,在该游戏中,说话人和听话人将看到一组图像,并且必须协作才能参考它们。在每次试验中,其中一个图像被私下指定为演讲者的目标,演讲者必须生成描述目标的话语。然后,听者必须根据上下文和说话者的话语猜测目标。两个代理都接收关于侦听器的响应和目标身份的反馈。试验序列的设计使每个图像重复出现为目标,使我们能够跟踪性能以及每个图像的通信随时间变化的方式。本文中描述的方法是基于针对特定任务的分层贝叶斯自适应方法,它包括在损失函数中结合说话人和听话人信息,以及使用正则化方案在不过度拟合的情况下微调模型权重。该模型是通过将标准的交叉熵项(独立地解释最可能的话语)与对比项(解释最具辨别力的话语)以及基于KL的正则化项(旨在防止灾难性遗忘)相结合来实现的。我们的论文以这项工作为基础,通过使用迭代参考博弈;与目前为止所做的不同,我们考虑Expert-Layman设置,并研究专家如何通过关于相同实体或相同领域的迭代通信来适应外行的部分知识。此外,我们还评估了灾难性遗忘对上述学习范式的影响。最后,我们提出了一种新的自适应计算模型,该模型在一定程度上受到了“监控和调整”理论的启发:演讲者在记忆中跟踪听者的错误,并在随后的回合中生成一个字幕,以避免此类误解。对比度集从一开始就不存在,如霍金斯等人(2020a),但它通过交互(即通过侦听器错误选择的图像)部分可用。

2.2. 实用主义演讲者

上述研究的核心动态适应过程与弗兰克和古德曼(2012)RSA模型对语言实施了一种社会认知方法,旨在捕捉说话人产生信息性话语的想法(格莱斯,1975年). 此外,它基于这样一个假设,即语言表达式的含义在很大程度上取决于使用该表达式的上下文,因此需要进行推断。在这个框架中,说话人和听话人对彼此的观点进行推理,并利用先前的信念来解释或生成话语。通过这样做,演讲者可以生成实用主义的信息描述。直观地说,RSA演讲者不仅通过推理什么是真实的,而且通过推理听众的推理来实现这种能力。例如,在一个基于视觉的参照游戏中,说话人必须描述一个图像,而听话人必须在一组图像中识别它,说话者可以为各种描述分配相同的概率,但它将通过推理哪种话语最有助于听者识别目标来决定生成什么。它是从一个字面上的说话人开始,生成一些字幕;模拟一个理性的听者,对所选的话语进行推理,并选择最符合这种描述的图像;最后,扮演一个理性的演讲者,考虑到这些模拟的选择,并说出最有信息的标题。参考读者古德曼和弗兰克(2016);Franke和Jaeger(2016)有关RSA框架的更多详细信息,请发送至Hawkins等人(2022)基于持续学习的最新扩展。

RSA模型在门罗和波茨(2015)年,提出了将语用推理与神经网络相结合的重要性安德烈亚斯和克莱恩(2016)最近在IC Generation中得到了利用(Schüz等人,2021年)系统。有趣的是,Zarrieß和Schlangen(2019年)将RSA与零镜头设置相结合,生成描述说话者未知类别的对象的引用表达式。与上一项工作类似,我们基于RSA的模型必须学会引用未知对象类别,但在我们的示例中,这些类别对于侦听器是未知的,对于说话者是已知的。Bao等人(2022)通过强化学习扩展RSA以适应说话人和听话人的词汇差异。与它们不同的是,我们利用RSA来帮助生成区分性字幕,如果它们导致成功的交互,那么这些字幕将被可能性损失所提升。我们依赖于中提出的增量RSA技术Cohn-Gordon等人(2018年)为了生成关于给定图像集中目标的实用信息描述。早期的RSA实现从所有可能的完整语句空间中采样;为此,他们只使用了话语空间的一小部分,导致字幕并不总是最实用的信息。为了克服这一限制,提出了一种增量方法。对话语生成的每一步进行推理。这一步骤既可以逐字生成句子,也可以实现(Cohn-Gordon等人,2019年)或者可以用不同的语言单位来定义,例如字符(Cohn-Gordon等人,2018年). 后者是最有效的方法,因为前者需要从大约20000个单词中取样,而后者需要在每个步骤中从大约30个字符中取样。因此,本文使用基于字符的解码器Cohn-Gordon等人(2018年)为说话人的语用推理建模。

此技术支持在通过字符级解码器操作的生成过程中利用RSA高效生成实用描述。使用字符级解码器比使用单词级解码器的优点是,在每个生成步骤中,前者的操作空间要小得多,这使得我们在自适应阶段使用的RSA技术更加有效。

3.数据集和任务

3.1. 数据集集合

我们的代理人将首先通过IC预培训阶段获得扎实的概念知识;然后,演讲者通过玩一个迭代参考游戏来适应听众。下面我们描述这两个阶段使用的数据集。

3.1.1. 预训练数据

我们想评估一个领域专家(他知道某个领域的所有概念)和一个外行(他对该领域有部分了解)之间的交互。为了向说话人和听话人灌输不同的背景知识,使用不同的数据集对这两个代理进行了IC任务的预培训。演讲者被视为专家,根据整个MS-COCO训练集的图像进行预训练,该训练集包含关于被组织成12个超级类别的对象的图像字幕对。因此,她是所有MS-COCO领域的专家(我们认为每个超类别都是一个领域)。监听器是门外汉,对此类数据的子集进行了预培训;对于每个MS-COCO超类别,他都没有看到N个它的类别(例如,在超类别“动物”中,他看到狗和猫,但没有看到马和牛,因为他一直住在城市里)。对于我们在本文中报告的实验,我们为每个超类别取了一个未知类别,并且我们不考虑超类别“人”,因为它只包含一个类别。

3.1.2. 适应数据

以下霍金斯等人(2020a),自适应数据由我们从MS-COCO验证集中收集的四幅图像的对比集组成。不同于Hawkins等人(2020a),我们使用以下标准构建了上下文,这些标准侧重于说话者-倾听者的知识差异:(1)每个上下文中的四个图像中有两个包含倾听者未知类别的视觉显著对象;(2) 另外两幅图像仅包含未知超类别的已知类别的视觉显著对象;(3) 这四幅图像在视觉上很相似。通过应用这些约束,我们构建了1.956个上下文;其中,对于11个MS-COCO超类别中的每一个,我们随机选择了6个上下文来运行适应阶段。在下文中,我们将未知对象类别称为“未知图像”或“未知对象”。

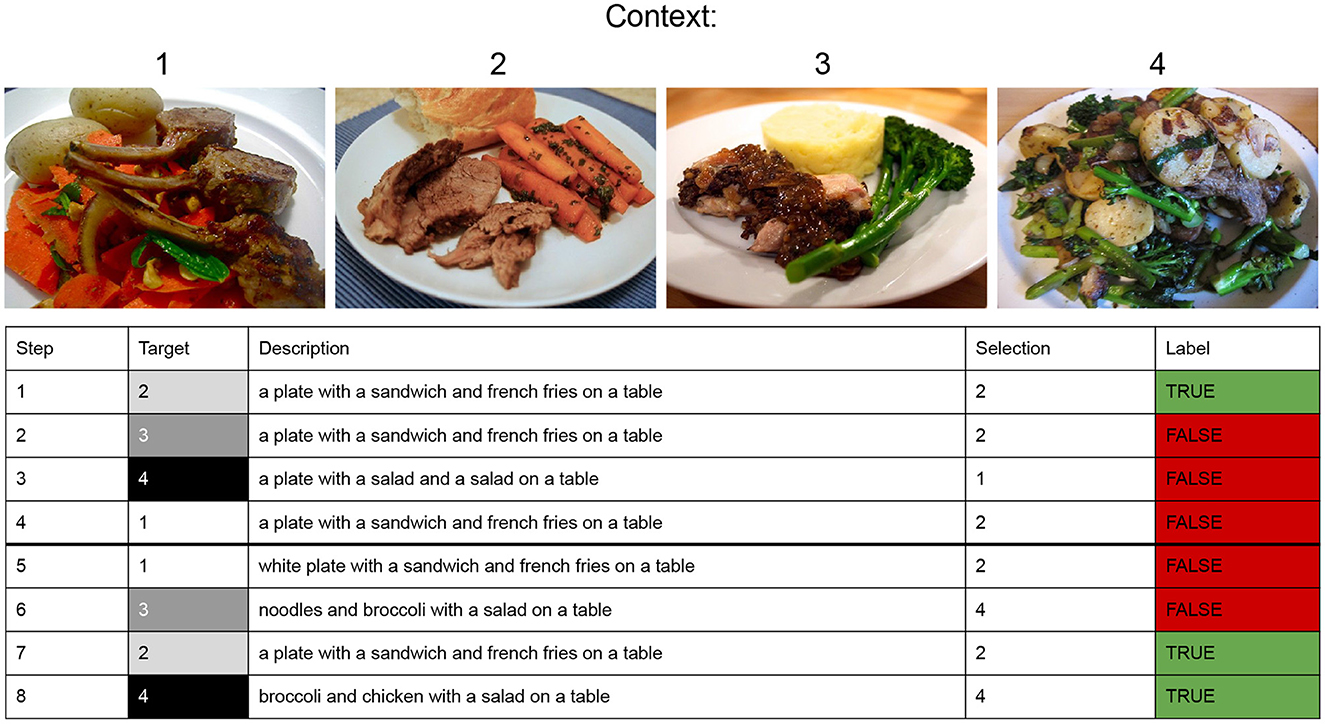

3.2. 重复参考游戏

我们创建迭代参考游戏,每个游戏由十个回合组成。如所示图2,每个回合由四个交换(步骤)组成。每次交换时,说话人都会收到给定上下文的四幅图像中的一幅作为目标,并必须对其进行描述。侦听器接收生成的标题,并必须从相应上下文的四张图像中选择目标。在一个回合内,目标交给演讲者的顺序是随机的。转弯1包括前4个步骤。在图中所示的示例游戏中,在步骤1中,指定演讲者描述目标2。演讲者生成标题,监听器正确选择目标2。在步骤2中,指定演讲者描述目标3,监听者收到生成的字幕,但错误地选择了目标2。Speaker-Listener交互继续执行步骤3和4,其中其他图像(分别为4和1)被指定为目标。因此,第1回合结束,下一回合开始。关键的是,交互是关于相同的图像,这些图像再次随机分配给作为目标的扬声器。总的来说,在第2回合之后,游戏会重复进行其他8回合,在此期间,演讲者会被要求再次描述前2回合中看到的4幅图像。

我们的主要重点是研究模型是否以及如何在一个迭代参考游戏中使其语言适应听者的知识。不同于霍金斯等人(2020a)在我们的实验中,两个模型之间发生了相互作用。

4.型号

我们与演讲者和监听者一起玩参考游戏。对于侦听器,我们使用中使用的模型霍金斯等人(2020a)基于标准编解码结构(Sutskever等人,2014年). 给定一个包含四个候选图像和一个标题的上下文,听者选择他认为最合理的标题图像:对于这四个图像中的每一个,他根据标题中单个单词的可能性来计算收到标题的总体可能性,并选择最接近的图像。对于扬声器,我们使用下面描述的模型。

4.1. 基线

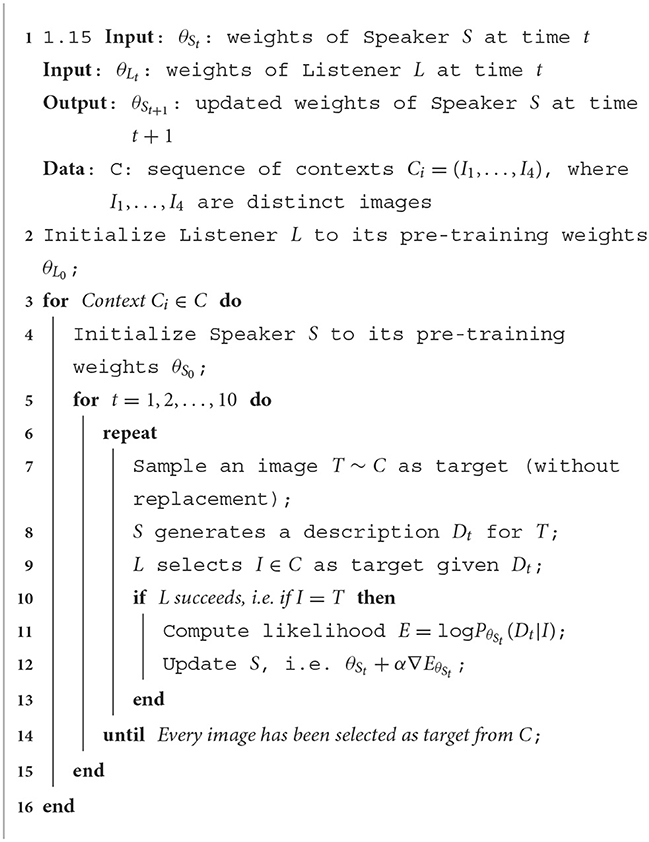

作为监听器,说话人由一个通过ResNet-152 CNN表示图像的编码器和一个基于具有长短期记忆单元的递归神经网络的解码器组成(Hochreiter和Schmidhuber,1997年)接收图像的编码并生成其视觉内容的描述。如中所示Cohn-Gordon等人(2018年)与霍金斯等人(2020a),扬声器的解码器执行字符级建模,根据前面字符的序列预测每个字符。给定一幅图像,说话人通过对图像进行编码并在每个步骤中选择解码器计算出的概率分布中具有最高值的字符来生成其描述。我们评估这个模型时,没有通过转弯进行调整(固定的模型)以及在每次成功交换时更新其参数(左侧型号)。特别是在时间步t吨监听器选择正确的目标我收到描述后D类t吨作为输入,参数θS公司t吨对说话人进行更新,最大限度地提高目标图像描述的可能性;可能性定义为对数P(P)θS公司t吨(D类t吨|我). 适应的程序左侧模型被描述为伪代码算法1.

4.2. 基于RSA的模型

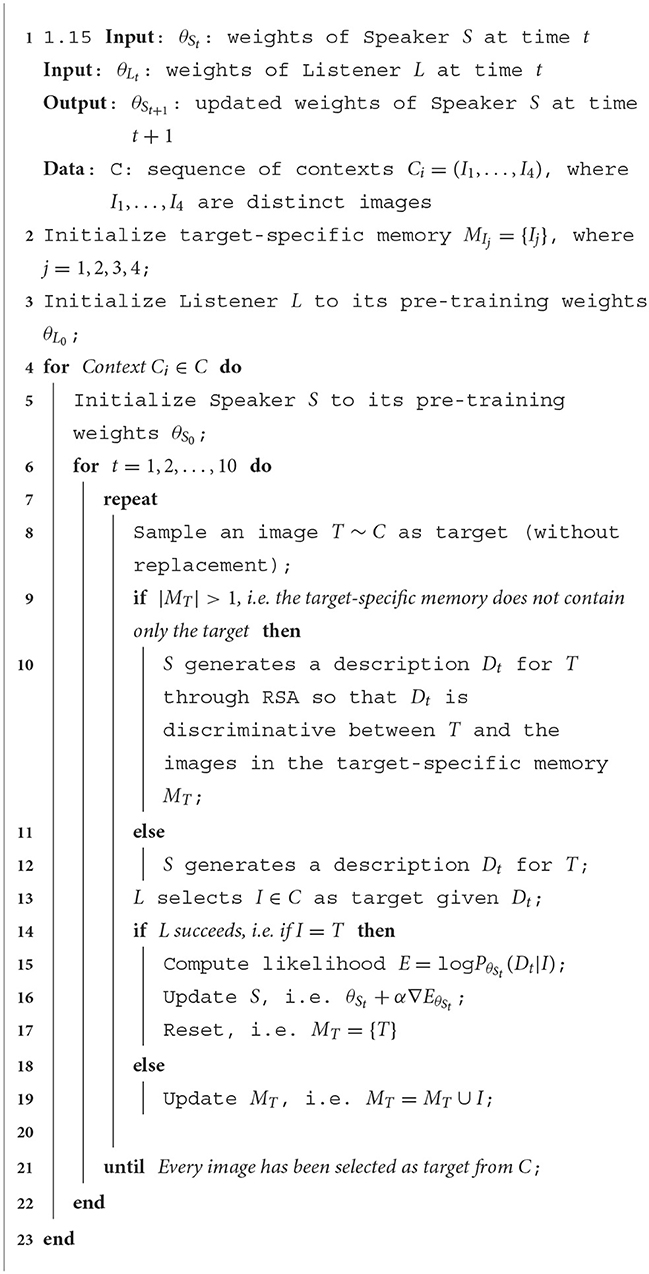

基于RSA的模型依赖于Cohn-Gordon等人(2018年)他指出,使用基于字符的解码器可以在语言模型中管理语用推理。在这个增量RSA实现中,literal Listener根据literal Speaker生成的部分标题在图像上生成分布。语用说话者在给定目标图像的情况下,对一组可能的字符进行推理,以选择最能引导听话者选择正确图像的字符。基于这种增量RSA实施,我们建议使用特定目标 记忆其工作原理如下。与基线一样,给定特定上下文的4幅图像中的一幅,说话人会生成对它的描述。听话人接收描述并尝试猜测上下文中哪个图像与说话人描述的图像对应。至关重要的是,如果侦听器选择了错误的图像,则该图像将添加到目标特定存储器演讲者在接下来的回合中使用。当演讲者再次描述该目标时,它将利用RSA来找出该目标与前一回合错误选择的图像之间的区别。为此,扬声器使用内部侦听器:在她可能生成的真实字幕中,她选择了一个可以让内部听众区分正确目标和其他目标的字幕。当外部侦听器正确猜测目标时,给定目标的生成描述的可能性会增加,编码器和解码器的参数都会更新。基本上,RSA用于指导说话人生成描述,从而根据听话人的知识成功进行交流。与基线的自适应相同,当处于时间步长时t吨听众选择正确的目标我收到描述后D类t吨作为输入,参数θS公司t吨更新说话人的描述,最大化目标图像描述的可能性,定义为logP(P)θS公司t吨(D类t吨|我). 我们将此模型称为RSA左侧.

为了研究RSA和LH之间的相互作用,一方面,我们评估当监听器选择正确的图像时重置目标特定内存的扬声器(RSA LH重置)另一方面,我们仅基于RSA而不使用LH来评估模型,即当侦听器正确猜测时,它不会增加描述的可能性。我们将此模型称为RSA公司.适应程序RSA LH重置被描述为伪代码算法2. TheRSA左侧模型遵循相同的伪代码RSA LH重置,但它不执行第16行报告的指令。

5.评估方法

5.1. 实验

我们评估模型在同一实体上迭代交互时如何逐步适应侦听器的知识(如在中所做的那样霍金斯等人,2020a)(实验1:实体自适应),以及属于同一域的任何实体(实验2:域自适应)。在第一种情况下,我们在每个上下文之后重置模型,从而评估模型在特定上下文的十个回合中是如何变化的,而在第二种情况中,我们更进一步,因为我们在同一域中的每个上下文集之后重置了模型,因此评估模型是如何通过它们变化的。为了描述听者背景知识对说话人行为的影响,我们还将在对等环境中评估模型,在对等环境下,听者也是领域专家,即他已经使用所有MS-COCO培训集进行了IC预培训。

5.2. 韵律学

我们的目的是了解专家是否成功地与外行沟通。我们从两个方面来衡量这种成功:通过评估听者在参考任务上的表现(任务成功的准确性)和说话人如何调整她的语言使用。

5.2.1. 准确性

当目标图像包含未知类别时,与当目标图像仅包含已知类别时相比,我们计算侦听器在每个转弯处获得的平均精度。在实验1中,我们对涉及相同上下文的话轮进行平均,而在实验2中,我们对六个上下文中的每一个话轮进行了平均,并报告了从第一个话轮到最后一个话轮到准确度的总体变化。因此,每回合准确度衡量的是听者在适应过程中猜测目标的平均提高程度。我们将准确性的提高解释为说话人对未知类别物体的描述变得更容易被听话人理解,换句话说,说话人已经适应了听话人。

5.2.2. 语言属性

霍金斯等人(2020b)研究表明,通过与同一对话者的反复互动,人类往往会缩短话语,减少封闭类词类,而非开放类词类。相反,在我们的知识差异设置中,我们希望演讲者对未知对象类别的描述更具信息性,因此更长,因为我们希望她使用更多的视觉属性(形容词),而涉及未知概念的名词可能更少。为了验证这个假设,我们进行了下面描述的分析。

5.2.3. 长度

我们比较了涉及具有已知类别和未知类别的图像的字幕的长度。对于每个上下文,我们通过简单地处理以已知对象与未知对象作为目标图像的步骤中生成的所有字幕的长度之和来计算每个回合中字幕的长度。我们预计指向侦听器未知对象的标题的长度会更长。

5.2.4. 形容词百分比

我们测量了从第一圈到最后一圈,形容词相对于生成字幕中出现的单词总数的百分比。我们将用NLTK标记的形容词总数相加(Bird等人,2009年),将其除以标题长度的总和,然后将该值乘以100。我们对每一回合都这样做,并在不同背景下取平均值。

5.2.5. 未知名词与已知名词

我们测量说话人使用的名词数量,这些名词指的是听话人未知或已知的对象类别。对于演讲者为未知(resp.known)图像生成的每个字幕,我们检查字幕是否提及未知(resp.knowning)类别。如果是这样,我们在标题中计算其频率。然后,我们计算所有这些频率的总和,并将其与标题的长度平均,得到最终的百分比。

6.结果

6.1. 任务成功

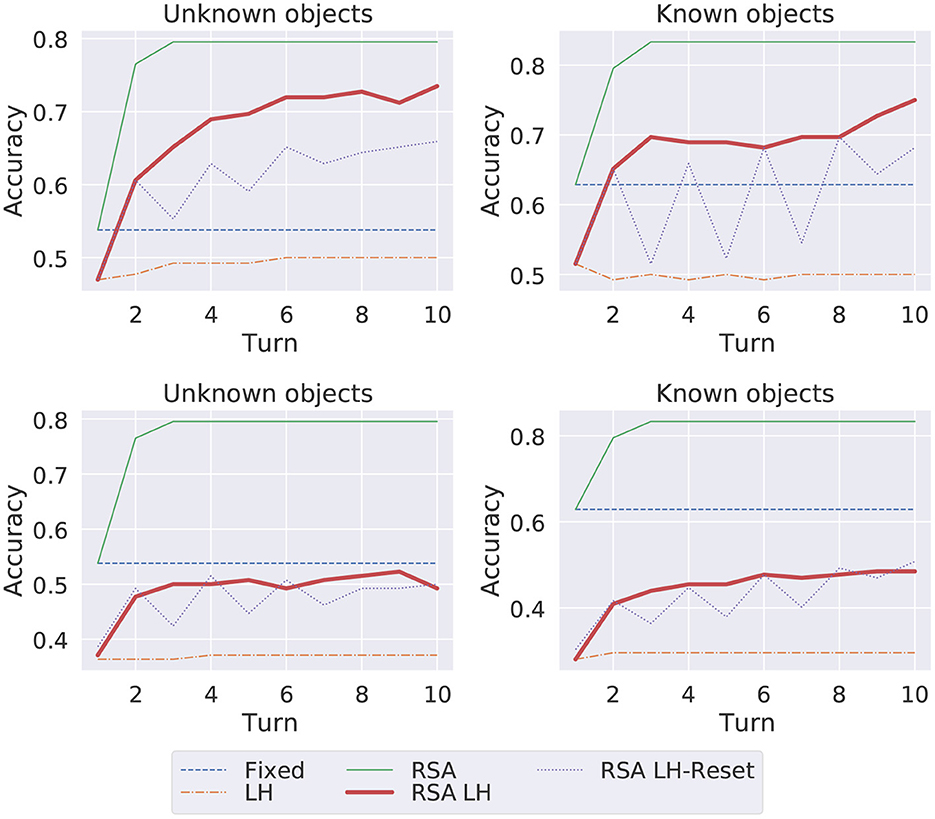

在图3,我们报告了当模型的参数在每个上下文之后(实验1在上部绘图)或在每个域内上下文集合之后(实验2在底部绘图)重置时,模型通过调整过程获得的总体准确性。我们比较了当目标图像包含未知对象类别和已知对象类别时获得的结果。

显然,当图像包含侦听器未知的对象类别时,通信会变得更加困难,这表现在侦听器使用固定模型生成的未知图像的标题获得的准确性较低。令人惊讶的是左侧模型比已知图像中的固定模型表现得最差,显示了基于似然损失的自适应的负面影响,即使在同一轮内也是如此。正如所料,对于未知图像和已知图像RSA公司是最好的模型RSA左侧是一种模型,无论是已知图像还是未知图像,都更接近它。然而,这两种模型总是能够访问侦听器在其目标特定内存中错误选择的图像。因此,从计算上来说,它们的成本更高,而且我们也会说认知上不太合理(它们依赖于更大且不断增长的记忆日记)。这个RSA LH重置相反,一旦它知道哪一个字幕更适合侦听器,就能够说出这种侦听器特定的描述,即使没有错误选择的图像。因此,我们认为它的结果是有希望的,因为它们显示了一种更具适应性的合并行为:它只在错误发生后的转弯处看到错误选择的图像,在随后的转弯处,它必须利用可能性损失为侦听器生成一个说明信息的字幕。其曲线显示,模型在前五个回合中努力纠正自己,但在这种互动之后,成功地适应了监听器(从第六个回合开始,监听器的性能不断提高。

图4(上半部分)显示了演讲者之间的交互示例,依赖于RSA LH-重置模型和普通监听器。对于十个回合中的每一个回合,它显示了说话人必须将其描述为目标图像4的步骤,其中包含了听话人不知道的花椰菜的概念。在每个步骤中,给定生成的描述,侦听器计算每个图像的概率分数,并选择得分最高的图像作为目标。每当侦听器无法识别正确的目标时,错误选择的图像就会添加到Speaker的目标特定内存中,并一直保留到侦听器成功为止。当下一个回合的演讲者将再次被分配该目标时,她将利用这种记忆跟踪,并通过生成一个标题来避免听众之前经历的混乱,她认为这将有助于听众更好地区分目标和错误选择的图像。从图中可以看出,使用内存跟踪有助于模型为侦听器生成更具信息性的标题(步骤9、18)。有趣的是,从第32步开始,即使不再依赖于特定于目标的内存(内存中只包含目标图像),听者也可以理解扬声器。除了这种有希望的行为,该模型还存在一些缺陷,应在未来加以解决。从示例交互中我们可以看到,它的描述有时指的是图像中没有的对象,例如“勺子”、“大米”、“三明治”等。即使在标题中也会出现这种情况,这会给外行带来更多信息。必须了解模型是否正在经历某种形式的语言漂移,以及如何在扎根语言生成过程中减少幻觉的出现。

当为所有自适应训练模型提供一批域内上下文并在每个域后重置时,它们的表现都比固定模型差(实验2)。这个结果表明模型经历了灾难性的遗忘。因此,在下文中,我们将重点关注演讲者在基于实体的适应阶段跨回合生成的字幕中的语言变化。

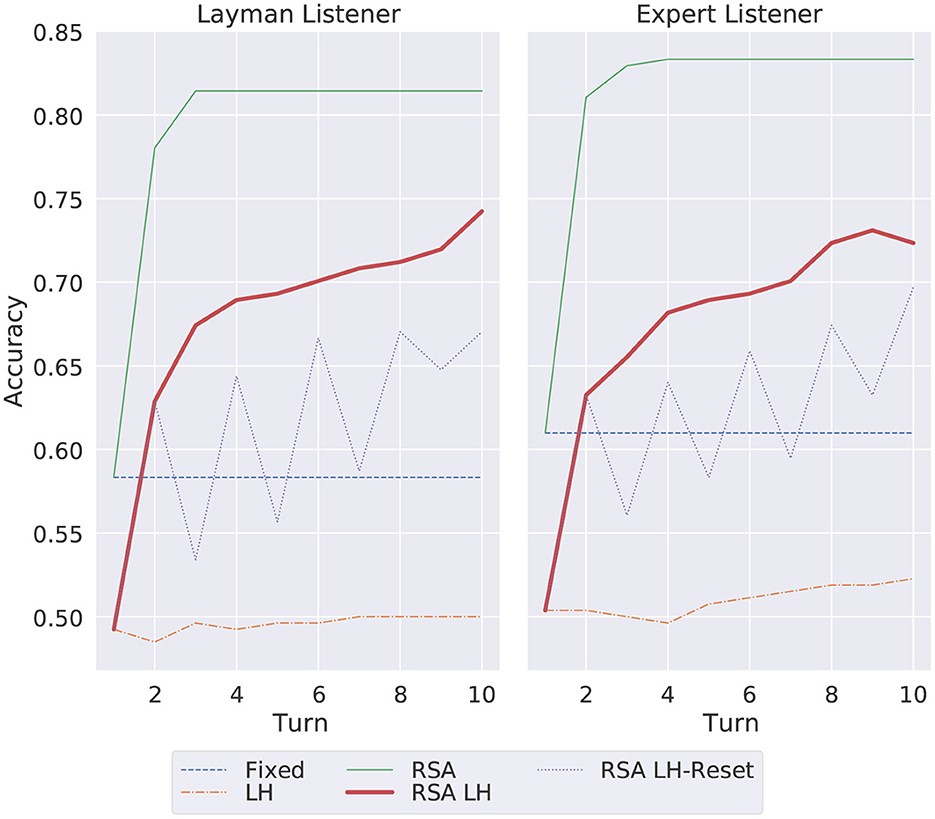

6.2. 与专家听众进行比较(对等)

我们还对对等设置进行了实验,在这种设置中,演讲者和接受过整个MS-COCO数据集IC培训的专家监听者之间会进行重复的参考游戏。回想一下,说话人和听话人并不共享非常精确的体系结构:前者构建在基于字符的解码器上,后者构建在基于单词的解码器上。因此,听者不应获得100%的准确率,演讲者仍应学会适应同龄人。图5显示了演讲者与专家侦听器通信时每回合(第1回合到第10回合)的总准确度,并将结果与迄今为止讨论的外行侦听器获得的准确度进行了比较。这些准确度是在实体适应级别计算的。正如预期的那样,由于Expert Listener通过IC预训练具有所有对象类别的经验,因此他的性能高于普通人的性能:固定模型获得了约62%(Expert),而普通人获得了57%(Layman)。这个RSA公司为专家监听器设定了更高的上限(约84%),奇怪的是RSA左侧似乎在交互结束时开始降低其性能,而RSA LH重置不断提高。结果证实,即使在说话人和听话人的知识不存在差异的情况下,所提出的RSA方法也能够在说话者和听话者之间提供更有效的通信(即提高准确性)。同样,效率更高的结果RSA LH重置模型很有前景。之所以会发生这种情况,是因为特定于目标的内存允许模型对侦听器在上下文中执行的实际错误进行推理,从而允许Speaker创建新的更有效的描述,这些描述更容易被侦听器理解,如图4.

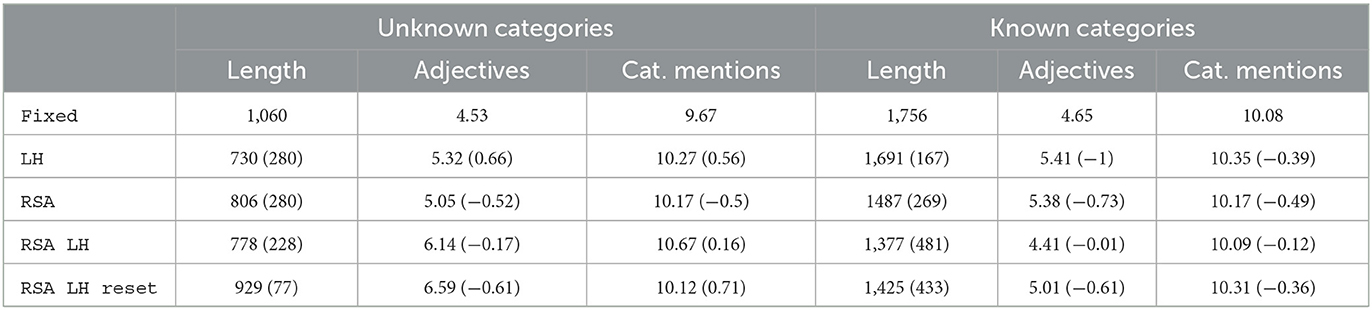

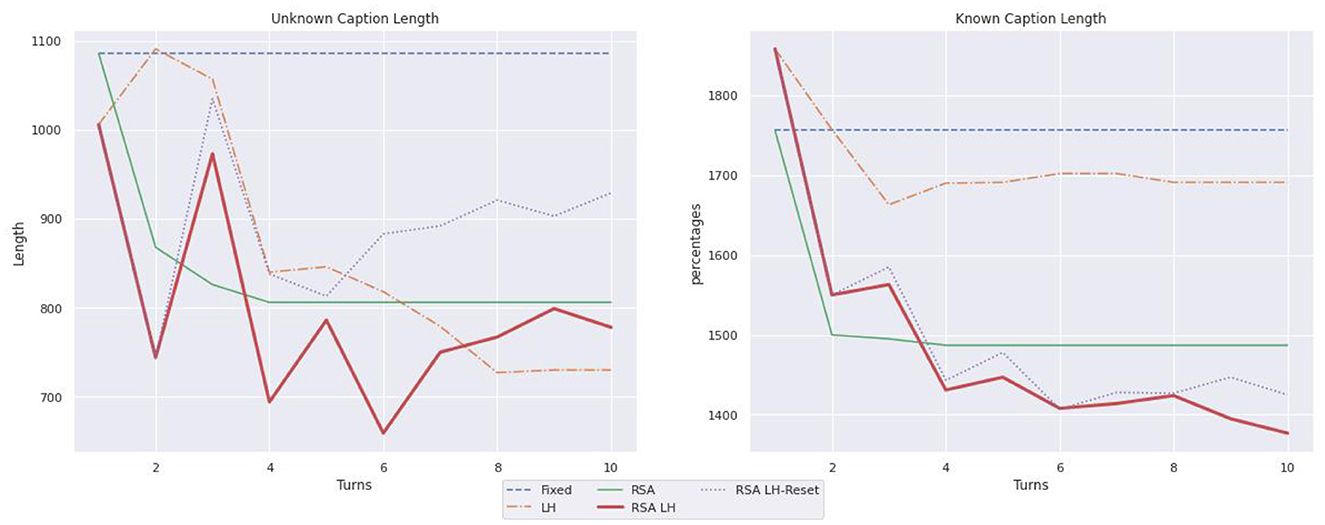

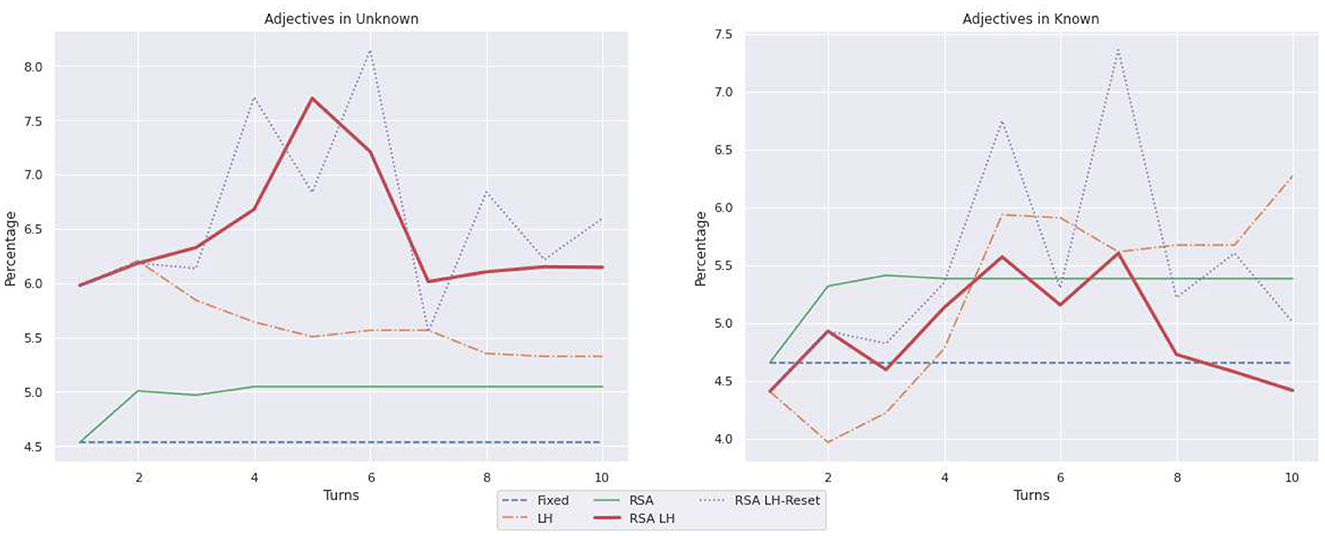

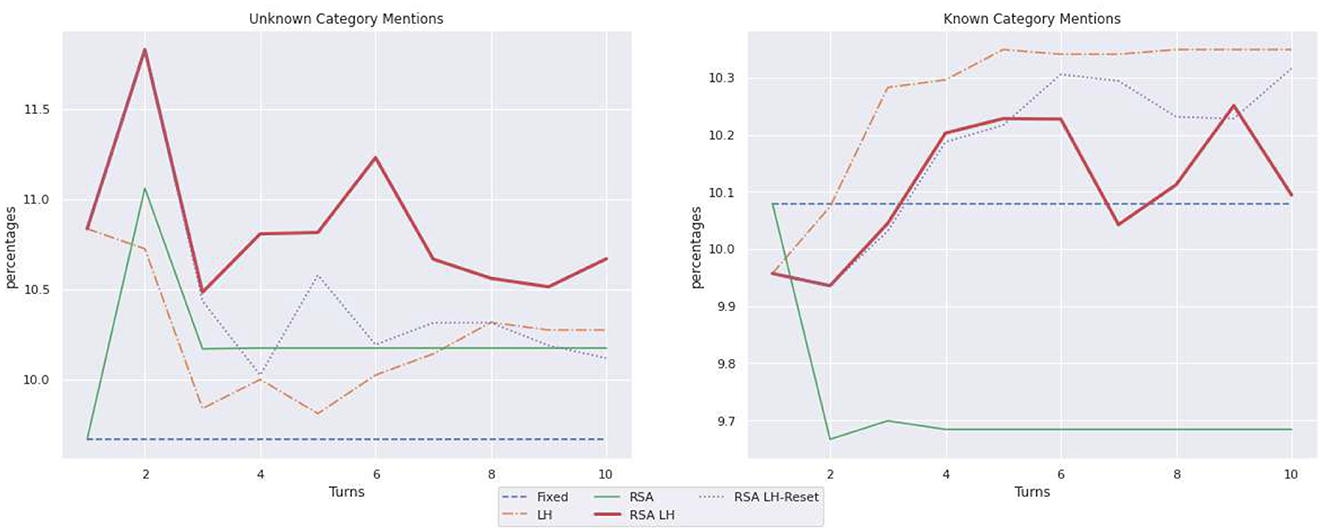

6.3. expert-Layman环境中的语言使用

表1总结了以下所示的统计数据图6–8关于语言使用。它只报告最后一圈的值,并在括号内报告第一圈与最后一圈之间的差异。如所示图6,描述已知对象时,RSA左侧和RSA公司 LH-重置是最短字幕长度的模型;例如,由RSA LH重置长度减少了433个标记,而RSA公司该模型只减少了269枚代币。另一方面,在未知物体的情况下,RSA左侧和RSA LH重置,经过一些缩短步骤后,学会问比左侧在最后一圈;RSA LH重置是一种模型,其标题在最后一回合变长,使用929个标记,而LH仅使用730个标记。为了更好地了解观察到的长度变化,图7说明形容词的用法。此外,RSA左侧和RSA LH重置描述未知物体时,形容词要比描述已知物体多(分别在第10回合,6.14对4.41,6.59对5.01)。有趣的是,它们也是通过互动增加形容词使用最多的模型,正如人们从适应性行为中所期望的那样。最后,图8显示了未知对象类别与已知对象类别的平均提及次数。随着转弯次数的增加,所有车型涉及的未知类别都会减少。另一方面,除了RSA公司,其对已知对象类别的提及次数在第一轮中减少,然后保持稳定。这种行为可能取决于以下事实:RSA公司生成语用描述,将目标与上下文中的其他对象区分开来。因此,它生成描述,突出显示目标和其他图像之间的差异,而不是直接引用目标。

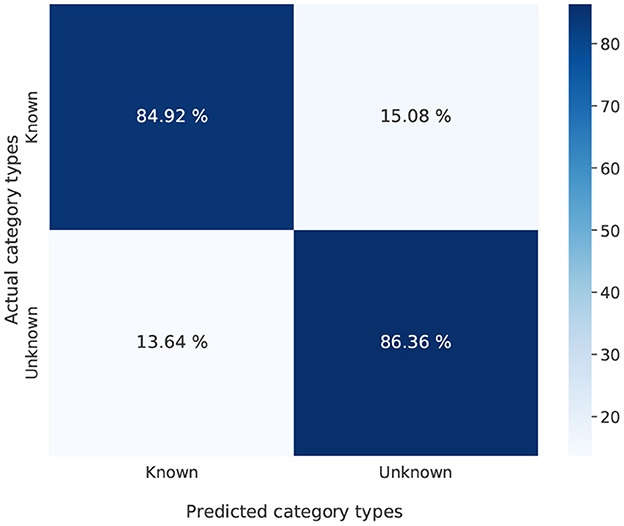

6.4. 未知对象与已知对象之间的混淆

为了评估听者在猜测目标图像时所犯的错误类型,我们计算了混淆矩阵报告,对于包含未知对象和已知对象的目标图像,预测涉及两种对象中每一种对象的数量。图9说明了这样的混淆矩阵RSA左侧; 它表明,当错误选择候选图像时,侦听器会将未知(分别为已知)对象与另一未知(分别是已知)对象混淆。在所有其他模型中都注意到了同样的模式,评估结果表明,一般来说,侦听器很少混淆已知对象和未知对象。因此,在类别级别上,选择是适当的。

7.结论

通过这项工作,我们旨在引起人们对交流的一个重要方面的关注,即对话者通过互动的动态风格相互适应。我们相信,使用基于神经网络的自然语言生成系统来面对这一挑战的时机已经成熟。特别是,我们认为持续学习的进展应该与基于语用推理和迭代设置的框架相结合,例如霍金斯等人(2020a)和朱等人(2021)是研究自适应模型的一大挑战。我们将注意力放在Expert-Layman交互中的语言适应上,在这种交互中,专家需要适应Layman缺乏领域知识的情况。

我们研究了演讲者产生的字幕,演讲者利用听者的错误产生更具歧视性的字幕,并从他的成功中学习如何为对话者提供更多信息。我们依靠弗兰克和古德曼(2012)并将其与Cohn-Gordon等人(2018年); RSA步骤提示模型生成字幕,以区分目标图像和侦听器在之前的交互中错误选择的图像,并通过似然损失提升这种区分字幕。我们的结果表明,RSA确实可以作为一个骨干,将说话人推向听话人:沟通变得更加成功(如准确性提高所示),说话人生成的语言特征发生了变化,这标志着听话人的背景知识得到了适应。在下文中,我们强调了当前工作的局限性以及它所开启的未来方向。

8.限制和未来方向

我们报告的工作有一些局限性,可以在未来加以解决。首先,我们使用的基于字符的解码器虽然计算效率很高,但会产生幻觉的字幕;如中所述示例中提到的“三明治”图4这种幻觉甚至存在于预期的适应过程的结果中。一些关于解码策略的最新研究表明,通过将解码器与“推理模块”(例如Testoni和Bernardi(2021年),我们希望在这个方向上还将使用基于字符的高效解码器进行进一步的工作。此外,我们希望看到字符与基于单词的解码器在这个问题上的详细比较。此外,我们还表明模型会经历灾难性遗忘,这是一个不应忽视的重要问题,因为与多个代理交互的能力是适应的一个核心方面。最后,在写论文时,我们发现Bao等人(2022)他们也依赖记忆,但与强化学习相结合,以进行适应;将我们提出的模型与他们的工作进行比较,以评估在两个代理之间的通信过程中在准确性和语言适应方面产生的差异。在开发自适应模型并比较各种技术场景时,需要记住的一个有趣观点是模型的认知合理性。这种观点有助于将重点放在适应过程上,这一过程的计算成本也较低,因此对大规模应用很有意义。

我们的工作解决了一些可以进一步探讨的有趣问题,并提出了新的挑战。首先,我们的模型接收侦听器错误选择的图像,并利用它生成更具辨别力的信息描述。研究演讲者是否能够学会预测听者的错误,并根据这种预测生成信息丰富的描述,这将是一件有趣的事情。此外,演讲者应该接受挑战,与具有不同知识的听众进行互动,并且仍然能够生成量身定制的描述。解决此限制的一个可能的解决方案是,在基于RSA的模型中为每个外部侦听器使用一个内部侦听器,以便构建和维护特定于侦听器的表示。此外,听者应该从与说话人的互动中学习如何构建未知类别的表示。贝诺蒂和布莱克本(2021)呼吁合作基础,通过合作从错误中恢复过来来协商意义。本着同样的精神,神经科学家提供了令人信服的证据。Hasson等人(2012年))和Nguyena等人(2019年)追踪心理语言学家注意到的语言对齐的原因(加罗德和皮克林,2004年)进入大脑排列;换言之,在言语产生过程中,说话人的大脑反应与听话人在言语理解过程中的大脑反应相结合。研究神经网络对齐是很有趣的。从这个角度来看,联合训练这两个系统是很有意思的,这样可以让它们协同调整和修改概念知识。

了解如何学习和适应具有自己偏好的不同用户,对于许多应用程序的未来开发非常重要,例如家庭机器人、语音助手和虚拟在线购物,每个客户都有自己的通信方式。随着当前许多智能家居设备和虚拟助理的发展,现在是时候把它们提升到一个新的水平了,他们的任务不仅限于了解客户的要求,还包括学习和适应环境,以及结合来自不同来源的知识,例如。,从语言交流和视觉角度解决更复杂的任务。我们的工作正朝着使客户适应并建立共同知识以更好地了解其偏好的方向发展。

数据可用性声明

本文/补充材料中包含了研究中的原始贡献,可向相应作者进行进一步查询。

作者贡献

CG实施了这些模型。DB构建了数据集并评估了语言的使用。RB设计并领导项目。D-TL对应用程序给予了特别关注的反馈。所有作者都为论文写作做出了贡献。所有作者都参与了这篇文章并批准了提交的版本。

基金

这项研究是通过亚马逊的捐款资助的。

致谢

我们感谢两位评论员的深刻反馈。我们感谢Robert Hawkins对其代码使用的支持,感谢Sina Zarieß和Simeon Schüz对RSA及其可能实现的有趣讨论。

利益冲突

D-TL受雇于Amazon Alexa。

其余作者声明,该研究是在没有任何可能被解释为潜在利益冲突的商业或金融关系的情况下进行的。

出版商备注

本文中表达的所有声明仅为作者的声明,不一定代表其附属组织的声明,也不一定代表出版商、编辑和审稿人的声明。任何可能在本文中进行评估的产品,或制造商可能提出的索赔,都不受出版商的保证或认可。

脚注

工具书类

Andreas,J.和Klein,D.(2016年)。《与神经听众和演讲者进行语用推理》2016年自然语言处理实证方法会议记录(德克萨斯州奥斯汀:计算语言学协会),1173-1182年。

PubMed摘要|谷歌学者

Bao,Y.、Ghosh,S.和Chai,J.(2022)。《学会调解语用沟通方面的差异》计算语言学协会第60届年会论文集(第一卷:长篇论文)(都柏林:计算语言学协会),2829-2842。

谷歌学者

Bara,C.-P.,CH-Wang,S.和Chai,J.(2021)。《MindCraft:协作任务中情境对话的思维建模理论》2021年自然语言处理实证方法会议记录(Punta Cana:计算语言学协会),1112-1125。

谷歌学者

Benotti,L.和Blackburn,P.(2021)。“作为协作过程的基础”计算语言学协会欧洲分会第16届会议记录:主要卷(计算语言学协会),515-531。

谷歌学者

Bird,S.、Klein,E.和Loper,E.(2009年)。使用Python进行自然语言处理:使用自然语言工具包分析文本O'Reilly Media,Inc.公司。

谷歌学者

Bisk,Y.、Holtzman,A.、Thomason,J.、Andreas,J.和Bengio,Y.,Chai,J.等人(2020年)。“经验决定语言”,in2020年自然语言处理实证方法会议记录,8718–8735(计算语言学协会)。

谷歌学者

Brennan,S.、Galati,A.和Kuhlen,A.K.(2010年)。《两个头脑,一个对话:协调说话和理解》学习与动机心理学,第53卷,编辑R.H.Ross(爱思唯尔),301–344。

谷歌学者

Brennan,S.E.和Clark,H.H.(1996年)。会话中的概念约定和词汇选择。《心理学实验杂志》。学习。内存。认知。22, 1482–1493.

PubMed摘要|谷歌学者

Chandu,K.R.、Bisk,Y.和Black,A.W.(2021)。“NLP中的接地”,in计算语言学协会的研究结果:ACL-IJCNLP 2021(计算语言学协会),4283–4305。

谷歌学者

克拉克,H.H.(1992年)。语言使用的舞台芝加哥大学出版社。

谷歌学者

Clark,H.H.和Marshall,C.R.(1981年)。“明确的知识和相互了解”话语理解要素,编辑A.K.Joshi、B.L.Webber和I.A.Sag(英国剑桥:剑桥大学出版社),10-63。

谷歌学者

Clark,H.H.和Wilkes-Gibbs,D.(1986年)。指的是协作过程。认知22, 1–39.

谷歌学者

Cohn-Gordon,R.、Goodman,N.和Potts,C.(2018年)。中的“带有字符级推理的实用信息图像字幕”计算语言学协会北美分会2018年会议记录:人类语言技术,第2卷(短文)(洛杉矶新奥尔良:计算语言学协会),439-443。

谷歌学者

Cohn-Gordon,R.、Goodman,N.和Potts,C.(2019年)。《语用学的增量迭代反应模型》2019年语言学计算学会会刊, 81–90.

谷歌学者

Corona,R.、Alaniz,S.和Akata,Z.(2019年)。图像参考游戏中的概念理解建模纽约州Red Hook:Curran Associates Inc。

谷歌学者

Frank,M.C.和Goodman,N.D.(2012年)。语言游戏中的预测语用推理。科学类336, 998–998. doi:10.1126/科学.1218633

PubMed摘要|交叉引用全文|谷歌学者

Franke,M.和Jaeger,G.(2016年)。概率语用学,或者为什么贝叶斯规则对语用学很重要。Z.Sprachwissenschaft公司35,3–44。doi:10.1515/zfs-2016-0002

交叉引用全文|谷歌学者

Gann,T.M.和Barr,D.J.(2014)。从经验上讲:观众设计是专家表演。语言认知。神经科学。29, 744–760. doi:10.1080/01690965.2011.641388

交叉引用全文|谷歌学者

Garrod,S.和Pickering,M.J.(2004)。为什么谈话这么容易?趋势认知。科学。8、8–11。doi:10.1016/j.tics.2003.10.2016

PubMed摘要|交叉引用全文|谷歌学者

N.D.古德曼和M.C.弗兰克(2016)。作为概率推理的语用语言解释。趋势认知。科学。20, 818–829. doi:10.1016/j.tics.2016.08.005

PubMed摘要|交叉引用全文|谷歌学者

Grice,H.P.(1975)。中的“逻辑和对话”句法和语义3:言语行为,编辑P.Cole和J.L.Morgan(纽约:学术出版社),第41-58页。

谷歌学者

Hasson,U.、Ghazanfar,A.A.、Galantucci,B.、Garrod,S.和Keysers,C.(2012)。大脑-大脑耦合:创建和共享社交世界的机制。趋势认知。科学。16, 114–121. doi:10.1016/j.tics.2011.12.007

PubMed摘要|交叉引用全文|谷歌学者

Hawkins,R.、Kwon,M.、Sadigh,D.和Goodman,N.(2020a)。“持续适应以实现高效的机器通信”,in第24届计算自然语言学习会议记录, 408–419.

谷歌学者

霍金斯,R.D.、弗兰克,M.C.和古德曼,N.D.(2020b)。描述重复参考游戏中学习动态的特征。认知。科学。44,e12845。doi:10.1111/cogs.12845

PubMed摘要|交叉引用全文|谷歌学者

Hawkins,R.D.、Franke,M.、Frank,M.C.、Goldberg,A.E.、Smith,K.、Griffiths,T.L.等人(2022年)。从合作伙伴到群体:协调和约定的贝叶斯层次描述。精神病。版次。doi:10.1037/rev0000348

PubMed摘要|交叉引用全文|谷歌学者

He,K.、Zhang,X.、Ren,S.和Sun,J.(2016)。《图像识别的深度残差学习》IEEE计算机视觉和模式识别会议记录(内华达州拉斯维加斯),770-778。

PubMed摘要|谷歌学者

Hochreiter,S.和Schmidhuber,J.(1997年)。长短期记忆。神经计算。9, 1735–1780.

谷歌学者

Horton,W.S.和Gerrig,R.J.(2005)。语言生成中的会话共同点和记忆过程。话语过程。40, 1–35. doi:10.1207/s15326950dp4001_1

交叉引用全文|谷歌学者

Horton,W.S.和Gerrig,R.J.(2016)。重新审视基于内存的处理方法以找到共同点。顶部。认知。科学。780-795之间。doi:10.1111/tops.12116

PubMed摘要|交叉引用全文|谷歌学者

Horton,W.S.和Keysar,B.(1996年)。发言者什么时候考虑到共同点?认知59, 91–117.

PubMed摘要|谷歌学者

Janarthanam,S.和Lemon,O.(2010年)。《学习适应未知用户:在口语对话系统中指代表达生成》计算语言学协会第48届年会会议记录(乌普萨拉:计算语言学协会),69-78。

谷歌学者

Krauss,R.M.和Weinheimer,S.(1964年)。社会交往中参考短语的变化与使用频率的关系:初步研究。精神病患者。科学。1, 113–114.

谷歌学者

Kuhlen,A.K.、Bogler,C.、Brennan,S.E.和Haynes,J.-D.(2017)。对话中的大脑:解码与对话伙伴对话的神经准备。社会认知。影响。神经科学。12, 871–880. doi:10.1093/scan/nsx018

PubMed摘要|交叉引用全文|谷歌学者

Lazaridou,A.、Peysakhovich,A.和Baroni,M.(2017年)。《多智能体合作与(自然)语言的出现》2017年ICLR会议记录.

PubMed摘要|谷歌学者

Lazaridou,A.、Potapenko,A.和Tieleman,O.(2020年)。《多智能体通信与自然语言:功能性和结构性语言学习之间的协同作用》计算语言学协会第58届年会会议记录(计算语言学协会),7663-7674。

谷歌学者

Loy,J.E.和Smith,K.(2021年)。在互动过程中,演讲者与伴侣的过度指定保持一致。认知。科学.45,e13065。doi:10.1111/cogs.13065

PubMed摘要|交叉引用全文|谷歌学者

Monroe,W.和Potts,C.(2015年)。《理性言语行为模式中的学习》阿姆斯特丹学术讨论会会议记录.

谷歌学者

Nguyena,M.、Vanderwal,T.和Hasson,U.(2019年)。对故事的共同理解与共同的神经反应相关。神经成像184, 161–170. doi:10.1016/j.neuroimage.2018.09.010

PubMed摘要|交叉引用全文|谷歌学者

Premack,D.和Woodruff,G.(1978年)。黑猩猩有心理理论吗?贝哈夫。脑科学。515-526之间。

谷歌学者

Ruder,S.(2019)。自然语言处理中的神经转移学习(博士论文)。爱尔兰国立大学,爱尔兰戈尔韦。

谷歌学者

Schüz,S.、Han,T.和Zariyß,S.(2021)。“多样性是一种副产品:以目标为导向的语言生成导致语言变异”话语和对话特别利益小组第二十二届年会记录(新加坡:计算语言学协会),411-422。

谷歌学者

Stalnaker,R.C.(1978年)。断言莱顿:布瑞尔。

谷歌学者

Sutskever,I.、Vinyals,O.和Le,Q.V.(2014)。《神经网络的序列到序列学习》神经信息处理系统的进展27编辑Z.Ghahramani、M.Welling、C.Cortes、N.D.Lawrence和K.Q.Weinberger(魁北克省蒙特利尔)。

谷歌学者

Testoni,A.和Bernardi,R.(2021)。“我见过一些你们这些人不会相信的事情”:在《猜猜看什么》中产生幻觉的实体在里面计算语言学协会第59届年会和第11届国际自然语言处理联合会议记录:学生研究研讨会(计算语言学协会),101-111。

谷歌学者

Zarireß,S.和Schlangen,D.(2019年)。“知道你不知道的:为一个提及未知类别对象的务实演讲者建模”计算语言学协会第57届年会会议记录(佛罗伦萨:计算语言学协会),654-659。

谷歌学者

Zhu,H.、Neubig,G.和Bisk,Y.(2021)。《通过思维建模理论实现的少语速语言协调》(The Few-shot language coordination by modeling theory of mind)第38届机器学习国际会议论文集,第139卷,共页机器学习研究进展,编辑M.Meila和T.Zhang(PMLR),12901–12911。

谷歌学者